强化学习(1)— 基本概念

.1.1 状态、动作、奖励

状态:对当前环境的概括

状态空间:所有可能存在的状态集合

动作:智能体基于当前状态做的决策

动作空间:所有可能存在的动作集合

奖励:智能体执行完一个动作后,环境返回的一个数值

1.1.2 状态转移

状态转移:智能体从t时刻s状态转移到t+1时刻的状态s’的过程

通常强化学习假设状态转移是随机的,用状态转移函数表示:

pt (s’ | s, a) = P (S’t+1= s’ | St=s, At=a)

通常假设状态转移函数是平稳的,即函数不会随着时刻t变化

1.2 策略

策略:如何根据观测到的状态做出决策,即如何从动作空间选取动作,强化学习的目标即是学习策略函数

随机性策略:随机性策略π:S×A→[0, 1]是一个概率密度函数 π(a|s) = P (A= a | S=s),输入是S和A,输出是0~1之间的数值

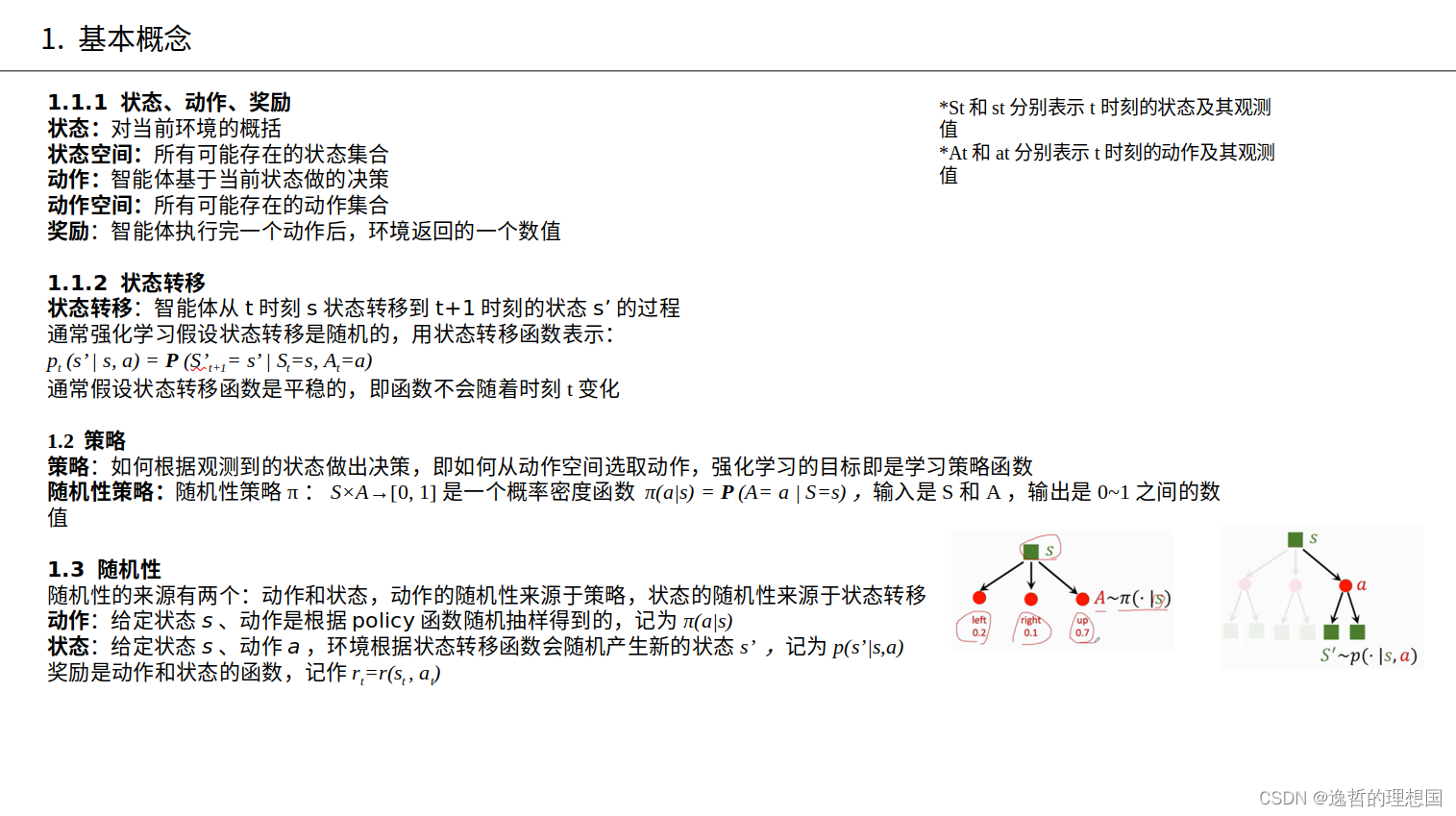

1.3 随机性

随机性的来源有两个:动作和状态,动作的随机性来源于策略,状态的随机性来源于状态转移

动作:给定状态s、动作是根据policy函数随机抽样得到的,记为π(a|s)

状态:给定状态s、动作a,环境根据状态转移函数会随机产生新的状态s’ ,记为p(s’|s,a)

奖励是动作和状态的函数,记作rt=r(st , at)

1.4 回报和折扣回报

回报:从当前状态开始到状态本回合结束所有奖励的总和,也叫累计奖励

Ut = Rt+Rt+1+Rt+2+…+Rn

强化学习的目标是寻找一个策略,使得回报的期望最大化,这个策略称为最优策略

折扣回报:对未来的奖励打折,γ∈[0, 1]

Ut = Rt+γRt+1+γ2Rt+2+…+γn-1Rn

假设在t时刻只观测到st及其之前的状态、动作和奖励:

s1, a1, t1, s2, a2, t2 ,…, st-1, at-1, rt-1, st

剩余状态At, Rt, St+1,…, Sn, An, Rn(随机变量,尚未被观测到), Ut依赖于Rt , …, Rn,Ut属于随机变量

1.5 价值函数

价值函数:回报的期望

动作价值函数:Qπ(st , at ) = ESt+1, At+1,…, Sn, An [Ut | St=st , At=at ],观测到st,且做完了决策、选择了动作at

Qπ(st, at)依赖当前状态st、当前动作at和策略函数π,是回报的期望

最优动作价值函数:Q*(st ,at ) = maxπ Qπ(st , at ),∀ st∈S, at∈A

有多种策略可供选择,选择其中最好的策略函数:

π*=argmaxπ Qπ(st, at ), ∀ st∈S, at∈A

状态价值函数:Vπ(st )=EAt~π(• |st) [Qπ(st , At )] = ∑a∈Aπ(a|st ) • Qπ(st , a)

用来判断策略π和状态st的好坏,也是回报的期望:Vπ(st ) = EAt , St+1, At+1,…, Sn , An [Ut | St = st ]

2241

2241

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?