一、摘要

-

困境:卷积神经网络(CNN)由于感知场有限,只能提取局部时间特征,可能无法捕获脑电图解码的长期依赖关系。

-

方案:提出了一个紧凑的卷积变压器,称为脑电信号Conformer。局部和全局特征封装在一个统一的脑电信号分类框架中。

-

具体:卷积模块学习整个一维时间和空间卷积层的低级局部特征。自关注模块直接连接,提取局部时间特征中的全局相关性。采用基于全连通层的简单分类器模块对脑电信号进行分类预测

二、介绍

1.模式识别方法

-

公共空间模式(CSP):增强运动想象(MI)任务的空间特征

-

滤波器组:进一步嵌入MI和稳态视觉诱发电位(SSVEP)分类[9]的频率节奏

-

连续小波变换:从脑电信号中提取时频特征来检测痴呆[10]

-

经验小波变换:对脑电图进行改进的时频特征提取,对癫痫发作的检测

2.困境

1.大多数传统的特征提取方法是任务相关的,这意味着对于不同的脑机接口范式,特征提取具有特定的先验知识,泛化能力有限。

2.此外,单独优化特征提取和分类器也可能导致不完美的全局优化。

3.潜在方案

1.改进的CNN模型ConvNet[16]在脑电分类任务上取得了与传统算法相当的性能,学习了卷积层的判别特征。

2.紧凑的EEGNet[17]表现出显著的时间特征感知,并在多个脑接口范式中表现出良好的泛化。

3.缺点:核大小的限制,cnn学习具有局部接受域的特征,但无法获得对时间序列至关重要的长期依赖关系。递归神经网络(RNN)和长短期记忆(LSTM)被进一步提出用于捕获EEG分类的时间特征[18],[19]。然而,这些模型不能并行训练,并且依赖影响不能计算

4.基于注意力的Transformer

-

优点:具有全局依赖性的固有感知,利用长期时间关系[21],[22]获得良好的性能。

-

缺点:忽略了局部特征的学习,必须增加额外的特征提取处理。

5.解决方案:EEG Conformer

介绍:综合利用CNN和Transformer的优点。组成

-

卷积模块:使用时间和空间卷积分别捕获局部时间和空间特征,采用平均池化层对时间特征段进行切片,将时间维度上每个点的所有卷积通道作为一个令牌,并将它们馈送到自注意模块中。

-

自关注模块:进一步学习全局时间依赖性

-

分类器:使用简单的全连接层来获得解码结果

6、具体模型和解读

组成:

-

卷积模块:原始的二维脑电实验作为输入,分别沿时间维度和电极通道维度施加时间和空间卷积层。然后利用平均池化层抑制噪声干扰,提高泛化能力。(1,c, t) --Tconv--> (k, c ,t)--Sconv--> (k ,1 ,t ) ---pooling and reshape ->(t,c)

-

自关注模块:其次,将卷积模块得到的时空表征输入到自注意模块中。通过测量特征图中不同时间位置之间的全局相关性,进一步提取长期时间特征。

-

全连接分类器:多个完全连接层组成的紧凑分类器输出解码结果

(一)预处理

1.预处理原始EEG试验大小为ch × sp,其中ch表示电极通道,sp表示时间样本。首先,采用带通滤波滤除无关的高低频噪声。在这里,我们使用6阶切比雪夫滤波器来保持任务相关的节奏。

2.然后,进行z分数标准化以减少波动和非平稳性,

其中xi和xo分别表示带通滤波数据和标准化输出。μ和σ2表示均值和方差,用训练数据计算,直接用于测试数据。

(二)神经网络结构

(1,c, t) --Tconv--> (k, c ,t)--Sconv--> (k ,1 ,t ) ---pooling and reshape ->(t,c)

1.将二维卷积算子分离为两个一维时空卷积层来设计卷积模块。第一层有k个大小为(1,25)的核,其步幅为(1,1),这意味着卷积是在时间维度上执行的。

2.第二层保留k个大小为(ch, 1)的核,步长为(1,1),其中ch等于EEG数据的电极通道数。这一层作为一个空间滤波器来学习不同电极通道之间相互作用的表示。

3.采用批归一化方法加快训练过程,缓解过拟合问题。

4.指数线性单元(elu)作为以下非线性的激活函数[17]。

5.第三层是沿时间维度的平均池化,内核大小为(1,75),步长为(1,15)。该池化层平滑了时间特征,既避免了过拟合,又降低了计算复杂度。

(三)自注意力模块

步骤:

1.从上一个模块中排列的标记被线性转换成等形的三副本,称为查询(Q),键(K)和值(V)。对Q和K使用点积来评估不同标记之间的相关性。

2.设计了缩放因子以避免梯度消失,卷积变压器用于EEG解码和可视化。将结果通过softmax函数传递,得到权重矩阵,即注意力得分。

3.然后将注意力得分用点积对V进行加权[20]

K表示令牌的长度。并在后面连接两个全连通前馈层,增强拟合能力。该过程的输入和输出大小保持不变。整个注意力计算在自注意模块中重复N次。

采用多头策略,进一步提高代表的多样性。将令牌平均分成h段,分别馈送到自关注模块,并将结果串联为模块输出,

其中MHA表示多头关注,Ql, Kl, Vl∈Rm×k/h分别表示第l个头部的分割令牌进行线性变换得到的查询、键和值。

(四)分类器模块

两个完全连通的层作为分类器模块,经过softmax函数输出一个m维向量。交叉熵作为整个框架的损失函数:

其中M为脑电分类数,y和y分别为基础真值和预测标签。Nb表示一批试验的次数。

三、实验处理

(一)数据集

1.BCI Competition IV Dataset 2a

-

有四个运动想象任务,包括移动左手、右手、双脚和舌头的想象

-

采用22个Ag/AgCl电极,以250 Hz的采样率采集不同日期的两个时段。

-

一组实验包含288个脑电图试验,即每个任务72个试验。

-

处理:每次试验的[2,6]秒,并使用带通滤波器[8]将EEG数据过滤到[4,40]Hz。第一节用于训练,第二节用于测试

2.BCI Competition IV Dataset 2b

-

两个运动想象任务,包括移动左手和右手的想象。

-

三个双极电极(C3, Cz和C4)以250 Hz的采样率收集5个疗程,每个疗程包含120次试验。

-

处理:每个试验的[3,7]秒。在[4,40]Hz之间进行了带通滤波,以降低高频和低频噪声。前三组为训练集,后两组为测试集

3.SEED dataset

-

5个受试者的基于情绪的脑电信号组成。15个电影片段刺激了三种情绪,包括积极、中性和消极

-

数据收集过程大约每隔一周重复三次

-

用62个电极以1000hz的采样率捕获EEG信号,随后降采样至200hz。

-

一个不重叠的1秒时间窗口进行分割,从而在一个会话中总共进行了3394次试验。

-

进行了[4,47]Hz的带通滤波。SEED数据集采用五重交叉验证。

(二)数据增强

脑电采集耗时长,导致数据集小,容易出现过拟合。有些方法采用数据扩充来为模型提供足够的样本;

-

缺点:传统的加高斯噪声或裁剪策略可能会进一步降低信噪比或破坏原有的相干性。

-

方案:时域分割和重构(S&R)来生成新的数据。

-

具体步骤:将同一类别的训练样本平均分成n个片段,然后在保持原始时间顺序的情况下随机拼接。我们在每次迭代中生成与批处理相同大小的增强数据。

(三)实验细节

-

Adam优化器训练模型,其学习率,β1和β2分别为0.0002,0.5和0.999。

-

设置自我关注的执行次数N为6,正面次数h为10,S&R中的N为8。分类精度和kappa作为整体性能的评价指标

-

其中po表示所有试验的平均精度,pe表示随机猜测的精度。采用Wilcoxon sign - drink检验进行统计学显著性分析。

(四)基线比较

-

FBCSP[8],使用手工制作的空间特征

-

ConvNet[16]和EEGNet[17]:基于cnn的端到端框架在许多脑电数据集上显示出显著的效果

-

C2CM[28]:将FBCSP特征输入到CNN模型中,结合了传统特征提取和深度学习方法的优点

-

FBCNet[38],多视点数据空间滤波提取光谱空间特征。

-

基于深度表征的域适应(deep representation-based domain adaptation, DRDA)[39]进行了比较,后者利用来自其他学科的数据来增强对抗学习。

-

Conformer比依赖于传统特征提取的FBCSP显著提高了10.91%的准确率

-

ConvNet和EEGNet,优于FBCSP,表明基于cnn的方法具有较强的特征表示能力。cnn的方法由于感知场有限,只关注局部特征,而忽略了全局相关性,这可能会影响相干脑电图序列的解码精度。

-

通过在原始CNN的基础上集成Transformer架构来封装本地和全局依赖。因此,Conformer在大多数被试上获得了更好的结果,在平均准确率和kappa上都有显著的提升(p < 0.05)。

-

C2CM和FBCNet有效地结合了手工特征和深度模型的思想,但除了受试者5 (p < 0.05)之外,仍然无法击败我们,尽管C2CM对每个受试者的模型参数进行了微调。

-

DRDA引入了与目标受试者分布一致的其他受试者的数据,这仍然不如我们只使用目标受试者的数据(p < 0.05),再次证明了同时利用局部和全局特征的有效性。

数据集II上的几种最新方法进行了比较。我们可以看到,二值分类结果呈现出与数据集I相似的趋势。

-

FBCSP相比,Conformer显著提高了整体成绩(p < 0.05),甚至在受试者1上提高了12.5%的准确率。

-

与仅使用CNN架构的其他端到端方法相比,有明显的提升,ConvNet (p < 0.05)和EEGNet (p < 0.01)的改进分别为5.25%和4.15%。

-

在几乎所有的被试上,我们方法的平均准确率和kappa仍然高于DRDA,进一步验证了我们方法的有效性。

-

SVM[36]等机器学习方法进行了比较,[36]首先在该数据集上取得了显著的结果

-

图正则化极限学习机(GELM)[40]采用单前馈层学习判别特征,

-

区域为全局时空神经网络(R2G-STNN)[42]

-

双向长短期记忆学习情绪脑电图信号的时空特征

-

动态图卷积神经网络(DGCNN)

-

正则化图神经网络(RGNN)

(五)实验过程

-

在自关注模块的轻量级使用下,过程稳定。

-

模型在250t h历元附近收敛很快。

-

我们用数据集I中的第一个主题连续训练Conformer模型2000个epoch,在单个GPU上,每个epoch的平均时间为0.27秒。

(六)消融实验

与基于cnn的方法相比,EEG Conformer的关键改进是:

-

增加了基于注意力的Transformer模块来学习全局表示。

-

数据扩充也可能对最终结果有所贡献

-

处理:自关注模块和S&R数据增强分别被删除

结果:当变压器部分被移除后,每个科目的成绩都有很大的下降。

-

科目6减少最多,为8.68%,科目3减少最少,为3.12%。平均准确率显著下降6.02% (p < 0.01)。

-

数据增强策略有助于提高我们模型的性能。与未进行数据增强的方法相比,总体性能平均提高了3.75% (p < 0.01)。

(七)参数灵敏度

细评估自关注模块中几个重要参数对性能的影响。这些包括自注意层的深度N,注意头的数量h,以及池化核的设计,池化核构建了学习全局特征的输入。

(1)深度

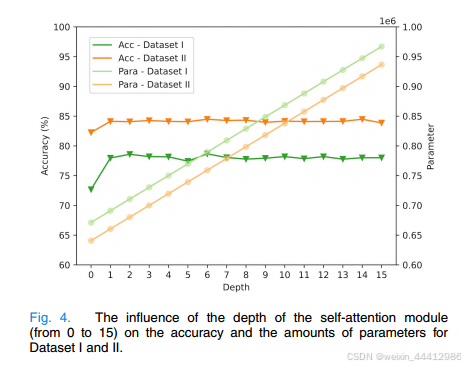

深度通常是影响端到端模型拟合能力的关键因素,如CNN和Transformer。如图4所示,我们通过将自注意模块的层数从0逐渐增加到15层来探索深度对EEG共形的影响。可以看出,

-

对于数据集I,当深度从0到1时,准确率有显著提高(p < 0.01)。说明了变压器的引入确实有助于脑电图的再次解码。对于其他深度,最高精度仅比最低精度高1.24%。差异无统计学意义(p > 0.05)。

-

数量参数的值随深度成比例增加,使得模型的成本效益降低。对数据集II的相同评价也表明Conformer对自注意深度不敏感。

(2)头部

头部是基于多头关注的常用变压器模型的一个重要参数。据报道,它可以帮助学习特征的不同方面。我们还比较了不同头像选择对模型的影响,

-

在1到40之间选择了8个头像数。从方框来看,不同的头数对结果的影响没有明确的模式。

-

不同受试者的分布无明显差异。平均精度保持温和波动,在数据集I上的范围仅为1.43%,在数据集II上的范围为1.02%。

-

随着头数的增加,性能有轻微的上升趋势,但随后下降。

-

当正面数为10时,平均准确率在数据集I中提高了0.82%,在数据集II中提高了0.50% (p > 0.05)。

-

总的来说,头部数量的变化尚未显示出对提示特征学习的显著影响。

(3)内核大小

图7所示。t-SNE可视化说明了引入Transformer进行特征学习的重要性。不同的颜色代表不同的类别。

-

由池化内核确定的令牌也是自关注模块的一个关键因素。如果内核大小太大,时间特征就会过于平滑而失去有用的细节。因此,模型很难感知细节之间的全局关系。

-

相反,如果核太小,性能容易受到局部噪声的影响。我们比较了不同池化内核选择对模型性能的影响,如图6所示。

-

内核大小从15到135,间隔为10。很明显,当内核大小开始增长时,平均精度会有实质性的提升。通过将核数从15增加到45,在数据集I上获得了13.08% (p < 0.01)的增益。

-

之后,结果趋于平缓,不会随着内核大小的增加而明显增加。实验表明,对于低信噪比的脑电图,在足够大的脑片上应用自注意是有意义的。

四、实验可视化

1.t-SNE[44]的深度特征

-

特征分布: 在使用Transformer和不使用Transformer进行充分训练后,Dataset I中Subject 1的特征分布如图7所示。我们可以看到,对于训练数据,在没有Transformer的帮助下,不同类别的特征是比较接近的。

-

加入Transformer后,类别间距离变大,类别内距离变小,如图7(b)所示。另一方面,在没有Transformer的情况下,类别之间的混叠很明显,这使图7(d)中的类别边界更加清晰。

2.t-SNE[44]的地形反映的时空特征

-

RAW :对每个受试者所有试验的原始脑电图图进行平均,

-

CAM:输入脑电图上Transformer模块的类激活图,

-

类激活图(CAT):显示CAM加权脑电图。原始数据显示,

-

在整个试验过程中,许多区域都处于激活状态。

-

CAM表明,我们的模型在时域中对不同范围的关注是不同的。

-

CAT显示了我们的模型专注于运动图像数据中的运动皮层区域。

-

全局表征:引入Transformer学习EEG数据的全局时间依赖关系,从时间序列中定位更重要的信息用于解码任务。我们使用地形和梯度加权类激活映射(Gradient-weighted Class Activation Mapping, CAM)[45]来展示我们的模型在图8中使用运动图像数据集学习到的全局表示

-

图中的第一行表示每个受试者的所有训练试验对地形取平均值。在不同的研究对象之间没有明显的大脑活动区域的线索。采用CAM监测自注意模块对EEG特征关注的时间段,如图8第二行所示。在运动想象过程中,EEG数据以顺时针方向向上的圆形绘制。在不同的时间呈现不同的激活。正如预期的那样,所有受试者的数据在试验开始时都是衰减的,这可能表明运动意图的延迟。

-

新的脑电可视化方法——类激活地形图(CAT)。在归一化数据与归一化CAM的乘积上绘制EEG地形图。从图8的第三行可以看出,经CAM加权后的脑电图数据大部分集中在运动皮层区域,与运动意象的范式一致[46]。

此外,想象左手运动和右手运动的原始EEG和CAT如图9所示。

我们惊奇地发现了事件相关去同步(ERD)和事件相关同步(ERS)现象。

与不规则的原始脑电图形貌相比,多例被试(如第1和第8)的CAT表现出明显的对侧激活和同侧抑制。

五、实验结论

-

Conformer,它结合了CNN和Transformer网络的优点。Conformer是一种轻量级的无需预训练的EEG解码解决方案。

-

它只采用几个步骤进行预处理,包括带通滤波和标准化,而不依赖于特定的任务。

-

具有时间和空间卷积层的卷积模块关注底层表征,考虑局部时间特征,而自关注模块进一步关注长期依赖关系,捕捉全局时间相关性。

-

Transformer模块对整个模型的贡献显著,数据增强有助于提高训练性能。

-

模型对自注意模块的深度和头数不敏感,池化层的核大小显示出明显的影响,这表明一个大的单元来应用注意力可以帮助避免局部噪声的干扰。

1481

1481

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?