[Pytorch]PyTorch使用tensorboardX(转

文章来源: https://zhuanlan.zhihu.com/p/35675109

https://www.aiuai.cn/aifarm646.html

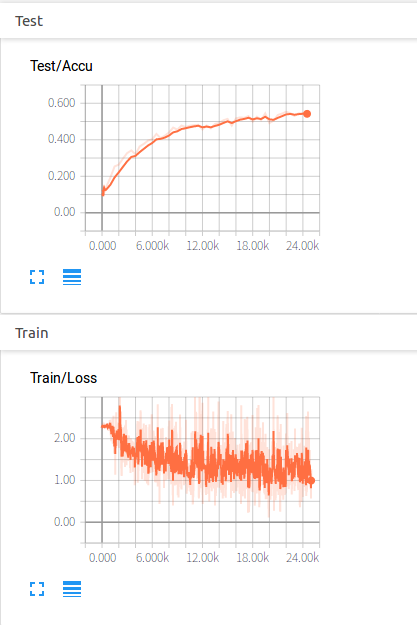

之前用pytorch是手动记录数据做图,总是觉得有点麻烦。学习了一下tensorboardX,感觉网上资料有点杂,记录一下重点。由于大多数情况只是看一下loss,lr,accu这些曲线,就先总结这些,什么images,audios以后需要再总结。

1.安装:有各种方法,docker安装,使用logger.py脚本调用感觉都不简洁。现在的tensorboardX感觉已经很好了,没什么坑。在命令行pip安装即可

pip install tensorboardX

2.调用

from tensorboardX import SummaryWriter

writer = SummaryWriter('log')

writer就相当于一个日志,保存你要做图的所有信息。第二句就是在你的项目目录下建立一个文件夹log,存放画图用的文件。刚开始的时候是空的。

训练的循环中,每次写入 图像名称,loss数值, n_iteration

writer.add_scalar('Train/Loss', loss.data[0], niter)

验证的循环中,写入预测的准确度即可:

writer.add_scalar('Test/Accu', correct/total, niter)

为了看得清楚一点,我把整个train_eval写一起了

def train_eval(epoch):

running_loss = 0.0

for i, data in enumerate(trainloader, 0):

inputs, labels = data

inputs, labels = Variable(inputs), Variable(labels)

optimizer.zero_grad()

outputs = net(inputs)

loss = criterion(outputs, labels)

loss.backward()

optimizer.step()

running_loss += loss.data[0]

#每2000个batch显示一次当前的loss和accu

if i % 2000 == 1999:

print('[epoch: %d, batch: %5d] loss: %.3f' %

(epoch + 1, i+1, running_loss / 2000))

running_loss = 0.0

print('[epoch: %d, batch: %5d] Accu: %.3f' %(epoch + 1, i+1, correct/total))

#每10个batch画个点用于loss曲线

if i % 10 == 0:

niter = epoch * len(trainloader) + i

writer.add_scalar('Train/Loss', loss.data[0], niter)

#每500个batch全验证集检测,画个点用于Accu

if i % 500 == 0:

correct = 0

total = 0

for data in testloader:

images, target = data

res = net(Variable(images))

_, predicted = torch.max(res.data, 1)

total += labels.size(0)

correct += (predicted == target).sum()

writer.add_scalar('Test/Accu', correct/total, niter)

3.显示

会发现刚刚的log文件夹里面有文件了。在命令行输入如下,载入刚刚做图的文件(那个./log要写完整的路径)

tensorboard --logdir=./log

在浏览器输入:

http://0.0.0.0:6006/

就可以看到我们做的两个图了

tensorboardX 用于 Pytorch (Chainer, MXNet, Numpy 等) 的可视化库.

类似于 TensorFlow 的 tensorboard 模块.

tensorboard 采用简单的函数调用来写入 TensorBoard 事件.

- 支持

scalar,image,figure,histogram,audio,text,graph,onnx_graph,embedding,pr_curve和videosummaries. demo_graph.py的要求:tensorboardX>=1.2,pytorch>=0.4.

安装:

sudo pip install tensorboardX

# 或

sudo pip install git+https://github.com/lanpa/tensorboardX1. TensorBoardX 使用 Demo

# demo.py

import torch

import torchvision.utils as vutils

import numpy as np

import torchvision.models as models

from torchvision import datasets

from tensorboardX import SummaryWriter

resnet18 = models.resnet18(False)

writer = SummaryWriter()

sample_rate = 44100

freqs = [262, 294, 330, 349, 392, 440, 440, 440, 440, 440, 440]

for n_iter in range(100):

dummy_s1 = torch.rand(1)

dummy_s2 = torch.rand(1)

# data grouping by `slash`

writer.add_scalar('data/scalar1', dummy_s1[0], n_iter)

writer.add_scalar('data/scalar2', dummy_s2[0], n_iter)

writer.add_scalars('data/scalar_group', {

'xsinx': n_iter * np.sin(n_iter),

'xcosx': n_iter * np.cos(n_iter),

'arctanx': np.arctan(n_iter)}, n_iter)

dummy_img = torch.rand(32, 3, 64, 64) # output from network

if n_iter % 10 == 0:

x = vutils.make_grid(dummy_img, normalize=True, scale_each=True)

本文介绍了如何使用TensorBoardX在PyTorch中进行数据可视化,包括Graph、matplotlib、nvidia-smi、embedding等不同类型的图表,便于理解和跟踪训练过程中的指标变化。

本文介绍了如何使用TensorBoardX在PyTorch中进行数据可视化,包括Graph、matplotlib、nvidia-smi、embedding等不同类型的图表,便于理解和跟踪训练过程中的指标变化。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

1775

1775

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?