概述:提出了异构图注意网络(Heterogeneous Graph ATtention networks, HGAT),在基于节点级和类型级注意的双层注意机制的基础上嵌入文本分类HIN。注意机制可以学习到不同相邻节点的重要性,以及不同节点(信息)类型对当前节点的重要性。

方法:

提出了HGAT的模型,使用异质网络的思想用于半监督的短文本分类,使用双重注意力机制,考虑A节点的不同邻居节点的不同重要程度和A节点不同类型的邻居节点的不同重要程度。

模型的总架构图:

具体的:

具体的:

三种类型的节点:

短文本、主题、实体。构建的异质网络(HIN) G = (V; E)

短文本:![]()

主题:![]()

实体:![]()

三种类型的边:

主题使用LDA挖掘,某主题ti包含单词数w,![]() ,对短文本中包含主题单词,则建立主题词和短文本之间的连线。

,对短文本中包含主题单词,则建立主题词和短文本之间的连线。

识别出实体E,使用维基百科的实体链接工具TAGME将E链接到维基百科中,如果短文本包含实体,则构建文档和实体之间的边界。

实体与实体之间:使用word2vec2学习基于维基百科语料库的实体嵌入,如果两个实体之间的相似度分数(余弦相似度),基于它们的嵌入计算,高于预定义的阈值δ,我们就在它们之间建立一条边

异质网络:

双重注意力:

1.节点层注意力:某节点邻居节点具有不同重要程度(降低噪声节点的影响)

2.类型层注意力:某节点不同类型的邻居节点具有不同的重要程度。

分类:softmax对短文本进行分类

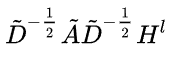

GCN的回顾:

核心思想:通过聚合周围节点信息来更新自身节点的信息。

节点更新公式:

A:邻接矩阵

D:度矩阵

H:输入的特征矩阵

W:可学习参数矩阵

具体的公式变换请参考原文

具体的公式变换请参考原文

两层GCN模型

X[N,M](N个节点,M维特征) A=[N,N] W0=[M,H]

W1=[H,F] F为标签数量,接入softmax可得出每个标签的分类概率。

由于GCN没有考虑不同类型节点的不同性质,不适用于本篇不同类型节点和边。

异质网络:

向量的初始特征表示:(模型的输入)

短文本:TF-IDF

主题词:one-hot

实体表示:文本中的embedding || 维基百科中的描述的TF-IDF)(拼接操作)

![]() 行表示所有节点,列表示关系

行表示所有节点,列表示关系下的节点。

![]() 初始为特征向量。

初始为特征向量。

双重注意力机制:

类型层的注意力计算方法:

初始节点为v,和它相邻的类型为的邻居节点有v' 。这些节点的特征表示为:

![]()

然后计算和初始节点的注意力权重:

![]()

µτ是下的注意力向量 σ(·)是激活函数 ||拼接

最后对所有的关系类型,使用softmax进行归一化,公式如下:

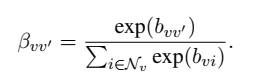

节点层的注意力计算方法:

首先设定类型下的节点v和

’类型下的节点v'为邻居。他们的节点注意力权重计算为:

![]()

归一化节点注意力评分函数:

合并双层注意力机制得到最终公式为:

Bτ 注意力的混淆矩阵,v行v'列的βvv‘

训练:

![]()

数据处理方面:

1.移除非英文字符 2.删除停止词 3.删除频率低于5的词

HGAT参数设定:

1.神经元512 2.词嵌入维度100 3.learning-rate=0.005 4.dropout=0.8

5.正则化因子the regularization factor η = 5e-6. 6.采取早期停止防止过拟合

307

307

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?