本文为下述视频的笔记:

【论文复现代码数据集见评论区】5小时精讲 Paper,BAT大厂导师带你吃透NLP自然语言处理的经典模型Word2vec_哔哩哔哩_bilibili

论文:

目录

1. 词向量储备知识

语言模型

概念:语言模型是计算一个句子是句子的概率的模型

基于专家语法规则的语言模型:语言学家企图总结出一套通用的语法规则,比如形容词后面接名词

统计语言模型:通过概率计算来刻画语言模型

用语料的频率代替概率 N表示语料中不去重词的总数 N1代表1个词,N2代表连续的2个词

N2=N1-1

已知词wi-1 求之后出现词wi的概率 -> 条件概率

因为count(wi-1) >= count(wi-1,wi),所以P的值处于0到1 之间

统计语言模型中的平滑操作:有一些词或者词组在语料中没有出现,但是不代表它不存在。平滑操作就是为那些没有出现过的词或词组也给一个比较小的概率。

Laplace Smoothing (或 加1平滑):每个词在原来出现次数的基础上加1

此时,

平滑操作的问题:参数空间过大;数据稀疏严重

假设语料库中没有“帅”和“桌子”,

- unigram:

下一个词的出现不依赖于前面的词

- bigram:

下一个词的出现依赖于前面的一个词

- trigram:

下一个词的出现依赖于前面的两个词

- k-gram:

下一个词的出现依赖于前面的k-1个词

语言模型评价指标:困惑度(Perplexity)

开n次方可以忽略句子的长短,长句出现的概率相对较小

句子概率越大,语言模型越好,困惑度越小

2. 论文模型导读

词的表示 word representation

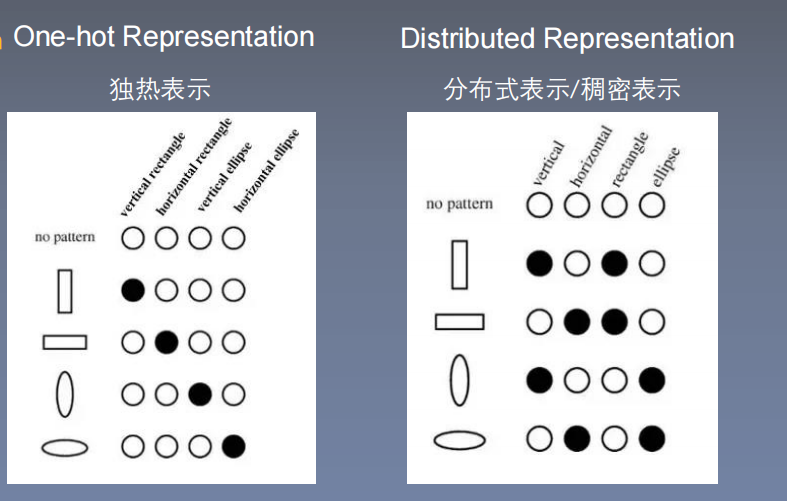

one-hot representation (独热表示):

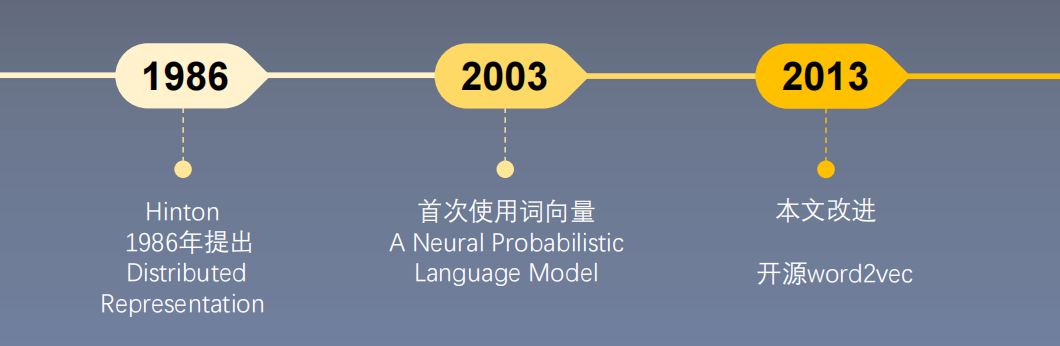

发展历程

研究成果

- 提出新的模型结构

- 提出优化训练的方法,使得训练速度加快

- 给出训练代码word2vec,使得单机训练成为可能

- 成果:训练的词向量,又快又好

研究意义

衡量词向量之间的相似程度

词类比analogy

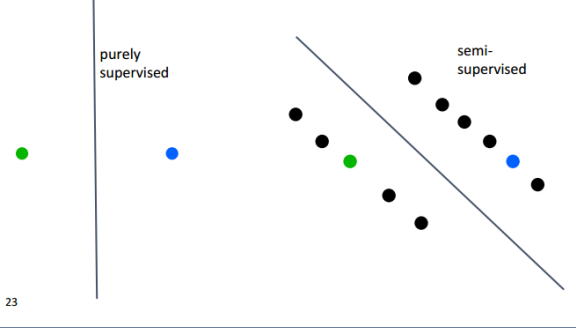

作为预训练模型提升nlp任务:外部任务如命名实体识别、文本分类;应用到其他nlp任务上,相当于半监督训练(减少过拟合,提高模型的泛化程度)

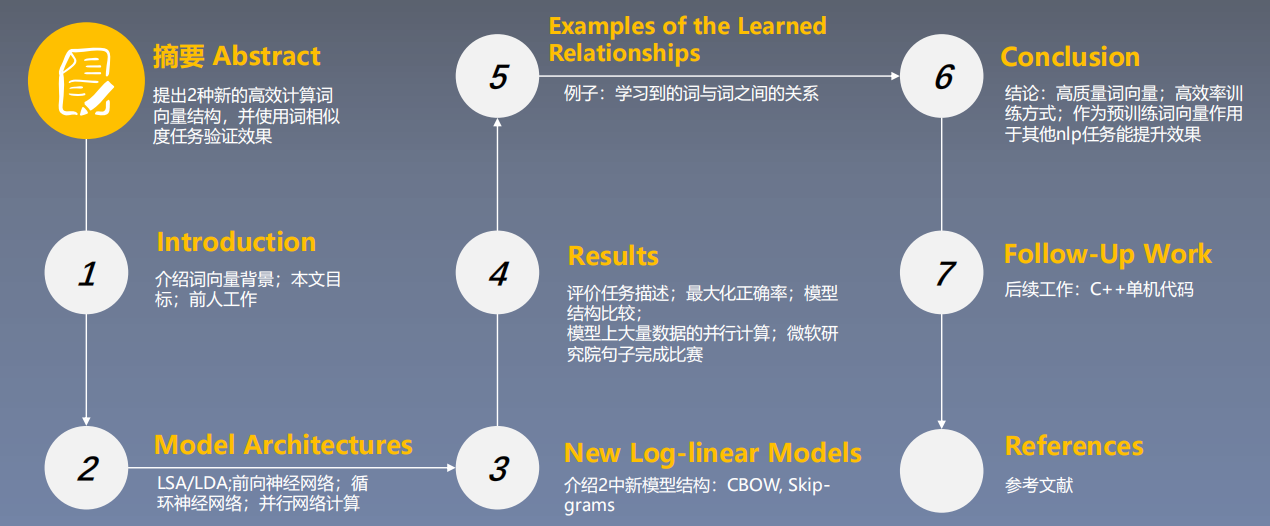

论文总览

摘要

摘要核心:

- 提出了两种新颖的模型结构用来计算词向量

- 采用一种词相似度的任务来评估对比词向量质量

- 大量降低模型计算量可以提升词向量质量

- 进一步,在我们的语义和句法任务上,我们的词向量是当前最好的效果

论文小标题:

1. Introduction

介绍 Introduction

- 传统NLP把词当成最小单元处理,并且能够在大语料上得到很好的结果,其中一个例子是N-gram

- 然而这种方法在许多任务中有其局限性,很多nlp任务只能提供很小的语料,如语音识别、机器翻译,所以简单的扩大数据规模来提升简单模型的表现在这些任务上不再适用,必须寻找更先进的模型

- 数据量较大时,可以采用分布式表示方法,如语言模型的分布式表示效果会超过 N-gram

Word2Vec 评价方法

- 内在评估方法,直接评估词语之间的相似性

- 外在评估方法,通过下游任务的表现来间接评估

3. 前人提出的相关模型及其复杂度

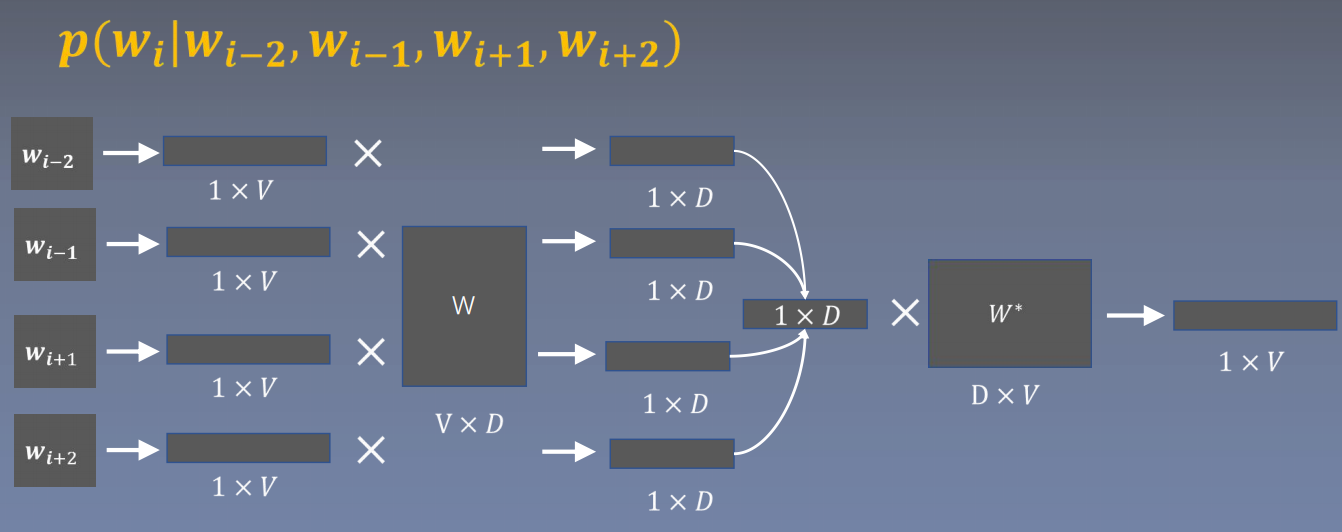

NNLM 前馈神经网络语言模型

n-gram: 根据前n-1个单词,预测第n个位置单词的概率

输入层: 输入每个单词的index,将每个index映射成一个向量,相当于一个1XV的one-hot向量乘以一个VXD的矩阵(该矩阵随机初始化,后续通过训练来更新)得到一个1XD的向量,然后将这些向量concat成一个向量

隐藏层:一个以tanh为激活函数的全连接层

输出层:一个全连接层,后面接一个softmax函数(将每个数归一化成0到1之间的数,并且这些数相加为1)来生成概率分布。,其中y是一个1XV的向量:

语言模型困惑度和Loss的关系:

Loss:

如何改进/改进方向:

- 仅对一部分输出进行梯度传播。

- 引入先验知识,如词性等。

- 解决一词多义问题。

- 加速softmax层

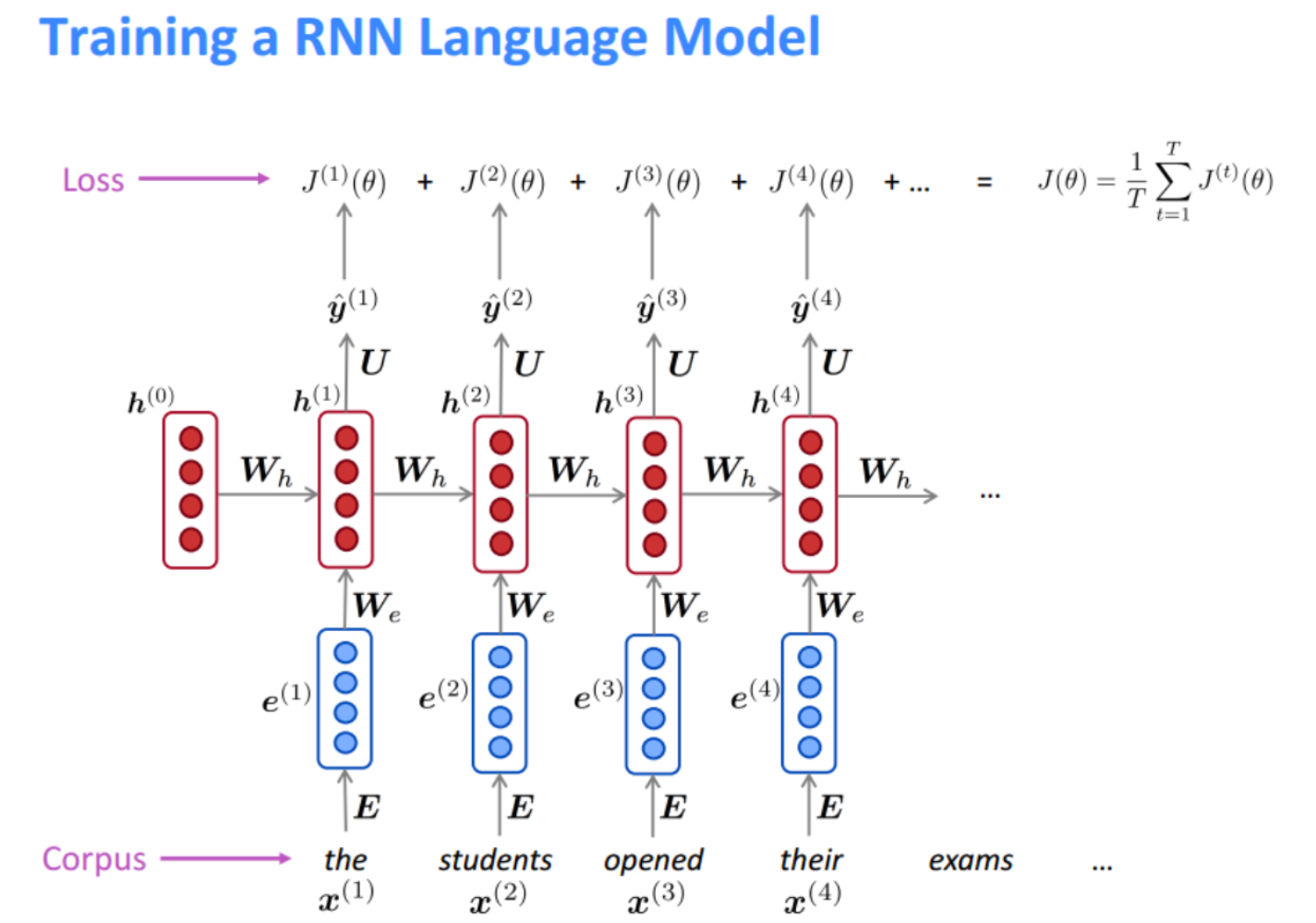

RNNLM 循环神经网络语言模型

每个时间步预测一个词,在预测第n个词的时候使用了前n-1个词的信息

输入层:和NNLM一样,需要将当前时间步的单词转换为词向量

隐藏层:对输入和上一个时间步的隐藏输出进行全连接层操作:

输出层:一个全连接层,后面接一个softmax函数(将每个数归一化成0到1之间的数,并且这些数相加为1)来生成概率分布。,其中y是一个1XV的向量:

Loss:

4. 模型精讲

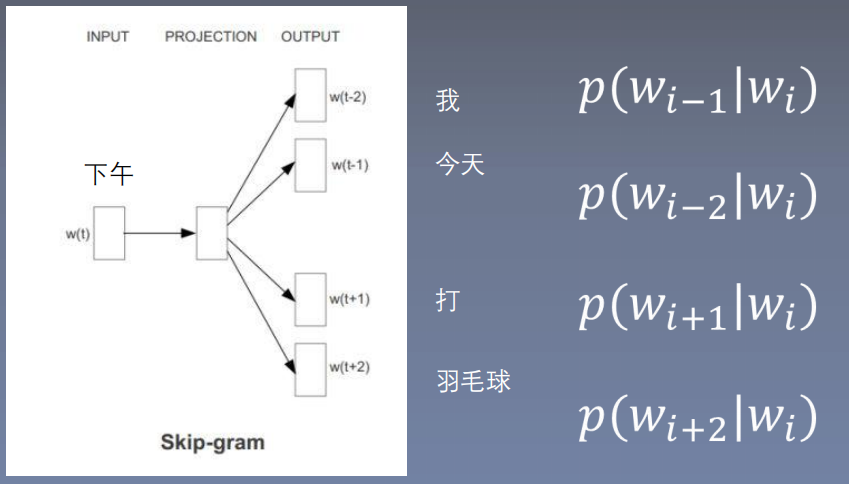

skip-gram

Log-linear model: 将语言模型的建立看成一个多分类问题,相当于线性分类器加上softmax

语言模型的基本思想:句子中下一个词的出现和前面的词是有关系的,所以可以使用前面的词预测下一个词

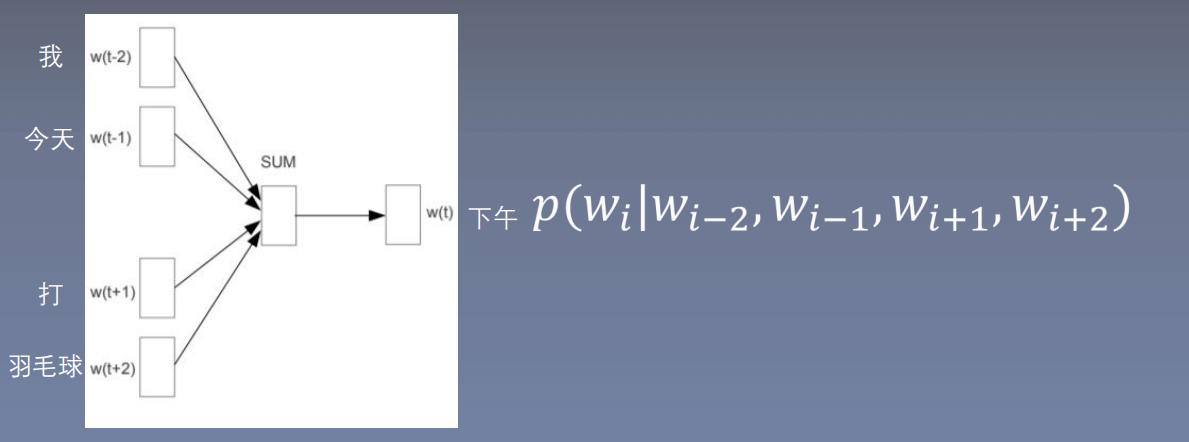

Word2Vec基本思想:句子中相近的词之间是有联系的,比如今天后面经常出现上午、下午和晚上。所以Word2Vec基本思想就是用词来预测词,skip-gram使用中心词预测周围词,cbow使用周围词预测中心词

skip-gram原理:看作多分类问题input:wi,label:wi-1,wi-2,wi+1,wi+2

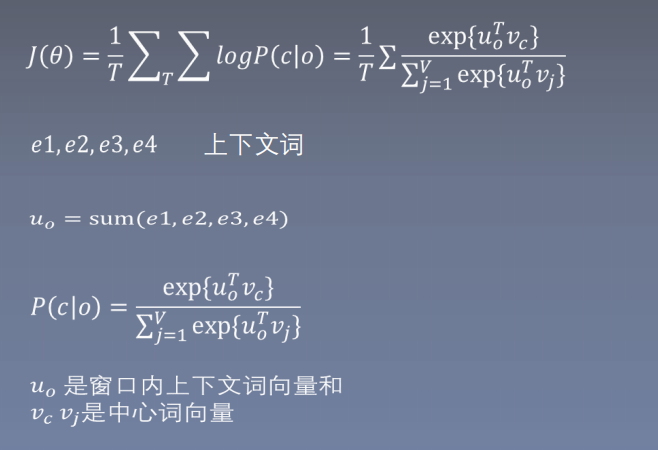

cbow

5. 效率提高的关键技术

层次softmax

word2vec原理(二) 基于Hierarchical Softmax的模型 - 刘建平Pinard - 博客园

负采样 (效果更好)

word2vec原理(三) 基于Negative Sampling的模型 - 刘建平Pinard - 博客园

435

435

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?