研究问题:

- 主流的基于对抗的方法在适应过程中通常会忽略分类器,而且对分类没有影响的背景特征也得到了适应。

- 存在标签分布偏移( LDS ),源数据集可能是均匀分布的,但目标数据集中某些类可能存在样本不均衡,部分类样本过多或过少。

研究假设:

研究思路及方法:

- 引入了基于分类器的反向传播算法诱导的特征空间加权。(分类损失反向传播到特征层)

- 使用一种迭代的标签分布对齐方法。(伪标签由上一次预测和当前预测加权)

研究基础:

网络结构:基于DANN

移动语义损失:在MSTN(Learning Semantic Representations for Unsupervised Domain Adaptation,2018)上添加了一个损失来惩罚不同类的相似表示(使用了类间损失来扩大不同类之间的距离,没具体看,有点像MCC损失)。

备注:

大概阅读了文章,创新点反向传播分类的误差挺有意思的,强调对分类重要的特征,同时衰减不相关的特征。

全文翻译如下:

摘要

对大规模标注数据集的需求是训练精确深度神经网络的限制因素之一。无监督域适应通过将知识从一个有很多标记数据的域迁移到另一个几乎没有标记数据的域来解决训练数据有限的问题。一种常用的方法是学习领域不变的特征,例如采用对抗的方法。以往的方法往往将领域分类器和标签分类器网络分开训练,两种分类网络之间的交互较少。在本文中,我们引入了基于分类器的反向传播算法诱导的特征空间加权。这种方法主要有两个优点。首先,它让领域分类器关注对分类重要的特征;其次,它将分类和对抗分支更紧密地耦合在一起。进一步,我们介绍了一种迭代的标签分布对齐方法,该方法利用先前运行的结果来近似类平衡的数据加载器。我们在三个基准测试Office - 31、OfficeHome和DomainNet上进行实验和消融研究,以表明我们提出的算法的有效性。

1 Introduction

深度学习的一个主要问题是需要大量有标签的训练数据才能得到准确的模型。标注训练数据的过程繁琐,需要大量的人工劳动。克服这一问题的一个研究分支是无监督域适应( UDA )。UDA试图利用一个已经存在的有标签(源)数据集到一个与源数据集具有某些相似性的无标签(目标)数据集。例如,计算机生成的CAD数据图片可以用来识别现实世界中的物体。然而,由于源数据和目标数据之间存在巨大的差异,即领域鸿沟,简单地在源数据集上进行训练会得到次优的结果。

克服域鸿沟的一种方法是训练域不变特征,即源域和目标域都可用的特征。一种常见的方法是使用对抗训练,其中训练一个域分类器来估计样本的特定域,同时训练特征提取器使提取的特征对域分类器不可区分。然而,这种方法在适应过程中通常会忽略分类器。此外,对分类没有影响的图片背景特征也得到了适应,这可能导致较低的准确率。为了克服这个问题,我们提出了反向传播算法诱导的特征空间加权。

域适应的另一个问题是标签分布偏移( LDS )。虽然源数据集可能是以均匀分布的方式创建的,但在目标数据集中,某些类可能是过度表示或表示不足的。这种失准会导致早期的适应误差,这种误差会随着训练的进行而累积。均衡的数据加载器为每个类等量地加载训练数据可以缓解这个问题,但由于目标数据的标签未知,这是不可行的。一种可能的解决方案是在训练过程中为目标数据加载器估计伪标注,并使用它们来平衡数据加载器。然而,由于伪标注是有噪声的,特别是在训练初期,这种策略可能会导致早期错误的积累。相比之下,我们提出了一种迭代适应范式。我们从头开始训练网络进行多次运行,其中每次新运行都使用前一次运行的预测标签,以实现更加均衡的数据加载器(第一次运行时使用随机数据加载器)。这种方法的主要优点是,即使在跑步训练的开始阶段,也可以获得相对准确的伪标注。

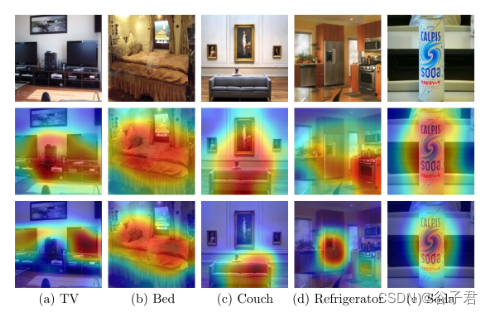

图一:对抗网络中对齐的特征的热图。第一行显示原始图像。第二行显示了DANN的热图[ 6 ],而最后一行显示了我们提出的反向传播权重方法的热图。网络改编自OfficeHome数据集的任务Art to Real World。在不使用权重的情况下,对抗网络关注图像的大部分,包括背景。加权使得对抗网络主要关注前景对象。

我们的主要贡献是:

- 我们引入了反向传播指导的特征空间加权。这让我们强调了用于分类的重要特征,也将分类器与对抗域适应过程更紧密地耦合在一起。

- 我们引入了迭代标签偏移对齐范式来近似平衡的目标数据加载器。迭代范式允许我们通过提供可靠的伪标注来避免早期失调误差的积累,即使在运行的训练开始阶段。

- 我们在三个数据集( Office - 31、Office - Home和DomainNet)上展示了我们算法的有效性,并进一步评估了不同方法在消融研究中的贡献。

2 Related Work

无监督域适应( UDA )的一种常用方法是提取域不变特征,即跨域共享的特征。这可以通过对抗的方法来实现。域对抗神经网络( Domain-adversarial neural network,DANN ) [ 6 ]使用域分类器来区分图像属于源域还是目标域。通过使用梯度反转层来训练特征提取器,以提取领域分类器无法区分的特征,从而提取领域不变特征。条件域对抗网络( Conditional Domain Adversarial Network,CDAN ) [ 16 ]对该方法进行了扩展,通过分类器预测对域分类器进行多线性条件化。许多对抗方法建立在DANN或CDAN上。文献[ 18 ]介绍了一种针对CDAN的光谱自适应。文献[ 8 ]在DANN中加入组和类域分类器,并同步不同域分类器之间的梯度。移动语义迁移网络[ 26 ]对DANN进行了移动语义损失扩展。该方法为特征空间中的两个域和每个类创建类表示,在训练过程中随着每个样本进行更新。将类的源和目标特征表示之间的距离作为域适应损失。

我们的方法基于DANN。此外,我们还使用了[ 26 ]中的移动语义损失,然而,受到当前聚类方法[ 10 ] [ 23 ]的启发,我们进一步添加了一个损失来惩罚不同类的相似表示。

最近的研究将神经网络的注意机制纳入到领域适应任务中。文献[ 21 ]表明,分类器的梯度可以用于可视化网络对分类输出的注意力。针对域适应,文献[ 13 ]提出了一种域条件信道注意力机制。与我们提出的反向传播算法诱导的特征加权最相似的可能是[ 11 ]。在他们的工作中,作者专注于识别可以更好地采用的区域。特别地,反向传播算法引入领域预测不确定性,以强调分类器采用良好的区域。

与此相反,在我们的工作中,我们反向传播分类错误,以强调对分类重要的特征,同时衰减不相关的特征。这让对抗分支更专注于图像的相关部分。

除了领域鸿沟,适应过程的另一个问题是源和目标数据集的标签分布可能存在巨大差异。文献[ 9 ]提出了一种基于采样的隐式对齐方法。[ 25 ]引入了平衡因子来缓解标签分布的差异。文献[ 28 ]引入类特定辅助权重来克服类先验概率的变化。文献[ 29 ]提出了一种基于领域相似度和每个样本预测不确定性的加权机制。然而,同时处理标签和域偏移问题会导致由早期错误匹配引起的误差累积,特别是在训练早期很难鲁棒地估计目标标签。为了避免这种错误的积累,我们选择了一个迭代过程,其中网络从头开始训练连续运行数次。每个新运行都使用上一次运行的伪标注。这意味着即使在运行的早期训练阶段,数据加载器也可以获得可靠的伪标注。

3 Methodology

在无监督域适应中,任务是减轻源域和目标域之间的域偏移。对于源域 D s \mathcal{D}_s Ds,给定一组 n s n_s ns个标记样本 D s = ( x i , s , y i , s ) i = 1 n s \mathcal{D}_s=\left(x_{i, s}, y_{i, s}\right)_{i=1}^{n_s} Ds=(xi,s,yi,s)i=1ns ,其中 x i , s x_{i, s} xi,s捐赠一个具有相应标记 y i , s y_{i, s} yi,s的样本。对于目标域 D t \mathcal{D}_t Dt ,只给出样本,没有任何标签 D t = ( x i , t ) i = 1 n t \mathcal{D}_t=\left(x_{i, t}\right)_{i=1}^{n_t} Dt=(xi,t)i=1nt。目标是通过利用相似但不同的共享特征空间来估计目标域 y i , t y_{i, t} yi,t的标签。在我们的工作中,我们处理vanilla或密集分布设置,其中源域和目标域具有相同的标签类 C s = C t \mathcal{C}_s=\mathcal{C}_t Cs=Ct。

在我们的工作中,我们使用了三种损失的组合,源域样本的分类损失 L c L_c Lc,对抗损失 L d L_d Ld和移动语义损失 L M S L_{M S} LMS。对于对抗损失,我们将DANN [ 6 ]中引入的对抗网络与我们提出的反向传播加权相结合。移动语义损失是在MSTN [ 26 ]的基础上进行的,但是我们使用了类间损失来扩大不同类之间的距离。

此外,我们引入了一种迭代策略来处理标签分布偏移。特别地,网络从头开始训练若干次运行,其中每次运行使用前一次运行的目标数据预测,以实现类平衡的数据加载器。我们方法的流程如图2所示。此外,我们方法的伪算法可以在Alg1中看到。

图2:我们提出的方法的流程。我们采用三种损失来训练网络。对于对抗损失,我们根据特征空间对分类器的重要性进行加权。特别地,我们将分类损失反向传播到特征层,归一化梯度并将其作为权重向量。进一步,在对网络进行单次运行训练后,利用目标域的预测标签初始化下一次运行的数据加载器,实现类平衡的数据加载器。

3.1. Backpropagation induced importance weighting

我们的网络由一个特征提取器 G f G_f Gf组成,它将输入的 x i x_i xi映射到特征空间 f i f_i fi

f i = G f ( x i ) f_i=G_f\left(x_i\right) fi=Gf(xi)

从特征空间 f i f_i fi开始,网络分裂为两个分支。第一个分支,即分类分支 G c G_c Gc,估计给定特征 f i f_i fi的类别标签概率 p ( y i ) p\left(y_i\right) p(y

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

1320

1320

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?