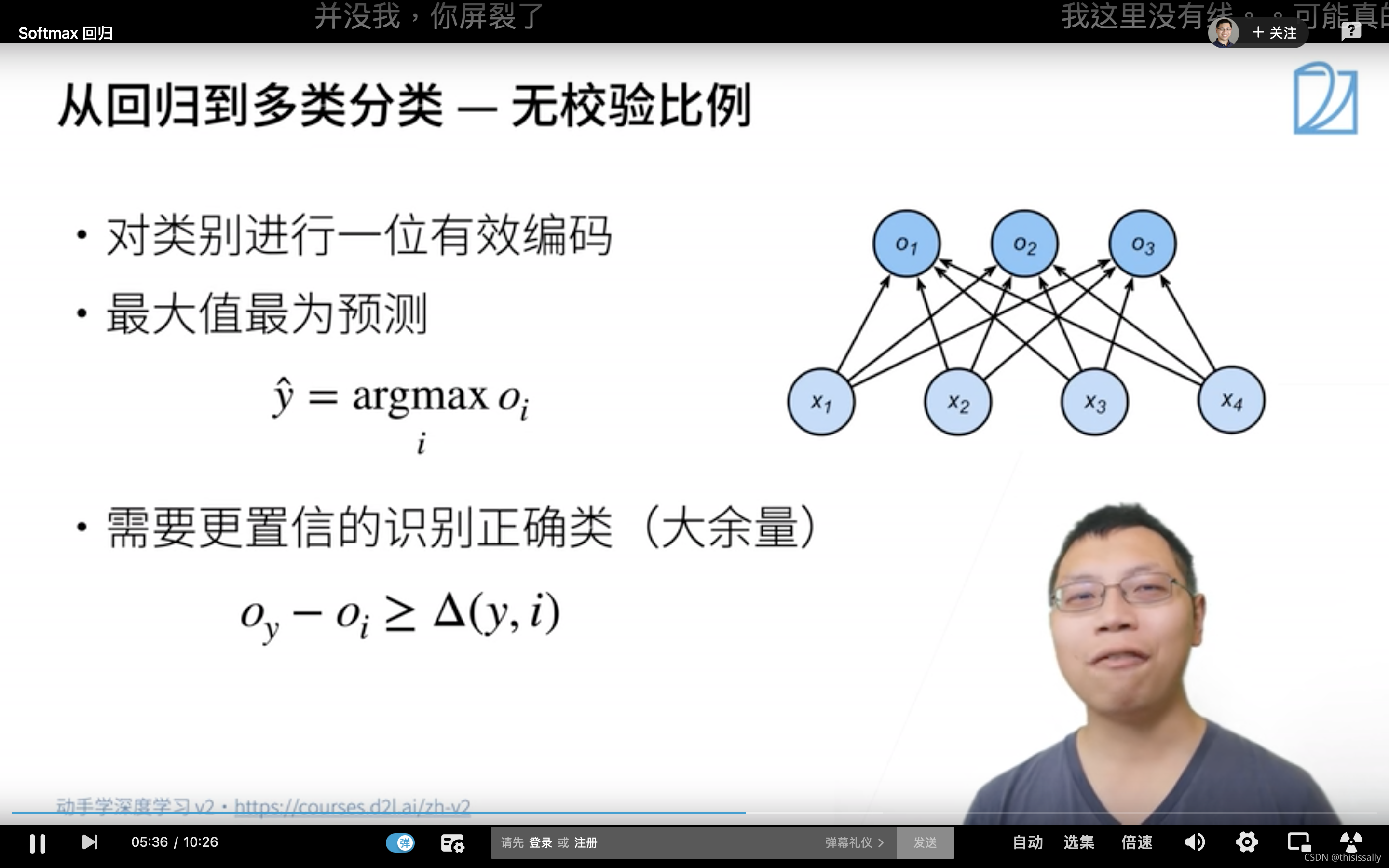

一、分类问题的目标

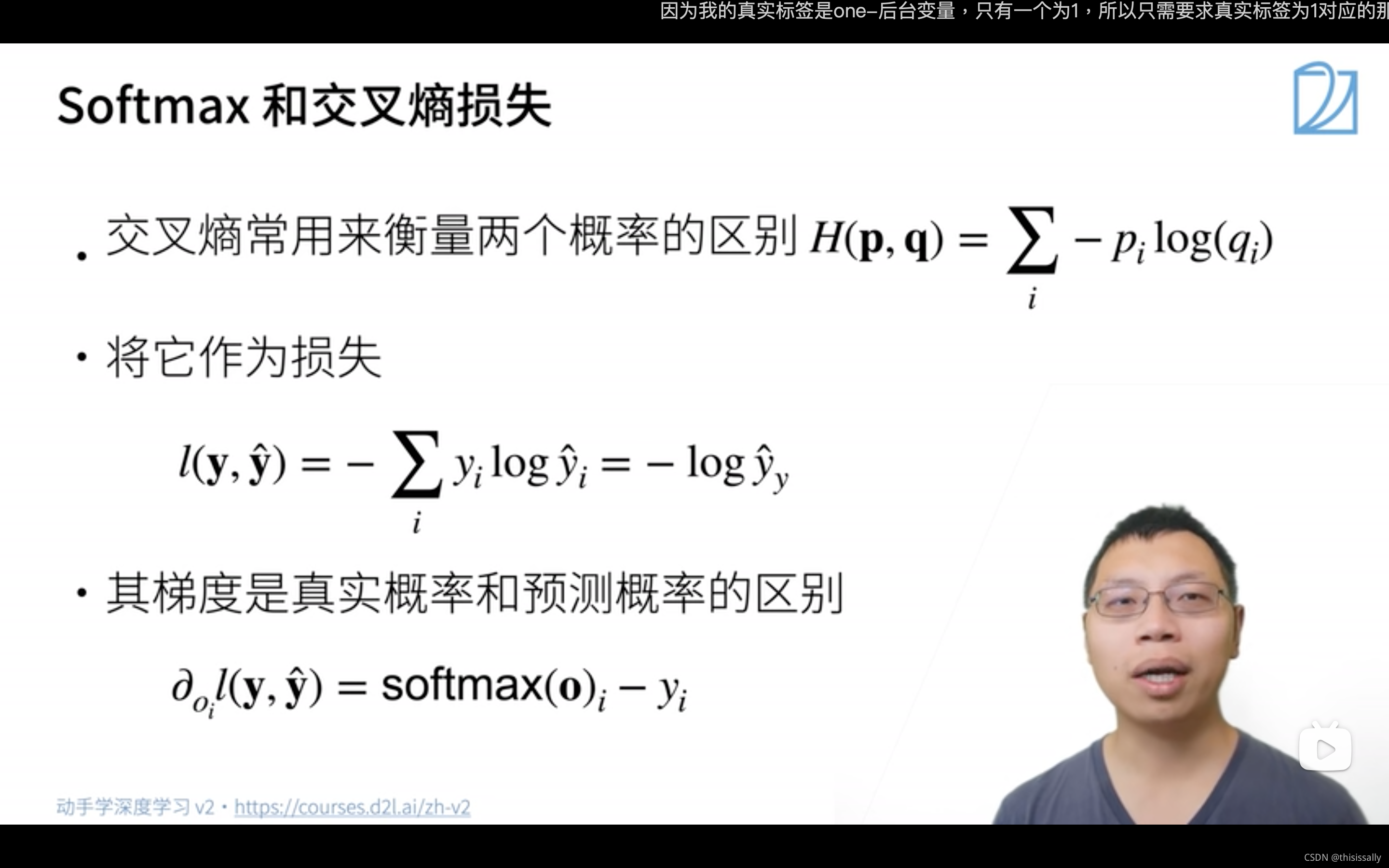

- 希望识别正确的概率越大越好,与其他类的差别越大越好。

- 概率的表示用softmax函数。

- 概率的差别的表示用交叉熵。

二、激活函数的作用

激活函数就是在原来的线性组合的基础上加上非线性函数,让模型的表达能力更强。因为线性模型的表达能力非常有限,分类时也只能划一条线来划分。

三、sigmoid和softmax的差别

二者都是在神经网络中引入非线性因素。softmax一般用于多分类的结果,一般和one-hot的真实标签值配合使用,大多数用于网络的最后一层;而sigmoid是原本一种隐层之间的激活函数,但是因为效果比其他激活函数差,目前一般也只会出现在二分类的输出层中,与0 1真实标签配合使用。

不过sigmoid函数目前用的也不多,大多数情况还是用Relu函数。

四、Relu函数

(一)什么是Relu函数?

(二)Relu函数的作用

Relu实质就是个取最大值的函数。

输入是负值的情况下,它会输出0,那么神经元就不会被激活。这意味着同一时间只有部分神经元会被激活,从而使得网络很稀疏,进而对计算来说是非常有效率的。)

之所以神经元稀疏更有效,理论上是因为可以集中注意力在挖掘和目标相关的特征上,提升效率;计算上不需要用到指数计算,比sigmoid快很多。

Relu的缺点是,神经元很容易die,因此需要设置较小的learning rate,尽量避免此类问题。

3161

3161

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?