目录

sigmoid 函数:

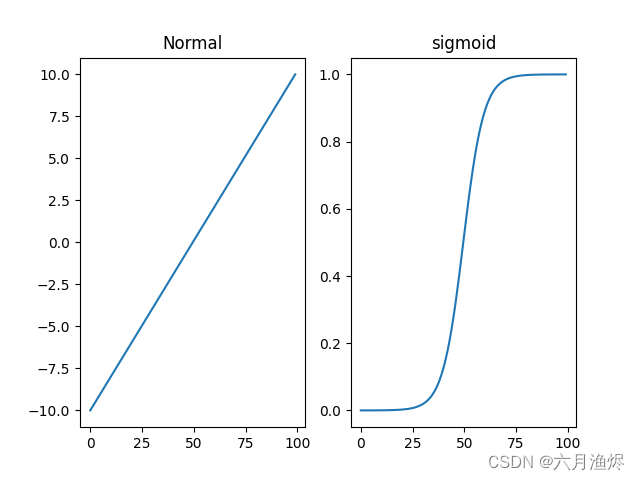

sigmoid 函数的作用原理很简单:将所有数限制在 0 ~ 1 范围内

我们可以直接利用 torch 模块利用 sigmoid 函数处理数据:

y = torch.sigmoid(x)或:

y = x.sigmoid()我们也可以利用 matplotlib 模块更直观地观察经由 ReLU 函数处理前后的数据(图像中的数据可以自由更改):

import matplotlib.pyplot as plt

import torch

x = torch.linspace(-10,10,100)

z = x.sigmoid()

plt.subplot(1,2,1),plt.plot(x),plt.title('Normal')

plt.subplot(1,2,2),plt.plot(z),plt.title('sigmoid')

plt.show()

ReLU 函数:

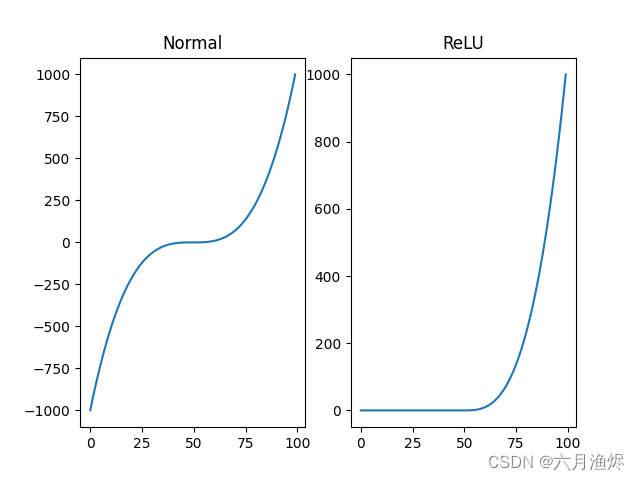

ReLu(rectified linear unit)函数的作用原理比 sigmoid 函数还要简单(这也是它在如今逐渐取代 sigmoid 函数的原因):非负数保留,负数归零

我们可以直接利用 torch 模块来利用 ReLU 函数处理数据:

y = torch.relu(x)或:

y = x.relu()我们也可以利用 matplotlib 模块更直观地观察经由 ReLU 函数处理前后的数据(图像中的数据可以自由更改):

import matplotlib.pyplot as plt

import torch

x = torch.linspace(-10,10,100)

y = pow(x,3)

z = y.relu()

plt.subplot(1,2,1),plt.plot(y),plt.title('Normal')

plt.subplot(1,2,2),plt.plot(z),plt.title('ReLU')

plt.show()

tanh 函数:

tanh 函数是双曲正切函数,它的原理也很简单,且与 sigmoid 函数很类似(它的图像形状也很像 sigmoid 函数):将所有数限制在 -1 ~ 1 范围内

我们可以直接利用 torch 模块利用 sigmoid 函数处理数据:

y = torch.tanh(x)或

y = x.tanh()我们也可以利用 matplotlib 模块更直观地观察经由 ReLU 函数处理前后的数据(图像中的数据可以自由更改):

import matplotlib.pyplot as plt

import torch

x = torch.linspace(-10,10,100)

z = x.tanh()

plt.subplot(1,2,1),plt.plot(x),plt.title('Normal')

plt.subplot(1,2,2),plt.plot(z),plt.title('sigmoid')

plt.show()

1万+

1万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?