文章目录

前置要求

Hadoop集群启动Kerberos认证

按照上述步骤为Hadoop集群开启Kerberos安全认证。

创建Hive系统用户和Kerberos主体

1,创建系统用户

[root@hadoop102 ~]# useradd hive -g hadoop

[root@hadoop102 ~]# echo hive | passwd --stdin hive

[root@hadoop103 ~]# useradd hive -g hadoop

[root@hadoop103 ~]# echo hive | passwd --stdin hive

[root@hadoop104 ~]# useradd hive -g hadoop

[root@hadoop104 ~]# echo hive | passwd --stdin hive

2,创建Kerberos主体并生成keytab文件

创建hive用户的Kerberos主体

[root@hadoop102 ~]# kadmin -padmin/admin -wadmin -q"addprinc -randkey hive/hadoop102"

在Hive所部署的节点生成keytab文件

[root@hadoop102 ~]# kadmin -padmin/admin -wadmin -q"xst -k /etc/security/keytab/hive.service.keytab hive/hadoop102"

3,修改keytab文件所有者和访问权限

[root@hadoop102 ~]# chown -R root:hadoop /etc/security/keytab/

[root@hadoop102 ~]# chmod 660 /etc/security/keytab/hive.service.keytab

配置认证

1,修改$HIVE_HOME/conf/hive-site.xml文件,增加如下属性

[root@hadoop102 ~]# vim $HIVE_HOME/conf/hive-site.xml

<!-- HiveServer2启用Kerberos认证 -->

<property>

<name>hive.server2.authentication</name>

<value>kerberos</value>

</property>

<!-- HiveServer2服务的Kerberos主体 -->

<property>

<name>hive.server2.authentication.kerberos.principal</name>

<value>hive/hadoop102@EXAMPLE.COM</value>

</property>

<!-- HiveServer2服务的Kerberos密钥文件 -->

<property>

<name>hive.server2.authentication.kerberos.keytab</name>

<value>/etc/security/keytab/hive.service.keytab</value>

</property>

<!-- Metastore启动认证 -->

<property>

<name>hive.metastore.sasl.enabled</name>

<value>true</value>

</property>

<!-- Metastore Kerberos密钥文件 -->

<property>

<name>hive.metastore.kerberos.keytab.file</name>

<value>/etc/security/keytab/hive.service.keytab</value>

</property>

<!-- Metastore Kerberos主体 -->

<property>

<name>hive.metastore.kerberos.principal</name>

<value>hive/hadoop102@EXAMPLE.COM</value>

</property>

2,修改$HADOOP_HOME/etc/hadoop/core-site.xml文件,具体修改如下

[root@hadoop102 ~]# vim $HADOOP_HOME/etc/hadoop/core-site.xml

1)删除以下参数

<property>

<name>hadoop.http.staticuser.user</name>

<value>root</value>

</property>

<property>

<name>hadoop.proxyuser.root.hosts</name>

<value>*</value>

</property>

<property>

<name>hadoop.proxyuser.root.groups</name>

<value>*</value>

</property>

<property>

<name>hadoop.proxyuser.root.users</name>

<value>*</value>

</property>

2)增加以下参数

<property>

<name>hadoop.proxyuser.hive.hosts</name>

<value>*</value>

</property>

<property>

<name>hadoop.proxyuser.hive.groups</name>

<value>*</value>

</property>

<property>

<name>hadoop.proxyuser.hive.users</name>

<value>*</value>

</property>

3,分发配置core-site.xml文件

[root@hadoop102 ~]# xsync $HADOOP_HOME/etc/hadoop/core-site.xml

4,重启Hadoop集群

[root@hadoop102 ~]# stop-dfs.sh

[root@hadoop103 ~]# stop-yarn.sh

[root@hadoop102 ~]# start-dfs.sh

[root@hadoop103 ~]# start-yarn.sh

启动hiveserver2

注:需使用hive用户启动

[root@hadoop102 ~]# sudo -i -u hive hiveserver2

Hive Kerberos认证使用说明

以下说明均基于普通用户

beeline客户端

1,认证,执行以下命令,并按照提示输入密码

[luanhao@hadoop102 ~]$ kinit luanhao

2,使用beeline客户端连接hiveserver2

[luanhao@hadoop102 ~]$ beeline

使用如下url进行连接

!connect jdbc:hive2://hadoop102:10000/;principal=hive/hadoop102@EXAMPLE.COM

3,测试查询

0: jdbc:hive2://hadoop102:10000/> select current_user();

DataGrip客户端

新建Driver

2,配置Driver

新建连接

1,创建连接

2,配置连接

1)基础配置

注:

url:jdbc:hive2://hadoop102:10000/;principal=hive/hadoop102@EXAMPLE.COM

2)高级配置

注:

配置参数:

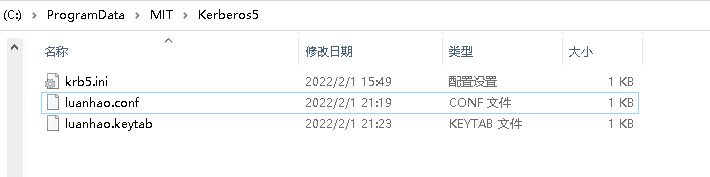

-Djava.security.krb5.conf="C:\\ProgramData\\MIT\\Kerberos5\\krb5.ini"

-Djava.security.auth.login.config="C:\\ProgramData\\MIT\\Kerberos5\\luanhao.conf"

-Djavax.security.auth.useSubjectCredsOnly=false

3)编写JAAS(Java认证授权服务)配置文件,内容如下,文件名和路径须和上图中java.security.auth.login.config参数的值保持一致。

在 “C:\ProgramData\MIT\Kerberos5” 目录下 新建luanhao.conf 文件 ,添加如下内容

com.sun.security.jgss.initiate{

com.sun.security.auth.module.Krb5LoginModule required

useKeyTab=true

useTicketCache=false

keyTab="C:\\ProgramData\\MIT\\Kerberos5\\luanhao.keytab"

principal="luanhao@EXAMPLE.COM";

};

4)为用户生成keytab文件,在krb5kdc所在节点(hadoop102)执行以下命令

[root@hadooop102]# kadmin.local -q"xst -norandkey -k /home/luanhao/luanhao.keytab luanhao"

5)将上一步生成的luanhao.keytab文件,置于Windows中的特定路径,该路径须与 3)中的keyTab属性的值保持一致。

6)测试连接

7)查询

1389

1389

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?