1. Wikidata 简介

维基数据是一个自由的协作式的多语言辅助数据库,用于收集结构化的数据,旨在支援维基百科、维基共享资源以及其他维基媒体运动中的项目,也支援世界上的每一个人。

官网:https://www.wikidata.org/wiki/Wikidata:Main_Page

全量数据包下载:https://www.wikidata.org/wiki/Wikidata:Database_download/zh

2. Wikidata 数据处理 demo

需求:下载 Wikidata JSON 数据包,转为 JSON 格式,MySQL 创建表,将数据导入 MySQL 中

1. 下载 Wikidata 语料库

说明:此处为演示 demo,由于 all 数据包过大,因此此处下载小的语料库进行处理

下载地址为:https://dumps.wikimedia.org/zhwiki/20230501/

- 2.6G 的那个下载了好几次下载不下来(网不行。。),所以下载了下边那个小包(215MB),它下边 index 那个是 215MB 包数据的索引,暂时用不到

2. 下载数据处理工具 wikiextractor-master

下载地址:https://github.com/attardi/wikiextractor

3. 将 bz2 数据包转成 JSON

说明:下载的 Wikidata 数据包格式是 bz2 的,使用 wikiextractor-master 将其转储为 JSON 格式

1. 将 wikiextractor-master 解压后,在解压后的文件夹中打开终端窗口

2. 在终端窗口中进入 Python 交互并执行安装

➜ ~ python3

Python 3.9.0 (v3.9.0:9cf6752276, Oct 5 2020, 11:29:23)

[Clang 6.0 (clang-600.0.57)] on darwin

Type "help", "copyright", "credits" or "license" for more information.

>>> python setup.py install

# 等待安装完成

3. 安装完后,执行数据格式转换

WikiExtractor -o [output] --process 2 -b 1024K --json [input]

参数说明:

-o:该参数表示输出的目录

–process:表示进程数

-b:表示生成的单个文件的大小(默认值为1M)

–json:表示生成文件的格式,不使用该参数的话,生成的文件格式是xml

具体执行:

>>> wikiextractor -o ../zhwiki-20230501 --process 2 -b 512K --json ../zhwiki-20230501-pages-articles-multistream-index1.txt-p1p187712.bz2

# zhwiki-20230501 是新建的文件夹,用于存放转换后的JSON文件

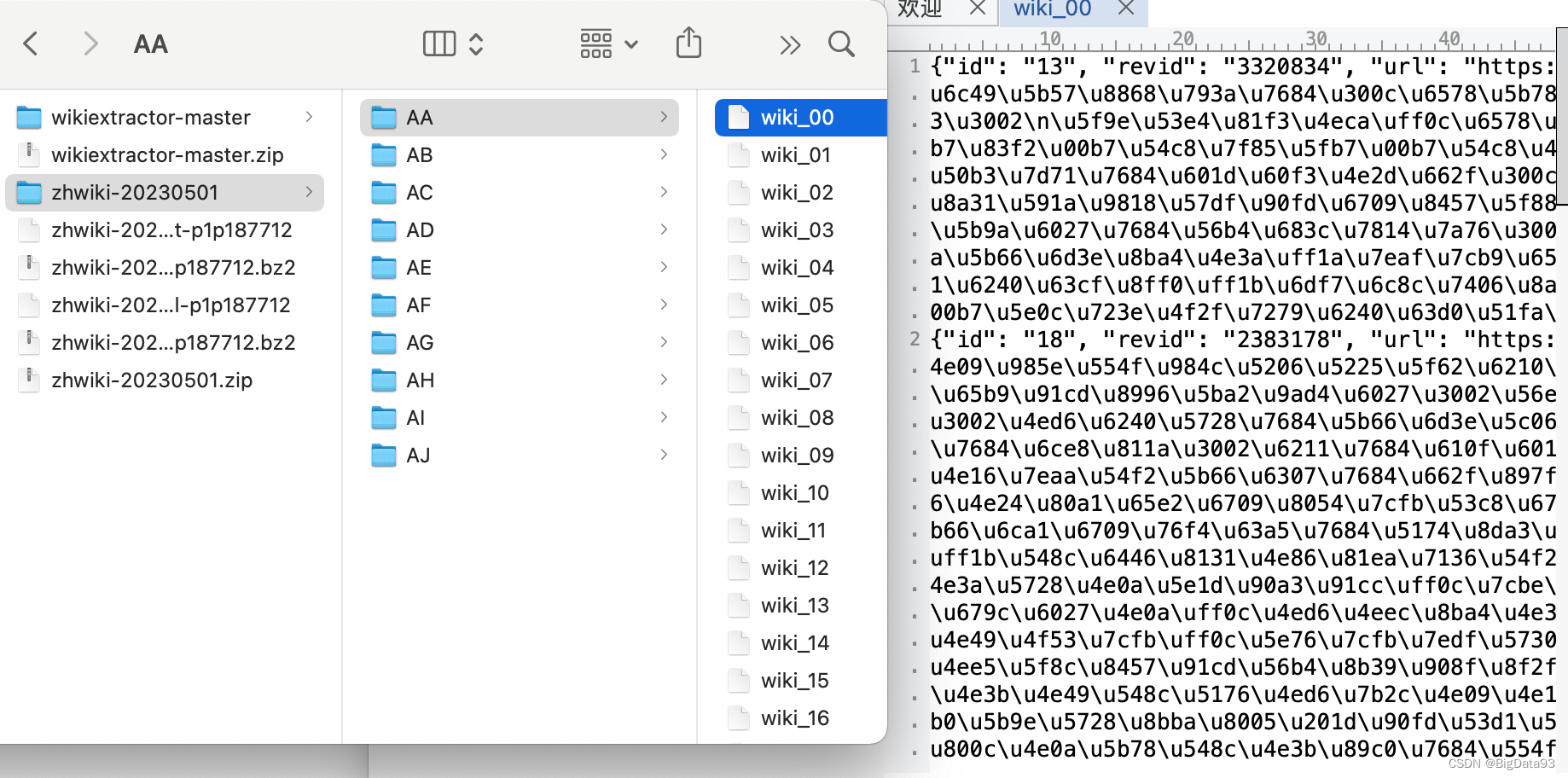

执行完后即可看到生成的相关文件:

- 说明:其他博客上说 Windows 系统执行可能会报一些错误,解决方法是使用 Ubuntu,或者使用 centOS 等 Linux 操作系统操作,我的是 Mac,一次成功了,所以此处无报错

4. 查看数据

使用 UltraEdit 编辑器打开某几个文件,查看数据为 JSON 格式,每条数据都包含 id、revid、url、title、text 五个字段。

注意:下载的这些文件数据中没有字段嵌套的情况,只是简单的一个文件中有 N 条数据,每条数据都有 5 个字段而已

4. MySQL 建库表并导入数据

由前面可知数据文件中包含 id、revid、url、title、text 五个字段,每个字段都是 string 类型

考虑到直接使用文件中的 id 作为主键的话会有重复的,为了方便后续操作,可以引入 uuid 作为主键

经对比,使用 uuid3 作为主键字段,其语法:uuid3(namespace, name)

1. 进入 MySQL 建库表

create database wiki charset=utf8;

create table wiki.demo (

`uuid` varchar(36) NOT NULL comment '主键',

`id` varchar(16) NOT NULL comment 'ID',

`revid` varchar(32) NOT NULL comment 'revid',

`url` varchar(255) DEFAULT NULL comment '地址',

`title` varchar(32) DEFAULT NULL comment '主题',

`text` MEDIUMTEXT DEFAULT NULL comment '描述',

PRIMARY KEY (`uuid`)

) ENGINE=InnoDB DEFAULT CHARSET=utf8;

2. 编写 Python 代码文件导入数据

import json

import pymysql

import os

import uuid

import random

err = [] # 记录导入失败条目

# 创建MySQL库连接和游标

conn = pymysql.connect(host='hadoop0', user='root', password='111111', port=3306, db='wiki')

cursor = conn.cursor()

''' 单个 json 文件导入 '''

'''

with open("wiki_00.json", 'r', encoding='utf-8') as f:

for line in f.readlines():

data = json.loads(line)

# 编写SQL执行即可

'''

base_file = '/Users/jason93/Desktop/Coder/BigData/Wikidata/zhwiki-20230501'

for root, dirs, files in os.walk(base_file):

for file in files:

path = os.path.join(root, file)

# 打印path发现有 AA/.DS_Store 文件,因此做判断进行过滤

if '.' not in path:

with open(path, 'r', encoding='utf-8') as f:

for line in f.readlines():

data = json.loads(line)

uid = uuid.uuid3(uuid.NAMESPACE_DNS, str(random.random()))

try:

sql = "insert into demo (uuid, id, revid, url, title, text) values (%s, %s, %s, %s, %s, %s)"

cursor.execute(sql, (uid, data['id'], data['revid'], data['url'], data['title'], data['text']))

except Exception as e:

# print(e)

err.append(data)

print(err[0]) # 失败条目 263,一共 69025 条数据

# 提交事务

conn.commit()

# 关闭游标和库连接

cursor.close()

conn.close()

3. 执行查询

代码中执行:

qry_sql = "select id, revid, url, title from demo"

cursor.execute(qry_sql)

# print(cursor.fetchone()) # 获取一条

# print(cursor.fetchall()) # 获取全部

print(cursor.fetchmany(5)) # 获取指定条数的

(('79345', '2819163', 'https://zh.wikipedia.org/wiki?curid=79345', '北京胡同列表'),

('100258', '2156442', 'https://zh.wikipedia.org/wiki?curid=100258', '北京天橋'),

('2292', '3253671', 'https://zh.wikipedia.org/wiki?curid=2292', '冬季奥林匹克运动会'),

('39314', '899028', 'https://zh.wikipedia.org/wiki?curid=39314', '限制海军军备条约'),

('5741', '3279586', 'https://zh.wikipedia.org/wiki?curid=5741', '外层空间'))

MySQL 中查询:

mysql> select count(*) from demo;

+----------+

| count(*) |

+----------+

| 68762 |

+----------+

1 row in set (0.15 sec)

mysql> select * from demo limit 2\G

*************************** 1. row ***************************

uuid: 00002da5-3868-39b8-80b1-4d8fd8ce34fe

id: 79345

revid: 2819163

url: https://zh.wikipedia.org/wiki?curid=79345

title: 北京胡同列表

text: 北京胡同有数千条,有「有名兒的胡同三千六,沒名兒的胡同賽牛毛」的说法,以下是按地区的列表:

护国寺.

护国寺东巷

护国寺大院

*************************** 2. row ***************************

uuid: 00003b92-511b-39f5-b1ba-0b29df4c7370

id: 100258

revid: 2156442

url: https://zh.wikipedia.org/wiki?curid=100258

title: 北京天橋

text:

2 rows in set (0.00 sec)

Tip:uuid

UUID是128位的全局唯一标识符,通常由32字节的字符串表示。它可以保证时间和空间的唯一性,也称为GUID,全称为:

UUID —— Universally Unique IDentifier Python 中叫 UUID

GUID —— Globally Unique IDentifier C# 中叫 GUID

它通过 MAC 地址、时间戳、命名空间、随机数、伪随机数来保证生成ID的唯一性。

UUID主要有五个算法,也就是五种方法来实现:

1、uuid1()——基于时间戳

- 由MAC地址、当前时间戳、随机数生成。可以保证全球范围内的唯一性,但MAC的使用同时带来安全性问题,局域网中可以使用IP来代替MAC

2、uuid2()——基于分布式计算环境DCE(Python中没有这个函数)

- 算法与uuid1相同,不同的是把时间戳的前4位置换为POSIX的UID。

实际中很少用到该方法。

3、uuid3()——基于名字的MD5散列值

- 通过计算名字和命名空间的MD5散列值得到,保证了同一命名空间中不同名字的唯一性,

和不同命名空间的唯一性,但同一命名空间的同一名字生成相同的uuid。

4、uuid4()——基于随机数

- 由伪随机数得到,有一定的重复概率,该概率可以计算出来。

5、uuid5()——基于名字的SHA-1散列值

- 算法与uuid3相同,不同的是使用 Secure Hash Algorithm 1 算法

综合对比:

- Python 中没有基于 DCE 的,所以 uuid2 可以忽略

- uuid4 存在概率性重复,由无映射性,最好不用

- 若在 Global 的分布式计算环境下,最好用 uuid1

- 最后,若有名字的唯一性要求,最好用 uuid3 或 uuid5

2. Wikidata 抽取实体执行查询

待补充

1467

1467

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?