文章目录

1. 【CoRL2022】PERCEIVER-ACTOR: A Multi-Task Transformer for Robotic Manipulation

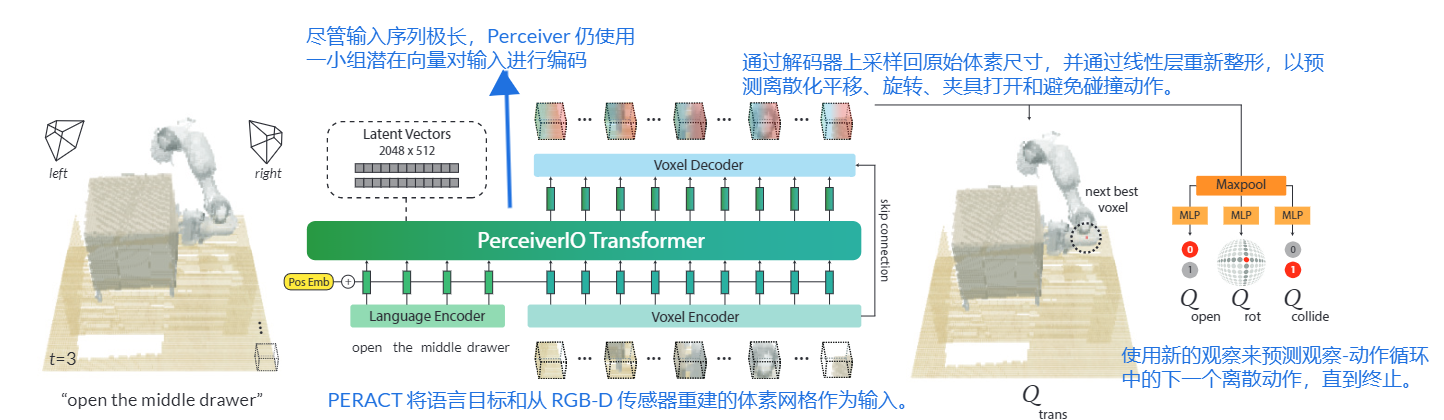

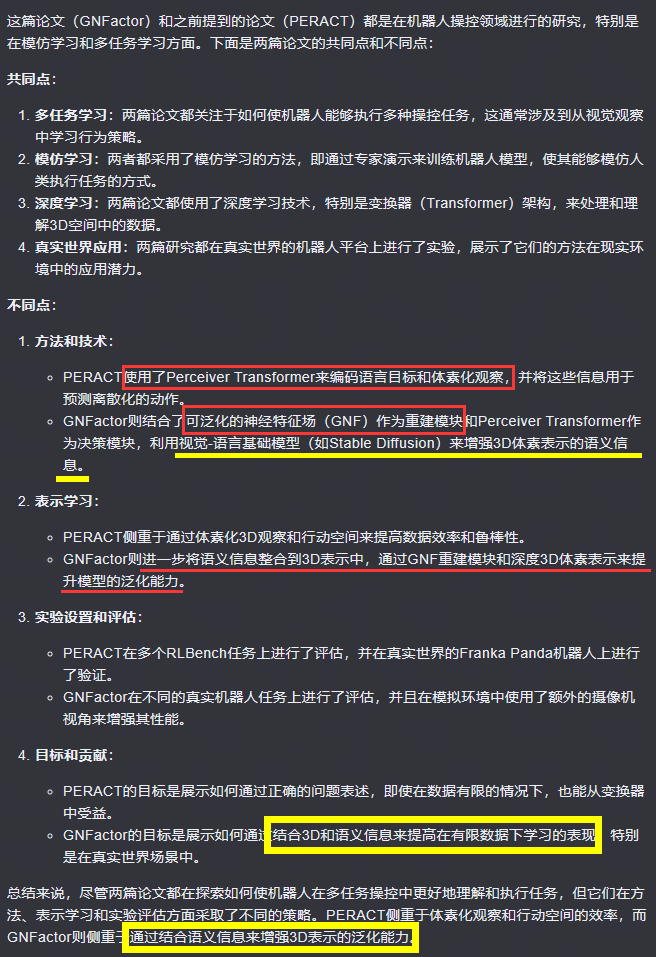

PERACT模型使用Perceiver Transformer来编码语言目标和RGB-D体素观察结果,并通过“检测下一个最佳体素动作”来输出离散化的行动。与传统的基于2D图像的框架不同,PERACT采用体素化的3D观察和行动空间,为高效学习6-DoF行动提供了强大的结构先验。

摘要和结论

- PERPACT 使用 Perceiver Transformer 对语言目标和 RGB-D 体素观察进行编码,并通过“检测下一个最佳体素(voxel)动作”输出离散化动作。

- 与操作 2D 图像的框架不同,体素化 3D 观察和动作空间为有效学习 6-DoF 动作提供了强大的结构先验。

引言

- PPACT编码一系列RGB-D体素 patches,并预测在观察-动作循环中使用运动规划器执行的离散化平移、旋转和抓取动作。

- PERACT 本质上是一个经过监督学习训练的分类器,用于检测类似于 CLIPort 等先前工作的动作,不同之处在于我们的观察和动作是用 3D 体素而不是 2D 图像像素表示的。

- 在 PERACT 中,我们使用 Perceiver2 Transformer [1] 对多达 100 万个体素的高维输入进行编码,而仅使用一小组潜在向量。

模型框架

PERACT 是一种用于 6-DoF 操作的语言条件行为克隆代理。关键思想是学习以语言目标为条件的动作的感知表征。给定场景的体素化重建,我们使用感知器变换器 [1] 来学习每个体素的特征。尽管输入空间非常大(100^3),Perceiver 使用一小组潜在向量对输入进行编码。然后,使用每个体素的特征来预测每个时间步的离散平移、旋转和夹具状态方面的下一个最佳动作。 PERACT 完全依赖于当前的观察来确定顺序任务中下一步要做什么。

3.1 Demonstrations

3.2 Demonstrations

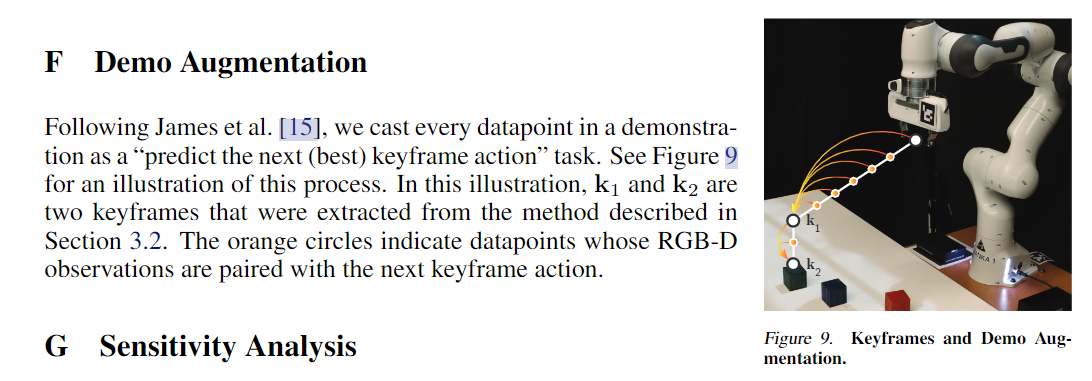

- 训练我们的代理直接预测连续动作是低效且嘈杂的。因此,对于每个演示 z,我们提取一组关键帧动作 {k1, k2,…。 。 。 , km} ⊂ A 通过简单的启发式捕获动作序列中的瓶颈末端执行器姿势 [71]:如果 (1) 关节速度接近零且 (2) 夹具打开状态未达到,则动作是关键帧改变了。演示中的每个数据点 z 都可以被转换为“预测下一个(最佳)关键帧动作”任务 [14,72,73]。有关此过程的说明,请参见附录图 F。

在此图中,k1 和 k2 是从 3.2 节中描述的方法提取的两个关键帧。橙色圆圈表示其 RGB-D 观察结果与下一个关键帧动作配对的数据点 - 关键帧动作 k 被离散化,这样训练我们的 BC 代理就可以被表述为“下一个最佳动作”分类任务。平移只是距离抓手手指中心最近的体素。对于三个旋转轴中的每一个,旋转都被离散成 5 度的区间。夹具打开状态是一个二进制值。

- Collide 也是一个二进制值,指示运动规划器是否应避免体素网格中的所有内容或根本不进行任何操作;这两种防撞模式之间的切换至关重要,因为任务通常涉及基于接触的运动(例如,拉开抽屉)和基于非接触的运动(例如,在不碰撞任何东西的情况下到达把手)。

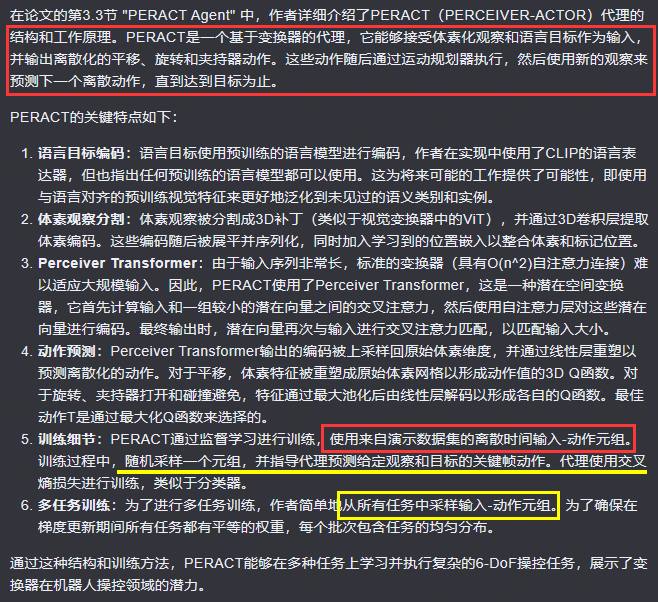

3.3 PERACT Agent & 3.4 Training Details

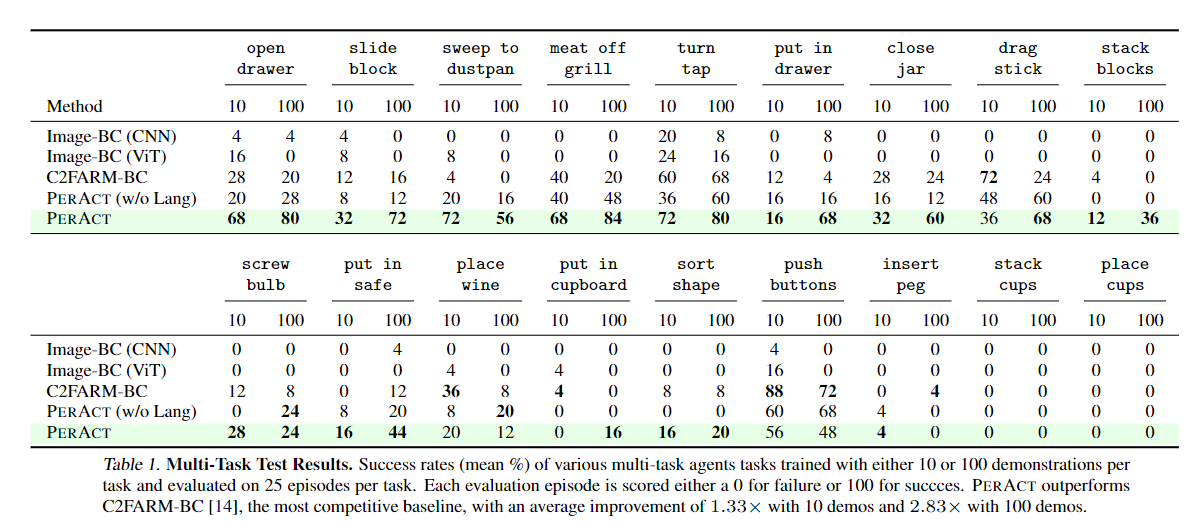

实验

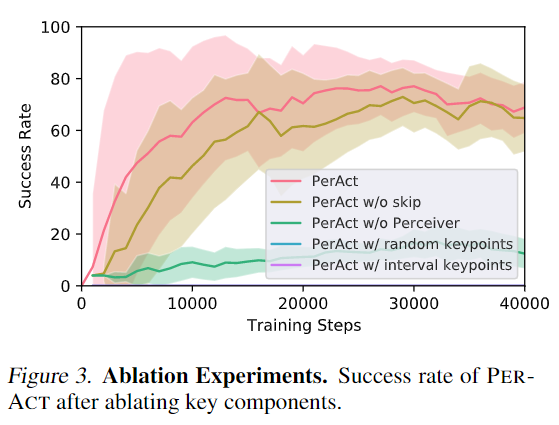

总结这些结果:

(1) 跳跃连接有助于稍微更快地训练代理,

(2) Perceiver Transformer 对于在全局感受野中实现良好的性能至关重要,

(3)提取良好的关键帧动作对于监督训练至关重要,因为随机选择或固定间隔的关键帧会导致零性能。

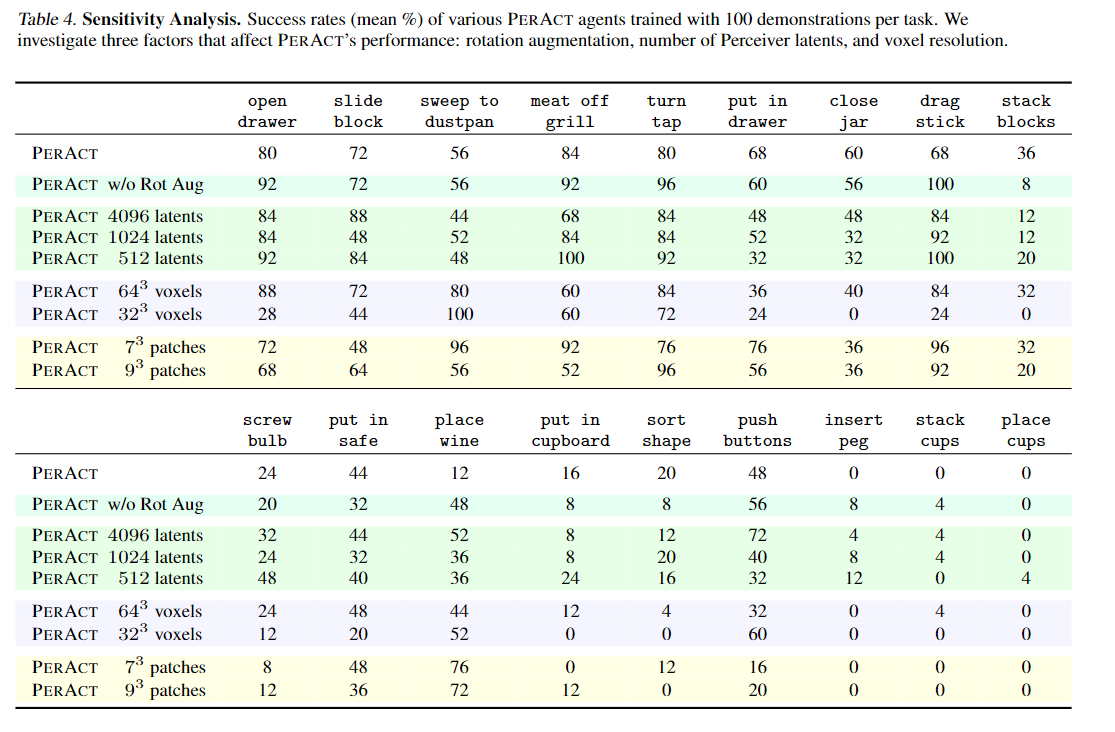

在表 4 中,我们研究了影响 PERACT 性能的三个因素:旋转数据增强、感知器潜在数量和体素化分辨率。所有多任务智能体都接受了每项任务 100 次演示的训练,并针对每项任务 25 次演示进行了评估。简要总结这些结果:

(1) 45° 偏航扰动可提高具有大量旋转变化的任务(如堆叠块)的性能,但也会恶化具有受限旋转的任务(如放置葡萄酒)的性能。

(2) 仅具有 512 个潜在变量的 PERACT 与具有 2048 个潜在变量的默认代理具有竞争力(有时甚至更好),这展示了 Perceiver 架构的压缩能力。

(3)像32^3这样的粗网格对于某些任务来说已经足够了,但是像排序形状这样的高精度任务需要更高分辨率的体素化。

(4) 大补丁大小会减少内存使用,但可能会影响需要子补丁精度的任务。

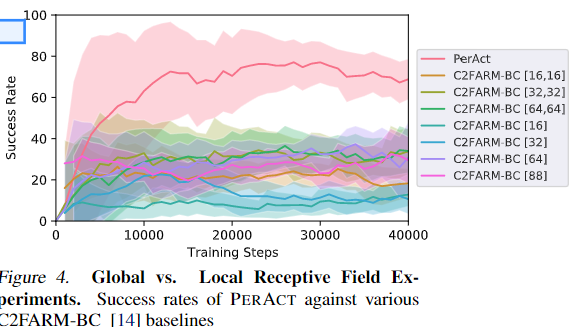

为了进一步研究 Transformer 代理的全局感受野,我们对打开抽屉任务进行了额外的实验。打开抽屉任务具有三种变体:“打开顶部抽屉”、“打开中间抽屉”和“打开底部抽屉”,并且由于接受域有限,很难区分抽屉手柄,这些手柄在视觉上都是相同的。图 4 报告了经过 100 次演示训练的 PERACT 和 C2FARM-BC 代理。虽然打开抽屉任务可以通过更少的演示来解决,但这里我们要确保数据不足不是问题。我们包括具有不同体素化方案的多个版本的 C2FARM-BC。例如,[16, 16]分别表示1m3和0.15m3的两个级别的163个体素网格。 [64] 表示 643 体素网格的单层,没有粗到细粒度的方案。 PERACT 是唯一取得超过 70% 成功率的智能体,而所有 C2FARM-BC 版本的成功率约为 33%,这表明 Transformer 的全局感受野对于解决任务至关重要。

总结

- 虽然 PERACT 功能相当强大,但将其扩展到灵巧的连续控制仍然是一个挑战。 PERACT 受基于采样的运动规划器的支配来执行离散动作,并且不容易扩展到像多指手这样的 N-DoF 执行器。有关 PERACT 局限性的详细讨论,请参阅附录 L。但总的来说,我们很高兴能够通过专注于机器人操作的多样化而不是狭隘的多任务数据来扩大机器人学习的规模

2. 【CoRL2023】GNFactor: Multi-Task Real Robot Learning with Generalizable Neural Feature Fields

- 挑战:主要挑战在于如何处理有限的演示数据下的泛化问题。这涉及到理解场景的3D结构、理解物体的语义和功能,并有效根据视觉线索执行任务指令。因此,为泛化提供全面和信息丰富的视觉表示是至关重要的基础。

- 解决方案设计:

为了解决这些挑战,作者们设计了一个名为GNFactor的框架,它包括以下几个关键部分:

通用神经特征场(GNF):这是一个重建模块,它通过模仿学习从多个视角重建RGB图像和从视觉-语言基础模型(如Stable Diffusion)中提取的特征。

Perceiver Transformer:这是一个决策模块,它使用深度3D体素表示来进行动作预测,并且可以接受语言指令来获取任务嵌入,并推理语言和视觉语义之间的关系。

多任务学习:通过在GNF学习到的3D体积特征上进行行为克隆,端到端地训练整个模型。

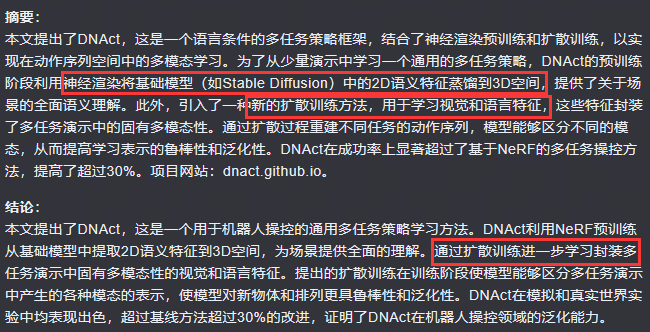

摘要和结论

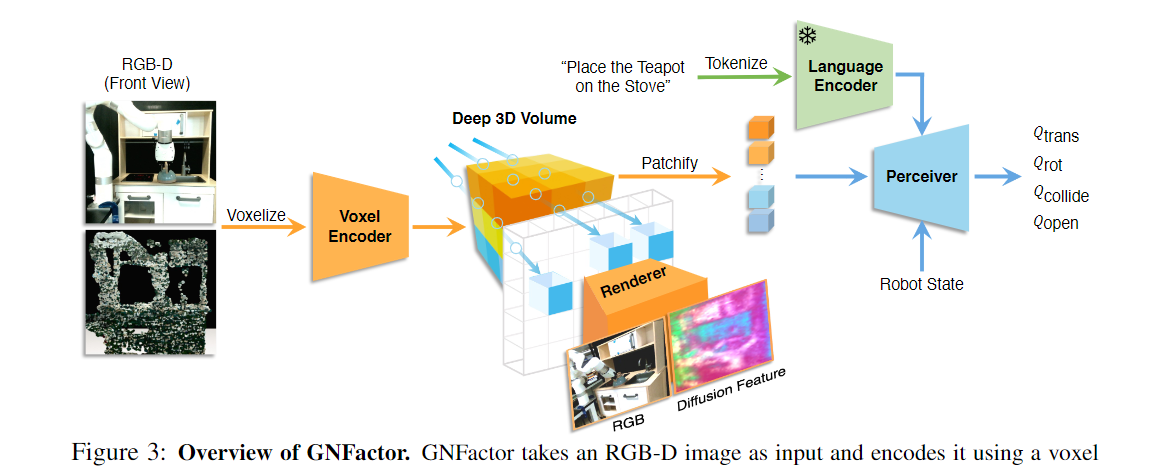

- GNFactor结合了一个 可泛化的神经场(GNF)作为重建模块和一个Perceiver Transformer作为决策模块 ,利用共享的深度3D体素表示。

- 为了在3D中融入语义信息,重建模块使用了视觉-语言基础模型(例如Stable Diffusion)将丰富的语义信息提炼到深度3D体素中。

模型框架

3.1 Problem Definition

和上一篇一样几乎。

3.2 Learning Volumetric Representations with Generalizable Neural Feature Fields

3.3 Action Prediction with Volumetric Representations

- 我们首先使用内核大小和步长为 5 的 3D 卷积层将共享体积表示 v 压缩为大小为 20^3 × 128 的体积,

- 然后使用 ReLU 函数,并将 3D 体积展平为大小为 8000 × 128的小立方体序列。

- 机器人的本体感觉被投影到一个128维的空间中,并与每个立方体的体积序列连接起来,得到一个大小为8000×256的序列。

- 然后,我们将来自 CLIP 的语言标记特征投影到相同的维度(77 × 256),并将这些特征与 3D 体积、机器人的本体感觉状态和 CLIP 标记嵌入的组合连接起来。结果是尺寸为 8077 × 256 的序列。

该序列与可学习的位置编码相结合,并通过 Perceiver Transformer,输出相同大小的序列。

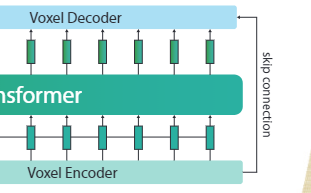

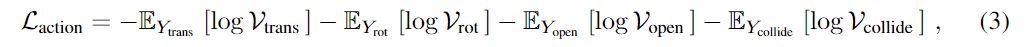

为了便于体素化,我们删除了最后 77 个特征 [3],并将序列重塑回大小为 20^3 × 256 的体素。然后使用三线性插值将该体素放大 (上采样) 到 100 ^3 × 128,称为 vPT。 vPT 在三个动作预测头(图 3 中的 Qopen、Qtrans、Qrot、Qcollide)之间共享,以确定与观察空间相同尺度的最终机器人动作。为了保留从 GNF 训练中学到的特征,我们在体积表示 v 和 vPT 之间创建了一个跳跃连接。组合体积特征(v、vPT)用于预测用于平移的 3D Q 函数 Qtrans,以及用于其他机器人操作的 Q 函数,例如夹具张开度 (Qopen)、旋转 (Qrot) 和碰撞避免 (Qcollide) 。这里的 Q 函数表示一个时间步的动作值,与 RL 中针对多个时间步的传统 Q 函数不同。例如,在每个时间步中,对于最可能的下一个体素,3DQtrans 值将等于 1,对于其他体素,3DQtrans 值将等于 0。然后模型像分类器一样优化交叉熵损失

GNFactor 的总体学习目标如下:

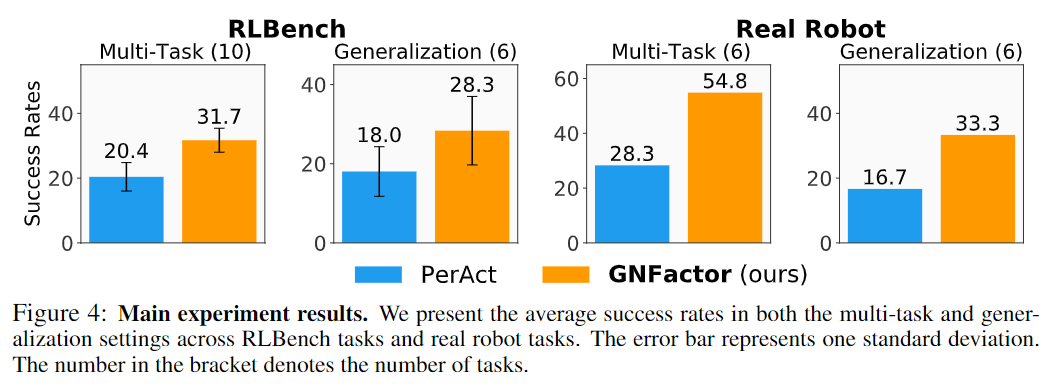

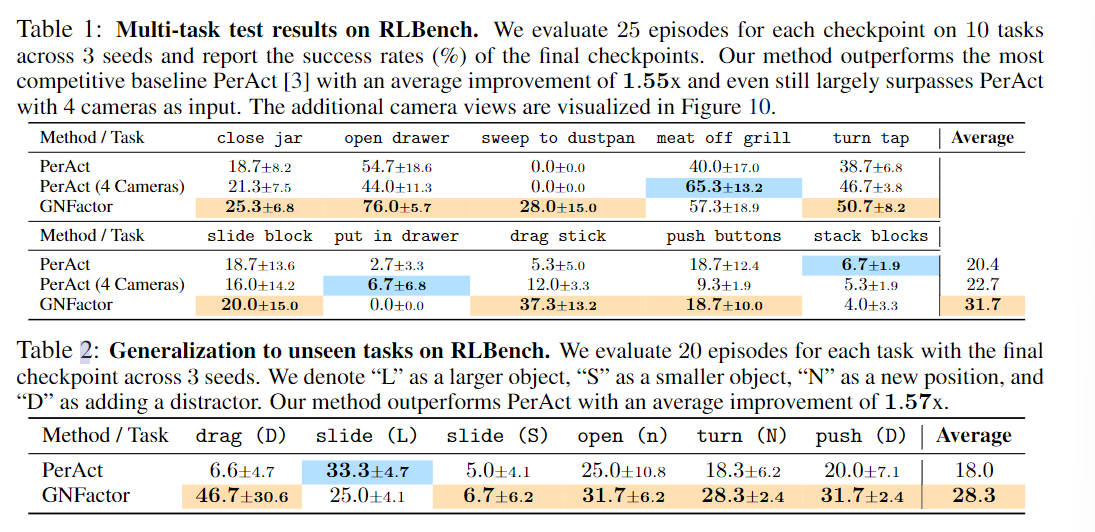

实验

总结

-

除了 RGB 特征之外,还使用来自基础模型 Stable Diffusion 的语言特征来监督 GNF 训练,并观察到 GNF 增强的体积表示有助于决策。

-

GNFactor 的一个主要限制是 GNF 训练需要多个视图,这在现实世界中扩展可能具有挑战性。目前,我们为 GNFactor 使用三个固定摄像头,但探索使用手机随机收集摄像头视图会很有趣,其中摄像头姿势的估计将是一个挑战

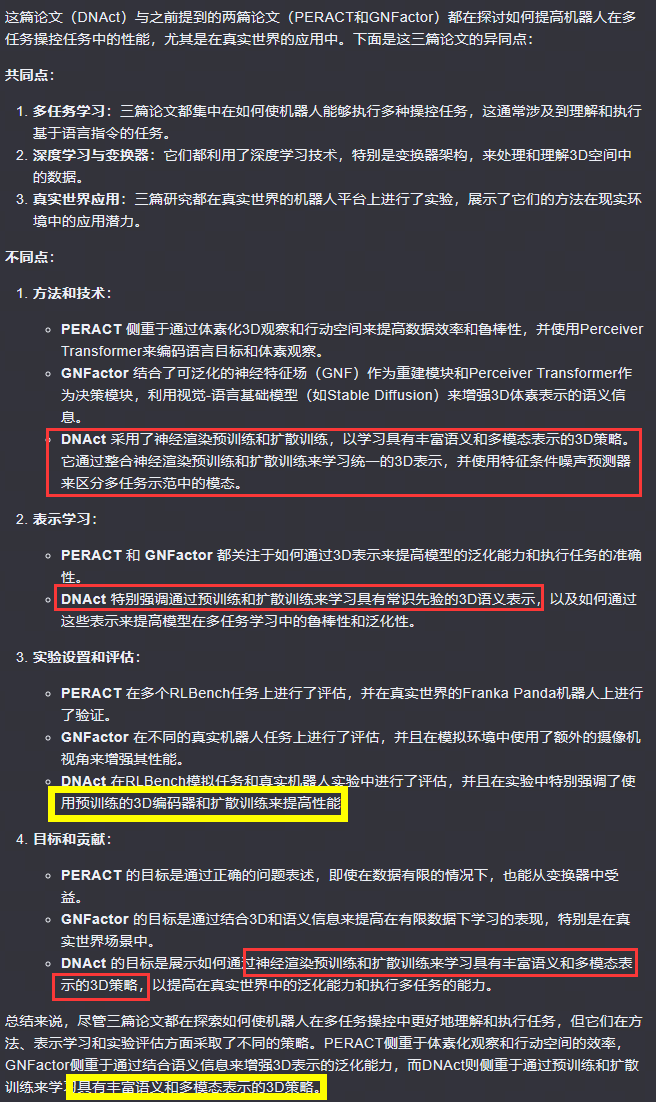

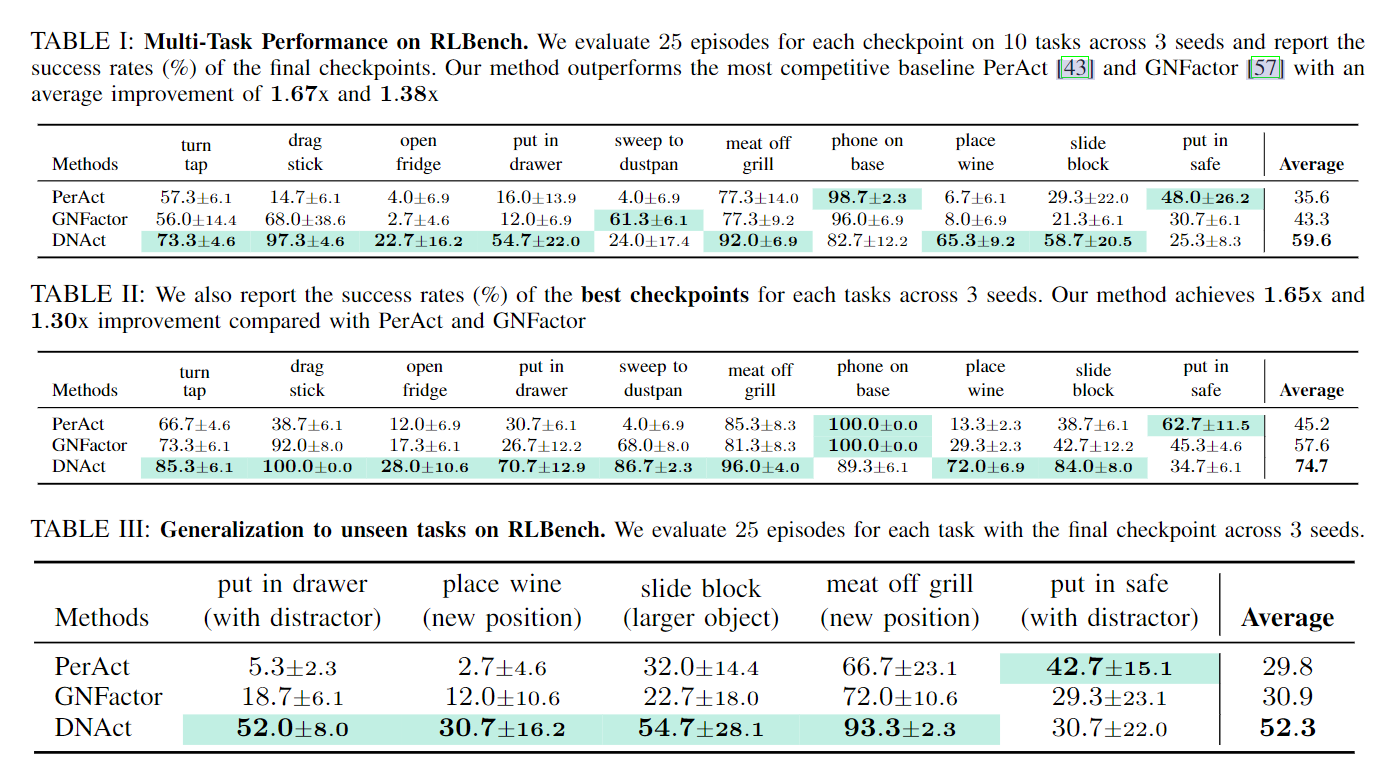

3. DNAct: Diffusion Guided Multi-Task 3D Policy Learning

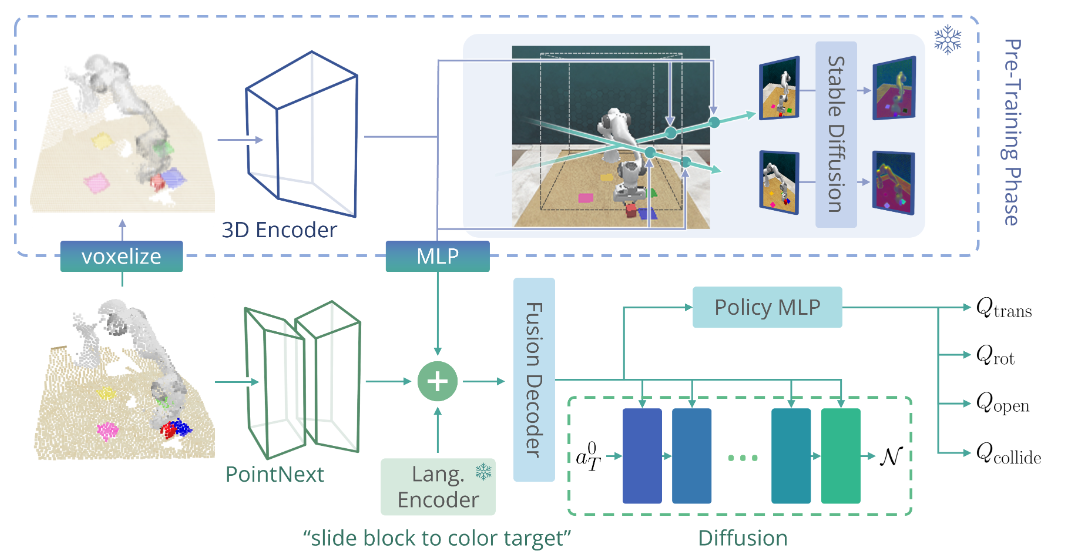

摘要和结论

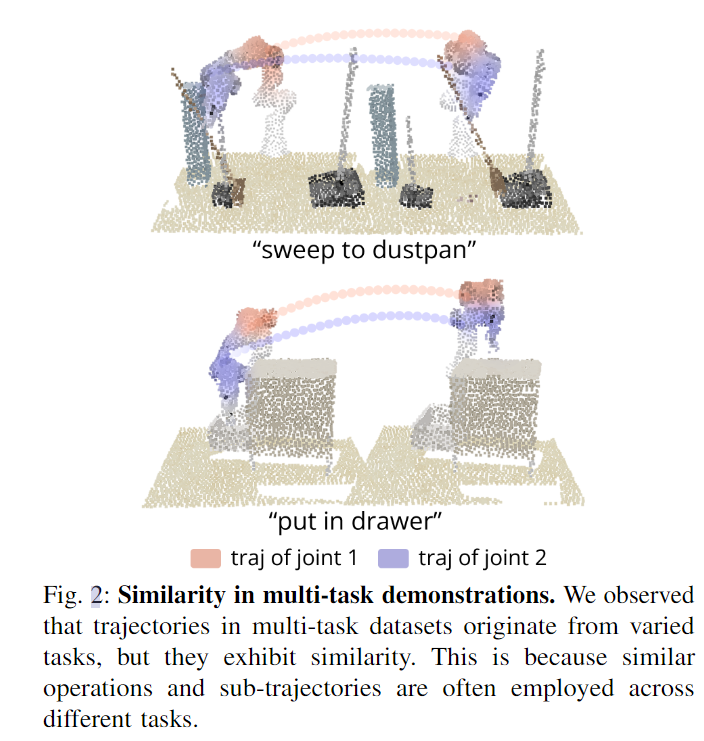

我们提出了一种新的多任务对象操作方法DNAct,该方法利用知识蒸馏和扩散训练来获得语义感知和多模态表示。

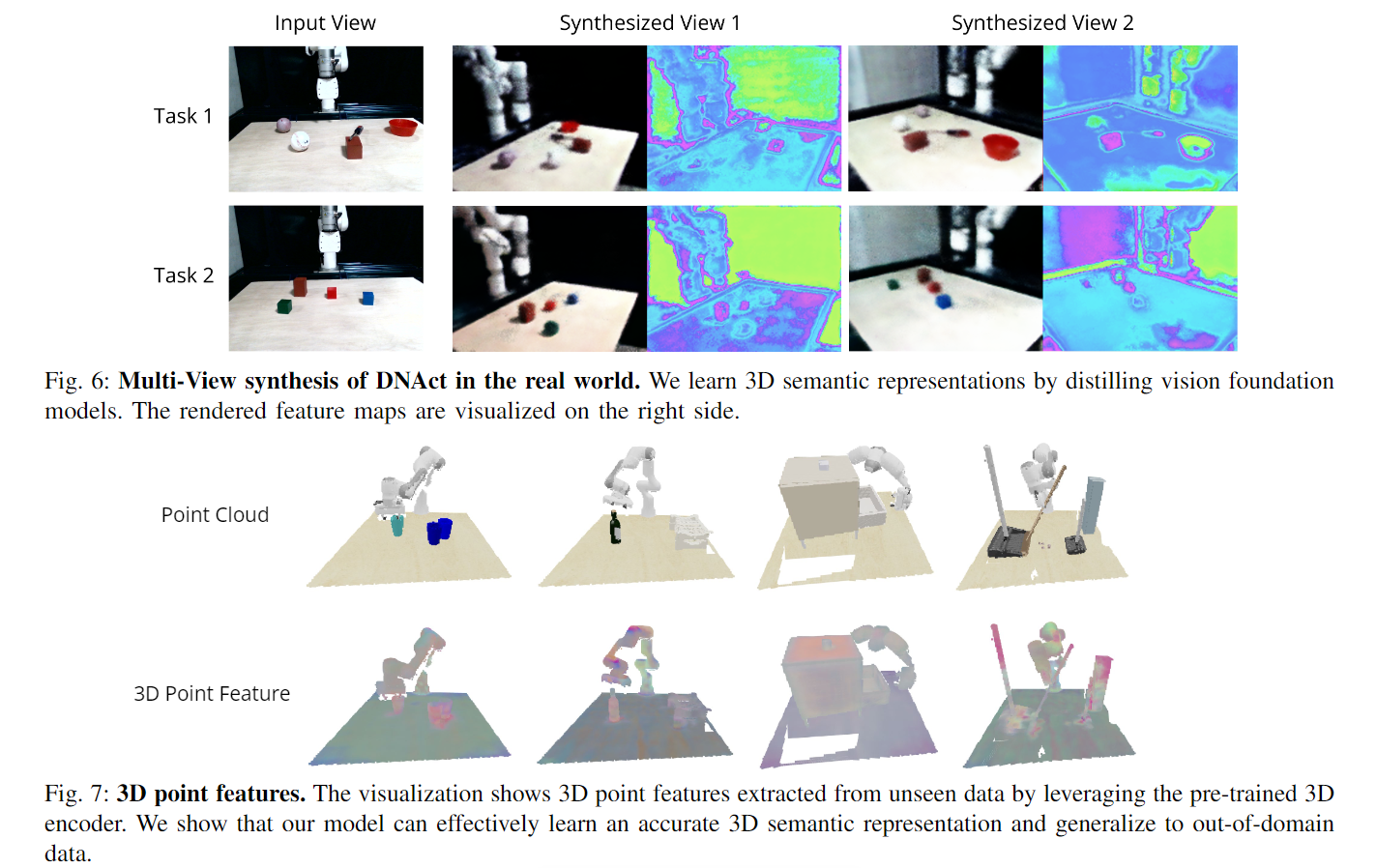

我们可视化预训练的语义感知表示,表明它们通过利用神经渲染进行预训练来准确捕获模拟和现实世界任务中的语义。

引言

开发能够在复杂环境中执行多任务机器人很有前景,对于未来应用(如家庭机器人)具有意义。最近的研究表明了这种方法的潜力,展示了训练单个模型完成多个任务的可能性。然而,仍然存在一些挑战需要克服:

(i) 从零开始学习一个通用的多任务策略需要大规模数据集来全面理解3D语义,这在现实世界中只有少量演示的情况下是一个挑战。(ii)为了在复杂环境中执行操控,需要能够识别给定演示中轨迹的多模态性的能力。例如,如果演示包含在厨房中避开杂乱物体拿起刀的几种可能轨迹,没有处理多模态性的策略学习方法可能会偏向于某一种模式(轨迹),并不能泛化到新的对象或排列。

为了应对这些挑战,我们通过集成神经渲染预训练和扩散训练来学习统一的 3D 表示。具体来说,我们首先通过带有 NeRF 的神经渲染预训练 3D 编码器。我们不仅利用神经渲染来合成RGB中的新视图,还从2D基础模型中预测相应的语义特征。通过提取预训练的 2D 基础模型,我们从互联网规模的数据集中学习了具有常识先验的可泛化 3D 表示。我们表明,这种预训练表示为策略配备了分布外的泛化能力。

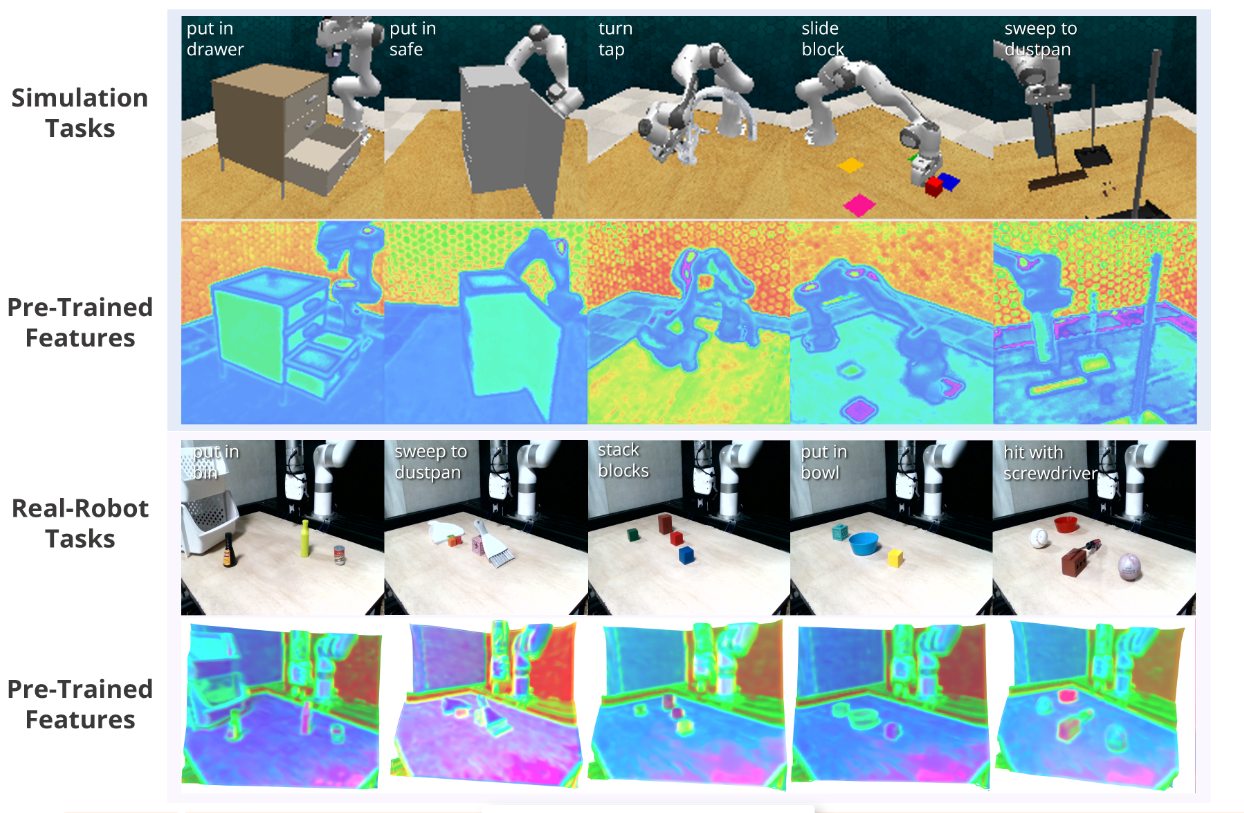

为了优化模型以区分多模态以及多任务演示的相似性(如图 2 所示),我们执行扩散训练来监督表示。 DNAct 的扩散训练涉及特征条件噪声预测器的优化,该预测器旨在重建跨不同任务的动作序列。通过重建过程,模型可以有效地识别轨迹中固有的多模态,而不偏向于某种模式。由于扩散训练优化的结构化和可概括的表示,学习的策略不仅在训练环境中能够实现更高的成功率,而且在存在新颖对象和排列的环境中也能实现更高的成功率。图 3 总结了 DNAct 中提出的概念。它说明了在预训练阶段通过重建 RGB 和相应的 2D 语义特征来学习 3D 语义特征。此外,所提出的扩散训练进一步增强了区分不同任务产生的各种模式的能力。

引言部分强调了通过预训练和扩散训练学习通用3D表示的重要性,并概述了DNAct方法的主要贡献和目标。

模型框架

A. Robotic Manipulation as Keyframe Prediction

和之前一样。关键帧的回归问题。

B. 3D Encoder Pre-Training with Neural Feature Fields

当从一组有限的演示中学习时,我们的预训练方法以及随后使用冻结的 3D 编码器执行下游任务的方法可 确保后续决策过程利用准确的 3D 语义,而不是通过 BC 过度拟合演示。此外,预训练不需要在训练数据集中进行配对动作,从而扩大了利用与目标任务和场景直接无关的更广泛的训练数据集的可能性。这种方法消除了 NeRF 和策略训练中对特定任务数据的需求,从而增强了可扩展性和多功能性。

C. Diffusion-Guided Feature Learning with Action Sequences

- 目的:促进Agent利用预先训练的 3D 语义特征并确保对各种任务的适应性

- 采样4096个点作为PointNext的输入来学习几何点特征

- 机器人的本体感觉通过应用线性层被投影到 32 维向量,而来自 CLIP 的语言目标特征被投影到 64 维向量。然后将两个向量附加到每个采样点,分别产生机器人本体感受和语言的大小为 4096 × 32 和 4096 × 64 的序列。我们将所有特征连接在一起,包括预先训练的语义特征、点云特征、机器人本体感知和语言嵌入。这种组合特征通过几个抽象层[35]进一步融合,以获得最终的视觉语言嵌入 vf 。

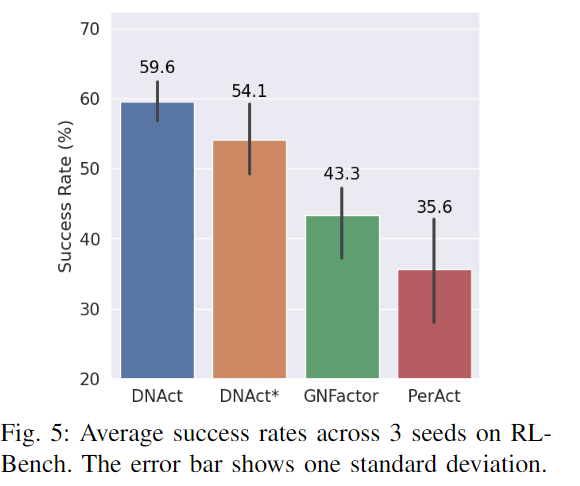

实验

484

484

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?