1.1概念简介

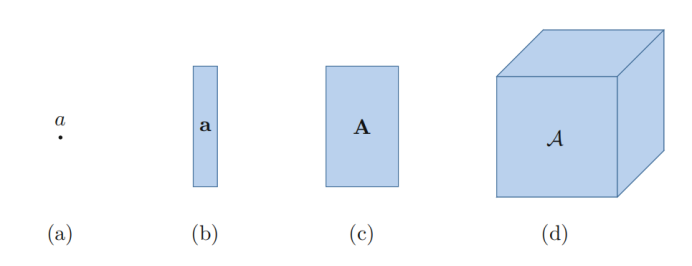

简单理解,张量就是一个多维数组,张量计算在众多领域均有体现,其中常用的表示方法如下:

a表示标量,a 表示向量,A表示矩阵,A表示张量(时常也用T或 来表示张量)。

来表示张量)。

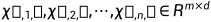

张量的定义方式可由向量和矩阵类似推出,其中 表示n维张量。

表示n维张量。

例如,给定三维张量 ,可以通过切片(slice)的方式进行观察计算。

,可以通过切片(slice)的方式进行观察计算。

其中,

horizontol切片为:

lateral切片为:

frontal切片为:

以下分别为 的horizontol切片,lateral切片,frontal切片:

的horizontol切片,lateral切片,frontal切片:

1.2 基本运算【Basic Computation】

矩阵的迹 (Matrix Trace):

当矩阵 时,

时,

张量的迹通常在不同分解(decomposition)下有不同的定义方式,也进一步拓宽了张量实现现实问题的可能性。

内积 (Inner Product):

两个向量内积a、b对应分量乘积之和,结果为一个标量,记作<a,b>。

两个矩阵A、B对应分量乘积之和,结果为一个标量,记作<A,B>(与向量的内积/点积/数量积的定义相似)。所以A、B的行数列数都应相同,且有结论<A,B>=tr(A^T* B)。

例如:

,

, ,则有c=<A,B>=1x5+2x6+3x7+4x8=70

,则有c=<A,B>=1x5+2x6+3x7+4x8=70

推广至张量同样是两个大小(size)相同张量A和B对应分量乘积之和,结果仍为一个标量,记作<A,B>。

可概括为:c=<A,B>=<vec(A),vec(B)> R

R

外积 (Outer Product)

950

950

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?