目录

2 Unsupervised Data Augmentation (UDA)

Augmentation Strategies for Different Tasks

4 Additional Training Techniques

Domain-relevance Data Filtering

5.1 Correlation between Supervised and Semi-supervised Performances

5.2 Algorithm Comparison on Vision Semi-supervised Learning Benchmarks

5.3 Evaluation on Text Classification Datasets

5.4 Scalability Test on the ImageNet Dataset

Abstract

在有标签数据稀缺的情况下,半监督学习在改进深度学习模型方面显示出很大的潜力。在最近的方法中,常见的是对大量未标记数据进行一致性训练,以约束模型预测对输入噪声保持不变。在这项工作中,作者提出了一个关于如何有效地对未标记数据进行噪声处理的新方法,并认为噪声的质量,特别是那些由先进的数据增强方法产生的噪声,在半监督学习中起着至关重要的作用。通过使用先进的数据增强方法(如RandAugment和反向翻译)代替简单的噪声操作,该方法在相同的一致性训练框架下对六种语言和三种视觉任务带来了实质性的改进。在IMDb文本分类数据集上,只有20个标记示例,该方法实现了4.20的错误率,优于在25000个标记示例上训练的最先进模型。在标准的半监督学习基准CIFAR-10上,该方法优于所有以前的方法,仅使用250个示例,错误率为5.43。该方法还与转移学习很好地结合在一起,例如,当从BERT进行网络调整时,无论是在只有10%的标记数据时,还是在使用带有1.3M额外未标记示例的完整标记集时,都可以改善高数据区域,例如ImageNet。

1 Introduction

在该工作中,作者研究了一致性训练中注入噪声的作用,发现先进的数据增强方法,特别是那些在监督学习中效果最好的方法,在半监督学习中也表现良好。监督学习中数据增强操作的性能与其在一致性训练中的性能之间确实存在很强的相关性。因此,作者建议用高质量的数据增强方法代替传统的噪声注入方法,以提高一致性训练。为了强调在一致性训练中使用更好的数据增强,作者将他们提出的方法命名为无监督数据增强(Unsupervised data augmentation,简称UDA)。本文的主要贡献和发现总结如下:

- 在监督学习中发现的最先进的数据增强也可以作为一致性强制半监督框架下的优越噪声源。

- UDA 可以匹配甚至优于使用数量级更多标记数据的纯监督学习。

- UDA 与迁移学习结合得很好。

- 作者还提供了关于 UDA 如何提高分类性能以及最先进增强的相应作用的理论分析

2 Unsupervised Data Augmentation (UDA)

在这项工作中,我们感兴趣的是输入注入噪声后的

。但是与现有工作不同,作者关注如下问题,即噪声操作

的形式或“质量”如何影响一致性训练框架的性能。 具体而言,为了增强一致性,之前的方法通常采用简单的噪声注入方法,例如添加高斯噪声。相反,在半监督学习框架中,使用在监督学习中的数据增强功能来处理未标记数据也可以带来更好的性能,因为已经证明:更多样化和更自然的高级数据增强可以在监督模型中显著提高性能。

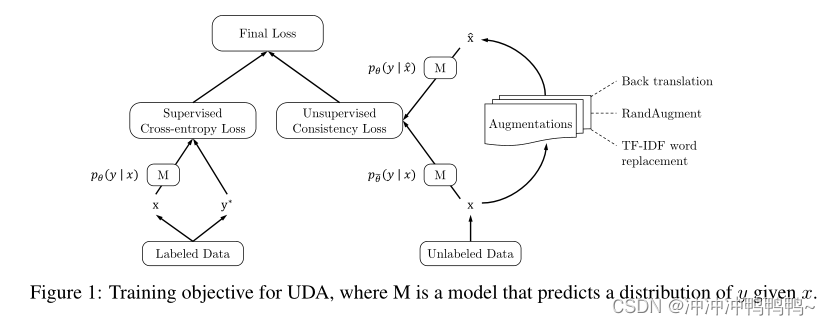

遵循这一想法,作者建议使用一组在监督学习中已经验证出的最先进的数据增作为噪声注入,并在未标记的例子上优化相同的一致性训练目标。当与标记的例子联合训练时,我们利用一个权重因子来平衡监督交叉熵和非监督一致性训练损失,如图1所示。正式地说,完整的目标(loss)可以这样写:

其中CE表示交叉熵,是数据增强变换,并且

是当前参数的固定副本

表明梯度未通过

。在多数实验中

都设为1。在每次迭代中,我们计算小批量有标签数据上的监督损失,并计算小批量无标签数据上的一致性损失。然后将这两个损失相加为最终损失。在计算一致性损失事使用更大的批量。

Discussion

在详细介绍本工作中使用的增强操作之前,作者首先从三个方面提供了一些直观信息,说明更高级的数据增强如何比早期工作中所使用的简单数据增强提供更多优势:

- Valid noise (有效噪声):在监督学习中取得良好性能的先进的数据增强方法通常生成合理的增强示例,这些示例与原始示例共享相同的ground-truth标签。因此,鼓励对原始无标签数据和增强后的无标签数据的预测之间的一致性是安全的。

- Diverse noise(多样性噪声):先进的数据增强可以生成一组多样的示例,因为它可以在不改变其标签的情况下对输入示例进行大量修改,而简单的高斯噪声只会进行局部更改。

- Targeted inductive biases(目标归纳偏差):不同的任务需要不同的归纳偏差。在监督训练中效果良好的数据增强操作基本上提供了缺失的归纳偏差。

Augmentation Strategies for Different Tasks

- RandAugment for Image Classification.

- Back-translation for Text Classification.

- Word replacing with TF-IDF for Text Classification.

4 Additional Training Techniques

Confidence-based masking

掩盖当前模型不确定的例子是有帮助的。具体地说,在每个小批处理中,一致性损失项只在分类类别中最大概率大于阈值的例子上计算。将阈值

一般设置为一个高值。

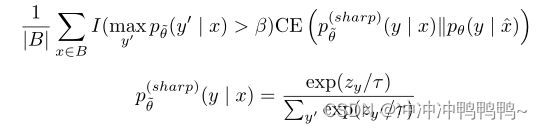

Sharpening Predictions

由于正则化的预测具有低熵已被证明是有益的,在计算目标分布时,通过使用低Softmax温度锐化预测。当与基于置信度的掩蔽相结合时,将在小批量B中未标记示例的损失计算为:

其中I(·)是指示符函数,是标签y的logit,例如x。

Domain-relevance Data Filtering

理想情况下, 我们希望使用域外未标记的数据, 因为它通常更容易收集, 但是域外数据的类别分布与域内数据的类别分布不匹配, 这可能导致如果直接使用, 造成性能损失。为了获得与手头任务相关的域数据, 采用了一种通用技术来检测域外数据,使用在域内数据上训练的基准模型来推断大型域外数据集中的数据标签, 并挑选出模型最有信心的示例。具体来说, 对于每个类别, 根据属于该类别的分类概率对所有示例进行排序, 并选择概率最高的示例。

5 Experiments

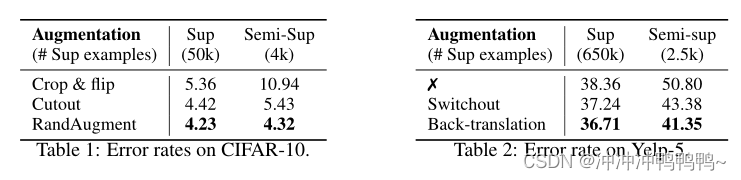

5.1 Correlation between Supervised and Semi-supervised Performances

作者验证了数据增强在监督学习和半监督学习中的有效性存在正相关。基于Yelp-5(一种语言任务)和CIFAR-10(一种视觉任务),作者比较了在完全监督或半监督环境下不同数据增强方法的性能。结果如下图所示,

该结果说明当应用于半监督学习设置时,监督学习中发现的更强的数据增强总是可以带来更多收益。

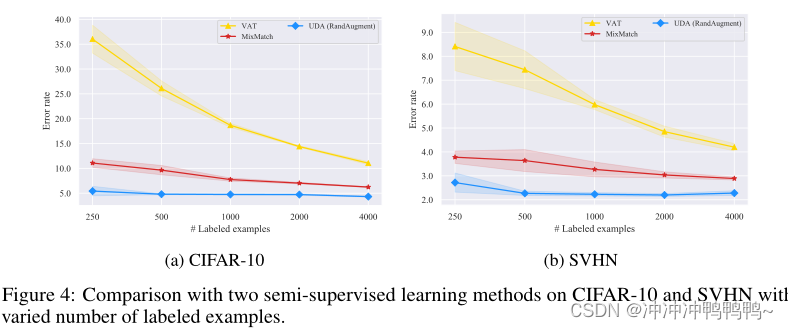

5.2 Algorithm Comparison on Vision Semi-supervised Learning Benchmarks

Vary the size of labeled data

从上图可以看出,不同大小的标记数据,UDA始终优于两条基线;此外,UDA和VAT之间的性能差异表明了基于数据增强的噪声的优越性。UDA和VAT的区别本质上是噪声过程。虽然VAT产生的噪声通常包含真实图像中不存在的高频伪影,但数据增强大多会生成各种逼真的图像。

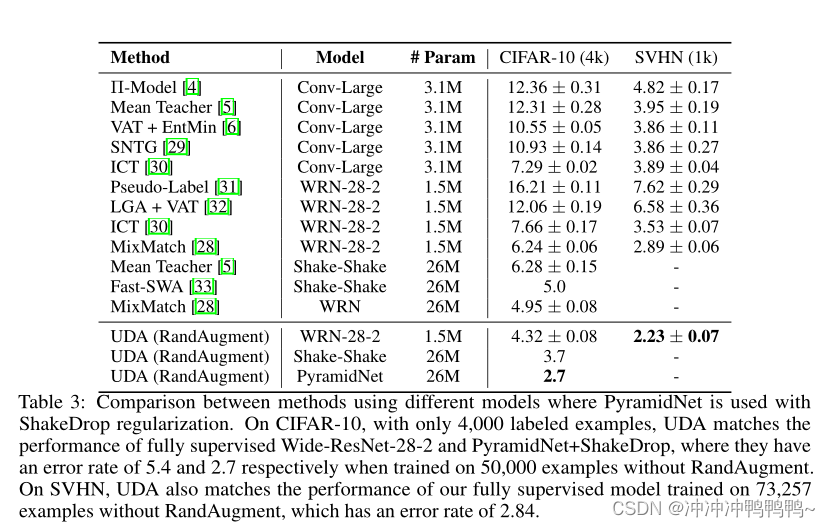

Vary model architecture

从上表可以看出,在相同的架构下,UDA的性能明显优于所有已公布的结果,几乎与完全监督的性能相匹配,后者使用了10倍以上的有标签数据。这证明了在视觉领域一致性训练框架下的最新数据增强的巨大潜力。

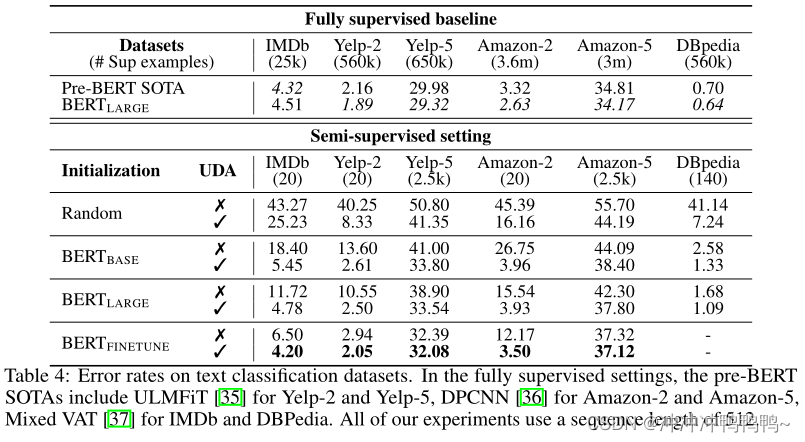

5.3 Evaluation on Text Classification Datasets

从上表可以发现:

-

与使用全监督数据训练的SOTA模型相比,即使只有很少的标记示例,UDA也可以提供良好甚至具有竞争力的性能。

-

UDA是对转移学习/表征学习的补充。如我们所见,当使用BERT初始化并进一步微调域内数据时,UDA仍然可以显著地将IMDb上的错误率从6.50降低到4.20。

-

对于五类情感分类任务,每类500个标记示例的UDA与在整个监督集上训练的BERT之间仍然存在明显的差距。直观地说,五类情感分类比二类情感分类要困难得多。这表明未来还有进一步改进的空间。

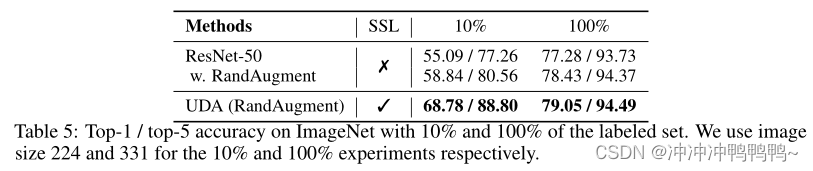

5.4 Scalability Test on the ImageNet Dataset

为了评估UDA是否可以扩展到大规模和更高难度的问题,现在转向以ResNet-50为基础架构的ImageNet数据集。具体来说,作者考虑了两种性质不同的实验设置:

-

使用ImageNet 10%的监督数据,同时使用所有其他数据作为未标记数据。因此,未标记的数据完全在域中。

-

作者将所有图像作为监督数据保存在ImageNet中。然后,使用域相关数据过滤方法从JFT中过滤出1.3M图像。因此,未标记数据不一定在域中。

从表中可以看出,在10%和完整数据设置中,与监督基线相比,UDA始终带来显著收益。这表明UDA不仅能够扩展,而且能够利用域外未标记示例来提高模型性能。

6 Conclusion

本文证明了数据增强和半监督学习是密切相关的:更好的数据增强可以显著改善半监督学习。UDA,采用监督学习中发现的最先进的数据增强,以生成多样的和合理可靠的噪声,并强制模型与这些噪声一致。对于文本,UDA与表示学习结合得很好,如BERT。在视觉方面,UDA的表现明显优于先前的工作,几乎与在大一个数量级的全标记集上训练的全监督模型的表现相匹配。作者希望UDA将鼓励未来的研究,将高级监督增强转移到不同任务的半监督设置。

论文地址和代码地址

论文:https://proceedings.neurips.cc/paper/2020/file/44feb0096faa8326192570788b38c1d1-Paper.pdf

945

945

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?