想拥有一个完全属于自己的AI助手,还不依赖互联网?本教程带你从零开始搭建本地AI环境!(Apple Silicon架构)

💻 环境说明

| 配置项 | Mac | Windows |

|---|---|---|

| 操作系统 | macOS Sonoma | Windows 10/11 |

| CPU | M4 | 12核或以上 |

| 内存 | 16GB | 32GB或以上 |

| 硬盘空间 | 20GB | 20GB或以上 |

🛠️ Ollama安装配置

官网:https://ollama.com/

模型:https://ollama.com/library

Github:https://github.com/ollama/ollama

Docker:https://hub.docker.com/r/ollama/ollama/tags

1. 安装Ollama

# 使用Homebrew安装

brew install ollama

# 或直接下载安装包

curl https://ollama.ai/download/Ollama-darwin.zip -o Ollama.zip

unzip Ollama.zip

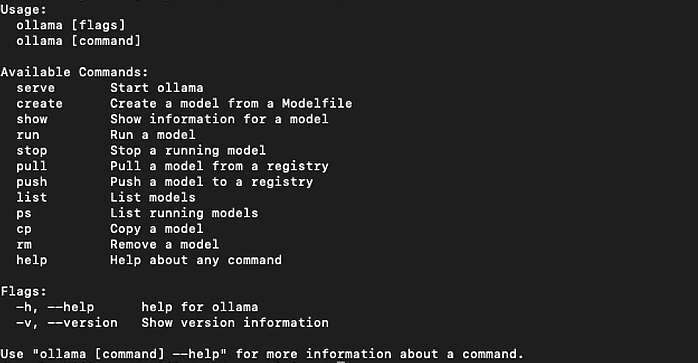

# 输入`ollama`或 `ollama -v`验证安装

ollama

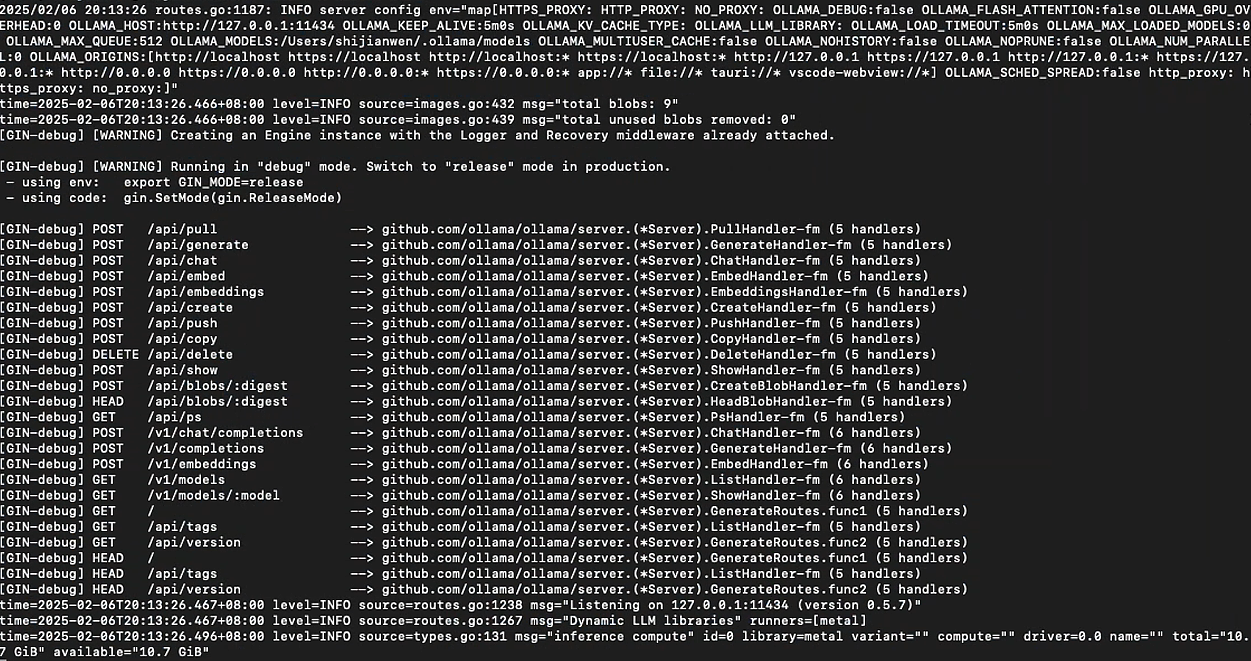

2. 启动Ollama

# 启动Ollama服务

ollama serve

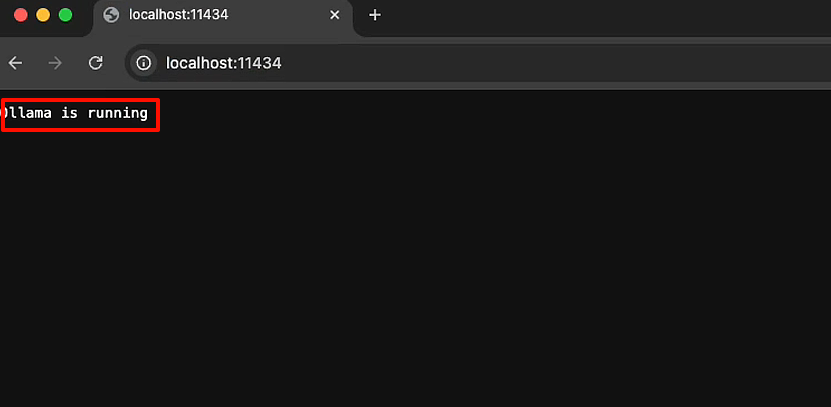

# 或点击浏览器访问:http://localhost:11434

显示Ollama is running代表已经运行起来了!

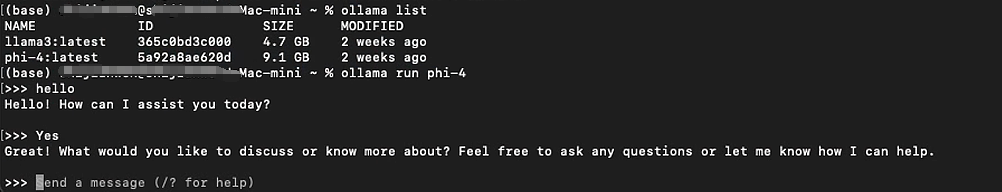

# 下载Llama3 8B模型

ollama run llama3:8b # 建议先尝试小模型

💡 小贴士:你应该至少有 8 GB 的 RAM 来运行 7B 模型,16 GB 的 RAM 来运行 13B 模型,以及 32 GB 的 RAM 来运行 33B 模型。

3. 模型存储位置

Mac下,Ollama的默认存储位置:

- 模型文件:

~/.ollama/models - 配置文件:

~/Library/Application Support/Ollama

Windows下,Ollama的默认存储位置:

- 程序目录:

C:\Users\<用户名>\AppData\Local\Programs\Ollama - 模型目录:

C:\Users\<用户名>\.ollamamodels - 配置文件:

C:\Users\<用户名>\AppData\Local\Ollama

💡 小贴士:建议通过环境变量OLLAMA_MODELS自定义模型存储路径,避免占用系统盘空间。

4. 配置 Ollama 环境变量

Ollama 提供了

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

1593

1593

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?