LM Studio:在 Mac 上轻松运行本地 AI 大模型

1. 下载与安装 LM Studio

步骤 1:访问官网并下载

- 打开浏览器,访问 LM Studio 官网。

- 选择适用于 Mac 的版本并下载安装包。

步骤 2:安装 LM Studio

- 将下载的

.dmg文件拖拽到Applications文件夹中。 - 打开

Applications文件夹,双击 LM Studio 图标启动程序。 - 根据提示完成安全设置(如允许从“未知来源”安装)。

步骤 3:为 LM Studio 更换镜像源(全局替换)

原因:安装开始搜索模型时,列表可以看到,但无法下载模型。这是因为 https://huggingface.co/ 在国内无法访问。即便有科学上网,设置了全局代理也无法生效,无法下载模型。

详细拆解:

- 科学上网的作用:

- 科学上网工具(如 VPN 或代理)通常会将你的网络流量通过境外服务器转发,从而绕过国内的网络限制。

- LM Studio 的特殊性:

- 对于大多数软件(如浏览器),科学上网工具可以正常工作,因为它们会遵循系统的代理设置或环境变量(如 HTTP_PROXY)。

- 但是 LM Studio 不支持通过 HTTP_PROXY 设置代理,因此即使你有科学上网工具,LM Studio 也不会使用你配置的代理工具,而是通过 HTTPS 直接尝试连接 Hugging Face。

解决办法:

- 在

huggingface.co或国内镜像站hf-mirror.com的项目介绍页面下载模型后,拖入 LM Studio 的模型文件夹。这样无法利用 LM Studio 本身的搜索功能。 - 使用国内镜像站

hf-mirror.com替换huggingface.co。

使用第2种办法:全局替换

在 macOS 上使用 VSCode 为 LM Studio 设置国内模型源(将 huggingface.co 替换为 hf-mirror.com)的操作步骤如下:

-

准备工作:检查VSCode 的

code命令有没有正确安装或配置到系统的环境变量中- 安装 VSCode 的

code命令- 打开 VSCode。

- 按下

Cmd+Shift+P,打开命令面板。 - 输入

Shell Command: Install 'code' command in PATH,然后选择并运行该命令。 - 完成后,关闭并重新打开终端。

- 验证

code命令是否可用

在终端中输入以下命令:

如果显示 VSCode 的版本号,说明code --versioncode命令已成功安装。

- 确认 LM Studio 的安装路径

- 通常位于

/Applications/LM Studio.app/Contents/

- 通常位于

- 安装 VSCode 的

-

定位 LM Studio 的配置文件

- 打开 终端(Terminal)。

- 输入以下命令,进入 LM Studio 的

.webpack目录:cd /Applications/LM\ Studio.app/Contents/Resources/app/.webpack - 使用以下命令在 VSCode 中打开该目录:

code .

-

全局替换域名

- 在 VSCode 中,按下

Ctrl+Shift+H(或点击菜单栏的Search > Replace in Files),打开全局替换功能。 - 在

Find输入框中输入huggingface.co,在Replace输入框中输入hf-mirror.com。 - 点击

Replace All,将所有文件中的huggingface.co替换为hf-mirror.com。

保存所有修改(Ctrl+S)。

- 在 VSCode 中,按下

-

重启 LM Studio

- 关闭 VSCode 和 LM Studio(如果已打开)。

- 重新启动 LM Studio,此时模型下载功能应已恢复正常。

-

验证

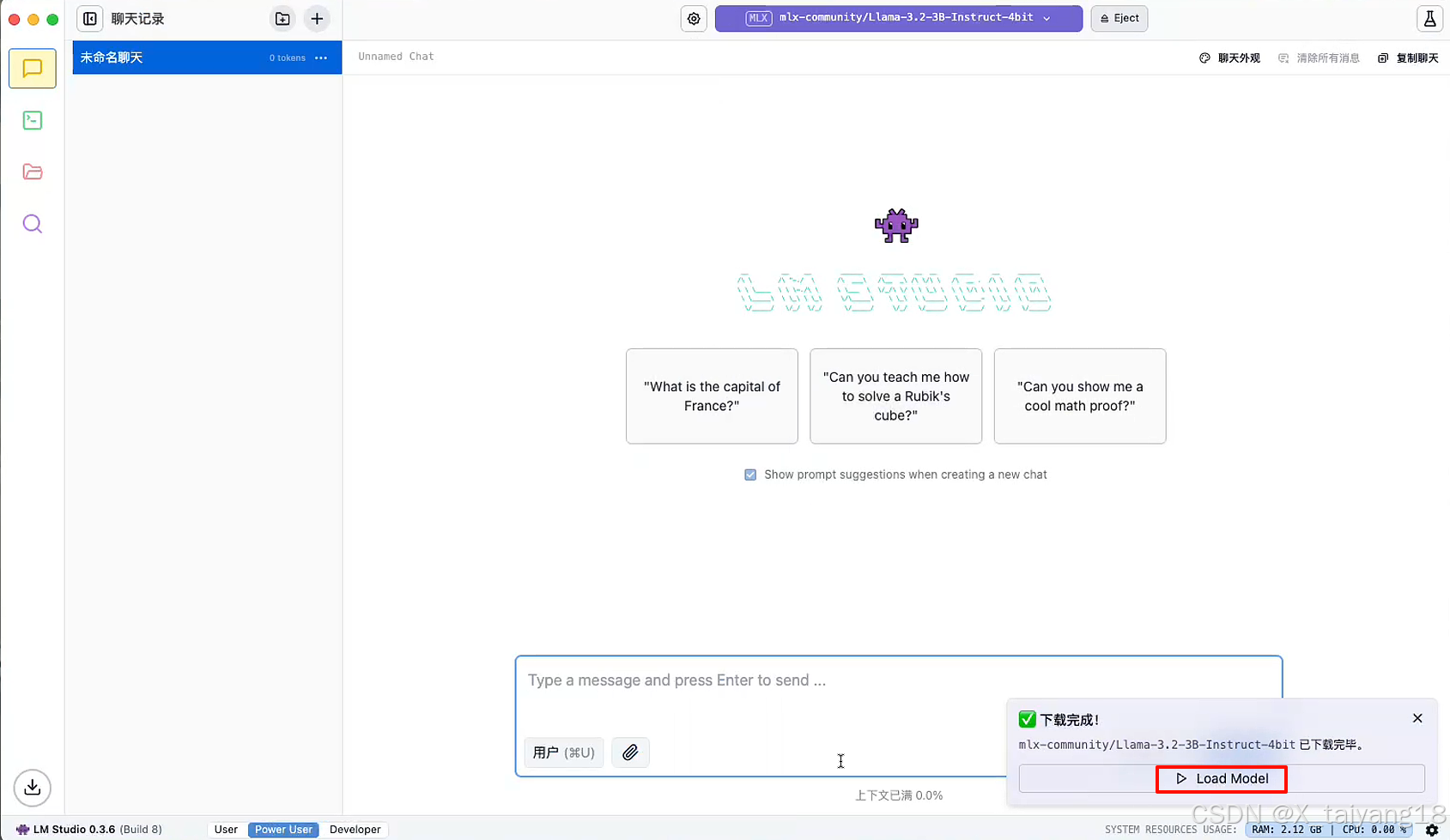

- 在 LM Studio 中尝试搜索并下载模型(如

Llama 3.2 3B Instruct 4bit)。 - 如果模型能够正常下载,说明替换成功。

- 在 LM Studio 中尝试搜索并下载模型(如

步骤 4:设置中文(可选)

在 LM Studio 的右下角设置中,选择中文语言。

步骤 5:设置模型目录(可选)

可以修改但是建议将模型目录设置为英文路径,避免中文特殊符号导致的问题。

2. 使用聊天界面

点击Load Model

功能亮点

-

实时互动:与模型对话,观察其反应和性能指标(如每秒 token 数)。

-

多模型支持:轻松切换不同模型,体验不同的 AI 能力。

-

Qwen2-7B-Instruct-4bit

-

DeepSeek-Coder-V2-Lite-Instruct-4bit-mlx

-

Llama-3.2-3B-Instruct-4bit

3. 利用 API 服务器

步骤 1:启动 API 服务器

- 点击左侧边栏的“服务器”图标。

- 点击“启动服务器”按钮,复制提供的服务器地址(如

http://localhost:1234)。

步骤 2:发送 API 请求

- 使用 Postman 或代码向服务器发送请求。例如:

curl http://localhost:1234/v1/chat/completions \ -H "Content-Type: application/json" \ -d '{ "model": "deepseek-coder-v2-lite-instruct-mlx", "messages": [ {"role": "system", "content": "你是一个乐于助人的助手,对Python非常了解"}, {"role": "user", "content": "讲一个笑话"} ], "temperature": 0.7, "max_tokens": 50, "stream": false }' - 观察模型的回复,并将其集成到你的应用中。

4. 常见问题与解决方案

问题 1:无法下载模型

- 原因:国内用户可能无法直接访问 Hugging Face 模型库。

- 解决方案:使用镜像站点

hf-mirror.com替换huggingface.co,具体方法如下:- 打开 LM Studio 的安装目录。

- 使用文本编辑器全局替换

huggingface.co为hf-mirror.com。 - 如果替换后仍无法下载模型,可以尝试清除 LM Studio 的缓存或重新安装软件。

问题 2:模型加载缓慢

- 原因:模型文件较大,或硬件配置不足。

- 解决方案:选择较小的模型(如

llama2 3B),或升级硬件配置(建议至少 16GB 内存)。

结语

LM Studio 是一款功能强大且易于使用的工具,适合任何希望在 Mac 上运行本地 AI 模型的用户。无论是探索 AI 的初学者,还是需要快速集成模型的开发者,LM Studio 都能满足你的需求。赶快下载并体验吧!🎉

如果你在安装或使用过程中遇到问题,欢迎在评论区留言,我会尽力为你解答!💬

参考来源:

854

854

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?