来源:量子位

尤洋团队新作,首个基于DiT的实时视频生成方法来了!

先来直观感受一下效果(右侧为新方法):

这是团队在Open-Sora上,使用5个4s(192帧)480p分辨率视频进行的测试。

新方法名为Pyramid Attention Broadcast(PAB),由新加坡国立大学尤洋以及3位学生推出。

具体来说,PAB通过减少冗余注意力计算,可实现高达21.6FPS和10.6倍加速,并且不会牺牲基于DiT的流行视频生成模型(包括Open-Sora、Open-Sora-Plan和Latte)的质量。

作为一种免训练方法,PAB可为将来任何基于DiT的视频生成模型提供实时功能。

看完效果对比,网友们纷纷惊叹:

这将是新纪元。

也引来了众多专业人士的转发和点评,如MIT博士Yilun Du表示:

是一个展示了如何将视频生成加速到实时速度的酷炫工作!可能会为视频策略和模拟的现实世界用例开辟新的领域。

那么,新方法具体如何破解实时生成视频这个难题的呢?

减少冗余注意力计算

一开始,团队比较了当前扩散步骤与前一步骤的注意力输出差异。

这些差异通过均方误差(MSE)进行量化,并对每个扩散步骤的所有层进行平均。

团队捕捉到两个关键信息:

随着时间推移,注意力差异遵循U形模式,中间70%差异较小

注意力差异的排序为:空间>时间>交叉

具体而言,不同时间步骤的注意力差异呈现出U形模式,在第一步和最后一步的15%步骤中发生显著变化,而中间70%的步骤非常稳定,差异很小。

其次,在稳定的中间部分,不同类型的注意力表现出差异:空间注意力变化最大,涉及高频元素,如边缘和纹理;时间注意力显示出与视频中的运动和动态相关的中频变化;跨模态注意力最为稳定,它将文本与视频内容联系起来,类似于反映文本语义的低频信号。

对此,团队正式提出用PAB来减少不必要的注意力计算。

PAB通过根据每种注意力的差异将注意力输出到不同的后续步骤,从而节省计算量。

举个例子,就像广播电台把一个信号发送给多个听众一样,如果某个步骤的注意力结果在接下来的几个步骤中仍然适用,就不需要重新计算,而是直接使用之前的结果。

团队发现,即使没有后期训练,这种简单策略也能实现高达35%的加速,并且质量损失可以忽略不计。

为了进一步增强PAB,团队基于动态序列并行(DSP)改进了序列并行。

序列并行通过在多个GPU上分割视频以降低延迟,但DSP带来的时间注意力需两次全对全通信,导致高通信开销。

而PAB由于时间注意力不再需要被计算,使这些通信开销减少了50%以上,从而优化了实时视频生成的分布式推理效率。

借助并行功能,PAB可实现高达21.6FPS和10.6倍加速,并且不会牺牲基于DiT的流行视频生成模型(包括Open-Sora、Open-Sora-Plan和Latte)的质量。

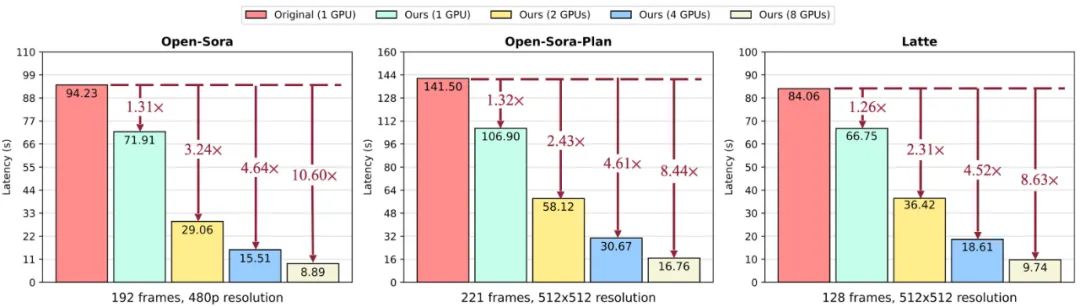

展开来说,团队测量了PAB在8个英伟达H100 GPU上为不同模型生成单个视频的总延迟。

使用单个GPU时,PAB实现了1.26倍到1.32倍的速度提升,这一提升在不同调度器中保持稳定。

扩展到多个GPU时,PAB实现了高达10.6倍的速度提升,且这一提升几乎与GPU数量成线性关系。

背后团队

简单介绍一下提出PAB的团队成员,总共有4位。

尤洋教授想必大家都比较熟悉了,清华计算机系硕士,UC伯克利博士,毕业后加入新加坡国立大学计算机系,担任校长青年教授 (Presidential Young Professor)。

2021年7月,在北京中关村创办了“潞晨科技”。

作者之一Xuanlei Zhao(赵轩磊),华科大计算机科学与电子信息专业工程学士,硕博均在新国立(目前为博一),导师为尤洋,研究方向包括但不限于算法、数据结构、计算机网络、信号处理、通信系统等方面。

作者之一Kai Wang(王锴),新国立HPC-AI实验室博士生,导师为尤洋,本科就读于北师大珠海分校电气工程与自动化系,硕士就读于中科院深圳先进技术研究院(MMLAB-SIAT),研究重点是以数据为中心的人工智能和高效机器学习。他和尤洋教授共同指导了这个项目。

最后一位Xiaolong Jin(金小龙),本科就读于中国科学技术大学少年班学院,目前是普渡大学在读博士生。

目前相关研究已公开,感兴趣可以进一步了解。

项目主页:

https://oahzxl.github.io/PAB/

开源地址:

https://github.com/NUS-HPC-AI-Lab/OpenDiT

参考链接:

[1]https://x.com/oahzxl/status/1805939975420330298

[2]https://kaiwang960112.github.io/#work_experience

[3]https://oahzxl.github.io/

[4]https://x.com/YangYou1991

[5]https://www.linkedin.com/in/xiaolong-jin-514651284/

推荐阅读

欢迎大家加入DLer-计算机视觉技术交流群!

大家好,群里会第一时间发布计算机视觉方向的前沿论文解读和交流分享,主要方向有:图像分类、Transformer、目标检测、目标跟踪、点云与语义分割、GAN、超分辨率、人脸检测与识别、动作行为与时空运动、模型压缩和量化剪枝、迁移学习、人体姿态估计等内容。

进群请备注:研究方向+学校/公司+昵称(如图像分类+上交+小明)

460

460

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?