论文名称:MambaNeXt-YOLO: A Hybrid State Space Model for Real-time Object Detection

论文原文 (Paper):https://arxiv.org/abs/2506.03654

代码 (code):https://github.com/iefengyan/WPFormer

GitHub 仓库链接(包含论文解读及即插即用代码):https://github.com/AITricks/AITricks

哔哩哔哩视频讲解:https://space.bilibili.com/57394501?spm_id_from=333.337.0.0

1. 核心思想

本文旨在解决传统 CNN 在捕获全局上下文方面的局限性以及 Transformer 在计算复杂度上的高昂代价,提出了一种名为 MambaNeXt-YOLO 的新型实时目标检测框架。其核心创新在于设计了 MambaNeXt Block,这是一种结合了 CNN 局部特征提取能力和 Mamba(状态空间模型)高效长距离序列建模能力的混合模块。此外,该框架还引入了 多分支非对称融合金字塔网络(MAFPN) 来优化多尺度特征融合。最终,MambaNeXt-YOLO 在保持低计算成本的同时,显著提升了检测精度,特别适合在资源受限的边缘设备上部署。

2. 背景与动机

-

文本角度总结:

实时目标检测在自动驾驶、监控和机器人等领域至关重要。YOLO 系列虽然速度快,但受限于 CNN 的局部感受野,难以捕捉复杂的全局上下文。基于 Transformer 的检测器虽然擅长全局建模,但其自注意力机制的二次方计算复杂度 O ( N 2 ) O(N^2) O(N2) 使得它们难以在边缘设备上实时运行。近期出现的 Mamba 模型凭借其线性复杂度的序列建模能力为解决这一矛盾提供了新思路。然而,现有的 MambaYOLO 等尝试往往设计单一,未能充分挖掘 CNN 与 SSM 的协同潜力,也缺乏针对多尺度目标的优化。因此,本文提出了 MambaNeXt-YOLO,旨在通过混合架构设计,同时实现高效的局部特征提取和全局上下文感知。 -

动机图解分析:

-

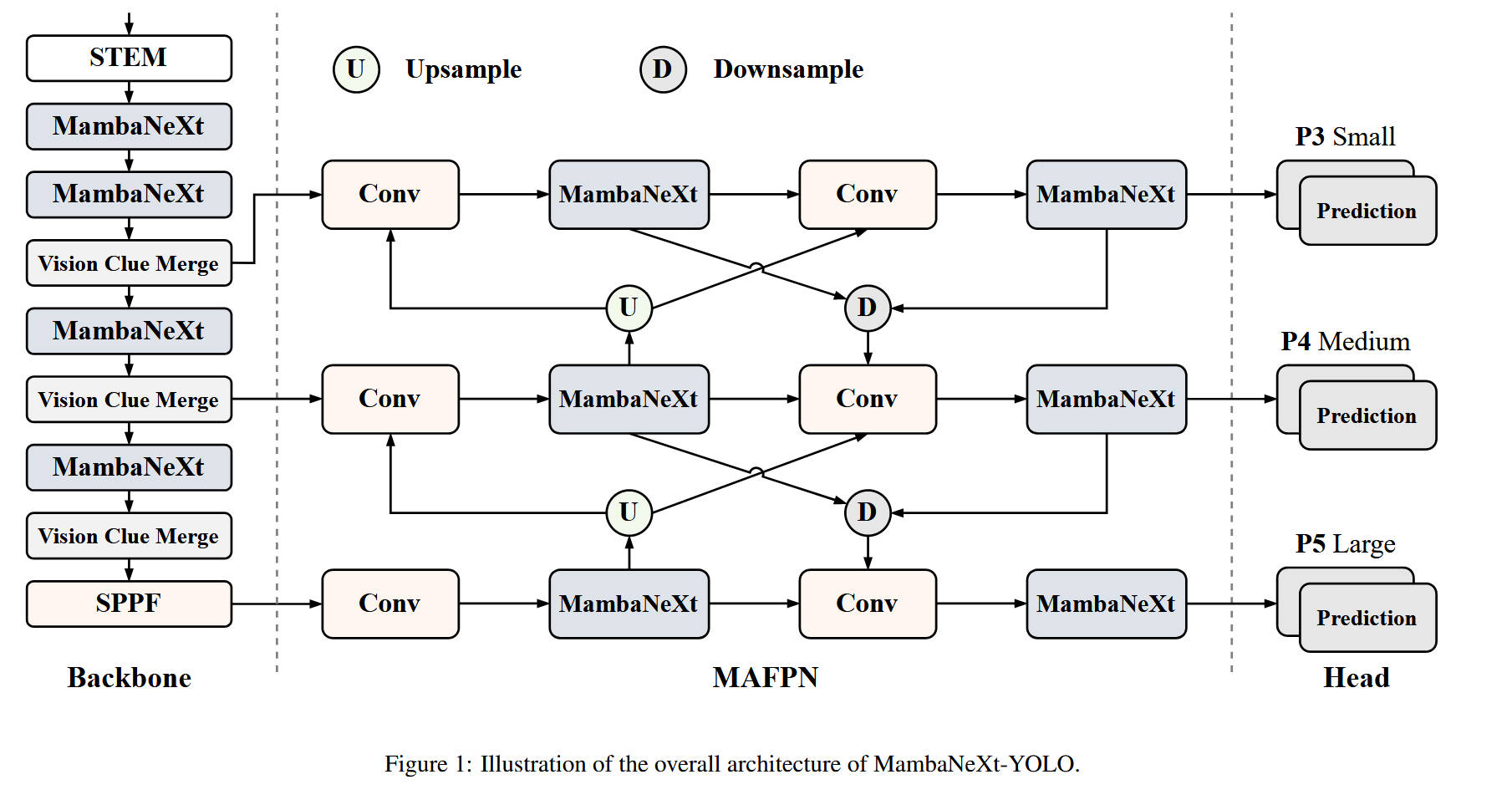

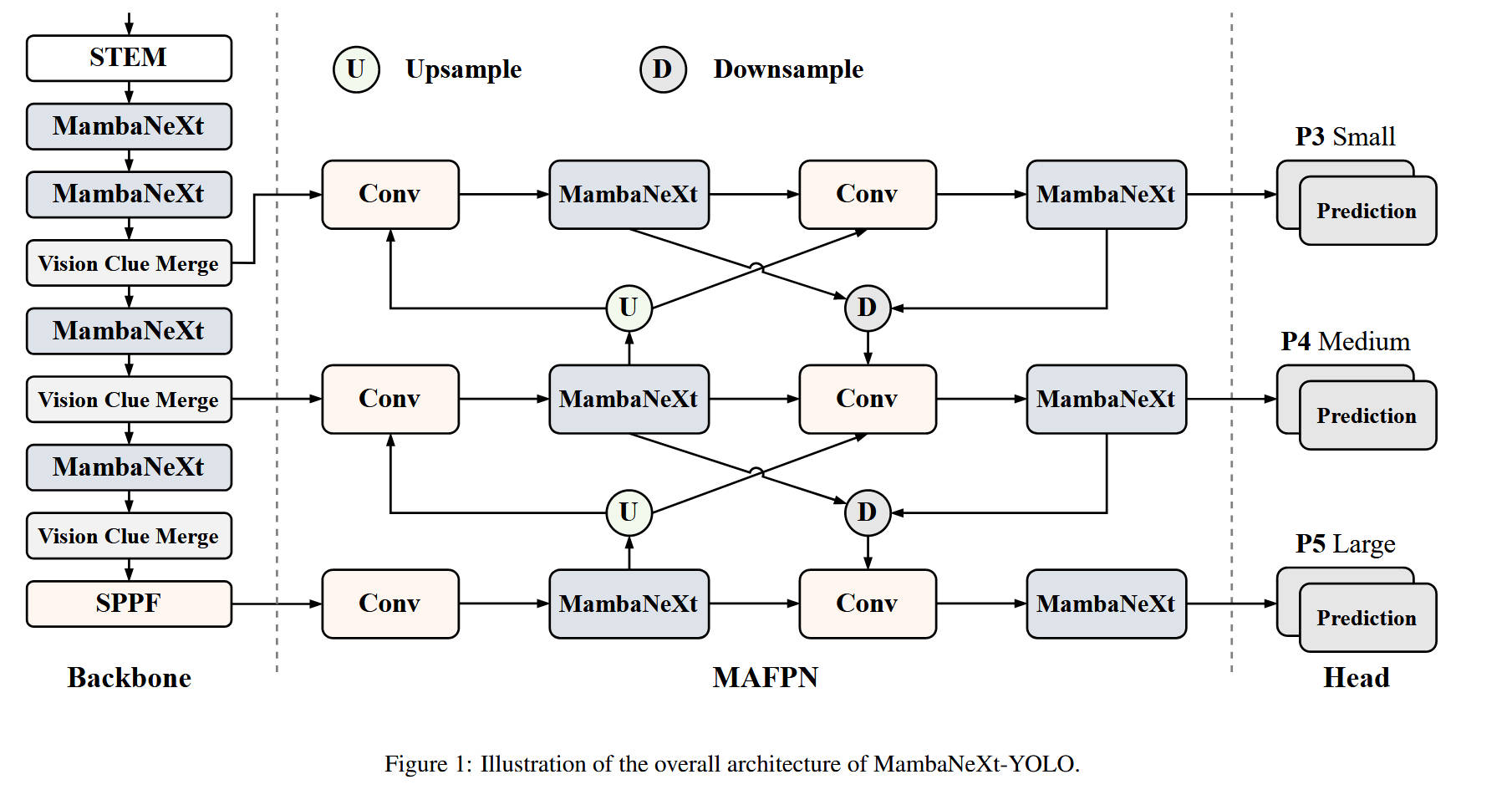

图 1 (Fig. 1): 整体架构概览

- 观察:展示了 MambaNeXt-YOLO 的整体结构,包括 Backbone、Neck (MAFPN) 和 Head。

- 分析:图中清晰地显示了 Backbone 由 STEM、堆叠的 MambaNeXt 模块和 Vision Clue Merge 模块组成。这反映了作者的动机:用混合模块(MambaNeXt)替代传统的纯 CNN 或纯 Mamba 模块,以在特征提取阶段就兼顾局部与全局信息。同时,Neck 部分采用了复杂的跨层连接(MAFPN),旨在解决多尺度目标检测的难题。

-

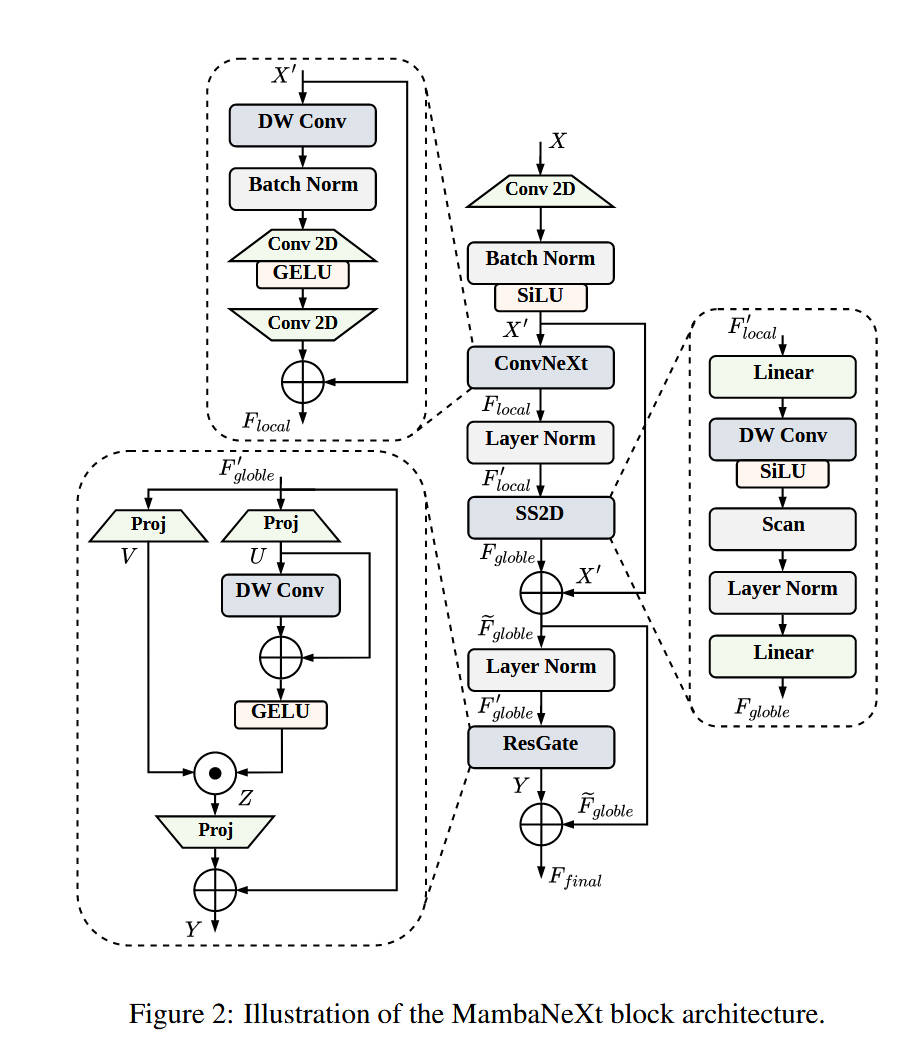

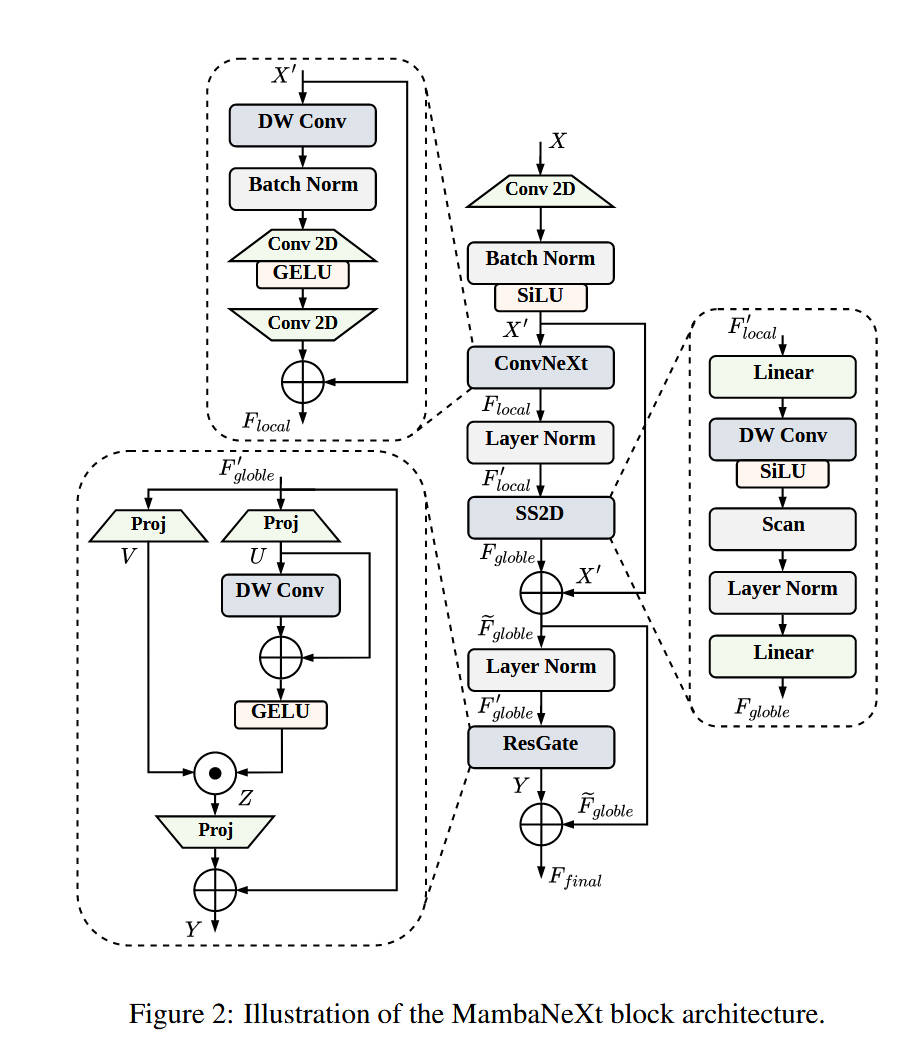

图 2 (Fig. 2): MambaNeXt Block 结构

- 观察:该图拆解了核心模块的内部构造,包含 ConvNeXt(局部)、SS2D Mamba(全局)和 ResGate(融合)。

- 分析:这直接回应了“如何协同 CNN 和 Mamba”的问题。ConvNeXt 分支负责提取细粒度的空间纹理(Local),Mamba 分支通过 SS2D 扫描机制捕捉长距离依赖(Global),ResGate 则负责自适应地融合这两类特征。这种设计有效地解决了单一模型在特征表达上的局限性。

-

3. 主要贡献点

-

[贡献点 1]:提出了 MambaNeXt Block

设计了一种新颖的混合模块,无缝集成了 ConvNeXt 风格的卷积层(用于局部特征)和 Visual Mamba (SS2D) 模块(用于全局依赖)。这种设计在保持线性计算复杂度的同时,显著增强了特征的表达能力。 -

[贡献点 2]:设计了多分支非对称融合金字塔网络(MAFPN)

改进了特征金字塔网络,引入了非对称的特征融合路径。通过结合自顶向下和自底向上的信息流,并利用 MambaNeXt 模块进行特征细化,MAFPN 有效提升了对不同尺度(特别是小物体)的检测性能。 -

[贡献点 3]:实现了边缘设备上的高效部署

在不使用任何预训练权重的情况下,MambaNeXt-YOLO 在 PASCAL VOC 数据集上达到了 66.6% mAP,且在 NVIDIA Jetson Orin NX 上实现了 31.9 FPS 的推理速度,证明了其在资源受限环境下的实用性。

4. 方法细节

-

整体网络架构(对应 Figure 1):

- Backbone:

- Stem:利用浅层卷积进行初步的 Patch Embedding。

- Stage 1-3:每个 Stage 包含堆叠的 MambaNeXt 模块,用于提取特征。

- Vision Clue Merge (VCM):在 Stage 之间,使用 VCM 模块(对应 Fig. 3)进行下采样。VCM 通过空间切分(Spatial Split)和点卷积(Pointwise Conv)来压缩特征图,避免了信息丢失。

- SPPF:在 Backbone 末端使用 SPPF 进一步扩大感受野。

- Neck (MAFPN):

采用了多分支架构,包含自顶向下(Upsample)和自底向上(Downsample)的路径。特征在融合时,经过 Conv 层处理,并再次通过 MambaNeXt 模块进行特征增强,确保多尺度语义的充分交互。 - Head:

采用解耦的检测头(Decoupled Head),分别为 P3(小目标)、P4(中目标)、P5(大目标)三个尺度的特征图预测类别和边界框。

- Backbone:

-

核心创新模块详解:

-

模块 A:MambaNeXt Block(对应 Figure 2)

- 内部结构:由三个并行/串行组件构成。

- ConvNeXt Local Block (局部特征):

- 输入特征 X X X 经过预处理得到 X ′ X' X′。

- X ′ X' X′ 进入 ConvNeXt 风格的卷积块: 7 × 7 7 \times 7 7×7 Depthwise Conv -> LN -> 1 × 1 1 \times 1 1×1 Pointwise Conv -> GELU -> 1 × 1 1 \times 1 1×1 Pointwise Conv。

- 输出 F l o c a l F_{local} Flocal,专注于捕获局部空间细节。

- Mamba Global Block (全局特征):

- F l o c a l F_{local} Flocal 作为输入,经过 LN 和 Linear 投影。

- SS2D Scan:核心步骤。特征被展平并沿四个方向(SS2D 机制)扫描,利用 SSM 的线性递归公式 h t + 1 = … h_{t+1} = \dots ht+1=… 更新隐状态,捕捉全局依赖。

- 输出经过重塑和线性投影,得到 F g l o b a l F_{global} Fglobal。

- ResGate Fusion Block (特征融合):

- 将 F g l o b a l F_{global} Fglobal 与原始输入 X ′ X' X′ 相加(残差连接)。

- Gating 机制:通过两个线性投影生成门控信号 U U U 和 V V V。利用深度卷积和 GELU 激活处理 U U U,然后与 V V V 进行元素级乘法(Gating)。

- 最终输出通过残差连接生成 F f i n a l F_{final} Ffinal。

- 设计目的:ConvNeXt 提取纹理,Mamba 关联上下文,ResGate 动态筛选有效信息,三者协作实现“既见树木,又见森林”。

-

模块 B:MAFPN (Neck 部分)(对应 Figure 1 中间部分)

- 内部结构:改进的特征金字塔。

- 数据流:

- 非对称融合:不仅有传统的 FPN(自顶向下),还有 PANet 风格的自底向上路径。

- 核心组件替换:将标准 FPN 中的卷积块替换为 MambaNeXt 模块。这意味着在特征融合阶段,网络依然在进行高强度的全局上下文建模。

- 下采样优化:在自底向上的路径中,使用跨步卷积(Stride Conv)替代最大池化,以减少信息损失。

- 设计理念:通过在 Neck 阶段引入 Mamba 的长距离建模能力,使得不同尺度的特征(如 P3 的小目标特征)能够感知到全局背景信息,从而提升检测准确率。

-

-

理念与机制总结:

- 混合建模(Hybrid Modeling):MambaNeXt-YOLO 坚信“卷积 + SSM > 单一模型”。它利用卷积的归纳偏置(Inductive Bias)来加速收敛和提取细节,利用 SSM 的线性全局能力来理解场景。

- 自适应融合(Adaptive Fusion):ResGate 机制允许网络根据输入内容动态调整局部特征和全局特征的权重,类似于一种注意力机制,但计算更高效。

-

图解总结:

- Figure 1 展示了宏观的“YOLO 风格”架构,但在模块内部(灰色框)和融合节点(蓝色框)进行了彻底革新。

- Figure 2 清晰地描绘了数据流在 MambaNeXt Block 中的“分流-处理-汇合”过程:数据先流经 ConvNeXt 变“厚”(提取局部特征),再流经 Mamba 变“广”(提取全局特征),最后通过 ResGate 变“精”(特征筛选)。

5. 即插即用模块的作用

本文提出的模块具有很好的通用性,可应用于其他视觉任务:

-

MambaNeXt Block

- 适用场景:任何需要兼顾局部细节和长距离依赖的视觉任务,如图像分类、语义分割、图像复原。

- 具体应用:

- 替换 Backbone:可以直接替换 ResNet、Swin Transformer 或 ConvNeXt 中的基础 Block,构建强力且高效的特征提取器。

- 增强 U-Net:在医学图像分割(如 U-Net)的瓶颈层(Bottleneck)使用 MambaNeXt Block,可以帮助模型更好地理解器官的长距离空间关系。

-

ResGate Block (以及 VCM 模块)

- 适用场景:特征融合或下采样阶段。

- 具体应用:

- 多模态融合:ResGate 的门控机制非常适合用于融合不同模态(如 RGB + Depth)的特征,可以动态选择有效信息。

- 无损下采样:VCM (Vision Clue Merge) 可以作为一种通用的下采样层(Downsampling Layer),替代传统的 MaxPool 或 Stride Conv,用于在分类或检测网络中减少空间分辨率同时保留更多信息。

-

MAFPN (Multi-branch Asymmetric Fusion Pyramid Network)

- 适用场景:目标检测、实例分割中的 Neck 部分。

- 具体应用:

- 提升 YOLO 性能:可以直接移植到 YOLOv5/v8/v10 等模型中,替换原有的 PANet。通过在 Neck 引入 Mamba 模块,可以显著提升模型对复杂场景和多尺度目标的理解能力,尤其是对大物体或背景干扰严重的场景。

到此,所有的内容就基本讲完了。如果觉得这篇文章对你有用,记得点赞、收藏并分享给你的小伙伴们哦😄。

2732

2732

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?