在 CA ARCserve Backup 中,重复数据消除是只能处理备份服务器上的单个会话。如果是要备份两台服务器(例如C盘),而这两台服务器有很多文件是相同的,则需要使用 “全局重复数据消除” 。

下面是CA 执行dedup的过程——

在第一次备份过程中:

(1)、CA ARCserve Backup 扫描传入数据并将其分解成块。此进程在磁带引擎的 SIS 层进行。

(2)、 CA ARCserve Backup 执行哈希算法,该算法会为每个数据块指定唯一的值,然后 CA ARCserve Backup 会将这些值保存到一个哈希文件中。 (3)、CA ARCserve Backup 比较哈希值。当发现重复数据之后,数据仅写入 磁盘一次,并且引用将添加到引用文件(指向首次识别的该数据块实例的存储位置)。

在后续备份过程中:

(1)、CA ARCserve Backup 扫描传入数据并将其分解成块。

(2)、CA ARCserve Backup 执行哈希算法以指定哈希值。 (3)、 CA ARCserve Backup 将新的哈希值与先前的值进行比较,以查找重复数据。如果发现了重复数据,则数据将不写入磁盘, 而是使用数据块原始 实例的存储位置来更新引用文件。

另外可以使用优化以获得更好的吞吐量并减少对 CPU 的占用。启用优化后, CA ARCserve Backup 会扫描文件属性,查找文件标头级的更改。如果没有更改,则不对这些文件执行哈希算法,文件也不会复制到磁盘。哈希算法仅会对自上次备份后有所更改的文件运行。仅在 Windows 卷中支持优化。不支持对基于数据流的备份的优化,例如 SQL VDI、Exchange 数据库级、Oracle 和 VMware 映像级备份。

下面是做的dedup的实验。

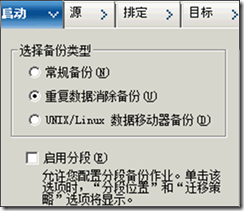

step1、在启动项中选择“重复数据消除备份”

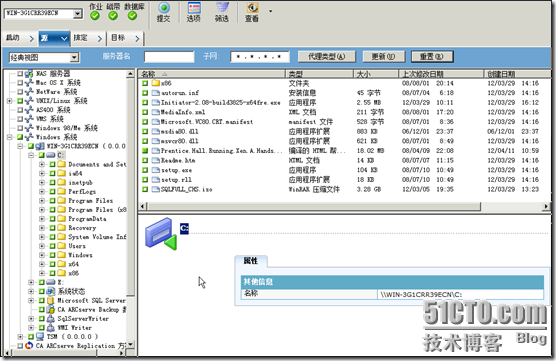

step2、在源中选择备份一个18.02M的电子书

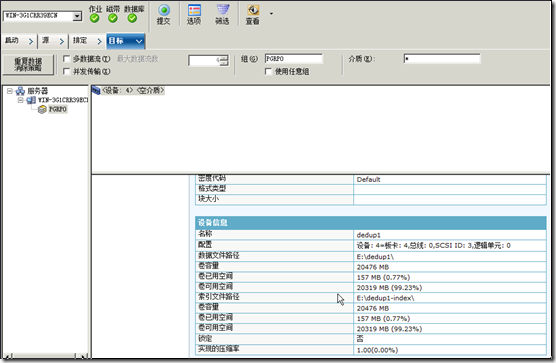

step3、在“目标”项中选择创建的“重复数据消除设备dedup1”,在如下图的右下角可以看到dedup1设备的详细信息

step4、备份完成

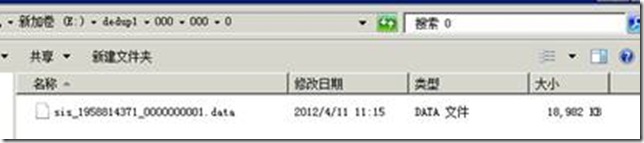

step5、可以看到在备份目录的“数据文件”中多了“000”这个文件夹

看到“000”目录下的备份数据是18982KB。

注:数据文件存储已备份数据的唯一实例。

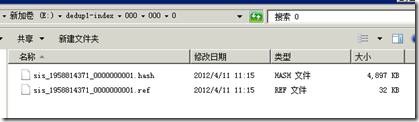

step6、再看“索引文件”中多了如下一些内容,

“000”目录中包括如下内容,其中由一个计算源文件得到的hash值的文件*.hash

注:

哈希文件 - 存储为每个冗余数据块分配的标记。

引用文件 - 计算哈希数量,并将地址存储到与各哈希相对应的数据文件中。

step7、再次备份18.02的电子书。可以看到数据文件中并没有大的变化,知识多了个49KB的“000000002.data”文件。

step8、看到多了“000000002.hash”文件和“000000002.ref”文件,两次hash计算得到的值是一样的。说明已经成功地经过SIS后再存储备份文件。

相关文章:

CA ARCserve Backup系列(4)—配置设备---

http://taotao1240.blog.51cto.com/731446/838243

CA ARCserve Backup系列(3)—安装代理(Linux篇)---http://taotao1240.blog.51cto.com/731446/833003

CA ARCserve Backup系列(2)—安装代理(windows篇)---

http://taotao1240.blog.51cto.com/731446/833002

CA ARCserve Backup系列(1)—安装---

http://taotao1240.blog.51cto.com/731446/832022

![clip_p_w_picpath002[11] clip_p_w_picpath002[11]](https://img-blog.csdnimg.cn/img_convert/1c99ffe2b5fd28aa96884060f58e160c.png)

2518

2518

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?