一.机器学习的定义(machine learning)

机器学习最常用的是以下两类:

1.监督学习(supervised learning)

2.无监督学习(unsupervised learning)

二.监督学习

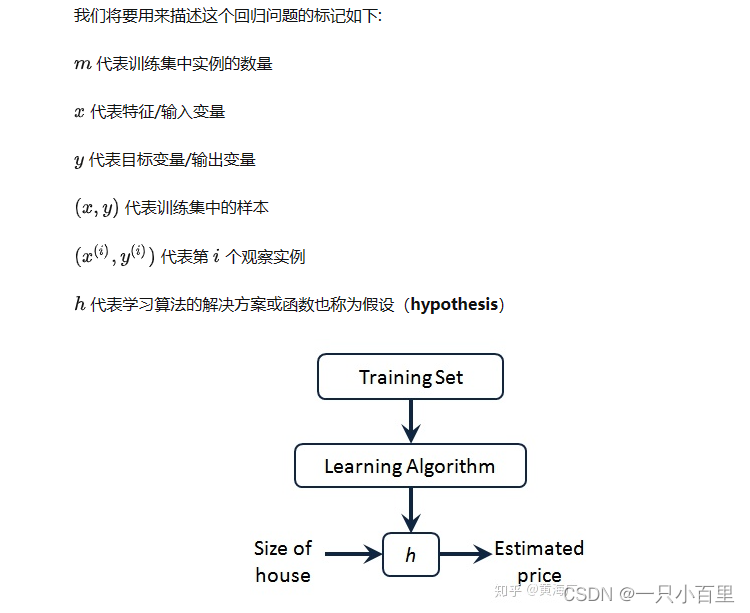

监督学习是指在训练数据中已经给出了“正确”的输出结果,机器学习模型通过学习这些已知输出和相应的 输入之间的关系,从而对新的数据做出准确的预测,在监督学习中,我们有个数据集,这个数据集被称为训练集。

三.无监督学习

无监督学习是指给你一个数据集,并不提前告知算法一些信息,要求自动找到数据中的结构,对数据聚类找出这些事物结构上的特征

四.单变量线性回归

4.1模型表示

4.1.1回归:回归问题实质预测连续值型变量的问题,我们需要通过已有数据集,建立一个模型,通过学习数据集中的特征和目标值的关系,来预测位置样本的目标值,常见的回归算法包括线性回归,多项式回归,决策树回归,神经网络回归等。

4.1.2分类:分类问题是预测离散型变量的问题,在分类问题中,我们需要将样本分为不同的类别,常见的分类算法包括逻辑回归、决策树分类、支持向量机、神经网络分类等。

4.1.3单变量线性回归问题:只含有一个特征/输入变量

4.1.4描述回归问题的标记:

五.代价函数

代价函数是机器学习中用来评估模型预测结果与真实值之间差异的函数,在监督学习中,我们通常会将数据集分为训练集和测试集,用训练集来训练模型,用测试集来评估模型的性能,代价函数就是用来度量模型在训练集上表现的。

代价函数通常用数学公式来表示,输入为预测结果和真实值,输出为一个实数,表示模型预测结果和真实值之间的差异。值越小,说明模型的预测结果越接近真实值,模型的性能越好。

在监督学习中,常见的代价函数包括均方误差(Mean Squared Error,MSE)和交叉熵(Cross Entropy)等。均方误差是回归问题中常用的代价函数,它用于度量模型预测结果和真实值之间的平均差异。交叉熵是分类问题中常用的代价函数,它用于度量模型预测结果和真实值之间的差异。交叉熵可以分为二元交叉熵和多元交叉熵两种,分别用于二分类问题和多分类问题。

选择合适的代价函数对于机器学习的性能和效果至关重要。一个好的代价函数应该能够反映模型预测结果与真实值之间的差异,并且能够被有效地优化。在实际应用中,我们需要根据具体问题的特点选择合适的代价函数,并通过调整模型的参数来最小化代价函数的值,从而得到最优的模型。

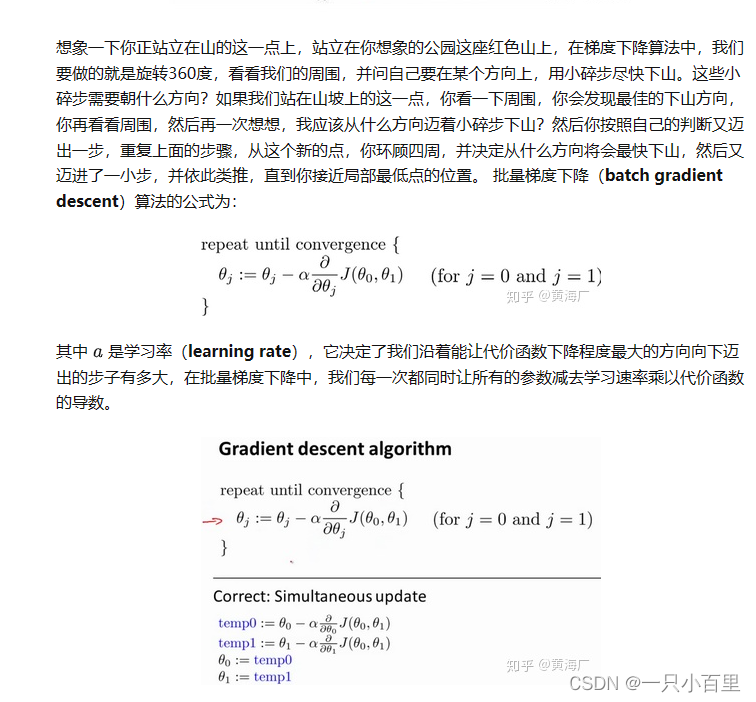

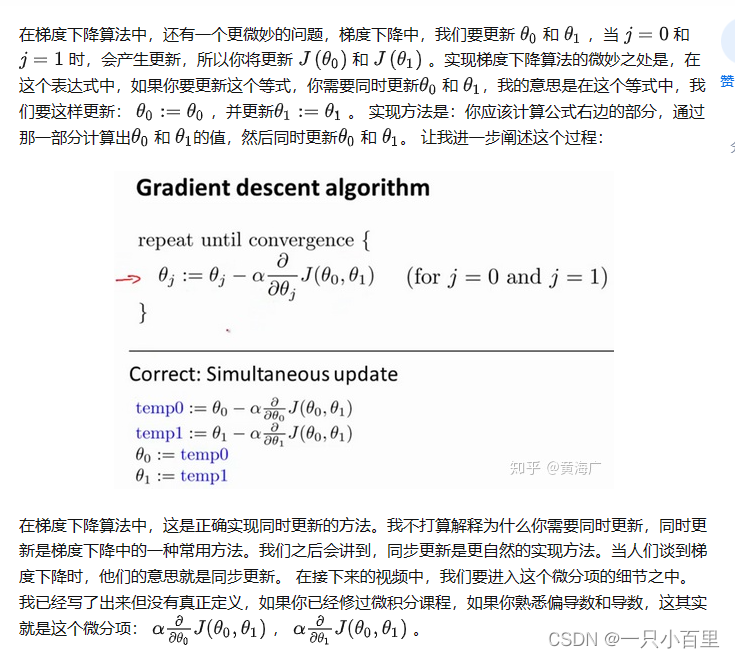

六.梯度下降

梯度下降算法是一个用来求最小值的算法,我们将使用梯度下降算法来求出代价函数的最小值。梯度下降的思想是:开始时我们随机选择一个参数组合,计算代价函数,然后我们寻找下一个能让代价函数下降最多的参数组合,重复此过程直到得到一个局部最小值(因为只使用了局部参数组合,所以只能得到局部最小值,用此最小值去接近全局最小值)

梯度下降算法的步骤如下:

-

随机初始化模型参数。

-

计算代价函数对于每个参数的偏导数(即梯度)。

-

根据梯度的方向和大小,更新模型参数。通常使用学习率(Learning Rate)来控制每次参数更新的步长。

-

重复步骤2和3,直到达到最小化代价函数的目标。

七.三种梯度下降算法:

1.批量梯度下降

最基础的梯度下降算法,每次更新模型时使用所有训练数据来计算梯度,算法具体实现步骤如下:

- 随机初始化模型参数。

- 在训练集上计算代价函数的梯度。

- 根据梯度的方向和大小,更新模型参数。

- 重复步骤2和3,直到达到最小化代价函数的目标。

批量梯度下降算法的优点是能够保证收敛到全局最优解,但缺点是每次更新模型参数时需要使用所有训练数据,计算速度较慢,尤其在处理大规模数据时。

2.随机梯度下降

随机梯度下降是指每次更新模型参数时只使用一个样本数据来计算梯度。梯度下降算法的步骤如下:

- 随机初始化模型参数。

- 在训练集中随机选择一个样本,计算该样本的代价函数的梯度。

- 根据梯度的方向和大小,更新模型参数。

- 重复步骤2和3,直到达到最小化代价函数的目标。

随机梯度下降算法的优点是计算速度较快,但缺点是可能会导致参数更新不稳定,并且可能会收敛到局部最优解。

3.小批量梯度下降

小批量梯度下降算法是介于批量梯度下降和随机梯度下降之间,每次使用一批数据来计算梯度。具体来说,小批量梯度下降算法的步骤如下:

- 随机初始化模型参数。

- 在训练集中随机选择一批数据,计算该批数据的代价函数的梯度。

- 根据梯度的方向和大小,更新模型参数。

- 重复步骤2和3,直到达到最小化代价函数的目标。

小批量梯度下降算法的优点是能够在处理大规模数据时保持计算速度较快的优势,同时也能够更稳定地更新模型参数。它是目前应用最广泛的梯度下降算法之一。

在梯度下降法中,当我们接近局部最低点时,梯度下降算法会自动采取更小的幅度,这是因为当我们接近局部最低点的时候,导数值会越来越小

八.梯度下降的线性回归

2万+

2万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?