在这项工作中,我们将迭代集成攻击视为随机梯度下降优化过程,其中不同模型上梯度的方差可能导致局部最优值不佳。为此,我们提出了一种新的攻击方法,称为随机方差降低集成(SVRE)攻击,它可以减少集成模型的梯度方差并充分利用集成攻击。标准ImageNet数据集的实证结果表明,所提出的方法可以提高对抗性可迁移性,并显着优于现有的集成攻击。

文中提出的一些总结性的知识:

- 现有的对抗攻击方法可以分为梯度优化攻击、输入转换攻击、模型集成攻击。集成攻击的基本思想是使用多个模型生成对抗样本

- 防御主要有基于对抗性训练的防御和基于输入转换的防御

- 对抗性训练被认为是最有效的防御方法之一,它通过在训练过程中生成对抗性样本来扩充训练数据。

- 如果一个采样图像再不同模型上更新方向的余弦相似度极低,那么说明这些模型再优化方向上存在相当大的差距,

- 在前人的工作中,Lin等人和Wang等[16,31]将对抗样本的生成过程类比为神经网络的训练过程,其中白盒模型类比为训练数据,黑盒模型类比为测试数据。因此,利用输入图像制作对抗样例的迭代优化可视为神经网络的参数更新,并将对抗样例的可转移性类比为模型的泛化

- SVRG的基本思想是利用预测方差缩减来减小随机梯度下降(Stochastic Gradient Descent, SGD)的固有方差,同时减小多个模型的固有梯度方差。

符号说明

x:干净的图片

y:x对应的真实标签

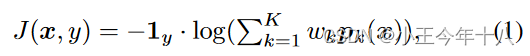

J(x,y):分类器的损失函数

:以x为中心,

为半径的

范数的球

无目标对抗性攻击的目的是搜索使损失最大化的对抗样本

本文将重点放在上。

方法

已存在的集成攻击方法:

Ensemble on predictions.

是x真实标签y的one-hot编码

为第k个模型的预测

,

是集合模型的权重

Ensemble on logits.

![]()

是第k个模型的logits

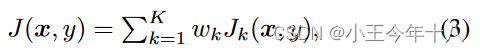

Ensemble on losses.

是第k个模型的损失。

上面三个模型中,=

。

从直观上看,现有的集成攻击方法有助于提高对抗可转移性,因为攻击集成模型可以帮助找到更好的局部极大值,并且更容易推广到其他黑盒模型。但是,仅仅对模型的输出(logits、预测或损失)进行平均来建立对抗攻击的集成模型可能会限制攻击性能,因为不同模型的单个优化路径可能会有差异,但没有考虑方差,导致对集成模型的过拟合。

Stochastic Variance Reduced Ensemble Attack

在本文中,将迭代集成攻击视为一个随机梯度下降优化过程,在每次迭代中攻击者选择一批集成模型进行更新,在对抗样本生成过程中,不同模型上的梯度方差可能会导致局部最优性较差,因此,我们的目标是减小梯度方差,以稳定梯度更新方向,使诱导的梯度更好地推广到其他可能的模型。

Ens:传统的模型集合攻击方法。

本文提出的方法与传统模型的主要区别在于SVRE有一个内部更新循环,SVRE通过M次更新获得方差降低的随机梯度

具体:

首先通过对模型的一次遍历得到多个模型的梯度,并且在M次内部迭代中保持这个值。

然后,从模型集合中随机选取一个模型,在方差缩减后得到随机内部梯度,并利用

的累计梯度更新内部对抗样本。

最后,使用一个内部循环的累积梯度更新外部梯度,由于是

的无偏估计,

有助于减少不同模型上的梯度。

SVRG与SVRE

为了解决这个问题,我们提出了一种新的方法,称为随机方差减少集合攻击(SVRE),以增强集合攻击的对抗可转移性。

我们的方法受随机方差减少梯度(SVRG)方法[12]的启发,该方法设计用于随机优化,它有一个外环,在一批数据上保持平均梯度,一个内环,从批中随机抽取一个实例,并根据方差减少计算梯度的无偏估计。

在我们的方法中,我们将集成模型作为外循环的批数据,在内循环的每次迭代中随机绘制一个模型。

将良性图像作为初始对抗样例,外循环计算该批模型的平均梯度,将当前样例复制到内循环,内循环对内部对抗样例进行多次迭代更新。

在每一次内部迭代中,SVRE计算一个随机选择的模型上的当前梯度,由该随机选择模型和集成模型上的外部对抗示例的梯度偏差调整。

在内部循环的最后,外部对抗示例将使用最新的内部对抗示例的调整梯度进行更新

2188

2188

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?