通过前置内容我们已经链接到开发机了,现在我们打开控制台一起部署 Web Demo

环境配置

# 创建 llama3 环境

conda create -n llama3 python=3.10

# 切换至 llama3

conda activate llama3

# 安装依赖

conda install pytorch==2.1.2 torchvision==0.16.2 torchaudio==2.1.2 pytorch-cuda=12.1 -c pytorch -c nvidia

软链接 InternStudio 中的模型

新建文件夹

mkdir -p ~/model

cd ~/model

软链

ln -s /root/share/new_models/meta-llama/Meta-Llama-3-8B-Instruct ~/model/Meta-Llama-3-8B-Instruct

Web Demo 部署

克隆Llama3-Tutorial项目

cd ~

git clone https://github.com/SmartFlowAI/Llama3-Tutorial

克隆XTuner

git clone -b v0.1.18 https://github.com/InternLM/XTuner

安装XTuner 依赖。

cd XTuner

pip install -e .

运行 web_demo.py,参数大模型所在路径

streamlit run ~/Llama3-Tutorial/tools/internstudio_web_demo.py \

~/model/Meta-Llama-3-8B-Instruct

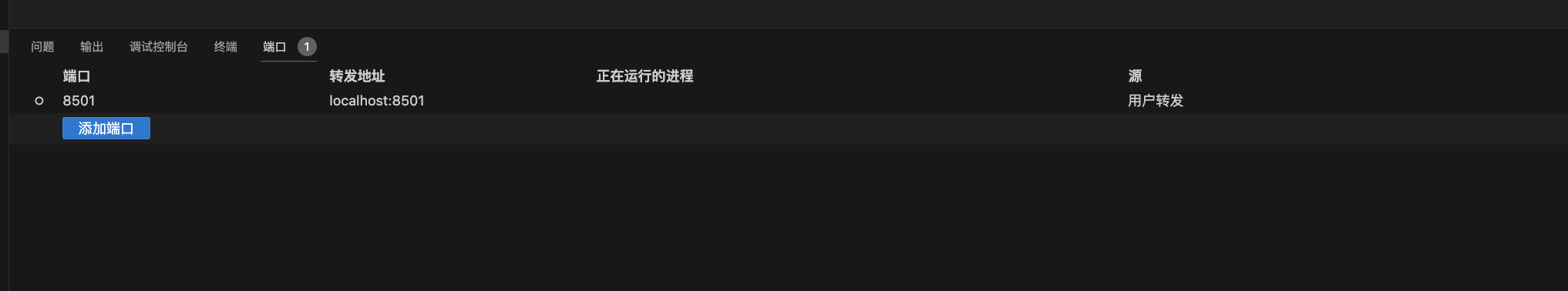

vscode 端口转发

现在,我们可以通过 浏览器打开http://localhost:8501/ 访问了

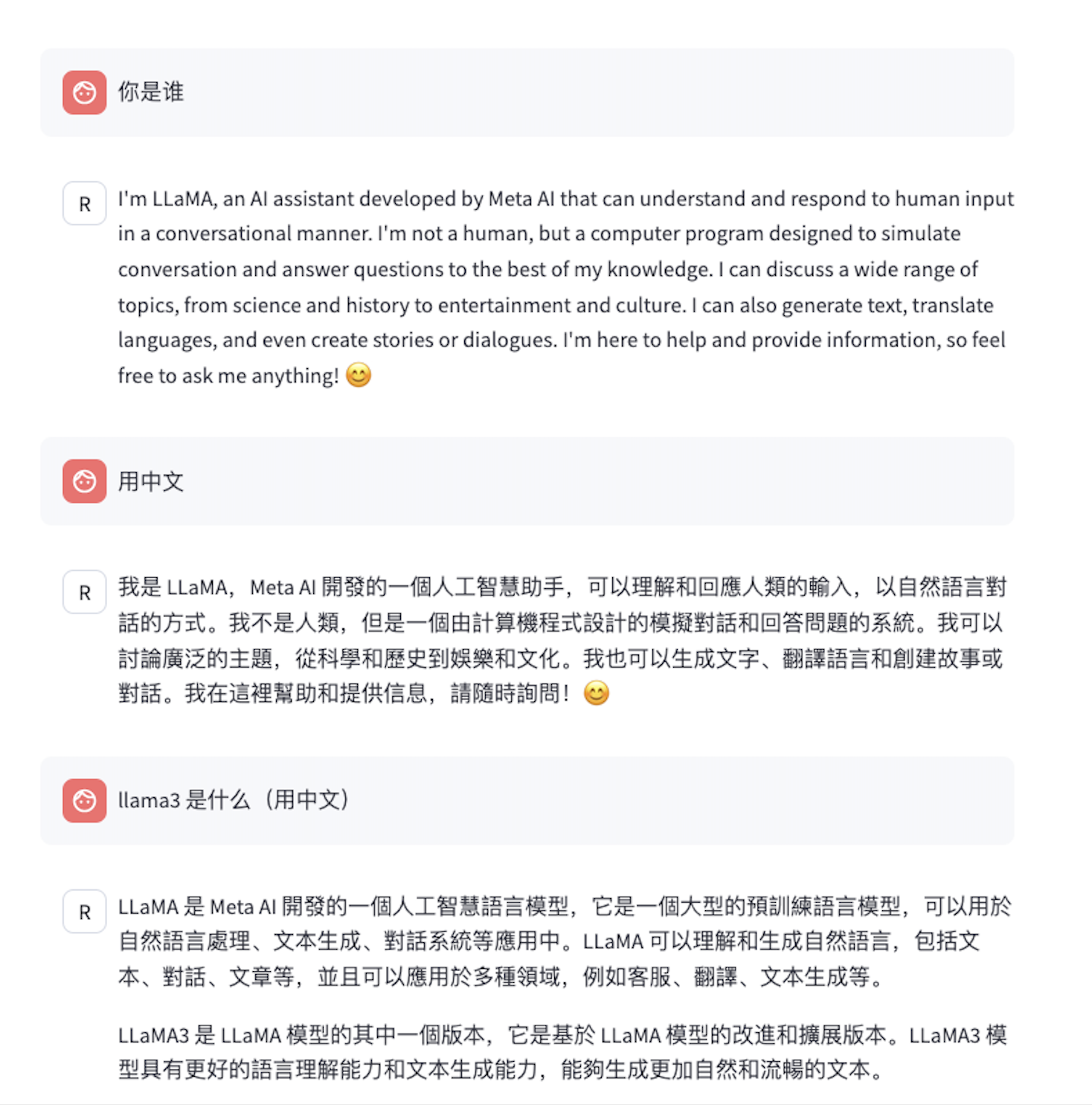

问几个问题

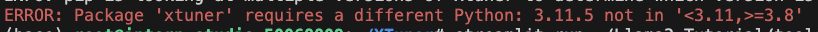

安装XTuner时,报错 py 版本不对

原因:

开发过程中,我执行了一个命令,我也忘了咋就执行了这个

conda deactivate

导致我退出了 llama3 环境

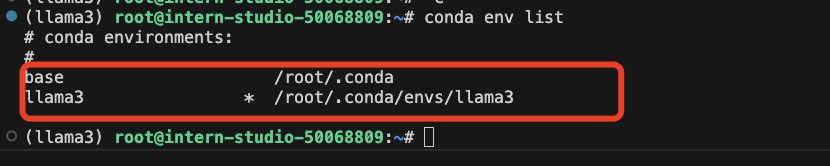

进入了 base 环境,下图第一个环境

而 base 环境 py 是 3.11.5

所以报错了

解决方案,执行以下命令,进入 llama3 环境

conda activate llama3

再安装就好了。

557

557

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?