循环神经网络的应用

一、embedding编码

- 词汇表大小:你的编码要表示多少个单词。

- 编码维度:用几个数字表示一个单词。

- embedding对输入数据的维度也有要求,要求输入数据是二维的。

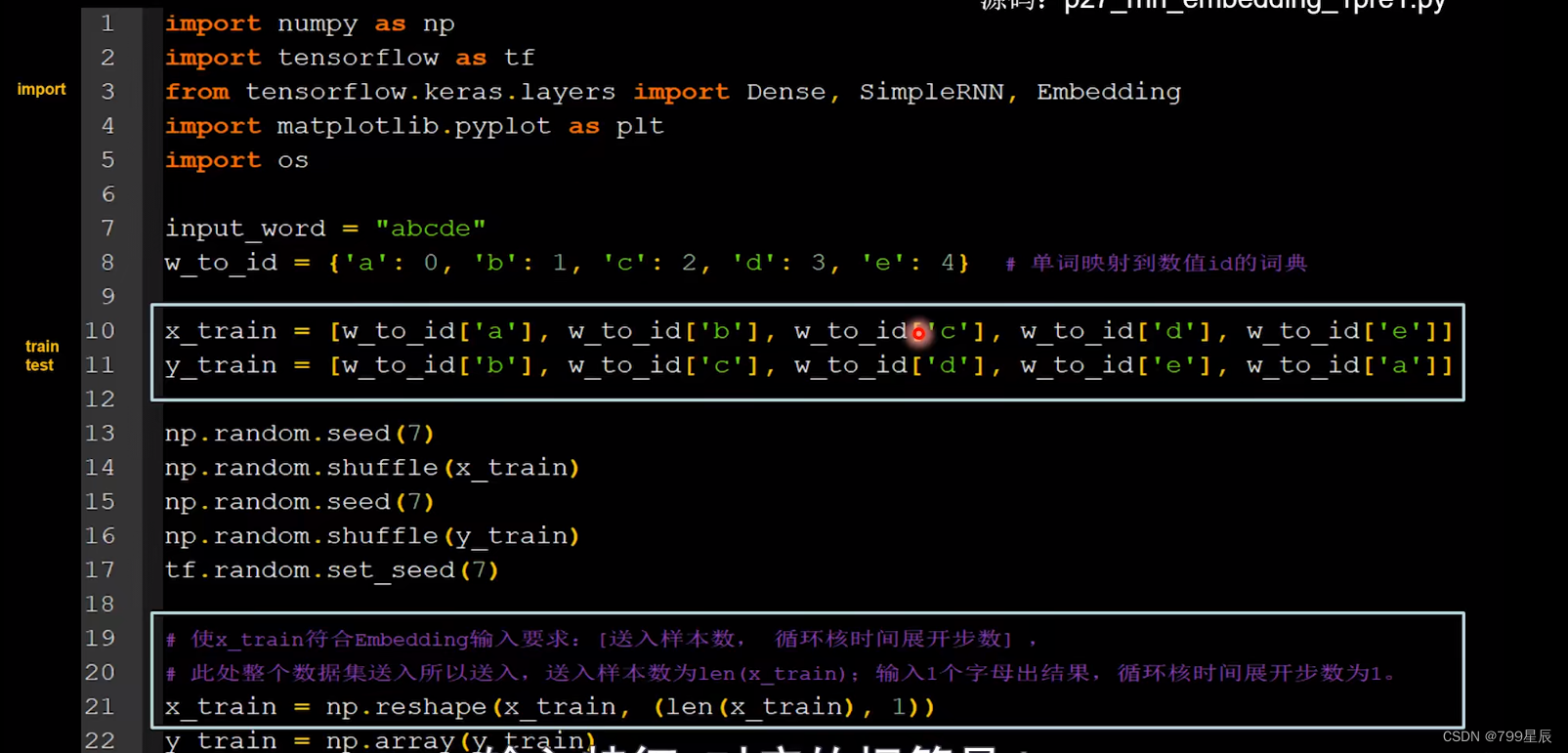

二、预测字母

1、输入一个字母,预测下一个字母(embedding编码)

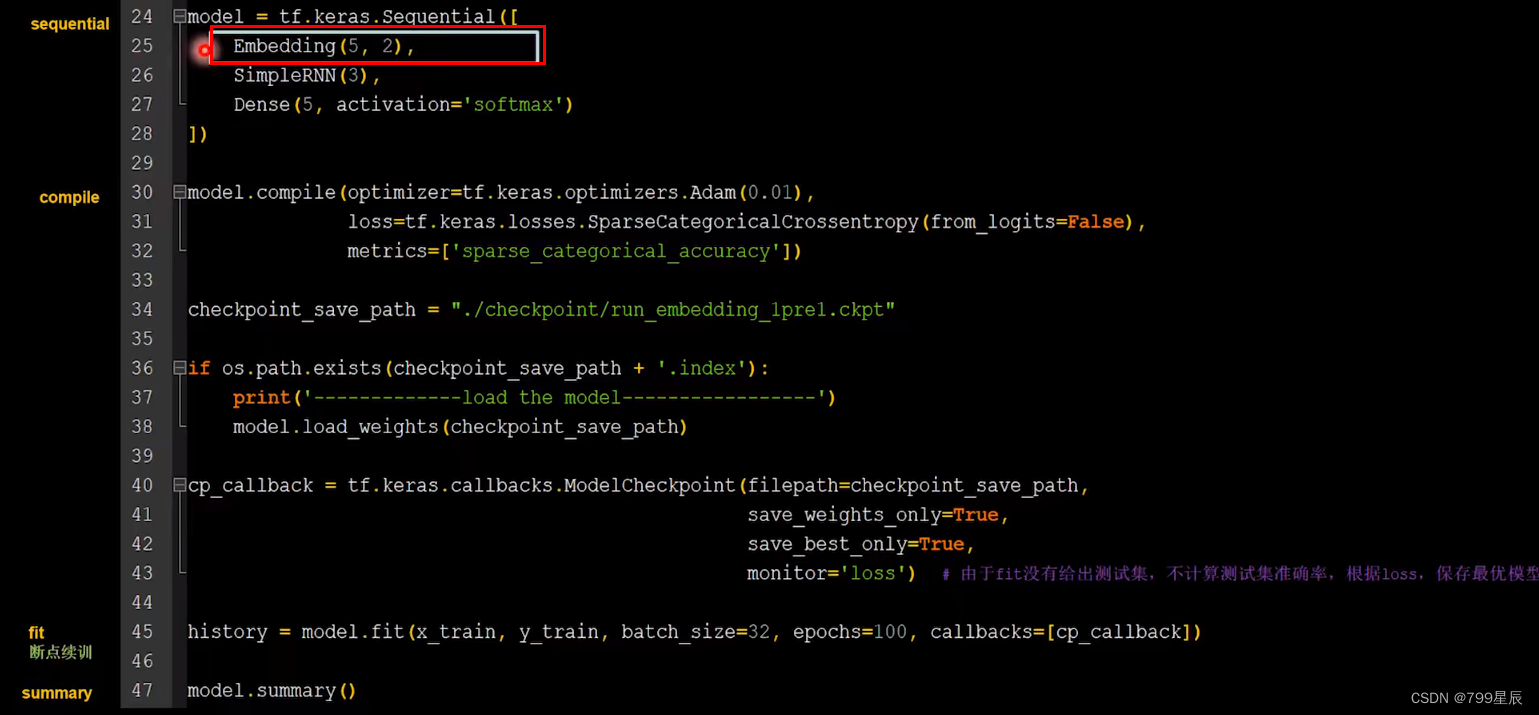

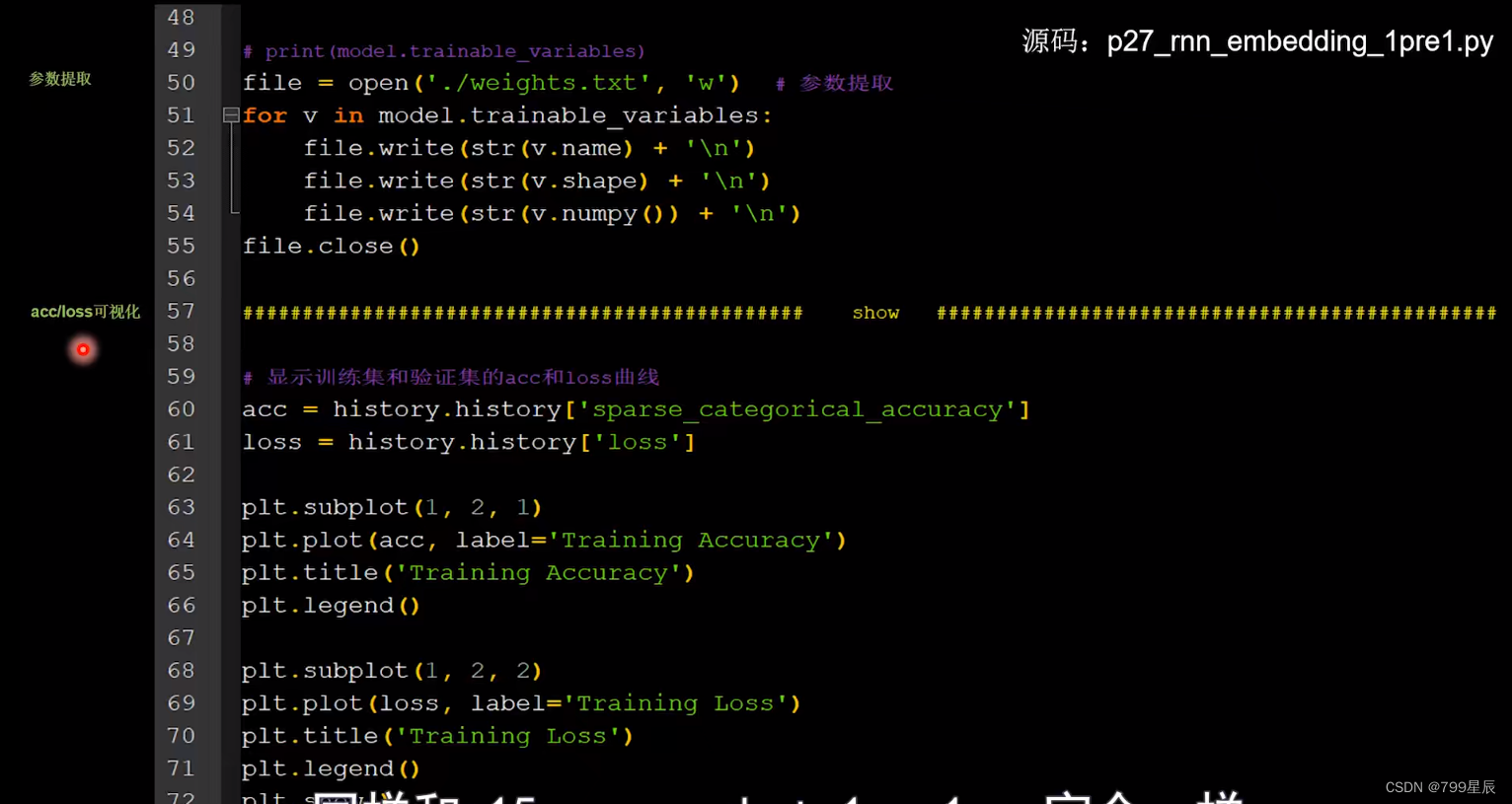

搭建网络时增加了一层embedding层,先对输入数据进行编码,生成一个5行2列的参数矩阵,实现编码可训练。

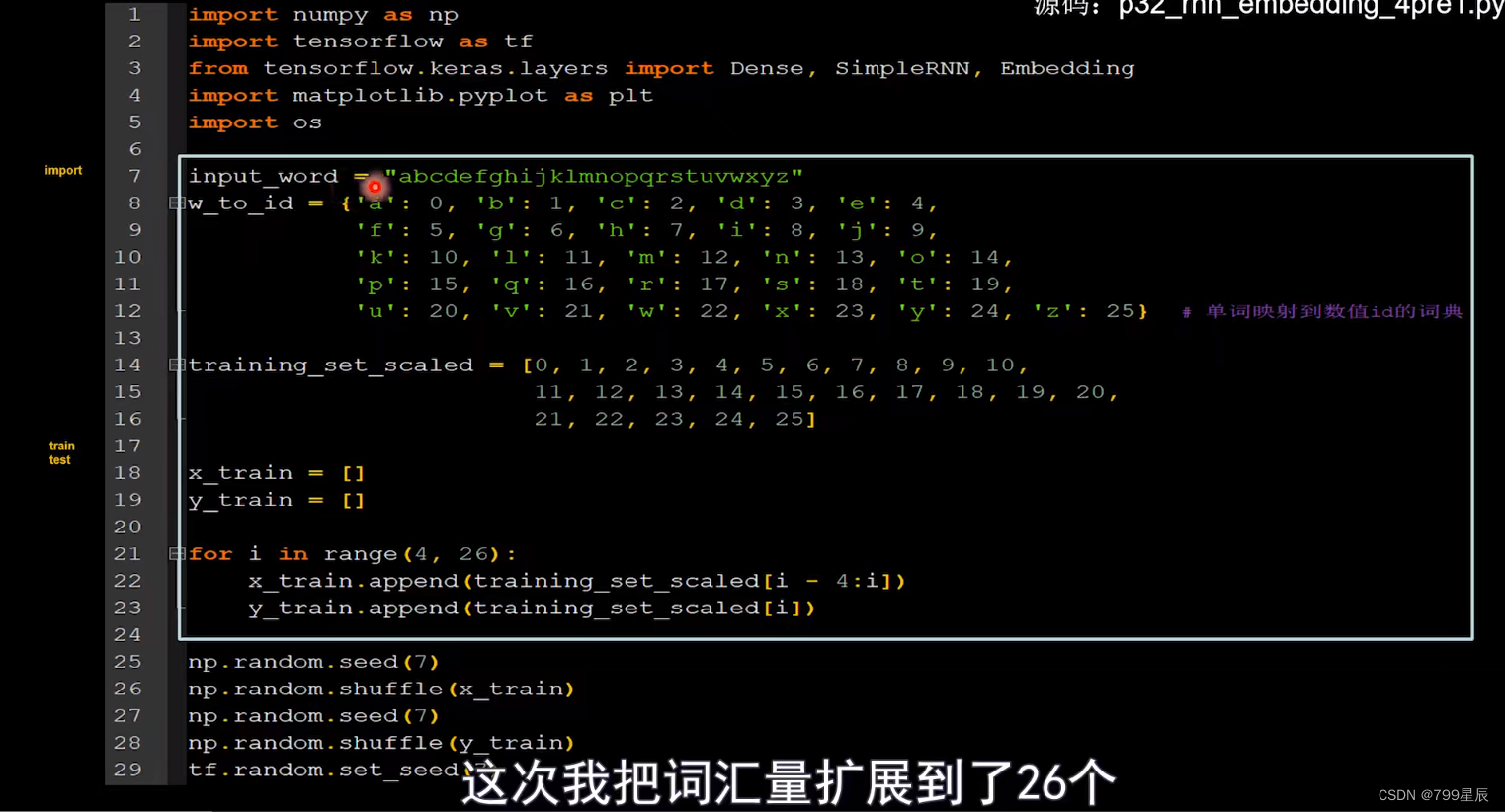

2、输入连续字母预测下一个

用for循环把连续四个数作为输入特征,添加到x_train中。第五个数作为标签添加到y_train中。

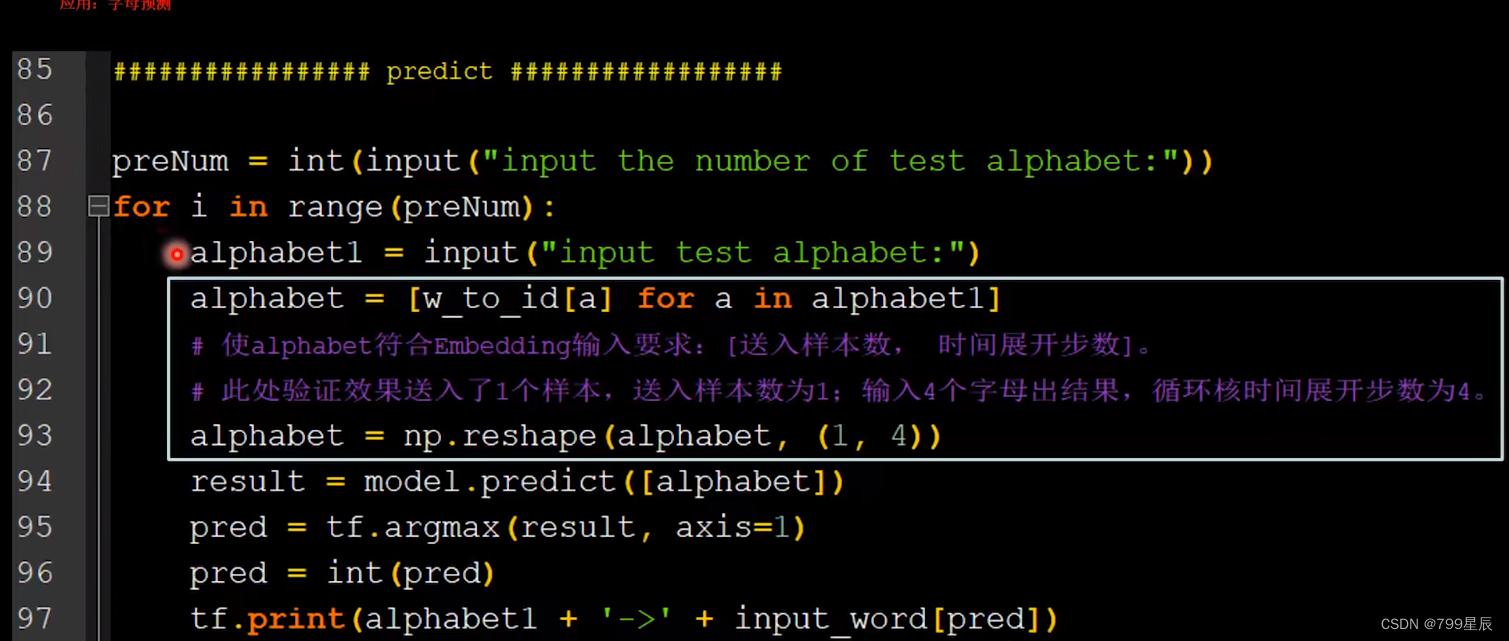

连续输入4个字母得到输出,所以时间展开步数是4.

Embedding(26,2):26表示词汇量是26,2表示每个单词用2个数值编码。

这一层会生成一个26层2列的参数训练矩阵。

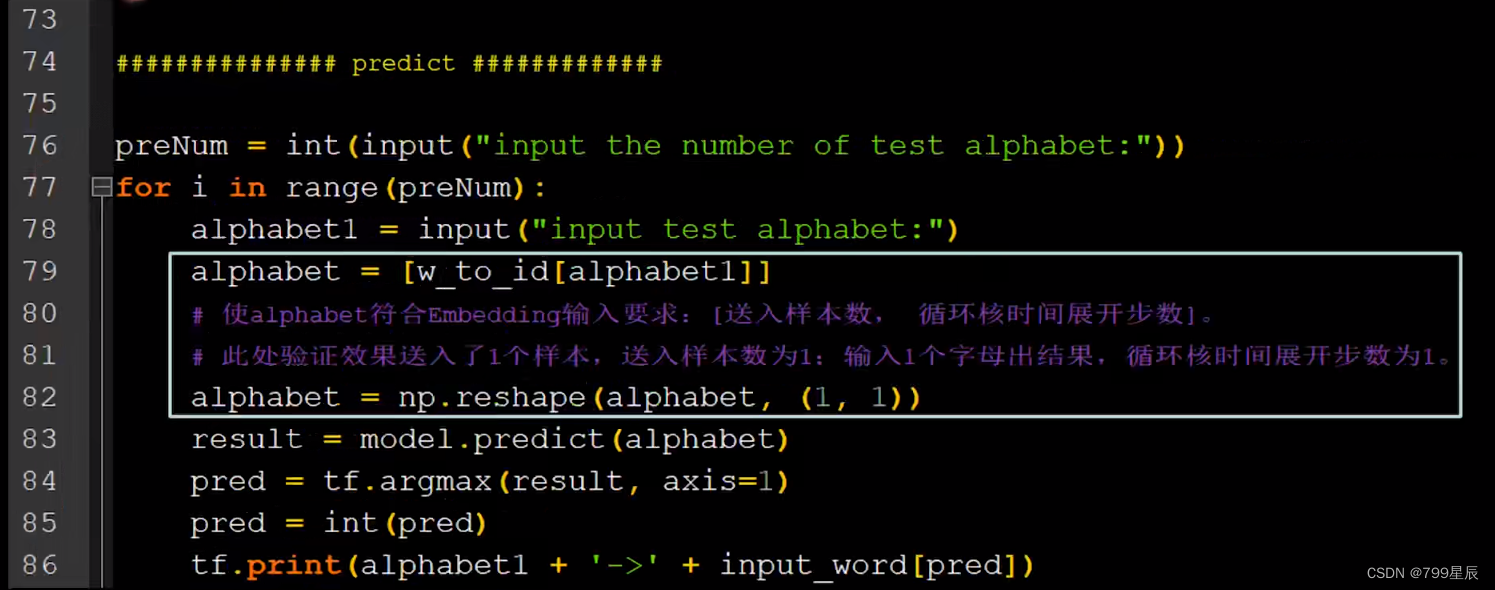

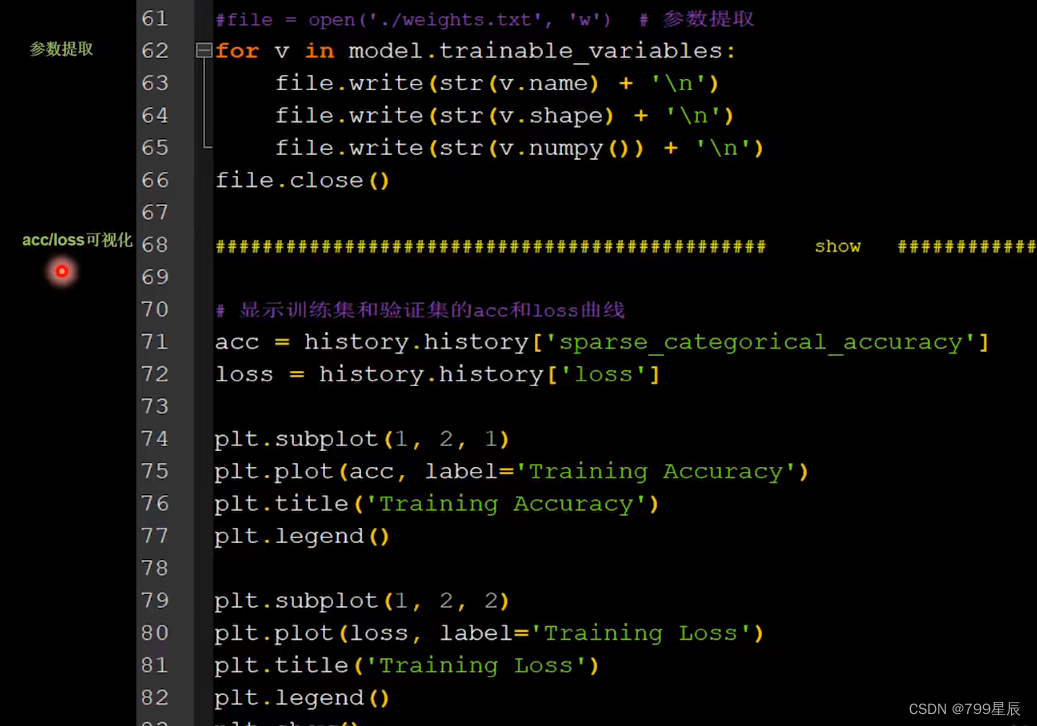

上面是对模型进行训练。接下来验证预测:

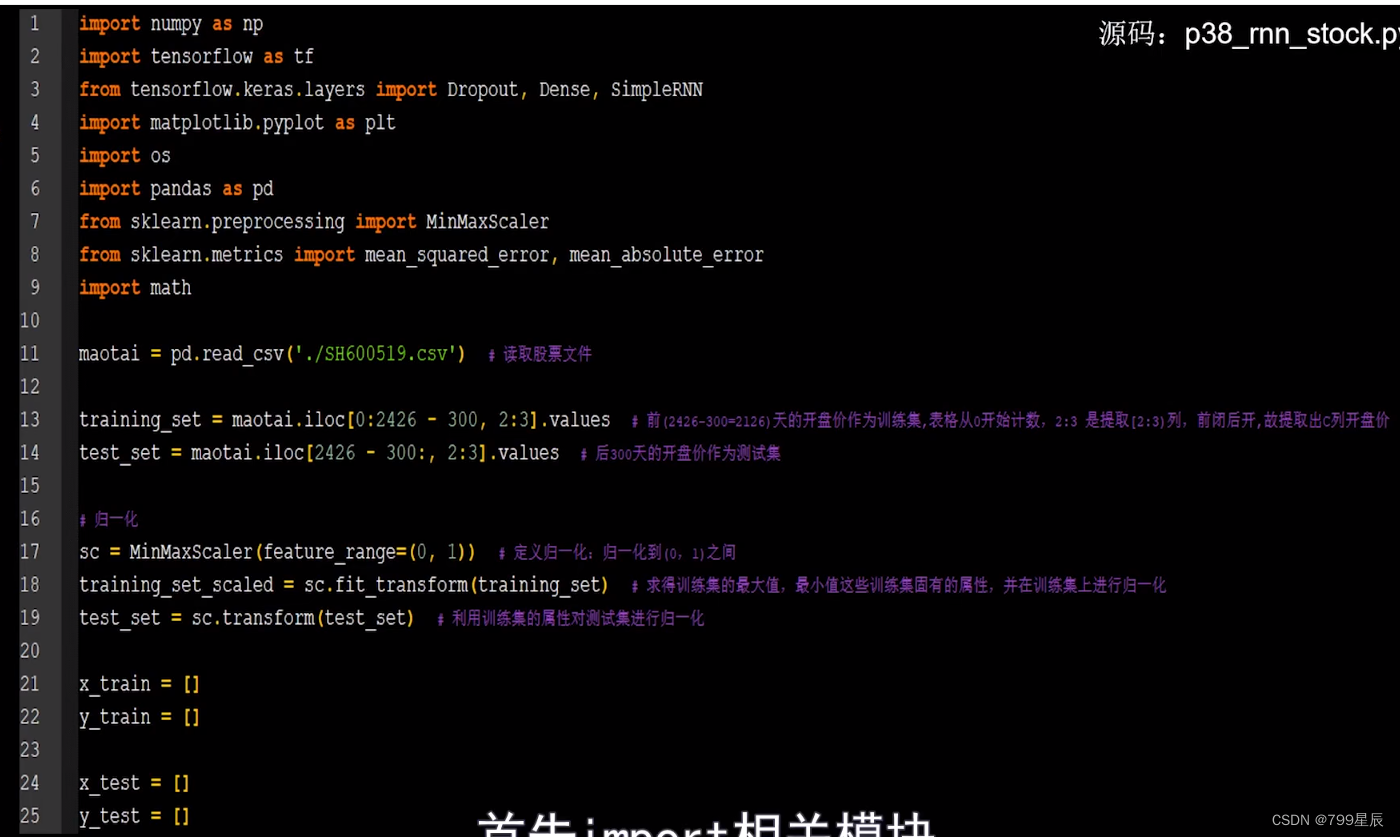

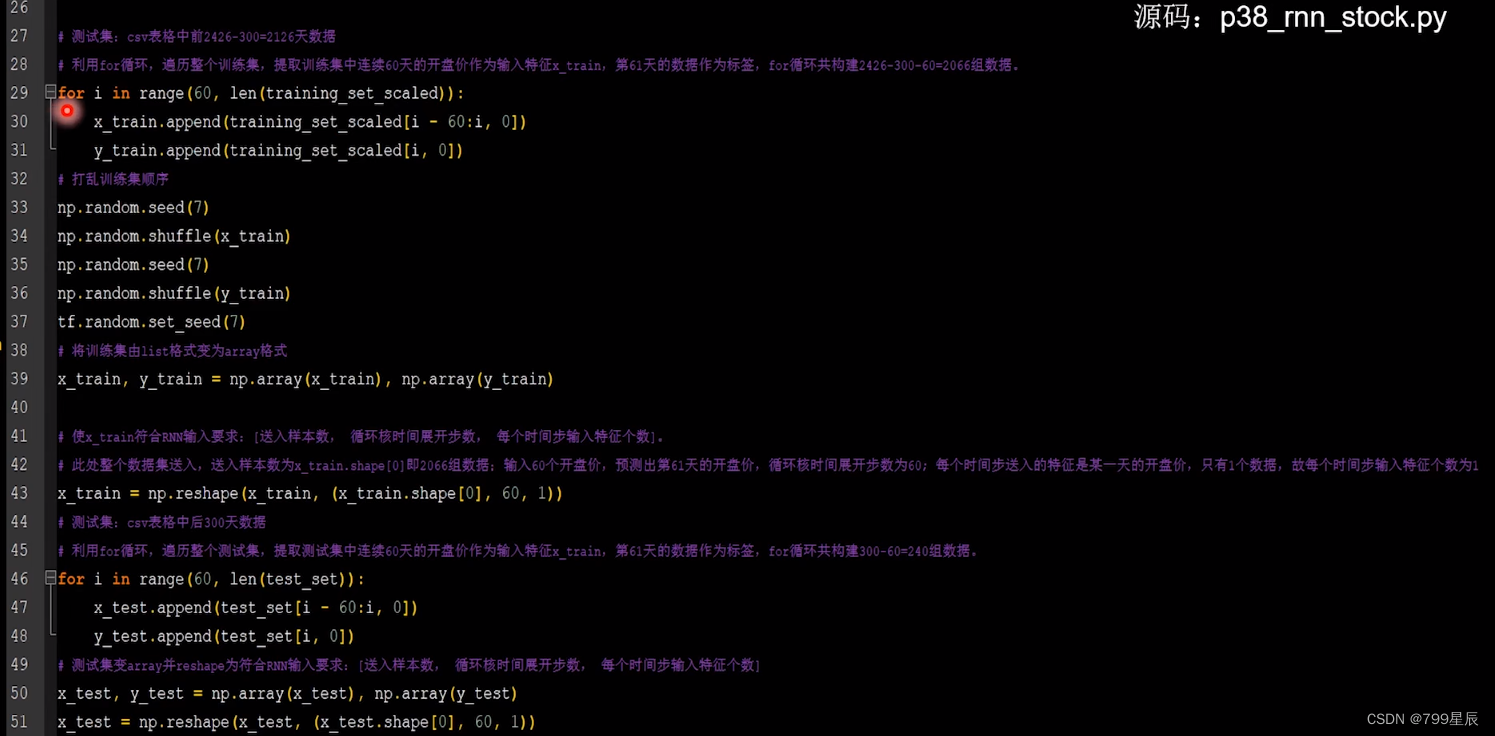

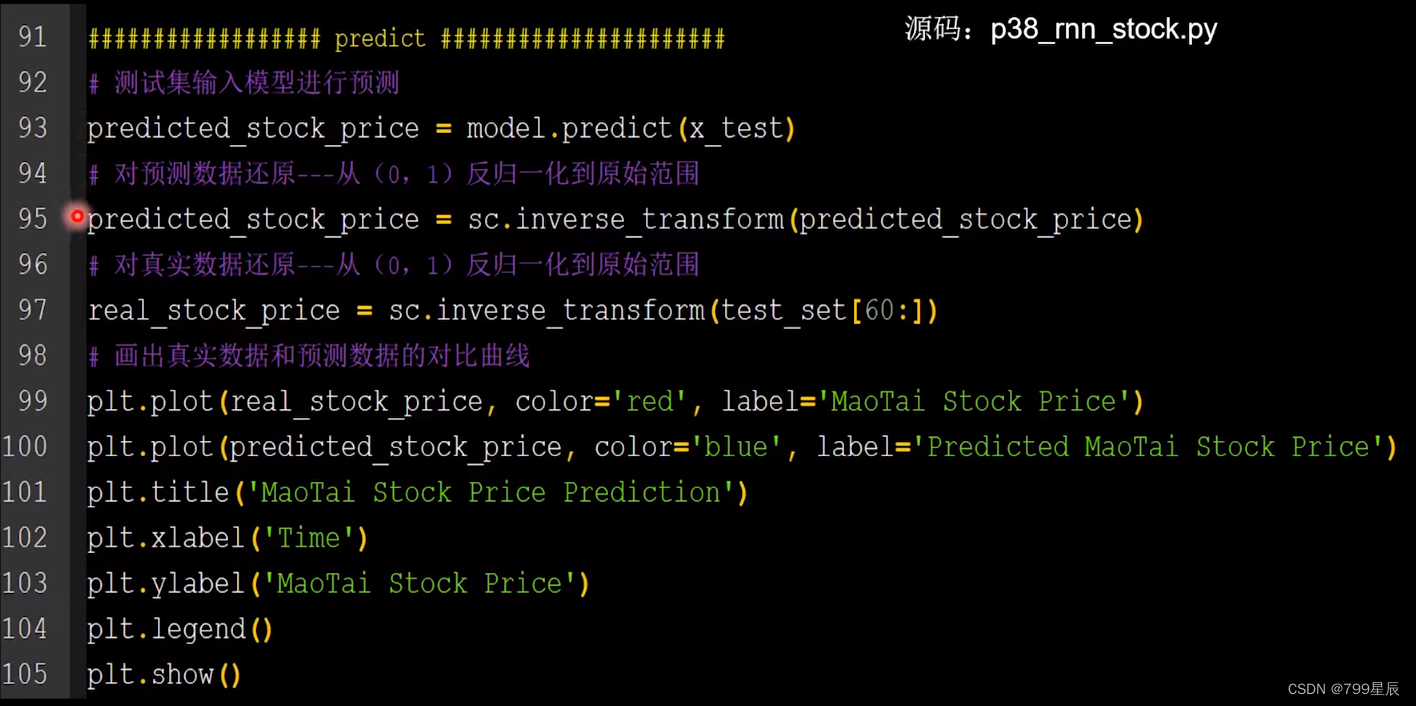

三、用RNN实现股票预测

下载所需要的股票数据

输出值是第61天的开盘价,因此dense值是1.

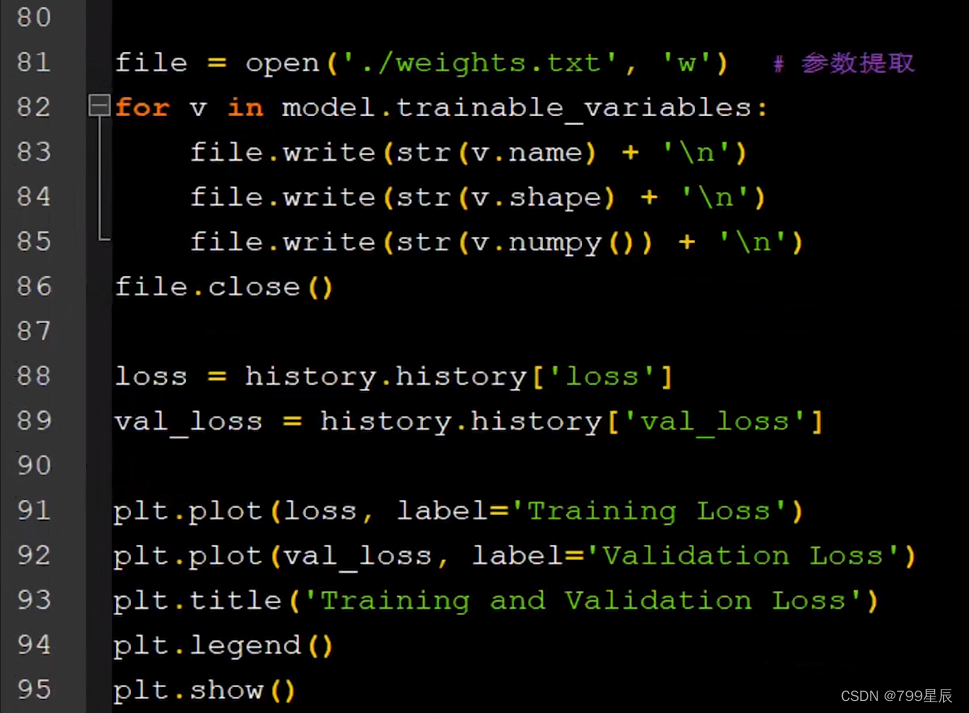

summary打印出网络结构和参数统计。

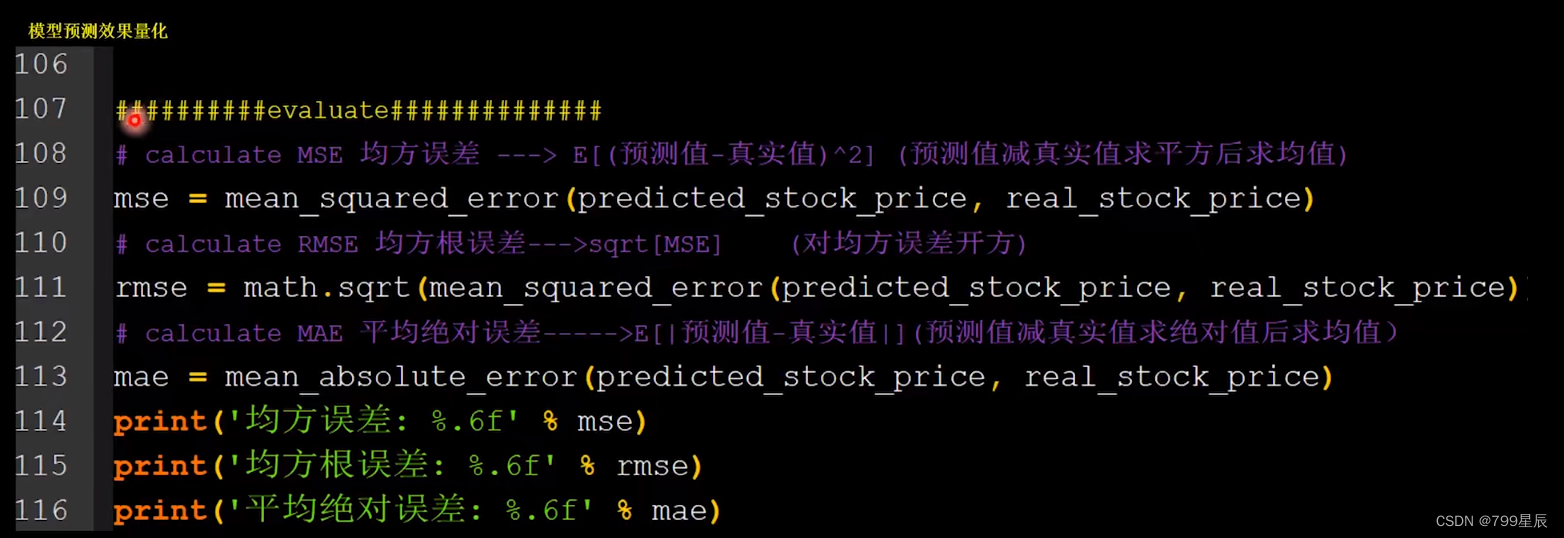

三个评价指标:

误差越小,预测与真实值越接近。

四、长短记忆网络LSTM

传统循环网络RNN,可以通过记忆体实现短期记忆,进行连续数据的预测。但是当连续数据的序列变长时,会使展开时间步过长,在反向传播更新参数时,梯度要按时间步连续相乘,会导致梯度消失。

所以提出了LSTM。

1、详细介绍LSTM

-

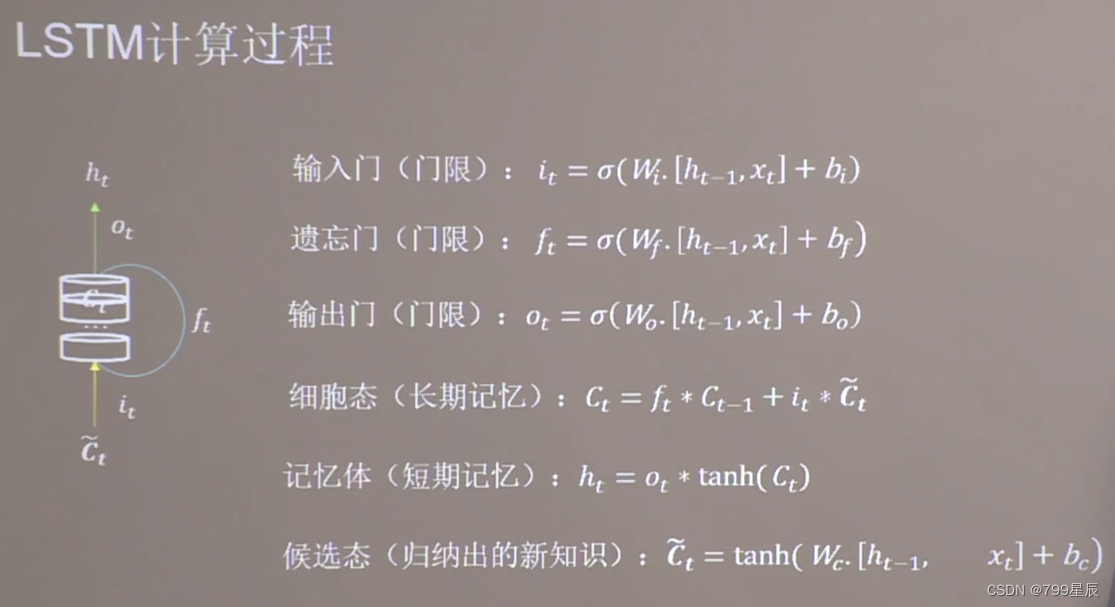

三个门限:它们都是当前时刻的输入特征 xt 和上一时刻的短期记忆的 ht-1 的函数。

wi,wo ,wf 是待训练参数矩阵,bi,bo,bf 是待训练参数矩阵。它们都经过sigmoid激活函数使门限的范围在0-1之间。 -

细胞态表示长期记忆,等于上个时刻的长期记忆 Ct-1 乘以遗忘门 + 当前时刻归纳出的新知识*输入门。(通俗讲:过去记忆留存下的知识+新知识)

-

记忆体表示短期记忆,属于长期记忆的一部分。(当给别人讲述时,不可能一字不落的将下来,讲的是留存在脑中的长期记忆,经过输出门筛选后的内容,这就是记忆体的输出)

-

候选态表示归纳出的待存入细胞态的新知识。(上一时刻的短期记忆ht-1+当前时刻的输入xt=即将存入脑中的现在的记忆)

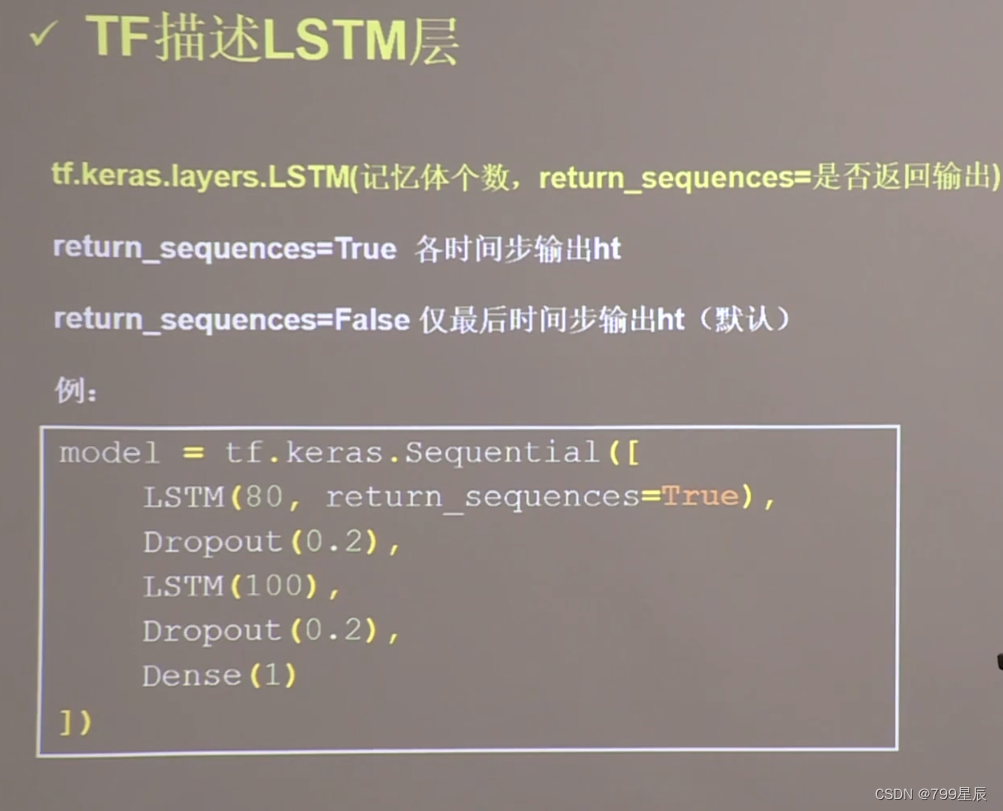

2、TF实现LSTM

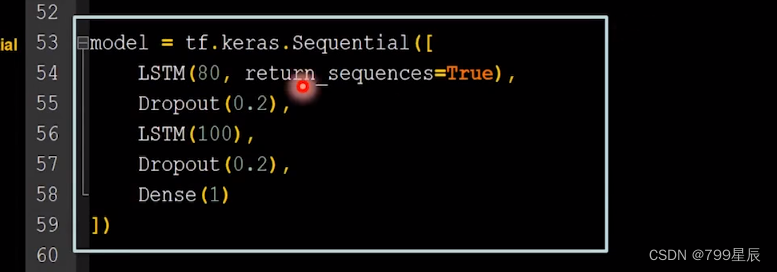

3、LSTM实现股票预测代码

把RNN层用LSTM层替代。共两处改动

1、导入

2、替换

五、GRU网络

简化的LSTM。

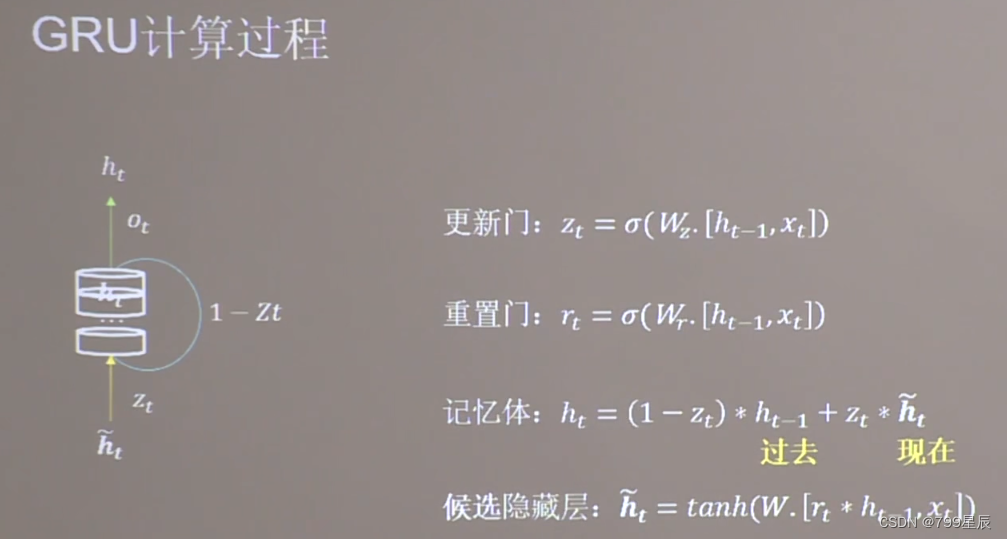

1、GRU计算过程

- GRU使记忆体ht融合了长期记忆和短期记忆。

- 两个门限的取值范围也是0-1.

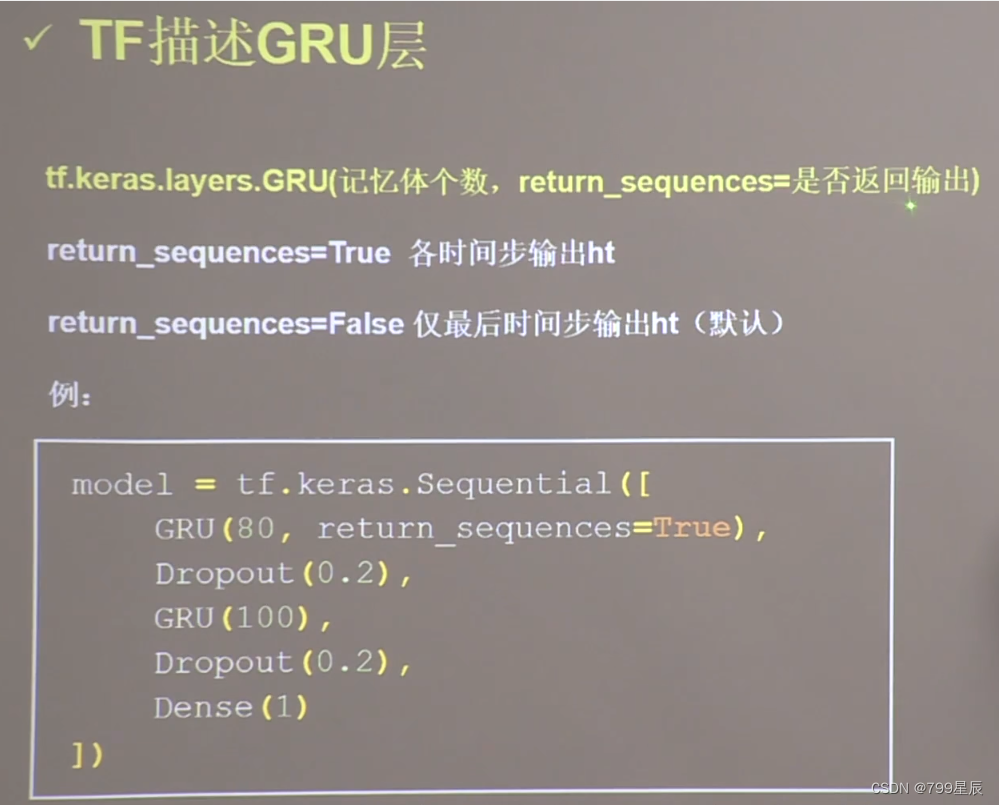

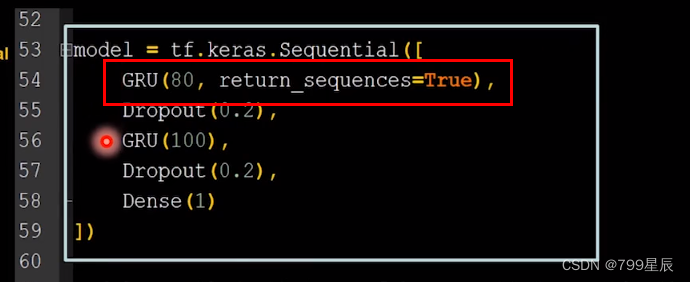

2、tf描述GRU层

代码两处改动:

359

359

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?