今天学了张量,一开始还不知道这个词的具体含义,还挺唬人的,说白了就是一种基本数据结构而已。学习文档中介绍了张量的概念,创建张量,张量转化,张量属性以及张量的稀疏矩阵存储。

创建张量

张量的创建方式有多种,构造张量时,支持传入Tensor、float、int、bool、tuple、list和numpy.ndarray类型。

根据数据直接生成

可以根据数据创建张量,数据类型可以设置或者通过框架自动推断。

data = [1, 0, 1, 0]

x_data = Tensor(data)

print(x_data, x_data.shape, x_data.dtype)

从NumPy数组生成

np_array = np.array(data)

x_np = Tensor(np_array)

print(x_np, x_np.shape, x_np.dtype)

使用init初始化器构造张量

当使用init初始化器对张量进行初始化时,支持传入的参数有init、shape、dtype。

init: 支持传入initializer的子类。如:下方示例中的 One() 和 Normal()。

shape: 支持传入 list、tuple、 int。

dtype: 支持传入mindspore.dtype。

from mindspore.common.initializer import One, Normal

# Initialize a tensor with ones

tensor1 = mindspore.Tensor(shape=(2, 2), dtype=mindspore.float32, init=One())

# Initialize a tensor from normal distribution

tensor2 = mindspore.Tensor(shape=(2, 2), dtype=mindspore.float32, init=Normal())

print("tensor1:\n", tensor1)

print("tensor2:\n", tensor2)

init主要用于并行模式下的延后初始化,在正常情况下不建议使用init对参数进行初始化。

继承另一个张量的属性,形成新的张量

from mindspore import ops

# 创建一个与 x_data 形状相同的全1数组

x_ones = ops.ones_like(x_data)

print(f"Ones Tensor: \n {x_ones} \n")

# 创建一个与 x_data 形状相同的全0数组

x_zeros = ops.zeros_like(x_data)

print(f"Zeros Tensor: \n {x_zeros} \n")

张量的属性

张量的属性包括形状、数据类型、转置张量、单个元素大小、占用字节数量、维数、元素个数和每一维步长。

形状(shape):Tensor的shape,是一个tuple。

数据类型(dtype):Tensor的dtype,是MindSpore的一个数据类型。

单个元素大小(itemsize): Tensor中每一个元素占用字节数,是一个整数。

占用字节数量(nbytes): Tensor占用的总字节数,是一个整数。

维数(ndim): Tensor的秩,也就是len(tensor.shape),是一个整数。

元素个数(size): Tensor中所有元素的个数,是一个整数。

每一维步长(strides): Tensor每一维所需要的字节数,是一个tuple。

x = Tensor(np.array([[1, 2], [3, 4]]), mindspore.int32)

print("x_shape:", x.shape)

print("x_dtype:", x.dtype)

print("x_itemsize:", x.itemsize)

print("x_nbytes:", x.nbytes)

print("x_ndim:", x.ndim)

print("x_size:", x.size)

print("x_strides:", x.strides)

张量索引

Tensor索引与Numpy索引类似,索引从0开始编制,负索引表示按倒序编制,冒号:和 …用于对数据进行切片。

在索引操作中,单个冒号 : 表示选择整个维度。例如,tensor[0] 表示选择张量的第一行,tensor[:, -1] 表示选择最后一列。

在多维数组中,省略号 … 可以用来代替一个或多个冒号 :,以保持代码的简洁。它通常用于表示多维数组中的省略部分,允许你选择整个维度或多个维度。例如,tensor[…, 0] 表示选择张量的第一列。

tensor = Tensor(np.array([[0, 1], [2, 3]]).astype(np.float32))

print("First row: {}".format(tensor[0]))

print("value of bottom right corner: {}".format(tensor[1, 1]))

print("Last column: {}".format(tensor[:, -1]))

print("First column: {}".format(tensor[..., 0]))

张量运算

张量之间有很多运算,包括算术、线性代数、矩阵处理(转置、标引、切片)、采样等,张量运算和NumPy的使用方式类似,下面介绍其中几种操作。

普通算术运算有:加(+)、减(-)、乘(*)、除(/)、取模(%)、整除(//)。

x = Tensor(np.array([1, 2, 3]), mindspore.float32)

y = Tensor(np.array([4, 5, 6]), mindspore.float32)

output_add = x + y

output_sub = x - y

output_mul = x * y

output_div = y / x

output_mod = y % x

output_floordiv = y // x

print("add:", output_add)

print("sub:", output_sub)

print("mul:", output_mul)

print("div:", output_div)

print("mod:", output_mod)

print("floordiv:", output_floordiv)

输出为:

add: [5. 7. 9.]

sub: [-3. -3. -3.]

mul: [ 4. 10. 18.]

div: [4. 2.5 2. ]

mod: [0. 1. 0.]

floordiv: [4. 2. 2.]

concat将给定维度上的一系列张量连接起来。

data1 = Tensor(np.array([[0, 1], [2, 3]]).astype(np.float32))

data2 = Tensor(np.array([[4, 5], [6, 7]]).astype(np.float32))

output = ops.concat((data1, data2), axis=0)

#轴(axis)是沿着数组的长度方向。默认情况下,数组的第一个维度是轴 0,第二个维度是轴 1,依此类推。代码中0表示是行,另一个维度就是列。

print(output)

print("shape:\n", output.shape)

输出为:

[[0. 1.]

[2. 3.]

[4. 5.]

[6. 7.]]

shape:

(4, 2)

stack则是从另一个维度上将两个张量合并起来。个人理解是再加一维包裹起两个张量

data1 = Tensor(np.array([[0, 1], [2, 3]]).astype(np.float32))

data2 = Tensor(np.array([[4, 5], [6, 7]]).astype(np.float32))

output = ops.stack([data1, data2])

print(output)

print("shape:\n", output.shape)

输出为:

[[[0. 1.]

[2. 3.]]

[[4. 5.]

[6. 7.]]]

shape:

(2, 2, 2)

Tensor与NumPy转换

#Tensor转换为NumPy

t = Tensor([1., 1., 1., 1., 1.])

print(f"t: {t}", type(t))

n = t.asnumpy()

print(f"n: {n}", type(n))

#输出为:

t: [1. 1. 1. 1. 1.] <class 'mindspore.common.tensor.Tensor'>

n: [1. 1. 1. 1. 1.] <class 'numpy.ndarray'>

#NumPy转换为Tensor

n = np.ones(5)

t = Tensor.from_numpy(n)

np.add(n, 1, out=n)

print(f"n: {n}", type(n))

print(f"t: {t}", type(t))

#输出为:

n: [2. 2. 2. 2. 2.] <class 'numpy.ndarray'>

t: [2. 2. 2. 2. 2.] <class 'mindspore.common.tensor.Tensor'>

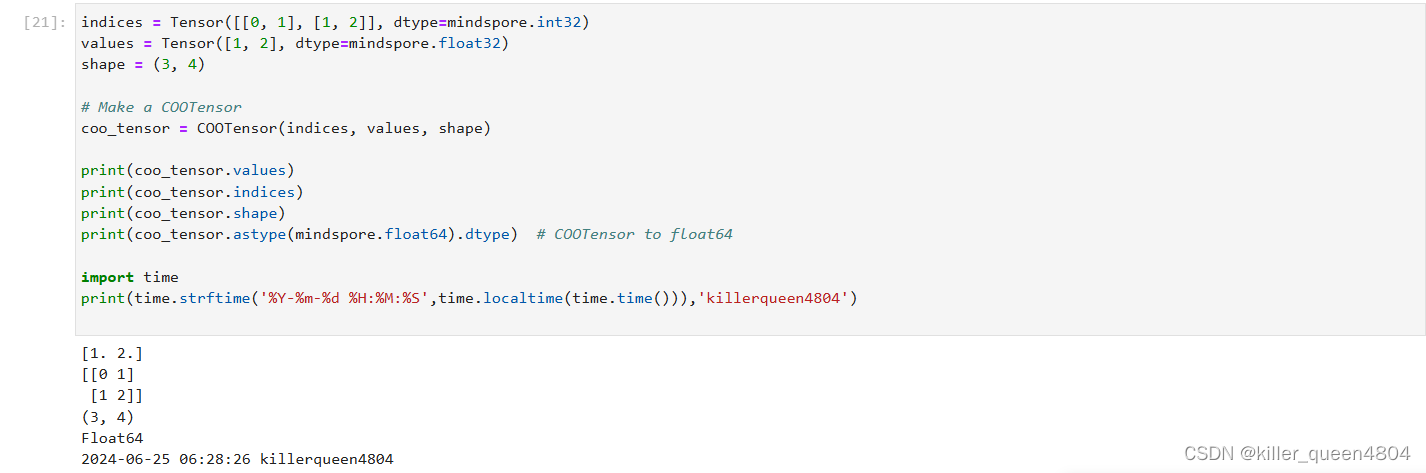

稀疏张量

稀疏张量是一种特殊张量,其中绝大部分元素的值为零。

在某些应用场景中(比如推荐系统、分子动力学、图神经网络等),数据的特征是稀疏的,若使用普通张量表征这些数据会引入大量不必要的计算、存储和通讯开销。这时就可以使用稀疏张量来表征这些数据。

MindSpore现在已经支持最常用的CSR和COO两种稀疏数据格式。

常用稀疏张量的表达形式是<indices:Tensor, values:Tensor, shape:Tensor>。其中,indices表示非零下标元素, values表示非零元素的值,shape表示的是被压缩的稀疏张量的形状。在这个结构下,我们定义了三种稀疏张量结构:CSRTensor、COOTensor和RowTensor。

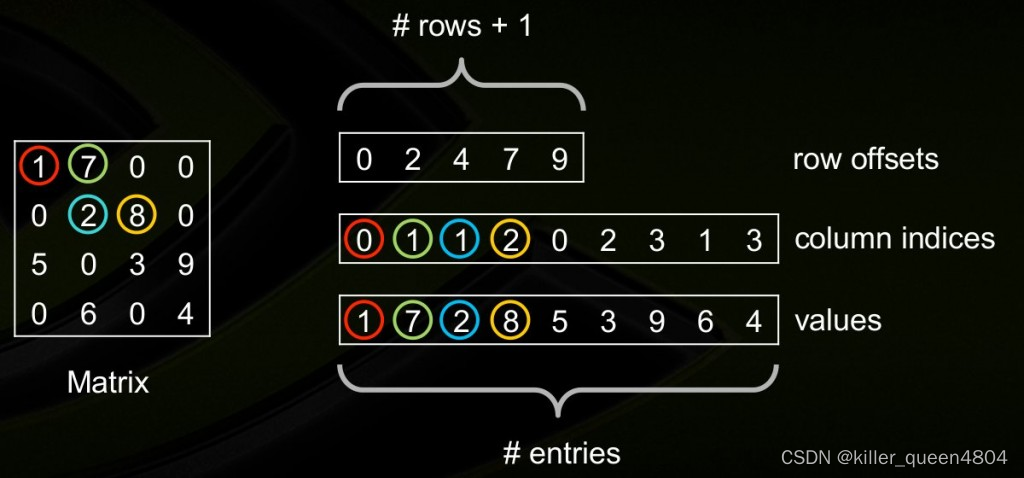

关于稀疏张量存储方式的详细解释

CSR矩阵格式通过用三个一维的数组来存储一个m×n的矩阵M。定义NNZ(Num-non-zero)为矩阵M中非0元素的个数.

第一个数组为values数组。其中,values数组的长度为NNZ,分别从从左到右从上到下的非零元素的值。

第二个数组为column数组。其中,column数组的长度为NNZ,其对应于values数组中的元素的column_index(例如元素8排列在所在行的第3个位置,因此其column index为2)。

第三个数组为row offsets,其中row offsets的数组大小为m+1,其前m个元素分别代表这每一行中第一个非零元素在Values数组的下标。(例如元素2是第二行的第二个元素,其在values数组中的下标为2.)

在上面我们惊奇的发现,使用CSR存储方式后,所使用的内存反而增加了。事实上,要满足NNZ<(m(n−1)−1)/2的时候,才会节省内存空间。

CSR(Compressed Sparse Row)的名字由来因为,CSR与COO相比,压缩了行(rowIndex)的信息。CSC和CSR类似,只不过和CSR行列互换。values数组里是按列存的数值,row offsets变成了col offsets,column数组变成了row数组。

1039

1039

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?