近年来,AI 领域不断取得突破,特别是多模态模型的出现,为计算机无人操控带来了全新的可能性。 想象一下,你的电脑不再需要你手动操作,而是可以像人一样,理解你的指令,并自动执行一系列鼠标键盘操作,完成你的任务。这听起来像是科幻电影里的场景,但现在,它已经成为现实!

Self-Operating Computer 正是这样一个框架,它将强大的 AI 多模态模型应用于计算机操控,赋予电脑“无人驾驶”的能力。 这个项目由 HyperwriteAI 开发,并已开源到 GitHub 平台,供所有人使用。

框架的核心思想是将 AI 模型与计算机交互过程进行连接,使模型能够像人类一样 “看” 屏幕,“理解” 指令,并通过鼠标键盘操作完成任务。 换句话说,它将 AI 的“智能”与计算机的“执行力”完美融合,打造出一种全新的交互模式。

框架特点

-

• 多模型兼容性: 该框架可以与多种多模态模型集成,包括 GPT-4.0、Gemini Pro Vision、Claude 3 和 LLaVA。

-

• 集成易用性: 用户可以通过简单的命令行操作,轻松启动框架并选择所需的 AI 模型。

-

• 持续发展: HyperwriteAI 正在不断完善该框架,并计划支持更多 AI 模型,以提升其功能和性能。

-

模型与功能

该框架目前集成了多种 AI 模型,并支持不同的操作模式,为用户提供了丰富的选择。

1. GPT-4.0 with OCR: 该模式结合了 GPT-4.0 的强大语言能力和 OCR(光学字符识别)技术,使模型能够识别屏幕上的文字信息,并根据文本指令进行操作。

2. GPT-4.0 with SoM: SoM(Set-of-Mark Prompting)是一种新兴的视觉提示方法,可以增强多模态模型的视觉理解能力。该模式利用 SoM 技术,提升了模型对屏幕元素的识别和定位精度。

3. Gemini Pro Vision: 来自 Google 的 Gemini Pro Vision 模型,具备强大的视觉理解能力,可以识别图像并生成文本描述,为计算机操控提供了新的可能性。

4. Claude 3: 由 Anthropic 开发的 Claude 3 模型,在文本理解和生成方面表现出色,也能够与视觉信息结合,实现更精准的计算机操控。

5. LLaVA: LLaVA 是一种基于视觉和语言的 AI 模型,能够理解图像和文字,并进行多模态任务。该框架支持使用 Ollama 在本地运行 LLaVA 模型,方便用户进行实验和研究。

6. Voice Mode: 该模式支持语音输入指令,用户可以用声音来操控电脑,更加便捷直观。

使用步骤

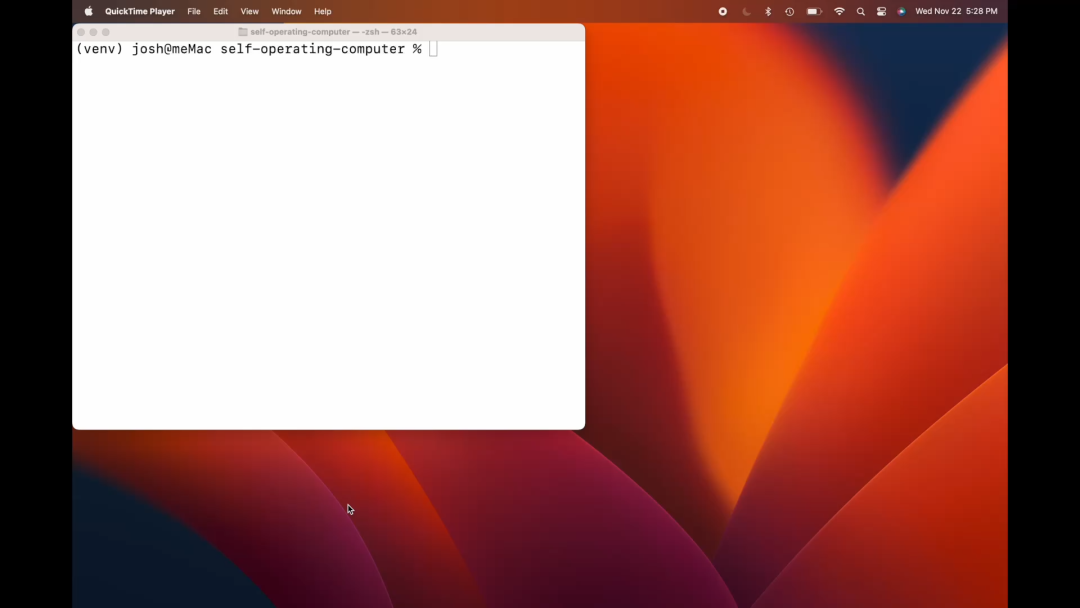

使用 Self-Operating Computer Framework 非常简单,用户只需按照以下步骤操作即可:

-

1. 安装项目: 使用 pip 命令安装框架。

-

2. 运行项目: 执行 operate 命令,按需要输入指令参数。

-

3. 选择模型: 根据需要选择不同的 AI 模型,例如 GPT-4.0、Gemini Pro Vision 等等。

-

4. 输入指令: 通过文本、语音或图像,输入你想要电脑执行的任务。

-

5. 观察结果: 框架将自动执行你的指令,并显示操作结果。

未来展望

无人"驾驶"电脑拥有巨大的潜力,它不仅可以改变我们与电脑的交互方式,更可以为各种应用场景带来革命性的变化。 例如,它可以用于:

-

• 自动化办公: 自动填写表格、发送邮件、整理文档等等。

-

• 游戏操控: 自动执行游戏操作,例如打怪升级、完成任务等等。

-

• 网站测试: 自动测试网站功能,寻找 bug 等等。

-

• 辅助工具: 帮助残疾人操控电脑,提高生活质量等等。

未来,随着 AI 技术的不断发展,其应用范围也会更加广泛。

项目地址:https://github.com/OthersideAI/self-operating-computer

680

680

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?