1. MATLAB准备

首先你需要下载好MATLAB,我使用的是MATLAB R2022b,下载教程参考:

【软件安装】(十)MATLAB R2022b完整安装教程(附安装包)

感谢作者码韵

2. 下载Homer3

下载地址

Homer3下载地址

下载好后解压,setpath将Homer3文件加入MATLAB路径中。

具体参考:

Homer3的安装

感谢作者洛神

3. 修改MATLAB的当前路径

刚安装好的MATLAB路径是默认在C盘如,如图所示:

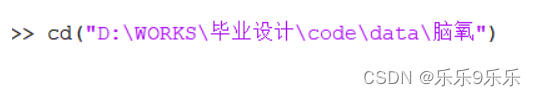

“DELL”是我的计算机用户名称,此时需要修改当前路径为放置.nirs文件的地方,具体来说就是:在命令行窗口中输入

下面展示一些 内联代码片。

cd("你的文件路径")

如:

这样MATLAB的当前文件夹就会出现你存放的.nirs文件:

4. 激活Homer3

在命令行窗口输入:

下面展示一些 内联代码片。

Homer3

【补充说明】

如果你同时装了Homer2和Homer3,在使用Homer3时,必须在setpath中将所有Homer3相关的文件移到顶端,否则命令行中会报错。

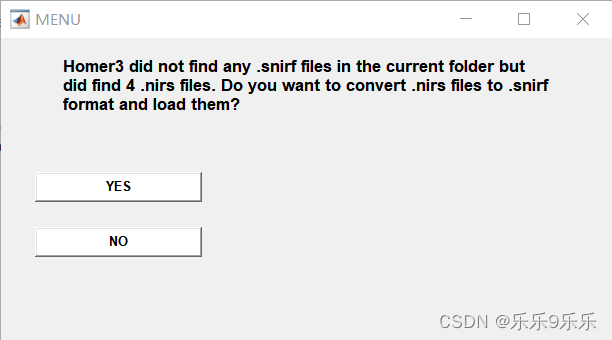

命令行窗口会出现:

同时回弹出窗口:

选择YES

你就会获得.snirf文件

完结!!!!撒花✿✿ヽ(°▽°)ノ✿

693

693

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?