softmax

读取数据集

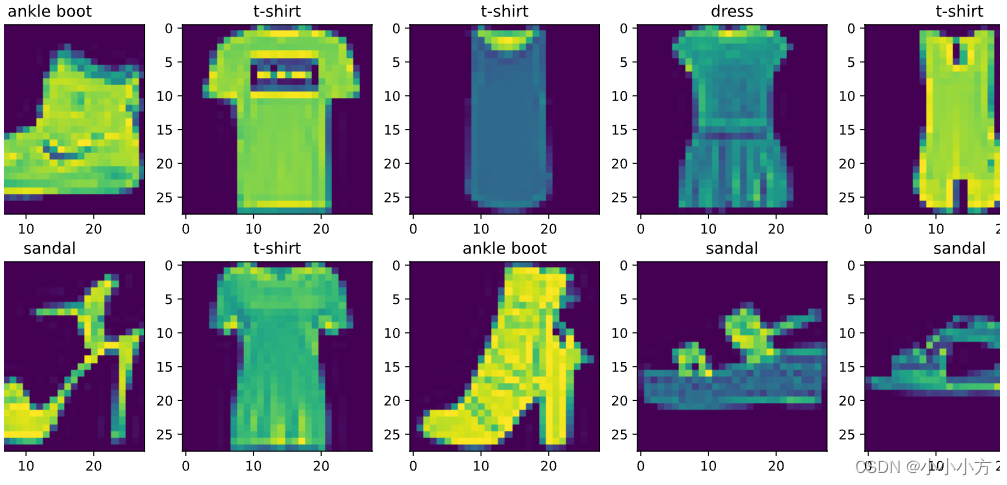

使用Fashion-MNIST数据集来验证模型之间的区别

# 使用Fashion-MNIST数据集

%matplotlib inline

import torch

# pytorch对于计算机视觉实现的库

import torchvision

from torch.utils import data

# 对于数据进行处理的模块

from torchvision import transforms

# 一些已经实现好的模块存放在d2l中

from d2l import torch as d2l

# 使用svg显示图片 这样清晰度更高

d2l.use_svg_display()

# 使用框架中的内置函数将数据集下载并读取到内存中

# 通过ToTensor实例将图像数据从PIL类型变换为32位浮点数格式

# 并除以255使得所有像素的数值均在0到1之间

# 预处理将图片转换为的tensord的形式

trans = transforms.ToTensor()

mnist_train = torchvision.datasets.FashionMNIST(root="../data",train=True,transform=trans,download =True)

mnist_test = torchvision.datasets.FashionMNIST(root="../data",train=False,transform=trans,download=True)

len(mnist_train),len(mnist_test)

运行结果:

(60000, 10000)

# 第一张图片的形状 黑白色的所以rgb通道为1

mnist_train[0][0].shape

运行结果:

torch.Size([1, 28, 28])

对代码进行了修改,原代码没有办法显示titlle。

# 两个可视化数据集的函数

# 数字标签索引和文本名称之间的转换

def get_fashion_mnist_labels(labels):

"""返回数据集的文本标签"""

text_labels=['t-shirt', 'trouser', 'pullover', 'dress', 'coat',

'sandal', 'shirt', 'sneaker', 'bag', 'ankle boot']

return [text_labels[int(i)] for i in labels]

# 可视化样本的函数

def show_images(imgs,num_rows,num_cols,titles=None,scale=1.5):

figsize = (num_cols*scale,num_rows*scale)

_,axes = d2l.plt.subplots(num_rows,num_cols,figsize=figsize)

axes = axes.flatten()

for i,(ax,img) in enumerate(zip(axes,imgs)):

if titles:

ax.set_title(titles[i])

if torch.is_tensor(img):

#图片张量

ax.imshow(img.numpy())

else:

#PIL图片

ax.imshow(img)

# 几个样本的图像以及相应的标签

# next拿到第一个小批量图片数据

X,y = next(iter(data.DataLoader(mnist_train,batch_size=18)))

show_images(X.reshape(18,28,28),2,9,titles=get_fashion_mnist_labels(y),scale=3.0)

# 读取一小批量数据 数据读取要比模型训练要更快

batch_size = 256

def get_dataloader_workers():

"""使用4个进程来读取的数据"""

return 4

# shuffle是否随机,num_workers进程数

train_iter = data.DataLoader(mnist_train,batch_size,shuffle=True,num_workers=get_dataloader_workers())

# 使用timer()函数测试读取数据的时间

timer = d2l.Timer()

for X,y in train_iter:

continue

f'{timer.stop():.2f}sec'

运行结果:

'1.09sec'

# 定义函数方便之后使用

def load_data_fashion_mnist(batch_size,resize=None):

trans=[transforms.ToTensor()]

if resize:

trans.insert(0,transforms.Resize(resize))

trans = transforms.Compose(trans)

mnist_train = torchvision.datasets.FashionMNIST(root="../data",train=True,transform = trans,download=True)

mnist_test= torchvision.datasets.FashionMNIST(root="../data",train=False,transform=trans,download=True)

return(data.DataLoader(mnist_train,batch_size,shuffle=True,num_workers=get_dataloader_workers()),

data.DataLoader(mnist_test,batch_size,shuffle=True,num_workers=get_dataloader_workers()))

softmax回归的从零开始实现

#从零开始实现

import torch

from IPython import display

from d2l import torch as d2l

# 每次随机读取256张图片

batch_size = 256

train_iter,test_iter=d2l.load_data_fashion_mnist(batch_size)

#将图像展平,长度为784的向量,具有10个类别,输出为10

num_inputs =784

num_outputs=10

# 随机初始化权重 均值为0,方差为0.01 行数等于输入的个数 列数等于输出的个数 需要计算梯度 requires_grad等于true

w=torch.normal(0,0.01,size=(num_inputs,num_outputs),requires_grad=True)

# 对于每一个输出都有一个偏移

b=torch.zeros(num_outputs,requires_grad=True)

# 知识回顾,给定一个矩阵,对所有元素求和

X=torch.tensor([[1.0,2.0,3.0],[4.0,5.0,6.0]])

X.sum(0,keepdim=True),X.sum(1,keepdim=True)

运行结果:

(tensor([[5., 7., 9.]]),

tensor([[ 6.],

[15.]]))

# 实现softmax操作 对于矩阵来讲按照每一行来做softmax

def softmax(X):

X_exp = torch.exp(X)

partition = X_exp.sum(1,keepdim=True)

return X_exp/partition

# 将每个元素变成一个非负数,每行总和为1

# 均值为0,方差为1的2*5的矩阵

X= torch.normal(0,1,(2,5))

X_prob = softmax(X)

X_prob,X_prob.sum(1)

运行结果:

(tensor([[0.2224, 0.3368, 0.0387, 0.2479, 0.1543],

[0.0465, 0.7085, 0.1058, 0.0670, 0.0721]]),

tensor([1.0000, 1.0000]))

# 实现softmax回归模型

# X为256*784的矩阵

def net(X):

return softmax(torch.matmul(X.reshape((-1,w.shape[0])),w)+b)

# 知识回顾 创建数据y_hat,其中包含2个样本在3个类别的预测概率,用y作为y_hat中概率的索引

# 两个真实的标号

y = torch.tensor([0,2])

# 预测值 对真实标号的预测值

y_hat = torch.tensor([[0.1,0.2,0.3],[0.3,0.4,0.5]])

y_hat[[0,1],y]

运行结果:

tensor([0.1000, 0.5000])

# 实现交叉熵损失函数

def cross_entropy(y_hat,y):

return -torch.log(y_hat[range(len(y_hat)),y])

cross_entropy(y_hat,y)

运行结果:

tensor([2.3026, 0.6931])

# 分类问题 预测的类别和真实的类别是否是一样的

# 将预测类别和真实y元素进行比较

def accuracy(y_hat,y):

"""计算预测正确的数量"""

if len(y_hat.shape)>1 and y_hat.shape[1]>1:

# 每一行的最大值的下标 预测的类别

y_hat = y_hat.argmax(axis=1)

# 转换数据类型继续进行比较

cmp = y_hat.type(y.dtype) == y

return float(cmp.type(y.dtype).sum())

# 预测正确的样本数/y的长度= 预测正确的概率

accuracy(y_hat,y)/len(y)

运行结果:

0.5

# 评估在任意模型net在数据迭代器上的精度(准确率)

def evaluate_accuracy(net,data_iter):

"""计算在指定数据集上模型的精度"""

if isinstance(net,torch.nn.Module):

net.eval() #将模型设置为评估模式 不计算梯度 只进行前向传播

metric = Accumulator(2) #正确预测数、预测总数

for X,y in data_iter:

metric.add(accuracy(net(X),y),y.numel())

# 分类正确的样本数/总样本数

return metric[0]/metric[1]

# 实现accumulator

class Accumulator:

"""在n个变量上累加"""

def __init__(self,n):

self.data = [0.0]*n

def add(self,*args):

self.data = [a+float(b) for a,b in zip(self.data,args)]

def reset(self):

self.data = [0.0]*len(self.data)

def __getitem__(self,idx):

return self.data[idx]

# 随机出来的模型以及我们测试的迭代器

evaluate_accuracy(net,test_iter)

运行结果:

0.0672

# 对整个数据迭代了一次

# softmax回归的训练

def train_epoch_ch3(net,train_iter,loss,updater):

if isinstance(net,torch.nn.Module):

# 开启训练模式

net.train()

#长度为3的迭代器 训练损失总和、训练准确度总和、样本数

metric = Accumulator(3)

for X,y in train_iter:

y_hat = net(X)

l = loss(y_hat,y)

# 使用模型 updater更新模型参数的常用函数,接受批量大小作为参数

if isinstance(updater,torch.optim.Optimizer):

updater.zero_grad()

l.backward()

updater.step()

# 将数据放入累加器中

metric.add(

float(1)*len(y),accuracy(y_hat,y),y.size().numel())

# 自行实现

else:

# 此时损失l是一个向量

l.sum().backward()

updater(X.shape[0])

metric.add(float(l.sum()),accuracy(y_hat,y),y.numel())

# loss累加/样本数 分类正确的样本/样本数

return metric[0]/metric[2],metric[1]/metric[2]

# 动画中绘制数据的类 看到数据的变化

class Animator: #@save

"""在动画中绘制数据"""

def __init__(self, xlabel=None, ylabel=None, legend=None, xlim=None,

ylim=None, xscale='linear', yscale='linear',

fmts=('-', 'm--', 'g-.', 'r:'), nrows=1, ncols=1,

figsize=(3.5, 2.5)):

# 增量地绘制多条线

if legend is None:

legend = []

d2l.use_svg_display()

self.fig, self.axes = d2l.plt.subplots(nrows, ncols, figsize=figsize)

if nrows * ncols == 1:

self.axes = [self.axes, ]

# 使用lambda函数捕获参数

self.config_axes = lambda: d2l.set_axes(

self.axes[0], xlabel, ylabel, xlim, ylim, xscale, yscale, legend)

self.X, self.Y, self.fmts = None, None, fmts

def add(self, x, y):

# 向图表中添加多个数据点

if not hasattr(y, "__len__"):

y = [y]

n = len(y)

if not hasattr(x, "__len__"):

x = [x] * n

if not self.X:

self.X = [[] for _ in range(n)]

if not self.Y:

self.Y = [[] for _ in range(n)]

for i, (a, b) in enumerate(zip(x, y)):

if a is not None and b is not None:

self.X[i].append(a)

self.Y[i].append(b)

self.axes[0].cla()

for x, y, fmt in zip(self.X, self.Y, self.fmts):

self.axes[0].plot(x, y, fmt)

self.config_axes()

display.display(self.fig)

display.clear_output(wait=True)

# 训练函数

def train_ch3(net,train_iter,test_iter,loss,num_epochs,updater):

# 可视化

animator = Animator(xlabel='epoch',xlim=[1,num_epochs],ylim=[0.3,0.9],legend=['train loss','train acc','test acc'])

for epoch in range(num_epochs):

# 训练误差

train_metrics = train_epoch_ch3(net,train_iter,loss,updater)

# 在测试数据集上评估精度

test_acc = evaluate_accuracy(net,test_iter)

# 可视化进行显示

animator.add(epoch+1,train_metrics+(test_acc,))

train_loss,train_acc=train_metrics

# 小批量随机梯度下降来优化模型的损失函数

lr = 0.1

def updater(batch_size):

# 梯度下降来优化损失函数

return d2l.sgd([w,b],lr,batch_size)

# 训练10个周期

num_epochs = 10

train_ch3(net,train_iter,test_iter,cross_entropy,num_epochs,updater)

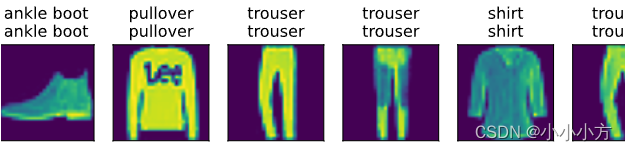

# 预测

def predict_ch3(net, test_iter, n=6):

"""预测标签"""

for X, y in test_iter:

break

# 真实标号

trues = d2l.get_fashion_mnist_labels(y)

# 预测标号

preds = d2l.get_fashion_mnist_labels(net(X).argmax(axis=1))

titles = [true +'\n' + pred for true, pred in zip(trues, preds)]

d2l.show_images(

X[0:n].reshape((n, 28, 28)), 1, n, titles=titles[0:n])

predict_ch3(net, test_iter)

softmax的简洁实现

import torch

from torch import nn

from d2l import torch as d2l

batch_size = 256

# 将数据放入数据迭代器

train_iter, test_iter = d2l.load_data_fashion_mnist(batch_size)

# pyTorvh不会隐式的调整输入的形状

# 定义展平层flatten在线性层前调整网络输入的形状 转换成一个2D,第0位保留,其余的转换成一个向量

# 线形层,输入是784 输出是10

net = nn.Sequential(nn.Flatten(),nn.Linear(784,10))

# 每一层初始化权重

def init_weights(m):

if type(m) == nn.Linear:

nn.init.normal_(m.weight,std=0.01)

net.apply(init_weights);

# 交叉熵 没有参数的化会返回一个标量

loss = nn.CrossEntropyLoss(reduction='none')

trainer = torch.optim.SGD(net.parameters(),lr=0.1)

num_epochs=10

d2l.train_ch3(net,train_iter,test_iter,loss,num_epochs,trainer)

765

765

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?