这篇可能是我学生生涯中撰写最后一篇技术类文章,只想好声跟您到声别。

四年前,我与CSDN相识,在这个平台上,我认识了许多志同道合的朋友,见证了众多积极向上、勇于攀登的学生。他们对未知世界的探索精神,不断攀登知识高峰的决心,对专业知识细致入微的讲解和疑难问题深入分析的态度,都让我深受感动,并激发了我向你们学习并齐的动力。

《资治通鉴》中有言:“尽小者大,慎微者著”。自大学以来,无论是经验分享还是案例分析,我一直坚信,从细微之处入手,从小处着眼,脚踏实地干,持之以恒干,是个人成长成才的宝贵品质。这几年间,我看到的人是这样做的,我可能也是这样做的。“随风潜入夜,润物细无声”,士别三日,当另眼相看。知识的力量总是强大的,岁月的积淀总是厚积成器。这几年间大家的变化很是显著,知识的储备、分析和解决问题的能力都变得更加强大,大家在不知不觉间掌握成长成才的宝贵品质。我为自己感到骄傲,也为每一位同行者鼓掌。

岁月不居,时节如流。但我们扬帆奋楫,勇敢前行。未来的漫漫长路肯定不是一片坦途,必定充满了荆棘和坑洼。因此,寄希望于我们:继续保持谦逊、务实的低调作风,秉承戒骄戒躁的精神,拿出“咬定青山不放松”的恒心,勇毅前行,坚定信念,念念不忘,必有回响。

祝愿大家安康。

一、 使用ilink-vpn 加速器进入github-ollama(重点是能进入github中ollama下载包的位置)

1.1 安装 ilink-vpn 插件

我的是edg浏览器,进入edge浏览器添加扩展业搜索- ilink,添加到浏览器扩展中后,开启vpn只要能进入GitHub即可。

1.2 在浏览器网页搜索: https://github.com/ollama/ollama/releases是Ollama项目在GitHub上的发布页面。通常,这个页面会列出项目的各种版本发布信息,包括但不限于版本号、发布时间、更新内容说明以及下载链接等资源。Releases · ollama/ollama![]() https://github.com/ollama/ollama/releases

https://github.com/ollama/ollama/releases

下滑找到最新 ollama版本的下载资源位置。

1.3 找到 OllamaSetup.exe (Ollama软件的安装程序,【通过运行这个.exe文件,用户可以按照向导完成Ollama软件的安装过程】)

1.3.1 鼠标右击将其下载连接copy下载

https://github.com/ollama/ollama/releases/download/v0.5.7/OllamaSetup.exe 【下载连接,进不去github不会魔法的可以直接使用我的这个连接】

1.4 下载安装,迅雷下载 。 将上面的copy(复制)的网址链接,放置 迅雷下载任务的框框中。

解决国内下载github部署的Ollama资源,速度慢,下载易失败的情况。

点击下载后,你可以看到速度很快,避免国内网速限制问题。

二、 安装

2.1 安装路径位置更改。 因为Ollama 默认 安装路径在c盘,考虑内存问题,建议更为安装路径,当双击Ollama时,默认会直接进入c盘,可视化安装界面没有提供更改路径位置。

在D:/或者E:/ (d或e盘的位置)创建一个文件夹,命名为 "MySoftware ",在文件夹“MySoftware”中再创建一个文件夹名为“Ollama”,讲再迅雷中下载好的“OllamaSetup.exe” Ollama安装程序复制到Ollama文件下。

在文件路径上输入CMD回车,该操作会自动打开在“E:\MySoftware\Ollama”该文件路径下的的命令窗口。

然后在CMD窗口输入:OllamaSetup.exe /DIR=E:\MySoftware\Ollama 点击回车【enter】

然后电脑界面就会弹出一个Ollama程序安装界面,点击install ,进行安装。

结果就是,顺利更改了“Ollama”安装路径。

【上述Ollama】已经安装完成了。

三、 本地部署 deepseek r1

进入Ollama官网, 网址:【 https://ollama.com/download 】

点击 Models 【Ollama 支持的DeepSeek-R1模型】

找到 deepSeek-r1 选项进入。

接下来,打开下来选项按钮,你会看到 Ollam模型库提供了不同电脑适配的DeepSeek-R1 模型版本,如 1.5B、7B、8B、....,等等。

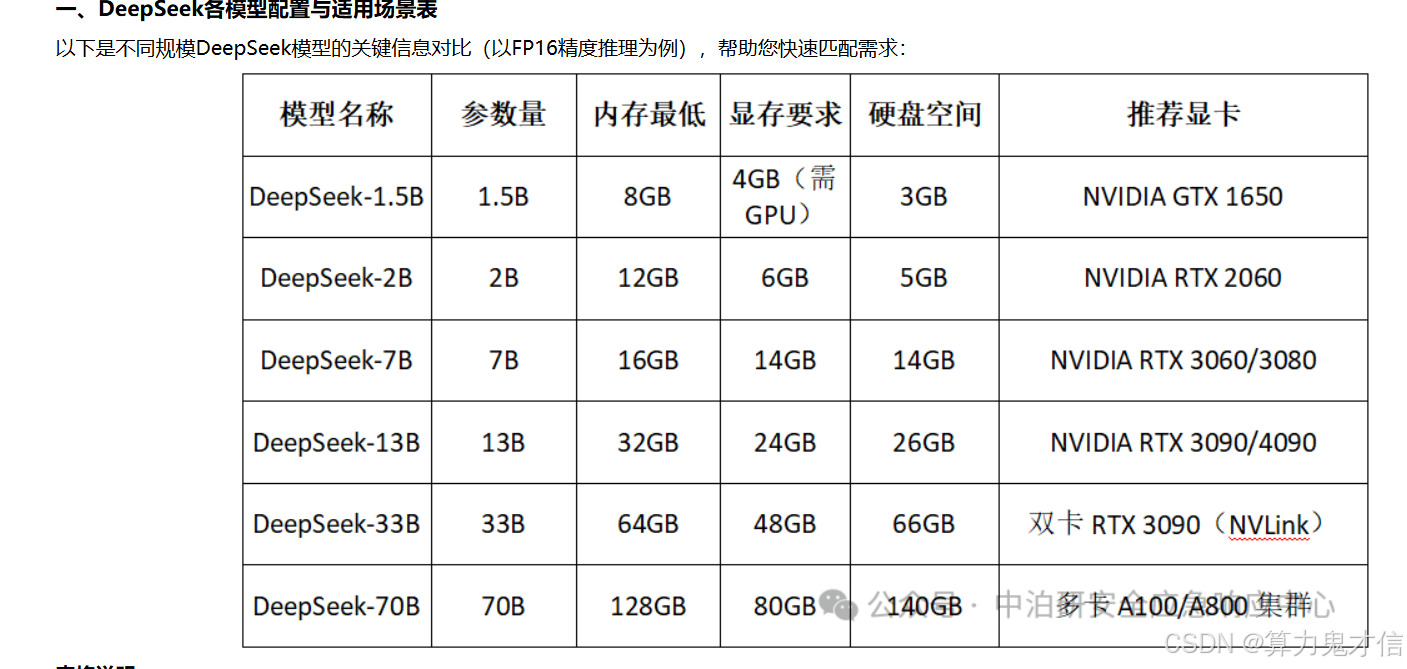

如何选择适合你自己电脑的配置的DeepSeek-R1 模型版本,请您看下方图片文字,并查看自身电脑显存

查看电脑显存

方法: win+r运行dxdiag win就是键盘上四个小方框的按键 微软图标

点击 确定后,点击显示,总内存约为8202MB 即为显存。

选择适合你电脑配置DeepSeek-R1 模型版本。

我的显存为 8202MB。 1GB = 1024MB 8202MB = 8.009765625 GB 约等于8GB

模型参数越大,脑容量就越大,响应速度,就越快。1.5 < 7b < 8b < 32b 等等。

因此我选择DeepSeek-R1-1.5 b。

命令行执行相应版本的代码

不同版本大小的DeepSeek-R1 模型 他的执行命令会变。注意: 复制下方图片右边的命令提示符

1.5b 对应 【 ollama run deepseek-r1:1.5b 】

在命令提示行中,执行该命令: ollama run deepseek-r1:1.5b

首次运行会自动下载模型,运行完成后再次输入该命令,就可以进行正常交互了

【当你执行命令 ollama run deepseek-r1:1.5b 时,如果本地环境中没有所需的模型文件(即 deepseek-r1 的1.5 billion参数版本),Ollama 平台会自动尝试从远程服务器下载该模型到本地。这是因为运行一个AI模型首先需要确保所有必要的文件和资源都已经在本地可用】。

下载完成后,再次输入 ollama run deepseek-r1:1.5b 就可以正常使用了。

ollama 跑这个deepseek模型已经跑起来来了

可视化界面我电脑内存不够了,安装不成功,大家在网上找找,一个是 open weui 一个是,

1万+

1万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?