🌟 前言

随着大语言模型(LLM)的普及,越来越多用户希望在本地部署模型以保护隐私、提升效率。本文将手把手教你如何在 Windows 10/11系统 上通过 Ollama 工具安装并运行 DeepSeek R1 模型。

🛠️ 第一步:安装Ollama

1. 下载Ollama安装包

- 官方地址:https://ollama.com/download

- 选择Windows版本:点击 “Download for Windows”,下载

OllamaSetup.exe(约745MB)。 - 加速下载建议:若浏览器速度慢,复制链接到迅雷或IDM下载。。

2. 安装Ollama

- 默认安装路径:双击

OllamaSetup.exe,点击 Install,默认安装到C:\Program Files\Ollama。 - 自定义安装路径:

- 打开命令行(Win+R → 输入

cmd)。 - 输入命令:

OllamaSetup.exe /DIR=D:\Ollama - 确认路径后点击 Install。

- 打开命令行(Win+R → 输入

3. 验证安装

- 命令行验证:

若输出类似ollama --versionollama version 0.1.34,则安装成功。 - 图形化验证:右下角任务栏应出现 羊驼图标(若未显示,展开状态栏检查)。

🔧 第二步:下载并运行DeepSeek模型

1. 选择模型版本

DeepSeek R1 提供多个版本,根据硬件配置选择:

| 模型版本 | 参数量 | 显存需求 | 推荐配置 |

|---|---|---|---|

deepseek-r1:1.5b | 15亿 | 4GB | 8GB内存 + 10GB磁盘 |

deepseek-r1:7b | 70亿 | 8GB | 16GB内存 + 20GB磁盘 |

deepseek-r1:14b | 140亿 | 12GB | 32GB内存 + 50GB磁盘 |

新手推荐:选择

deepseek-r1:1.5b以降低硬件要求。

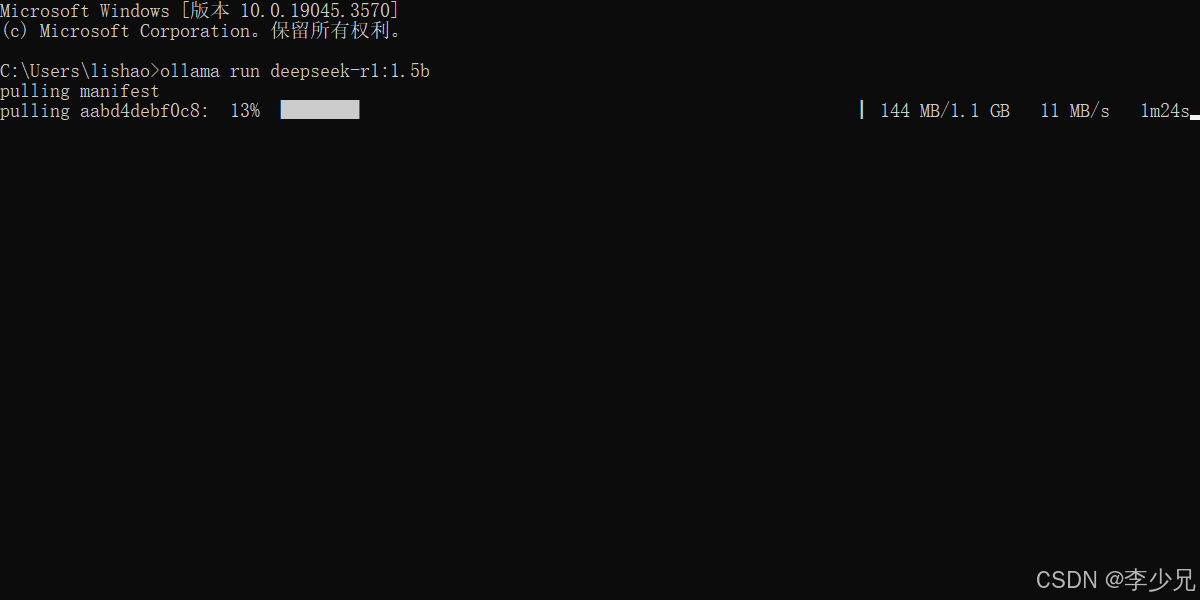

2. 下载模型

- 命令行执行:

ollama run deepseek-r1:1.5b - 下载过程说明:

自定义模型文件下载地址看 第四步

- Ollama 会自动从远程仓库下载模型文件(约2-3GB),并解压到默认路径:

C:\Users\<用户名>\.ollama\models。 - 下载中断处理:若下载失败,重复运行上述命令,Ollama 会自动续传。

3. 验证模型安装

- 查看已安装模型:

输出应包含ollama listdeepseek-r1:1.5b。

🧪 第三步:使用DeepSeek模型

1. 命令行交互

- 启动模型:

ollama run deepseek-r1:1.5b - 对话示例:

模型会返回详细回答,首次响应约需3-5秒。>>> 如何学习Python?

退出对话:Ctrl + d 或者 /bye

2. 通过API调用模型

- REST API 示例:

curl http://localhost:11434/api/generate -d '{ "model": "deepseek-r1:1.5b", "prompt": "如何学习Python?", "stream": false }'

🗂️ 第四步:更改模型存储路径(可选)

1. 设置环境变量

- 操作步骤:

- 右键 此电脑 → 属性 → 高级系统设置 → 环境变量。

- 在 系统变量 中点击 新建:

- 变量名:

OLLAMA_MODELS - 变量值:

E:\ollama\OllamaModels(自定义路径)。

- 变量名:

- 重启电脑使设置生效。

2. 验证路径更改

- 重新运行

ollama run deepseek-r1:1.5b,模型会下载到新路径。

📦 第五步:安装图形化界面(可选)

1. 安装Docker

- 下载地址:Docker Desktop

- 安装步骤:

- 启用 WSL 2 和 Hyper-V(需管理员权限)。

- 安装完成后启动 Docker Desktop。

2. 部署Chatbox

- 命令行执行:

docker run -d --name=maxkb --restart=always -p 8080:8080 -v C:/maxkb:/var/lib/postgresql/data -v C:/python-packages:/opt/maxkb/app/sandbox/python-packages registry.fit2cloud.com/maxkb/maxkb - 访问地址:

http://localhost:8080

3. 部署Open-WebUI

- 命令行执行:

docker run -d --name open-webui -p 3000:8080 -e OLLAMA_HOST=http://localhost:11434 open-webui/open-webui - 访问地址:

http://localhost:3000

⚠️ 常见问题与解决方案

1. 下载失败

- 解决方法:

- 重复运行

ollama run deepseek-r1:1.5b。 - 更换 DNS(如

8.8.8.8)或使用代理。

- 重复运行

2. 磁盘空间不足

- 解决方法:

- 删除旧模型:

ollama rm deepseek-r1:1.5b

- 删除旧模型:

3. 安全性建议

- 本地部署:默认监听

http://localhost:11434,无需公网暴露。 - 远程访问:若需开放,配置防火墙和身份验证(如 Nginx 反向代理)。

📚 附录:Ollama常用命令

| 命令 | 描述 |

|---|---|

ollama serve | 启动 Ollama 服务 |

ollama create | 从 Modelfile 创建模型 |

ollama show | 显示模型信息 |

ollama run | 运行模型 |

ollama stop | 停止正在运行的模型 |

ollama pull | 拉取模型 |

ollama list | 列出所有已下载模型 |

ollama ps | 列出当前运行的模型 |

ollama cp | 复制模型 |

ollama rm | 删除模型 |

ollama help | 获取命令帮助 |

✅ 总结

通过本文的步骤,你可以在本地快速部署 DeepSeek 模型并实现离线使用。以下是关键点总结:

- 核心流程:安装 Ollama → 下载 DeepSeek 模型 → 使用命令行或 API 交互。

- 推荐配置:选择

1.5b模型以降低硬件需求。 - 扩展功能:通过 Docker 部署图形化界面(如 Chatbox 或 Open-WebUI)。

548

548

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?