pytorch autograd

PyTorch的autograd(自动求导)是PyTorch中一个强大而灵活的自动微分库,它使得神经网络的训练和梯度计算变得更加容易。autograd会自动跟踪和记录执行的操作,从而构建计算图,然后可以使用这个计算图来计算梯度。以下是有关PyTorch autograd的一些重要概念和用法:

张量(Tensors): autograd的核心数据结构是张量,它是多维数组,类似于NumPy的数组。可以在张量上执行各种数学运算,并在需要时自动记录这些运算以构建计算图。

计算图(Computation Graph): 计算图是由张量和执行的操作组成的有向无环图(DAG)。PyTorch会自动构建计算图,记录每个操作,以便在后续需要时进行梯度计算。这使得反向传播算法能够有效地计算梯度。

叶子节点(Leaf Nodes): 在计算图中,叶子节点是用户手动创建的张量,而非通过操作生成的。叶子节点是梯度计算的起点,通常对应于模型的输入数据或参数。

requires_grad属性: 可以通过设置张量的requires_grad属性来指示是否要跟踪其操作以计算梯度。默认情况下,该属性为False。如果需要计算张量的梯度,可以将其设置为True。

反向传播(Backpropagation): 反向传播是自动求导的关键步骤,它通过计算链式法则来计算梯度。PyTorch的autograd模块会自动执行反向传播,从叶子节点开始,沿着计算图计算梯度。

梯度(Gradient): 梯度是指目标函数相对于某个参数的偏导数。PyTorch autograd可以计算张量相对于另一个张量的梯度,以及相对于多个参数的梯度。

autograd函数: autograd模块中有许多用于操作和计算梯度的函数,如backward()用于计算梯度、grad属性用于获取梯度等。

下面展示一些 `内联代码片`。

import torch

# 创建张量,并告知需要计算梯度

x = torch.tensor([1.0, 2.0, 3.0], requires_grad=True)

# 执行一些操作

y = x * 2

z = y.sum()

# 计算z相对于x的梯度

z.backward()

# 查看x的梯度

print(x.grad)

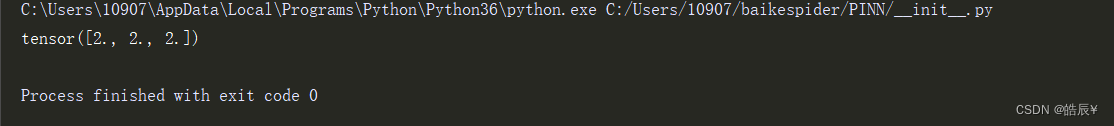

结果如下:

我们首先创建了一个张量 x,并将其设置为需要计算梯度,即 requires_grad=True。然后,我们执行了一系列操作,其中 y 是 x 的每个元素的两倍,z 是 y 的元素之和。因此,z 的值是 x 的每个元素的两倍之和,即 z = 2 * (1.0 + 2.0 + 3.0) = 12.0。

当我们调用 z.backward() 时,PyTorch会自动计算 z 相对于 x 的梯度。因为 z 是一个标量(单个值),而 x 是一个包含多个元素的张量,所以 x 的梯度是一个与 x 具有相同形状的张量,其中每个元素都是 z 相对于相应元素的偏导数。

在这个例子中,由于 z 是 x 的每个元素的两倍之和,所以 x 的每个元素对应的梯度都是 2。因此,x.grad 的值是 tensor([2., 2., 2.]),表示每个 x 元素的梯度都是 2。

这个结果符合梯度的计算方式,即通过链式法则,对于一个标量目标函数,梯度是该函数相对于每个输入元素的偏导数的向量。在这种情况下,目标函数是 z,而输入元素是 x 的三个元素。

1658

1658

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?