第一课:书生·浦语大模型全链路开源体系

一、前言

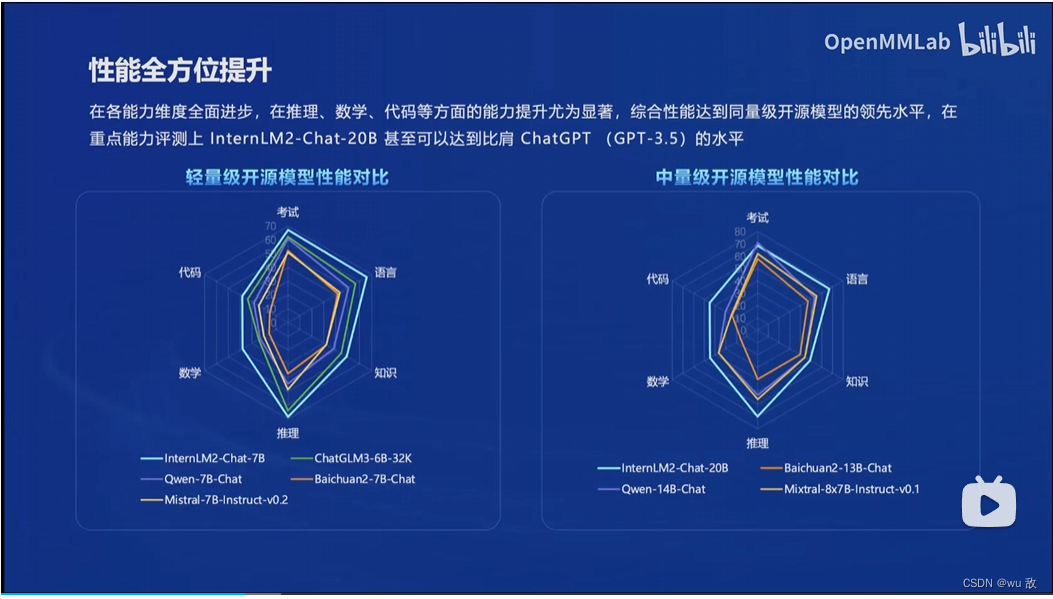

相对以往的专用大模型而言,通用大模型是一个模型对应多种任务,多种模态的模型,现成为人工智能发展趋势。书生浦语2.0大模型(InternLM2)与2024年1月17日开源,提供了7B轻量级模型和20B中量级模型,每个模型都包含了InternLM2-Base,InternLM2,InternLM2-Chat模型,InternLM2 的核心理念在于回归语言建模的本质,致力于通过提高语料质量及信息密度,实现模型基座语言建模能力获得质的提升,进而在数理、代码、对话、创作等各方面都取得长足进步,综合性能达到同量级开源模型的领先水平。

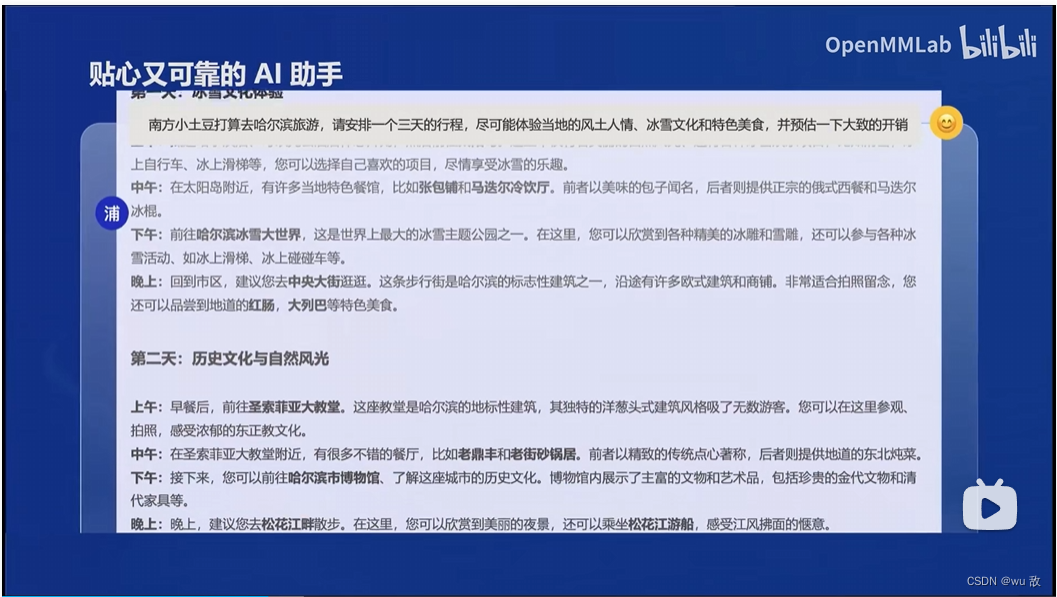

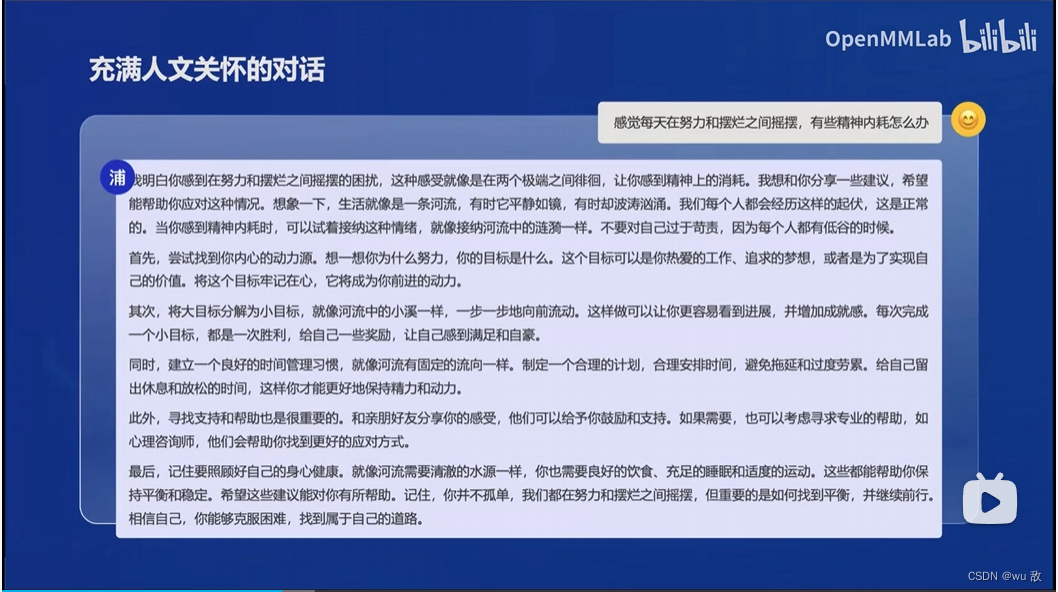

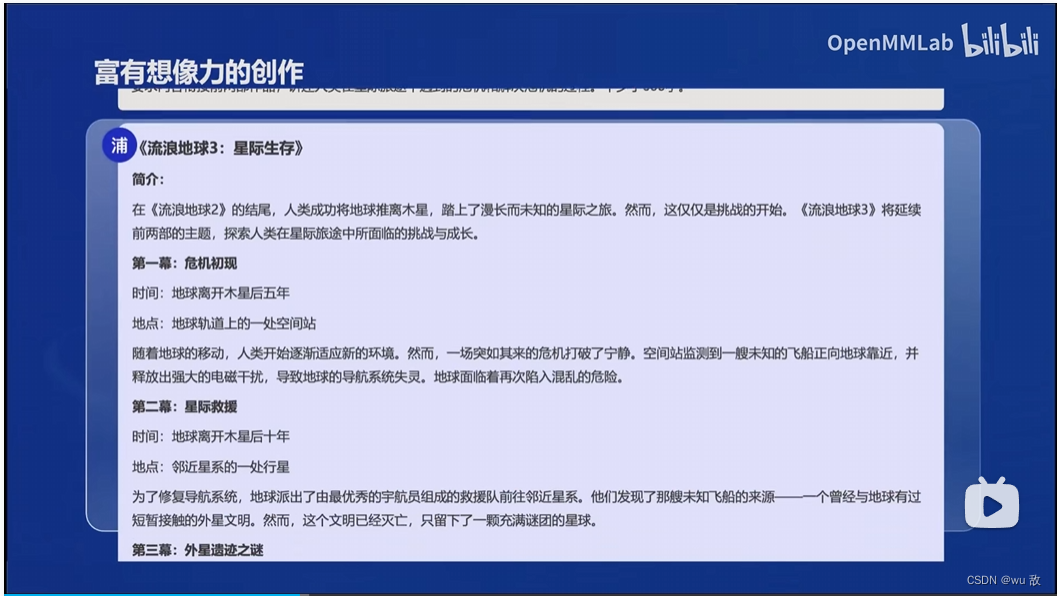

二、书生浦语2.0的主要亮点

1、超长上下文;

在20万超长token上下文中几乎完美实现“大海捞针”。

2、综合性能全面提升;

3、优秀的对话和创作体验;

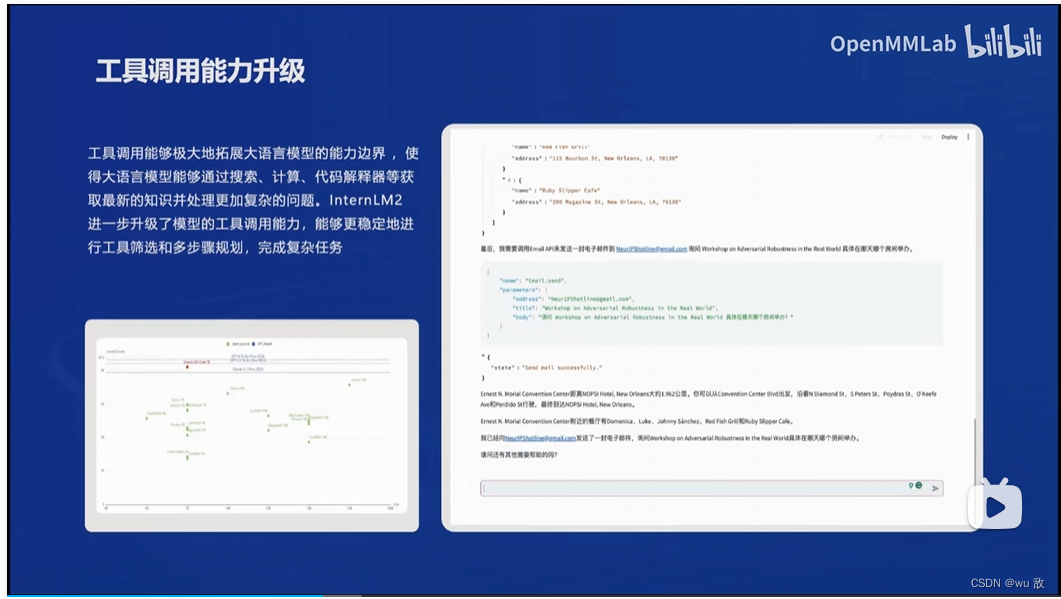

4、工具调用能力整体升级;

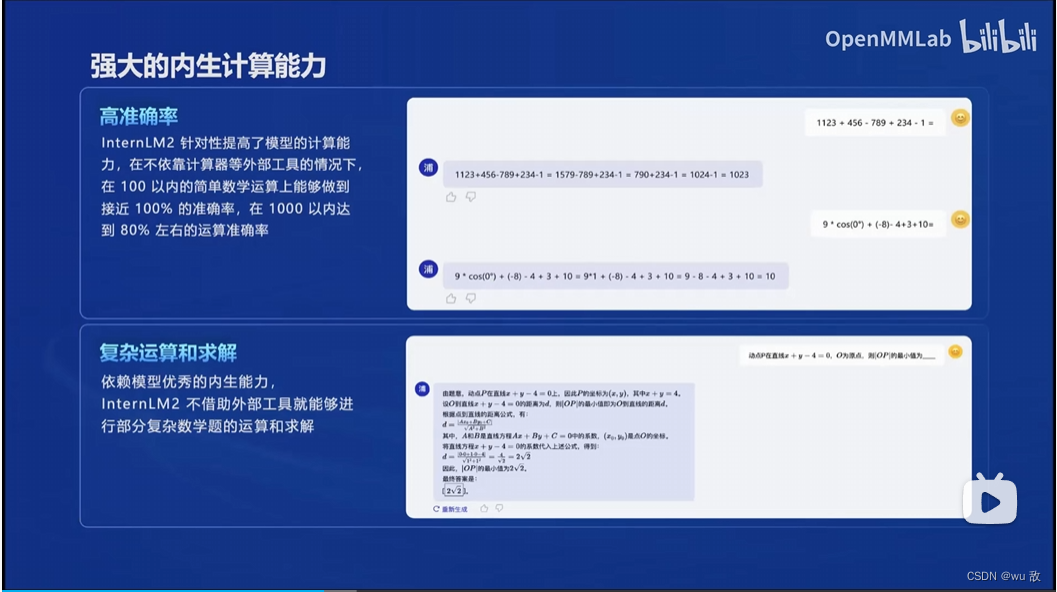

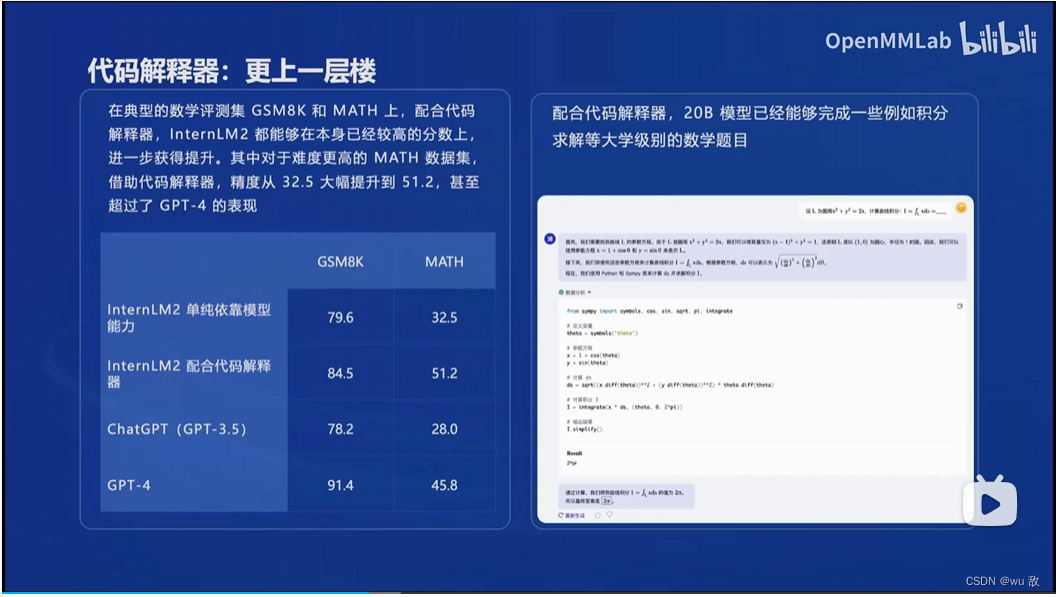

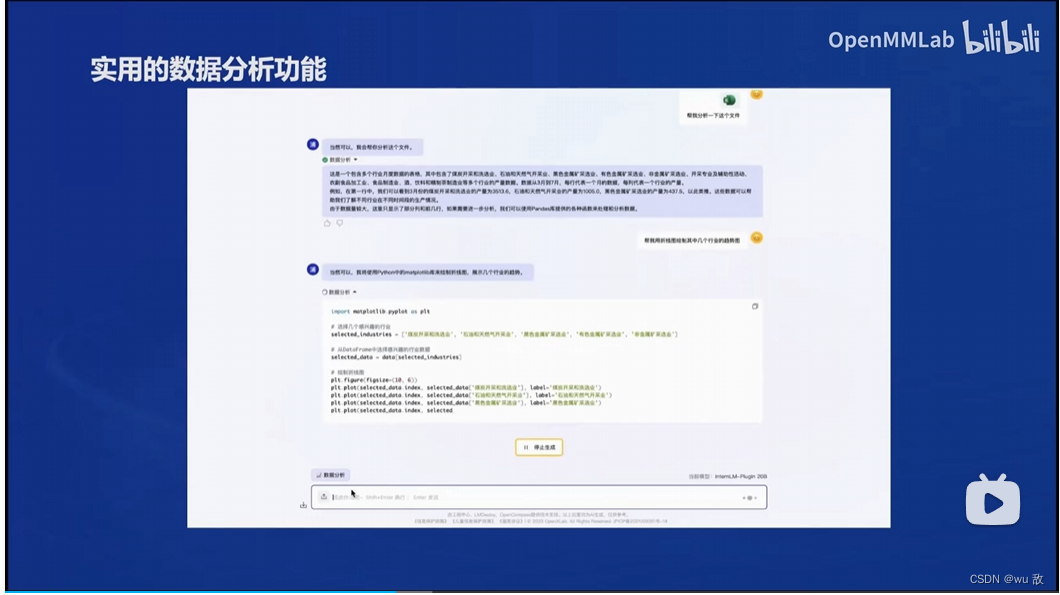

5、突出的数理能力和实用的数据分析功能。

三、从模型到应用

1、主要应用方向

智能客服、个人助手、行业应用。

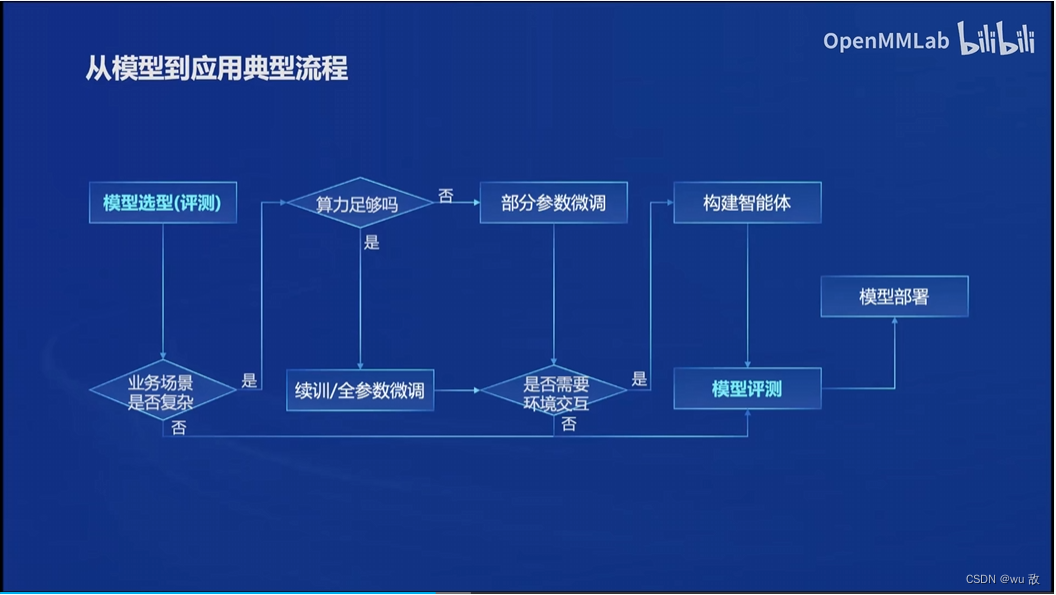

2、典型流程

四、全链条开源开放体系

书生浦语全链条开源开放体系

1、数据集:书生·万卷 1.0 书生·万卷 CC

2、预训练

3、微调:增量续训(文章、书籍、代码)(让模型学习一些新知识,如某个垂类领域的知识)

监督微调(高质量的对话,问答数据)(让模型学会理解各种指令)

高效微调框架(XTuner)

4、评测:Opencompass;compass Kit ;compass hub

5、部署:LMDeploy

6、应用:智能体lagent:多模态智能体工具箱agentLego

五、总结

书生浦语2.0大模型是上海人工智能实验室与商汤科技联合香港中文大学和复旦大学正式发布新一代大语言,该模型工具链极其完善,支持开源本地化部署与开发;模型性能强, 数据集都已开放,兼容性强,支持HuggingFace,是本地部署与二次开发应用的一款非常不错的大模型之一。

1304

1304

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?