ai的能力越来越强,之前认为是人类独有能力的领域,也在被ai不断的超越。创造性缺失是之前对ai的普遍性认知,死板、程序化是ai鲜明的特点,因此艺术创作普遍认为是ai不可替代的。

但好像这个认知被打破了,之前有新闻报道,完全不懂绘画的人,通过ai创作的画作拔得大赛头筹,引起了人们的普遍讨论。

对此事情,在此不做讨论,从这件事我们可以看到的是,ai逐渐拥有人类创造力,或者说逐渐的在模仿人类的创作力,但不管如何,ai在艺术上的创作能力是逐渐提升,这是不可否认的。

之前写过通过图像生成技术、语音技术创造一个属于自己独一无二的“女朋友”,图像生成可以看做是ai创造性能力获取的前置能力

在前不久,百度发布了“一格”——一个让任何人都可以进行艺术创作的平台,生成自己的大片不是梦,简单的操作就可以生成自己的“梦中情画”

一格的使用需要提交审核,但基本是三五分钟通过,生成的图片可以发表到一格的画廊,或者提交审核后自己下载

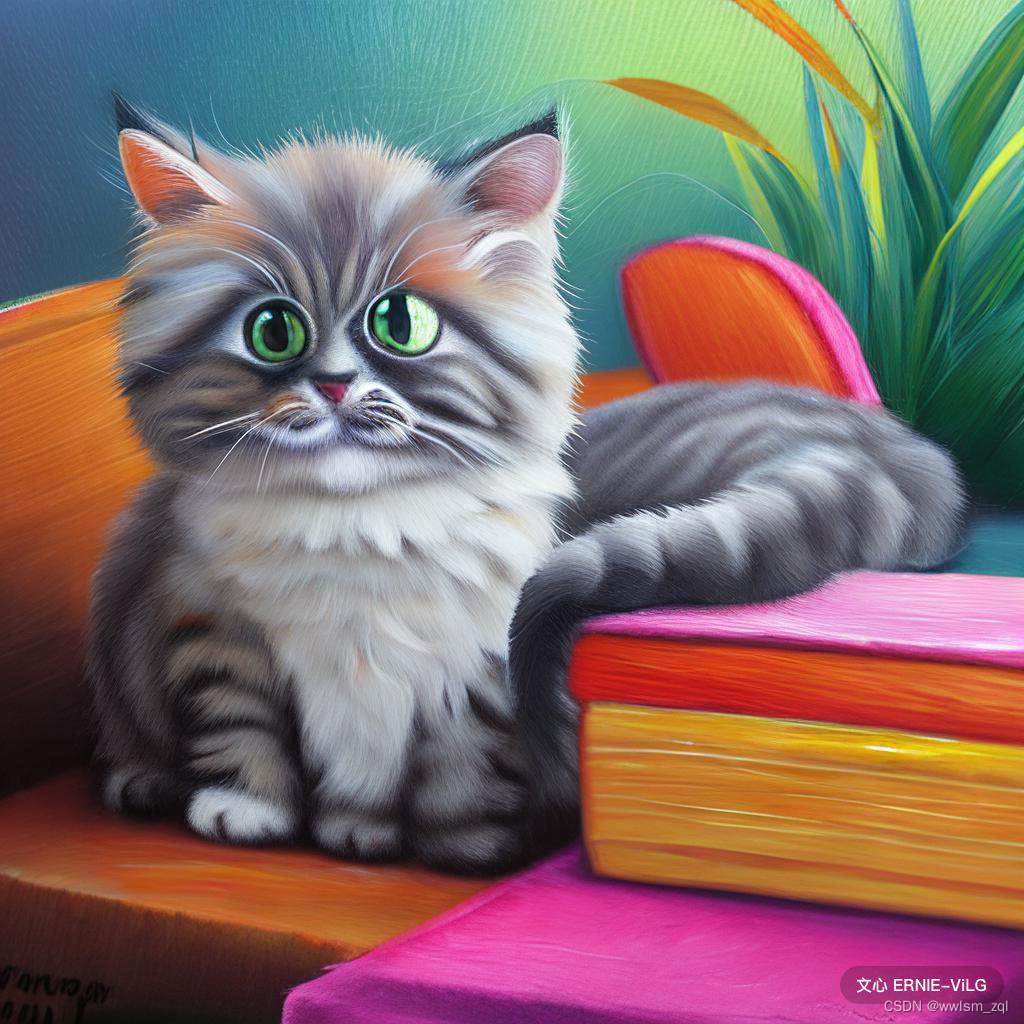

这是我比较中意的自己生成的一个结果——荷塘月色

这比网络上各种“大师”的结果好太多了

近期看到百度通过paddlehua发布了新的一款图像生成技术——ernie_vilg。相比“一格”,ernie_vilg是更属于技术宅人员,可以通过搭建环境自行生成任意的图片

环境搭建是非常简单的,通过百度提供的aistudio或者谷歌的colab都可以

import paddlehub as hub

module = hub.Module(name="ernie_vilg")

results = module.generate_image(text_prompts=["可爱的猫"])

在上述text_prompts后,写上自己对图片的描述,直接生成符合描述的图,一步到位。

如果不想自己搭建环境,也可以通过huaggingface的sapace空间进行体验,但生成速度比较感人

不论是百度之前的“一格”,还是paddlehub的ernie_vilg,都可以根据文本描述转图片,而文本生成图片最早可以追溯到迪斯尼的一篇论文,通过文本生成图片进而合成动画,随后有DELL、GPT-3、ERNIE等,都在尝试文本生成图片,效果都比较一般。

ai能力的不断增强,希望看到越来越多的惊喜~

1944

1944

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?