目录:Mask R-CNN论文理解

一、摘要

论文提出了一个概念上简单、灵活和通用的对象实例分割框架。有效地检测图像中的对象,同时为每个实例生成高质量的分割掩码。

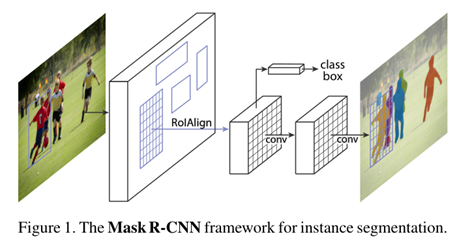

方法被称为Mask R-CNN,通过添加一个用于预测对象掩码的分支,并与现有的用于边界框识别的分支并行,扩展了Faster R-CNN。

二、介绍

视觉界在短时间内迅速改进了目标检测和语义分割结果。在很大程度上,这些进步是由强大的基线系统驱动的,例如分别用于对象检测和语义分割的Fast/Faster R-CNN和全卷积网络(FCN)框架。

这些方法在概念上是直观的,并提供了灵活性和鲁棒性,以及快速的训练和推理时间。

我们在这项工作中的目标是为实例分割开发一个相对可行的框架。

实例分割具有挑战性,因为它需要正确检测图像中的所有对象,同时还需要精确分割每个实例。

因此,它结合了对象检测的经典计算机视觉任务的元素,其目标是对单个对象进行分类,并使用边界框和语义分割对每个对象进行本地化,语义分割的目标是将每个像素分类到一个固定的类别集,而不区分对象实例。鉴于此,人们可能会期望需要一个复杂的方法来获得良好的结果。然而,我们展示了一个惊人的简单、灵活和快速的系统可以超越先前最先进的实例分割结果。

方法称为Mask R-CNN,通过添加一个用于预测每个感兴趣区域(RoI)上的分割掩码的分支,扩展了Faster R-CNN,与用于分类和边界盒回归的现有分支并行,如图所示:

掩码分支是应用于每个ROI的FCN,以pixel to pixel的方式预测分割掩码。基于Faster R-CNN框架,Mask R-CNN易于实现和训练,该框架促进了广泛的灵活架构设计。

此外,掩码分支只增加了少量的计算开销,可以实现快速的系统和快速的实验。

原则上Mask R-CNN是Faster R-CNN的直观扩展,然而正确构建Mask分支对于良好的结果是至关重要的。最重要的是,Faster R-CNN不是为网络输入和输出之间的像素到像素对齐而设计的。这在RoIPool中表现得最为明显,RoIPool实际上是处理实例的核心操作,它为特征提取执行粗空间量化。

为了解决不对中问题,我们提出了一个简单的、无量化的层,称为RoIAlign,它忠实地保存了精确的空间位置。

看似一个看似微小的变化,RoIAlign有很大的影响:它提高掩模精度相对10%到50%,在更严格的本地化指标下表现出更大的收益。

其次,我们发现将掩码和类预测解耦是至关重要的:我们独立地为每个类预测一个二进制掩码,没有类之间的竞争,并依赖于网络的RoI分类分支来预测类别。

相比之下,FCNs通常执行逐像素的多类分类,将分割和分类结合在一起,并且根据我们的实验,在实例分割方面效果不佳。

通过一系列的实验证实,我们的Mask R-CNN可以被更广泛地视为实例级识别的灵活框架,并且可以很容易地扩展到更复杂的任务。

三、Mask R-CNN

概念上很简单:Faster R-CNN对每个候选对象有两个输出,一个类标签和一个边界框偏移量;在此基础上,我们添加了输出对象掩码的第三个分支。

但是附加的掩码输出不同于类和框输出,需要提取更精细的对象空间布局。

接下来,我们将介绍Mask R-CNN的关键元素,包括像素到像素对齐,这是Fast/Faster R-CNN的主要缺失部分。

我们首先快速回顾一下Faster R-CNN:

Faster R-CNN由两个阶段组成。第一阶段称为区域提议网络(Region Proposal Network, RPN),提出候选对象边界框。第二阶段,本质上是Fast R-CNN,使用RoIPool从每个候选框中提取特征,并执行分类和边界盒回归。两个阶段使用的特征可以共享,以便更快地推断。

Mask R-CNN采用相同的两阶段程序,具有相同的第一阶段(即RPN)。在第二阶段,在预测类和盒偏移的同时,Mask R-CNN还为每个RoI输出一个二进制掩码。这与大多数最新的系统形成对比,其中分类取决于掩码预测。

形式上,在训练过程中,我们将每个采样RoI上的多任务损失定义为:

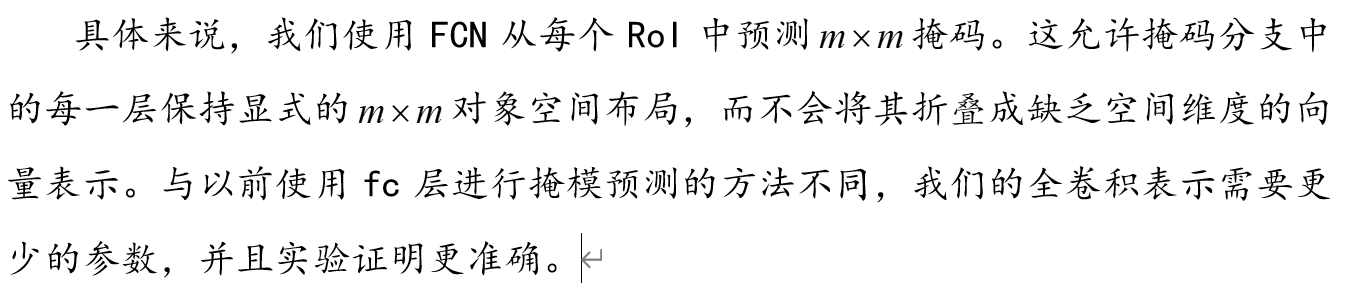

掩码编码输入对象的空间布局。因此,不像类标签或盒偏移不可避免地被全连接(fc)层折叠成短输出向量,提取掩码的空间结构可以通过卷积提供的像素到像素的对应自然地寻址。

这种像素到像素的行为要求我们的RoI特征(它们本身就是小的特征映射)很好地对齐,以忠实地保持显式的逐像素空间对应关系。这促使我们开发了以下RoIAlign层,它在掩模预测中起着关键作用。

四、RoIAlign

RoIPool是从每个RoI中提取小特征映射(例如,7×7)的标准操作。RoIPool首先将一个浮点数RoI量化为特征映射的离散粒度,然后将这个量化的RoI细分为空间箱,这些空间箱本身是量化的,最后对每个箱覆盖的特征值进行聚合(通常采用最大池化)。量化是通过计算[x/16]在连续坐标x上执行的,其中16是特征图步幅,[·]是舍入;同样地,量化是在划分到容器(例如,7×7)时执行的。这些量化引入了RoI和提取特征之间的失调。虽然这可能不会影响分类(对小的翻译是稳健的),但它对预测像素精确掩码有很大的负面影响。

为了解决这个问题,我们提出了一个RoIAlign层,它消除了RoIPool的苛刻量化,正确地将提取的特征与输入对齐。我们提出的改变很简单:我们避免任何RoI边界的量化或bins。(我们用x/16代替[x/16])我们使用双线性插值来计算每个RoI bin中四个常规采样位置的输入特征的精确值,并聚合结果(使用最大值或平均值)。我们注意到,只要不进行量化,结果对准确的采样位置或采样多少点并不敏感。

RoIAlign带来了很大的改进。我们还比较了提出的RoIWarp操作。与RoIAlign不同的是,RoIWarp忽略了对齐问题,并像RoIPool一样实现了量化RoI。因此,即使RoIWarp也采用了双线性重采样,但从实验结果来看,它的性能与RoIPool相当,说明了对齐的关键作用。

五、Network Architecture

为了演示我们方法的通用性,我们用多个体系结构实例化Mask R-CNN。为了清晰起见,我们区分了:(i)用于整个图像特征提取的卷积主干架构,以及(ii)用于边界框识别(分类和回归)和分别应用于每个RoI的掩码预测的网络头部。

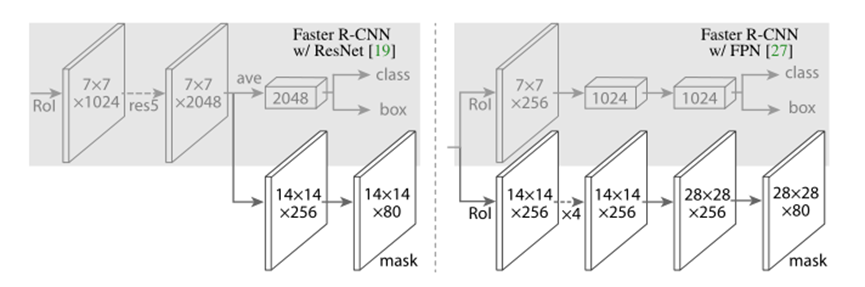

我们使用术语网络深度特征来表示骨干体系结构。我们评估了深度为50层或101层的ResNet和ResNeXt网络。使用ResNets的Faster R-CNN的原始实现从第4阶段的最后卷积层中提取特征,我们称之为C4。例如,ResNet-50的主干被表示为ResNet-50- c4。

我们还探索了Lin等人最近提出的另一种更有效的主干,称为特征金字塔网络(FPN)。FPN使用带有横向连接的自顶向下架构,从单尺度输入构建网络内特征金字塔。具有FPN主干的更快的R-CNN根据其规模从特征金字塔的不同级别提取RoI特征,但除此之外,该方法的其余部分类似于香草ResNet。使用ResNet-FPN骨干网与Mask RCNN进行特征提取,在精度和速度方面都获得了优异的收益。

对于网络头,我们密切关注在以前的工作中提出的架构,我们添加了一个完全卷积掩码预测分支。具体来说,我们从ResNet[19]和FPN[27]论文中扩展了Faster R-CNN盒头。详细信息如图4所示。ResNet- c4主干上的头部包括ResNet的第5阶段(即9层’ res5 '[19]),这是计算密集型的。对于FPN,骨干已经包括res5,因此允许使用更少过滤器的更有效的头部。

我们注意到我们的掩模分支有一个简单的结构。更复杂的设计有可能提高性能,但不是这项工作的重点。

六、训练

与Fast R-CNN一样,如果IoU的基本真相框至少为0.5,则RoI被认为是正的,否则为负。掩码损耗Lmask仅在正roi上定义。掩码目标是RoI与其相关的真实掩码之间的交集。

我们采用以图像为中心的训练。图像的大小被调整到它们的尺度(较短的边缘)为800像素。每个mini-batch每个GPU有2张图像,每张图像有N个采样的roi,正负比为1:3。C4骨干的N为64,FPN的N为512。我们在8个gpu上训练(因此有效的小批大小为16),进行160k次迭代,学习速率为0.02,在120k次迭代时下降了10。我们使用的权重衰减为0.0001,动量为0.9。使用ResNeXt,我们用每个GPU 1张图像进行训练,迭代次数相同,起始学习率为0.01。

RPN锚横跨5个尺度和3个纵横比。为了方便消融,RPN单独训练,除非指定,否则不与Mask R-CNN共享特征。对于本文中的每个条目,RPN和Mask R-CNN具有相同的主干,因此它们是可共享的。

1万+

1万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?