这是求职产品经理系列的第189篇文章

哈喽大家好,最近很多小伙伴求职NLP大模型算法工程师,找我要的一个干货资料:《NLP大模型开发18个干货资料合集》耗时25天终于整理完成了! (文末领取)

说明:

1)两个文档总字数4.46万,主要是大厂NLP大模型的高频面试问题答案以及面经总结汇总。

2)18个干货合集涵盖了NLP大模型算法相关的600道题左右,95%以上都是有答案的,可以极大提高大家求职面试的准备效率。

3)面经涵盖了百度、腾讯、阿里、字节、蚂蚁、小红书、寒武纪、网易、科大讯飞、荣耀、华为、商汤、Boss直聘、携程等一二线大厂。

4)高频面试的每一个问题都给出了回答框架以及参考答案,帮助大家提高面试准备效率

5)本内容为PDF格式文档,大家可以随到随学

详细的目录如下,需要的小伙伴可以详细看一下~

干货合集一:NLP大模型面试最全题库整理篇

一、大模型基本概念相关问题(9个)

二、基础知识相关问题(32个)

三、大模型算法相关问题(12个)

四、训练框架相关问题(3个)

五、评测相关问题(4个)

六、数据相关问题(3个)

( 不含答案,大家可以当做题库使用,但是这63道问题的答案基本已包含在其他干货合集中)

干货合集二:网易NLP大模型实习面试题及解析 (含答案)

=======================================

1、文本生成的几大预训练任务?

2、多模态中常见的SOTA模型有哪些?

3、介绍一下stable diffusion的原理。

4、instructGPT的原理,讲讲rlhf和reward。

5、讲讲T5和Bart的区别,讲讲bart的DAE任务。

6、讲讲Bart和Bert的区别。

7、对比学习负样本是否重要?负样本构造成本过高应该怎么解决?

8、介绍一下lora的原理和ptuning的原理。

干货合集三:科大讯飞-NLP大模型算法面试题及解析 (含答案)

======================================================

1、jieba分词的原理

2、word2vec的原理,怎么训练的?

3、ChatGPT是怎么训练出来的

4、BERT模型简述

5、PyTorch中的train和eval模块:

6、Python中字典的结构及实现方式

7、有一组无序数组,如何取前10个最大的数

干货合集四:荣耀NLP算法工程师面试题及解析 (含答案)

===========================================================

1、讲一下transformer

2、transformer怎么调优

3、讲讲word2vec和word embedding区别

4、有做过NER吗,讲讲prompt learning

5、讲讲生成模型和判别模型的区别

6、讲讲LDA算法

**干货合集五:华为NLP算法工程师面试题及解析 (含答案)

===================================================================

1、NLP中常见的分词方法有哪些?

2、讲一下BERT的结构?

3、自然语言处理有哪些任务?

4、L1,L2正则化的区别,岭回归是L1正则化还是L2正则化?

5、怎么处理类别不平衡?

6、模型提速的方法有哪些?

7、了解数据挖掘的方法嘛?

8、了解对比学习嘛?

9、说一下广度优先遍历和深度优先遍历?

干货合集六:大厂常考Transformer模型面试题及解析 (含答案)

==================================================================================

1、Transformer在哪里做了权重共享,为什么可以做权重共享?

2、不考虑多头的原因,self-attention中词向量不乘QKV参数矩阵,会有什么问题?

3、什么BERT选择mask掉15%这个比例的词,可以是其他的比例吗?

4、为什么BERT在第一句前会加一个[CLS]标志?

5、Self-Attention公式为什么要除以d_k的开方?

干货合集七:百度NLP实习面试及解析 (含答案)

===============================================================================

1、说一下transformer。

2、Layer Normalization 和 Batch Normalization。

3、项目里面具体怎么实现PGN的。

4、你知道什么生成任务的模型吗。

干货合集八:NLP大模型-Transformer面试题总结100道题

( 不含答案,但是这100道问题的答案基本已包含在其他干货合集中)

干货合集九:LLM大模型面试准备题库及答案(上)(含答案)

1. 如何定义“大模型”在现代AI领域的概念?

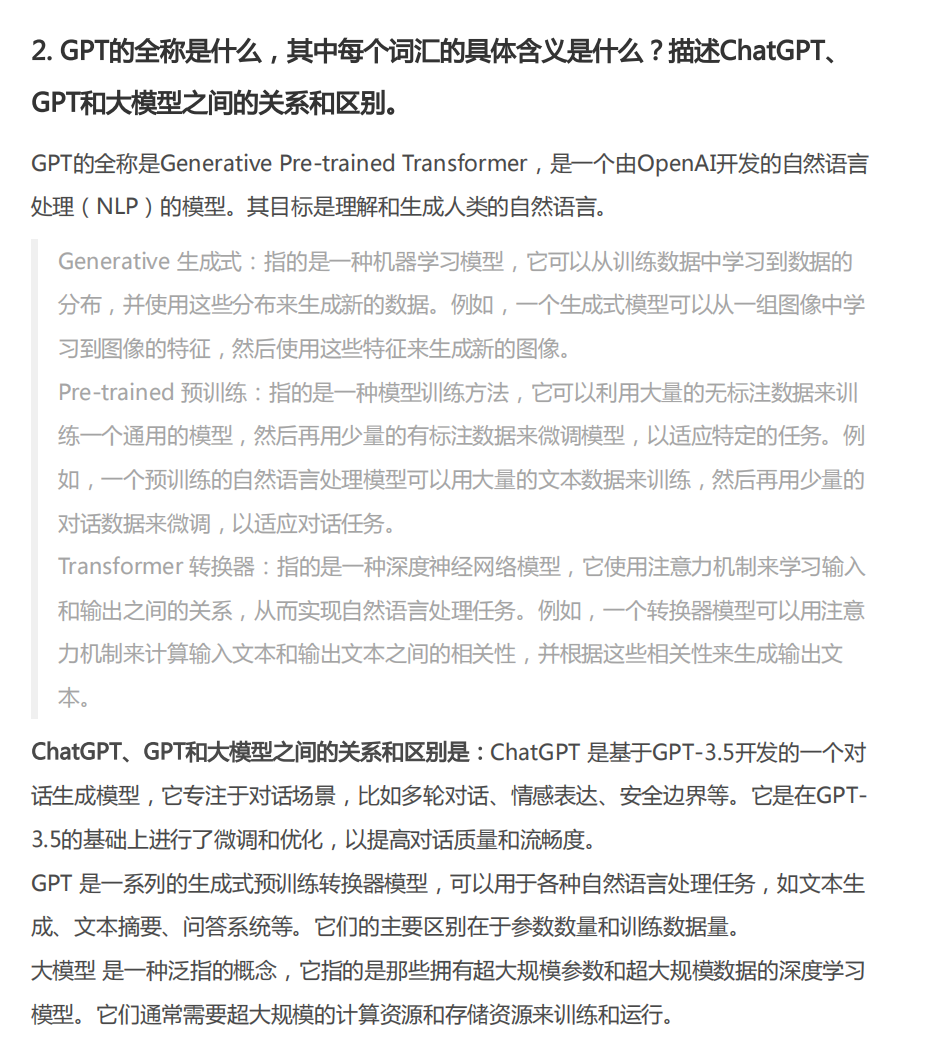

2. GPT的全称是什么,其中每个词汇的具体含义是什么?描述ChatGPT、GPT和大模型之间的关系和区别。

3.如何定义AGI这一概念?AIGC代表的是什么概念或技术?

4.对于OpenAI来说,语言类大模型有哪些,其基座模型是什么?

5.OpenAI的文本向量化模型是用来做什么的?

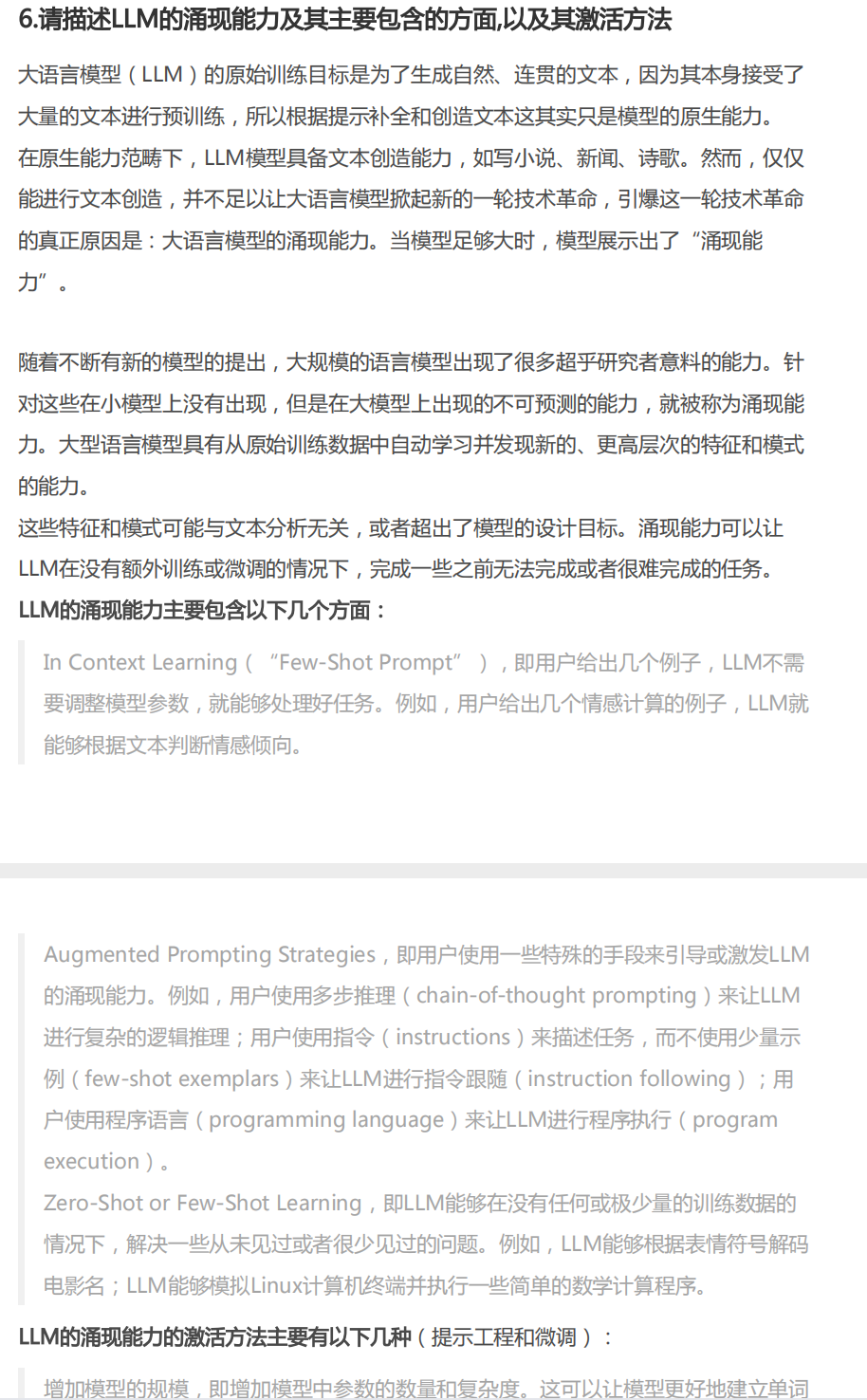

6.请描述LLM的涌现能力及其主要包含的方面,以及其激活方法

7.定义提示工程是什么?

8.在提示工程中,主要采用哪些方式添加提示?

9.微调的定义是什么?

10.当微调与提示工程进行比较时,优势和劣势是什么?

11.微调和提示工程在应用场景中的关系和联系是什么?

12.请描述代码提示工程的核心概念

13.什么是Zero-shot提示方法

14.什么是Few-shot提示方法

15.阐述One-shot和Few-shot提示策略及其应用场景

16.什么是思维链?思维链的本质是什么

17.什么是逐步Zero-shot

18.定义Zero-shot-CoT提示策略并描述其应用方法

19.解释Few-shot-CoT提示策略及其实际使用方式

20.什么是模型的推理能力?

21.LtM提示策略是如何分阶段进行的

22.Few-shot-LtM策略包含哪些主要阶段及其职责

干货合集十:LLM大模型面试准备题库及答案(下)(含答案)

1.相比较于llama而言,llama2有哪些改进,对于llama2是应该如何finetune?

2、什么是多模态,多模态中常见的SOTA模型有哪些?

3、什么是stable diffusion,请你介绍一下diffusion模型的原理?

4、instructGPT的原理,讲讲RLHF、SFT、和reward。

5、讲讲T5和Bart的区别,讲讲Bart的DAE任务。

6、讲讲Bart和Bert的区别。

7、对比学习负样本是否重要?负样本构造成本过高应该怎么解决?

8、介绍一下lora的原理和ptuning的原理。

9.aigc方向国内的典型研究机构以及代表性工作有哪些?

10.什么是langchain,原理是什么,有什么应用?

干货合集十一:NLP常见面试题及答案汇总 (含答案)

一 、基础问题

1. NLP有哪些常见任务

2. 请介绍下你知道的文本表征的方法(词向量)。

3. 如何生成句向量?

4. 如何计算文本似度

5. 样本不平衡的解决方法?

6. 过拟合有哪些表现,怎么解决?

7. 用过 jiaba 分词吗,了解原理吗

8. 了解命名实体识别吗?通常用什么方法,各自有什么特点

9. 了解HMM和CRF吗?

10. 了解RNN吗,LSTM呢,LSTM相对RNN有什么特点

11. 会用正则表达式吗?re.match() 和 re.search() 有什么区别?

二 进阶问题

1. elmo、GPT、bert三者之间有什么区别?

2. 了解BERT?讲一下原理?有用过吗?

3. word2vec和fastText对比有什么区别

4. LSTM时间复杂度,Transformer 时间复杂度

5. 如何减少训练好的神经网络的推理时间?

干货合集十二:NLP/Transformer/BERT/Attention面试问题与答案 (含答案)

一、BERT相关问题(15个)

二、Transformer相关问题(8个)

三、后BERT相关问题(6个)

四、Self Attention相关问题(6个)

五、Norm相关问题(8个)

干货合集十三:小红书/抖音/蚂蚁/寒武纪/Boss直聘NLP大模型社招面经汇总

(每一场面试都包含详细的面试问题以及参考答案)

一、整体面试总结

二、面经-小红书

小红书一面:

小红书二面:

三、面经-抖音

抖音一面

抖音二面

抖音三面

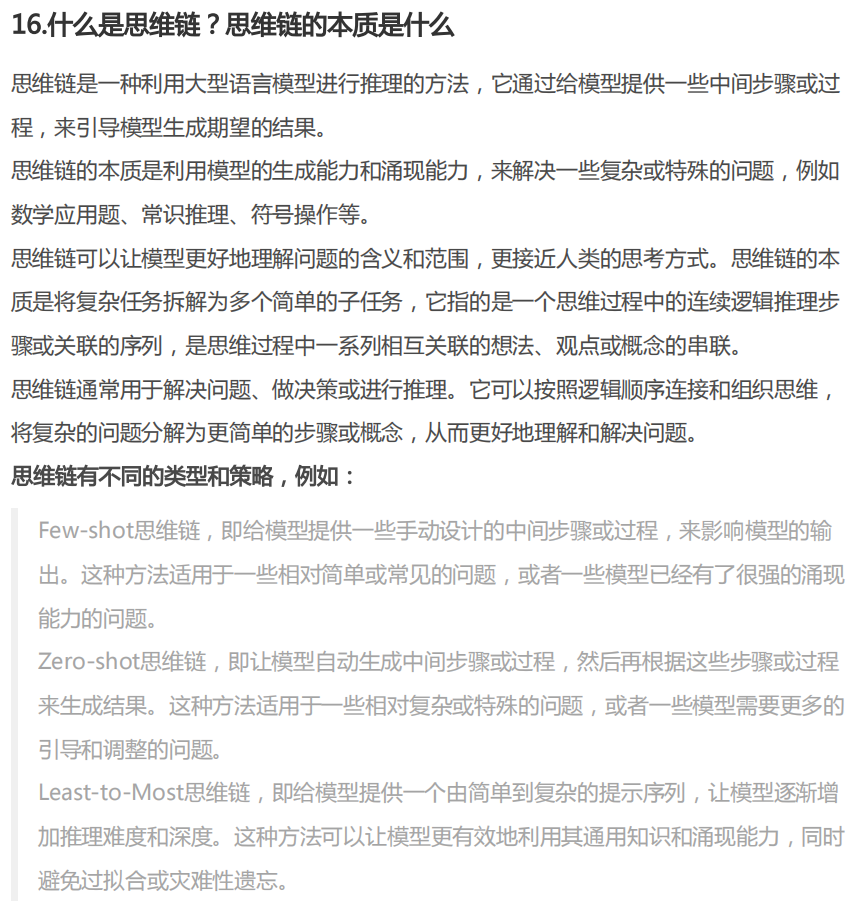

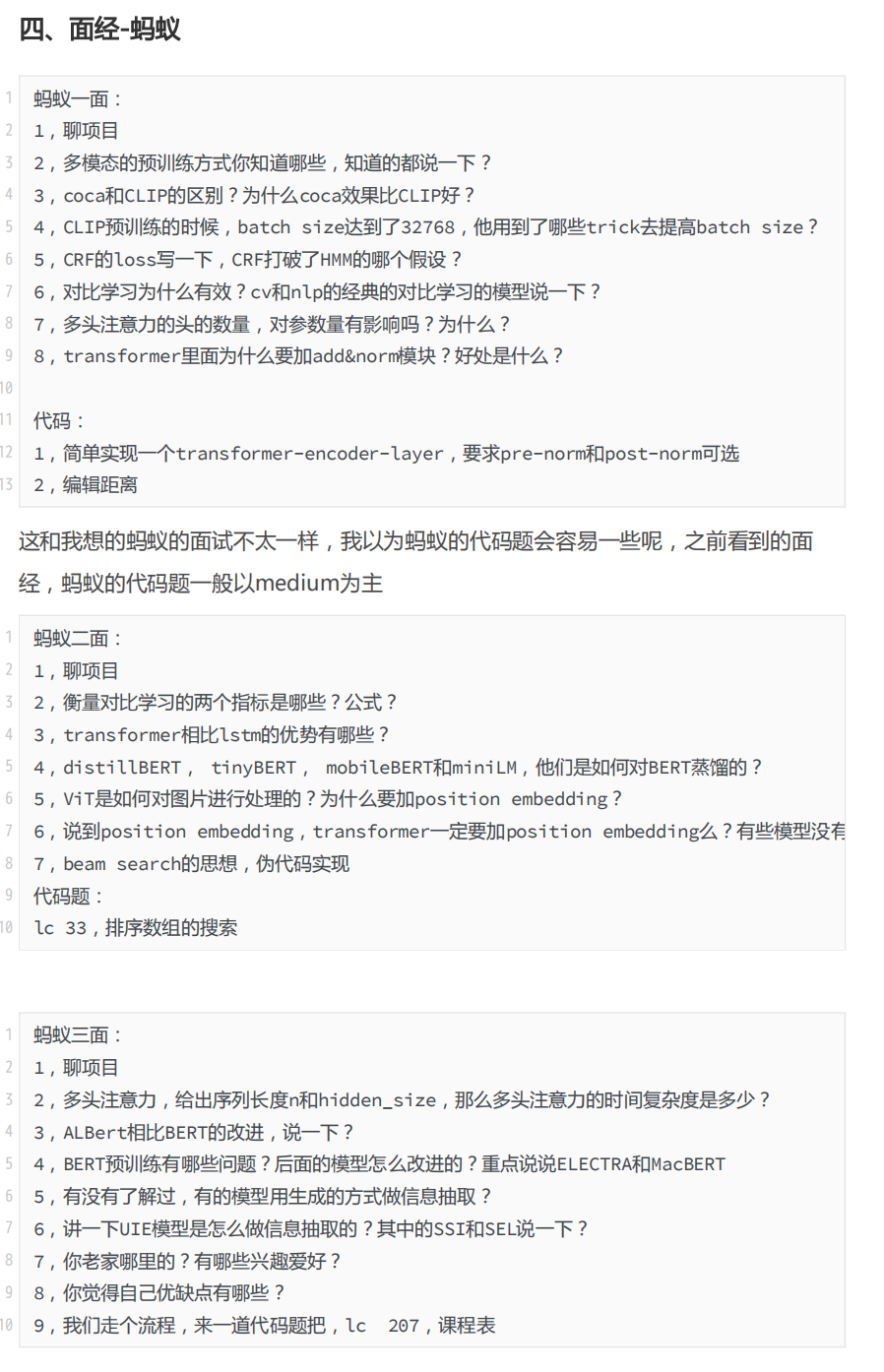

四、面经-蚂蚁

蚂蚁一面:

蚂蚁二面:

蚂蚁三面:

五、面经-寒武纪

寒武纪一面:

寒武纪二面:

六、面经-某金融公司

金融公司一面:

金融公司二面:

七、面经-boss直聘

BOSS一面:

BOSS二面:

面试合集十四:货拉拉NLP工程师面试题及答案 (含答案)

1.词向量平均法做分类的优劣势是什么

2.词向量的基础上如何做优化

3.Bert模型和Transformer模型之间的关系

4.Bert模型中有哪些预训练的任务

5.Bert模型的做句向量的缺陷

6.如何解决Bert句向量的缺陷

干货合集十五:腾讯/阿里/携程实习详细NLP面试题面经

(每一场面试都包含详细的面试问题以及参考答案)

一、阿里(已offer)

一面:电话面试(30min)

二面:电话面试(30min)

反问:

二、携程(已offer)

一面:线下面试(1h)

二面:线下面试(40min)

三、腾讯(HR面结束)

一面:腾讯会议面试(30min)

二面:腾讯平台面试(1h20min)

HR面:腾讯会议面试(18min)

反问:

干货合集十六:腾讯NLP算法面试题整(抽象归纳多篇腾讯面经)

编程&数学基础(25个)

项目深度(14个)

基础知识(48个)

开放题(17个)

干货合集十七:阿里巴巴NLP算法面试题整(抽象归纳多篇阿里巴巴面经)

编程&数学基础(21个)

项目深度(11个)

基础知识(37个)

开放题(18个)

干货合集十八:百度NLP算法面试题整(抽象归纳多篇百度面经)

编程题(11个)

项目深度(2个)

基础知识(32个)

开放题(6个)

都是移动互联网产品经看,随便截几张预览图片:

随便截图的示例一:

随便截图的示例二:

随便截图的示例三:

随便截图的示例四:

随便截图的示例五:面经

👉AI大模型学习路线汇总👈

大模型学习路线图,整体分为7个大的阶段:(全套教程文末领取哈)

第一阶段: 从大模型系统设计入手,讲解大模型的主要方法;

第二阶段: 在通过大模型提示词工程从Prompts角度入手更好发挥模型的作用;

第三阶段: 大模型平台应用开发借助阿里云PAI平台构建电商领域虚拟试衣系统;

第四阶段: 大模型知识库应用开发以LangChain框架为例,构建物流行业咨询智能问答系统;

第五阶段: 大模型微调开发借助以大健康、新零售、新媒体领域构建适合当前领域大模型;

第六阶段: 以SD多模态大模型为主,搭建了文生图小程序案例;

第七阶段: 以大模型平台应用与开发为主,通过星火大模型,文心大模型等成熟大模型构建大模型行业应用。

👉大模型实战案例👈

光学理论是没用的,要学会跟着一起做,要动手实操,才能将自己的所学运用到实际当中去,这时候可以搞点实战案例来学习。

👉大模型视频和PDF合集👈

观看零基础学习书籍和视频,看书籍和视频学习是最快捷也是最有效果的方式,跟着视频中老师的思路,从基础到深入,还是很容易入门的。

👉学会后的收获:👈

• 基于大模型全栈工程实现(前端、后端、产品经理、设计、数据分析等),通过这门课可获得不同能力;

• 能够利用大模型解决相关实际项目需求: 大数据时代,越来越多的企业和机构需要处理海量数据,利用大模型技术可以更好地处理这些数据,提高数据分析和决策的准确性。因此,掌握大模型应用开发技能,可以让程序员更好地应对实际项目需求;

• 基于大模型和企业数据AI应用开发,实现大模型理论、掌握GPU算力、硬件、LangChain开发框架和项目实战技能, 学会Fine-tuning垂直训练大模型(数据准备、数据蒸馏、大模型部署)一站式掌握;

• 能够完成时下热门大模型垂直领域模型训练能力,提高程序员的编码能力: 大模型应用开发需要掌握机器学习算法、深度学习框架等技术,这些技术的掌握可以提高程序员的编码能力和分析能力,让程序员更加熟练地编写高质量的代码。

👉获取方式:

😝有需要的小伙伴,可以保存图片到wx扫描二v码免费领取【保证100%免费】🆓

2957

2957

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?