最近几年人工智能爆火,除了AI对话,目前AI作图也很火,比起收费的Midjourney,还有一个超级好用的开源****免费AI作图项目:Stable Diffusion(简称SD),通过训练模型让它学会生成图片。

B站UP主@秋葉aaaki 大佬基于SD制作了novelai-webui,内置了运行所需要的环境还有各种插件,即开即用,大大方便 新手使用。

为了防止部分小伙伴看到之后嫌弃麻烦,先来看几个效果,这都是在课代表笔记本电脑里面生成的👇

01

配置要求

由于图片是在本地生成的,对电脑配置要求较高,所以要先检查电脑配置:

打开任务管理器的性能选项,这个工具适用于英伟达的显卡(AMD不行),显存至少要4GB以上****,电脑内存16GB或以上。

如果不满足配置要求,会无法使用或者很慢!

02

使用介绍

①解压课代表提供的压缩包,共有10GB大小,文件夹所在路径不要有中文名,第一次运行时以管理员身份运行。

②打开以后,点击一键启动即可,会弹出这些窗口,还有自动使用记事本打开的一个文本文件,粘贴那句话再保存文件就算是同意许可协议了。

③然后软件会调用浏览器打开网页,就可以使用了,输入提示词(Prompt)和反向提示词(Negative prompt),再选择迭代步数(50以上)、图片尺寸(也可以大一点)和采样方法,就可以生成了!

举例:

- 提示词:best quality, masterpiece, highres, 1girl,china dress,Beautiful face

- 反向提示词:NSFW, lowres,bad anatomy,bad hands, text, error, missing fingers,extra digit, fewer digits, cropped, worstquality, low quality, normal quality,jpegartifacts,signature, watermark, username,blurry,bad feet

- Sampling steps: 50

- Sampler: DPM++ SDE Karras or DDIM

④默认的模型是动漫风格的,可以下载不同的模型生成不同类型的图片。

⑤下载模型有两种方法,一个是从软件模块管理里面,刷新列表,然后找到要下载的模型点击下载,如果下载不动,就复制链接到浏览器下载。

⑥又或者在一些网站下载模型文件,比如:https://civitai.com/(需要特殊的网络手段,直接是打不开的),获取到的下载链接不需要特殊网络就可以直接下载。

⑦下载好的模型文件,通过软件的添加模型导入即可。

⑧然后重启应用,在左上角选择模型就可以应用了。

这里直接将该软件分享出来给大家吧~

这份完整版的SD整合包已经上传CSDN,朋友们如果需要可以微信扫描下方CSDN官方认证二维码免费领取【保证100%免费】

1.stable diffusion安装包

随着技术的迭代,目前 Stable Diffusion 已经能够生成非常艺术化的图片了,完全有赶超人类的架势,已经有不少工作被这类服务替代,比如制作一个 logo 图片,画一张虚拟老婆照片,画质堪比相机。

最新 Stable Diffusion 除了有win多个版本,就算说底端的显卡也能玩了哦!此外还带来了Mac版本,仅支持macOS 12.3或更高版本。

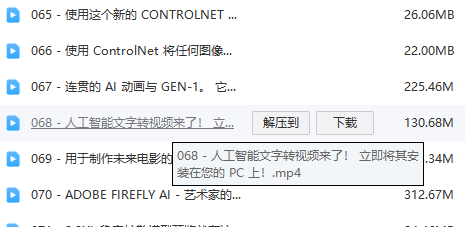

2.stable diffusion视频合集

我们在学习的时候,往往书籍源码难以理解,阅读困难,这时候视频教程教程是就很适合了,生动形象加上案例实战,一步步带你入坑stable diffusion,科学有趣才能更方便的学习下去。

3.stable diffusion模型下载

stable diffusion往往一开始使用时图片等无法达到理想的生成效果,这时则需要通过使用大量训练数据,调整模型的超参数(如学习率、训练轮数、模型大小等),可以使得模型更好地适应数据集,并生成更加真实、准确、高质量的图像。

4.stable diffusion提示词

提示词是构建由文本到图像模型解释和理解的单词的过程。可以把它理解为你告诉 AI 模型要画什么而需要说的语言,整个SD学习过程中都离不开这本提示词手册。

5.SD从0到落地实战演练

如果你能在15天内完成所有的任务,那你堪称天才。然而,如果你能完成 60-70% 的内容,你就已经开始具备成为一名SD大神的正确特征了。

这份完整版的SD整合包已经上传CSDN,朋友们如果需要可以微信扫描下方CSDN官方认证二维码免费领取【保证100%免费】

747

747

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?