简单认识

注意力机制可以增强神经网络输入中数据的一部分权重,减少其他部分的权重,将神经网络的关注点聚焦于数据中的一小部分,所以会降低神经网络中的收敛时间,提高神经网络的效率。在这里用聚焦(focus)理解可能会更好。

例子

具体为假设有一个索引排列好的(token)序列,而且对于每一个标记

,神经网络都会有一个相应满足

的权重

(非负软权重)(但是这里是否还有硬权重,不清楚),每一个标记都对于一个词嵌入得到的向量

,而且求加权平均

就是注意力机制的输出结果。

此外还可以通过查询-键 机制(query-key)计算软权重,而且对于每个标记的词嵌入,我们计算对于的查询向量和对于的键向量

(一一对应的关系),然后再计算点积的softmax函数(概念:Softmax是一种激活函数,它可以将一个数值向量归一化为一个概率分布向量,且各个概率之和为1)之后就可以得到相对应的权重。

实例

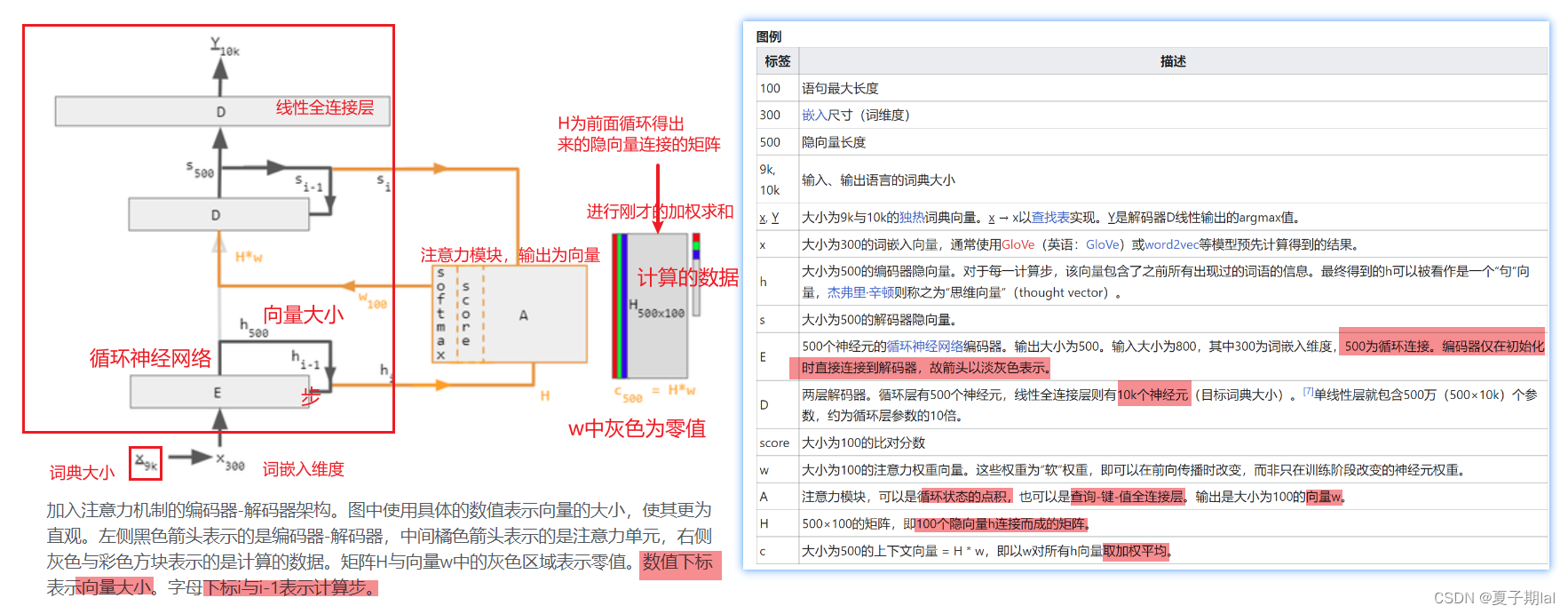

下列为基本框架为编码器-解码器模型,而且外加了一个注意力单元,而且注意力单元知识循环状态的点积运算,不需要训练,但是在实际运用过程中需要三个完全连接的神经网络层,而且分别被称为查询(query),键(key),值(value)。

代码

class EncoderDecoder(nn.Module):

def __init__(self,encoder,decoder,**kwargs):

super(EncoderDecoder, self).__init__()

self.encoder = encoder

self.decoder = decoder

def forward(self,enc_X,dec_X,*args):

enc_outputs = self.encoder(enc_X,*args)

dec_state = self.decoder.init_state(enc_outputs,*args)

return self.decoder(dec_X,dec_state)

1007

1007

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?