ChatGPT到底是泡沫,

-----还是AI真的来了?

一个交互界面,可以解决各种各样的问题?在ChatGPT横空出世之前,很多人可能想都不敢想,甚至有人现在也会想,当下的ChatGPT也做不到,对吧!在算力,算法,数据的汇聚、加工、标注,不断的迭代,应用逻辑巧妙的设计等等的加持下,诞生了火出圈的ChatGPT。ChatGPT各种问题,网上文章很多,大家自补,这里我们主要论述ChatGPT到底是泡沫,还是AI真的来了?对于这个问题,我们通过深层次的技术分析,阐述chatGPT的优缺点,来看真正的解决方案是什么。

一、chatGPT是什么

2022年11月30日,OpenAI公布了一个名为ChatGPT的对话聊天机器人模型,它通过对话的方式进行交互。

chatGPT主要基于GPT+RLHF,GPT-3.5可以认为是一个非常大的预训练好的语言模型(LM),RLHF是一种基于人工反馈的强化学习方法,来优化语言模型(LM)。总结起来,chatGPT就是大模型+人工反馈强化学习。可以说chatGPT之所以大火,RLHF很重要。GPT3当时就引起了关注,但没这么好,也没这么火。

GPT(Generative Pre-trained Transformer)是一种生成式预训练语言模型,采用无监督的深度学习的方法,预训练一套语言模型。RLHF(Augmenting Reinforcement Learning with Human Feedback)是基于人工反馈的强化学习技术,利用训练好的奖励模型,多轮迭代,来优化预训练语言模型。

GPT的生成式语言模型的训练是基于上下文信息去预测下一个词,然后计算每个词的损失,这种方式不能很好的从完整的输出层面对模型进行优化。而人工反馈的方法,可以从整体上对模型的输出进行评价,要比“基于上下文预测下一个词”的损失函数更符合真实场景。由此可见,RLHF的引入是非常重要的。但chatGPT本质上还是对promot(提示/输入)进行概率预测的模型,是条件、概率的关联。

chatGPT主要任务目标包括:分类、翻译、阅读理解、问答、填空、新闻/小说等内容生成、代码生成及审核等。

二、chatGPT原理

上面提到,ChatGPT基于GPT(生成式预训练语言模型)和RLHF(基于人工反馈的强化学习),这里我们重点从这两方面来分析chatGPT的结构及其原理。

1、GPT架构及其原理

GPT可以简单理解为一套数学模型,数据输入给GPT,GPT输出一套数据。例如:输入一段话,GPT模型根据语言/语料概率来自动生成回答的每一个字(词句)。即利用已经说过的一段话作为输入条件,预测下一个时刻不同语句甚至语言集合出现的概率分布。

GPT是生成式预训练语言模型,到目前,有GPT-1、GPT-2、GPT-3三个版本。三个版本首先,都是用无监督的方法,即在大量无标注的语料数据中,预训练出一个与下游任务无关的模型,三个版本在这里的主要区别是模型的参数越来越大。其次,在使用阶段,三个版本分别试验了在具体任务中通过任务数据微调模型、不通过具体任务数据来微调模型以及通过少量任务数据交互来解决具体任务应用问题。

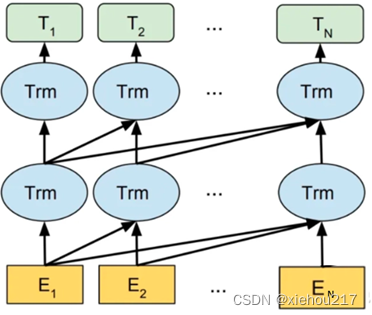

GPT模型架构如图1,它采用的以Transformer为核心结构的模型,其中Trm是一个Transformer结构,一个Trm可以简单理解为一套数据流转的结构。

图1 GPT系列的模型架构

GPT-1的完整结构如图2,其中左边是GPT使用的12层Transformer结构,右图是预训练模型根据不同任务进行微调的结构。这里重点是构建了一套具有强大自然语言理解能力的与任务无关的单模型框架:生成式预训练和判别式微调。预训练与微调的定义如下:

预训练:用标准的语言模型的目标函数,即似然函数,根据前k个词预测下一个词的概率。GPT预训练阶段其作者使用语言模型(LM)的训练方式,模型使用的是transformer的变体,即多层transformer-decoder。

微调:用的是完整的输入序列+标签。目标函数=有监督的目标函数+λ*无监督的目标函数。

通过上面可以看出,对预训练好的模型,叠加对应下游任务的层,就可实现不同下游任务。预训练语言模型能够充分利用大规模的无标注数据学习通用的语言模型,然后再使用下游任务的少量有标注数据进行模型微调,来使具体的任务获得较好的效果。

图2 GPT-1模型架构

GPT-2、GPT-3主要是增大了模型的容量,并去掉了监督微调。其作者认为大的模型应该能学习出多任务的能力,而不需要大的标注数据集来解决具体的任务问题,当然到此为止,实际上还没有达到预期。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

3394

3394

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?