论文:《Fast R-CNN》

此论文的总结也是和以前的sppnet以及rcnn论文总结一样参考了前人的博客来总结的。

1. 概述

论文是由R-CNN大牛作者rbg即R-Cnn和sppnet在2015提出发表于ICCV2015,Fast Rcnn是加强版的SPPnet,Fast Rcnn相比于Rcnn在时间和性能上都做了改进。它避免对一幅图片的多个proposal分别计算CNN特征(大量的重复计算),而是对整幅图提取CNN特征之后,再划分对应proposal,从而提高了检测效率,同时对RCNN的pipeline方法做了一定整合,提升了检测性能。

2. r-cnn和sppnet缺点:

1) 训练的时候,pipeline是隔离的,先提取proposal,然后CNN提取特征,之后用SVM分类器,最后再做bbox regression。RCNN实现了end-to-end的joint training(提proposal阶段除外)。

2) 训练时间和空间开销大。RCNN中ROI-centric sampling的运算开销大,所以FRCN用了image-centric sampling的训练方式来通过卷积的share特性来降低运算开销。RCNN提取特征给SVM训练时候需要中间要大量的磁盘空间存放特征,FRCN去掉了SVM这一步,所有的特征都暂存在显存中,就不需要额外的磁盘空间了。

3) 测试时间开销大。依然是因为ROI-centric的原因,这点SPP-Net已经改进,然后FRCN进一步通过single scale testing和SVD分解全连接来提速。

SPPnet:

SPP已有一定的速度提升,它在ConvNet的最后一个卷积层才提取proposal,但是依然有不足之处。和R-CNN一样,它的训练要经过多个阶段,特征也要存在磁盘中,另外,SPP中的微调只更新spp层后面的全连接层,对很深的网络这样肯定是不行的。

在微调阶段谈及SPP-net只能更新FC层,这是因为卷积强调内容特征是线下计算的,从而无法再微调阶段反向传播误差。而在fast-RCNN中则是通过image-centric sampling提高了卷积层特征抽取的速度,从而保证了梯度可以通过SPP层(即ROIpooling层)反向传播。

3. Fast-Rcnn 贡献:

比R-CNN更高的检测质量(mAP);

把多个任务的损失函数写到一起,实现单级的训练过程;

在训练时可更新所有的层;

不需要在磁盘中存储特征;

解决方式具体即以下几点:

1. 训练的时候,pipeline是隔离的,先提proposal,然后CNN提取特征,之后用SVM分类器,最后再做bbox regression。FRCN实现了end-to-end的joint training(提proposal阶段除外)。

2. 训练时间和空间开销大。RCNN中ROI-centric的运算开销大,所以FRCN用了image-centric的训练方式来通过卷积的share特性来降低运算开销;RCNN提取特征给SVM训练时候需要中间要大量的磁盘空间存放特征,FRCN去掉了SVM这一步,所有的特征都暂存在显存中,就不需要额外的磁盘空间了。

3. 测试时间开销大。依然是因为ROI-centric的原因(whole image as input->ss region映射),这点SPP-Net已经改进,然后FRCN进一步通过single scale(pooling->spp just for one scale)testing和SVD(降维)分解全连接来提速。

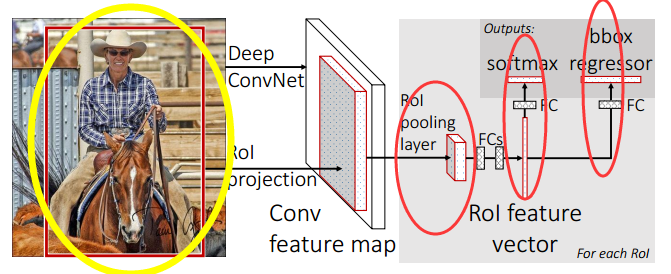

4. 整体框架

首先,输入的是一张完整图片和一组物体建议框(也叫RoIs)。然后对Conv feature map进行特征提取。每一个区域经过RoI pooling layer和FC layers得到一个固定长度的feature vector,这里需要注意的是,输入到后面RoI pooling layer的feature map是在Conv feature map上提取的,故整个特征提取过程,只计算了一次卷积。关于这一点的详细说明,大家可以看SPP net的论文,也可以看我前面的关于Spp-net论文笔记 ,虽然在最开始也提取出了大量的RoI,但他们还是作为整体输入进卷积网络的,我理解的最开始提取出的RoI区域只是为了最后的Bounding box 回归时使用,用来输出原图中的位置。

最后,这些特征向量在经过全接连层之后进入两个并列的输出层:

softmax layer:输出每一个RoI的概率分布;

bbox regressor:输出每一个种类的边界盒回归偏差;

整个结构是使用多任务损失的端到端训练(trained end-to-end with a multi-task loss),如下图所示:

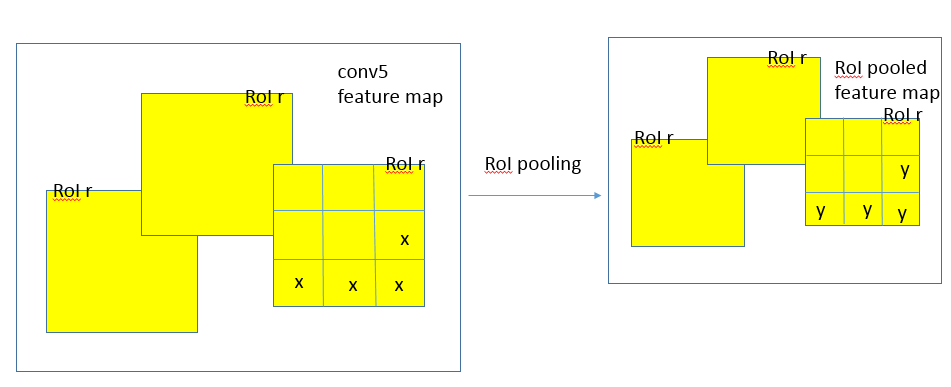

5. RoI pooling layer

这是SPP pooling层的一个简化版,只有一级“金字塔”,输入是N个特征映射和一组R个RoI,R>>N。N个特征映射来自于最后一个卷积层,每个特征映射都是H * W * C的大小。每个RoI是一个元组(n, r, c, h, w),n是特征映射的索引,n∈{0, … ,N-1},(r, c)是RoI左上角的坐标,(h, w)是高与宽。输出是max-pool过的特征映射,H’ * W’ * C的大小,H’≤H,W’≤W。对于RoI,bin-size ~ h/H’ x w/W’,这样就有H’W’个输出bin,bin的大小是自适应的,取决于RoI的大小。

Rol pooling layer的作用主要有两个:

- 将image中的rol定位到feature map中对应patch;

- 用一个单层的SPP layer将这个feature map patch下采样为大小固定的feature再传入全连接层。即RoI pooling layer来统一到相同的大小-> (fc)feature vector 即->提取一个固定维度的特征表示;

这里有几个细节:

- 对于某个rol,怎么求取对应的feature map patch?这个论文没有提及,笔者也觉得应该与spp-net的映射关系一致。

- 为何只是一层的SPP layer?多层的SPP layer不会更好吗?对于这个问题,可能是因为需要读取pretrain model来finetuning的原因,比如VGG就release了一个19层的model,如果是使用多层的SPP layer就不能够直接使用这个model的parameters,而需要重新训练了。

6. 从预训练的网络中初始化数据

有三种预训练的网络:CaffeNet,VGG_CNN_M_1024,VGG-16,他们都有5个最大池化层和5到13个不等的卷积层。用他们来初始化Fast R-CNN时,需要修改三处:

- 最后一个池化层被RoI pooling layer取代;

- 最后一个全连接层和softmax被替换成之前介绍过的两个兄弟并列的全连接层;

- 网络输入两组数据:一组图片和那些图片的一组RoIs;

7. 检测中的微调

前面说过SPPnet有一个缺点是只能微调spp层后面的全连接层,所以SPPnet就可以采用随机梯度下降(SGD)来训练。

Rcnn:

无法同时tuning在SPP layer两边的卷积层和全连接层

RoI-centric sampling:

从所有图片的所有RoI中均匀取样,这样每个SGD的mini-batch中包含了不同图像中的样本。(SPPnet采用)FRCN想要解决微调的限制,就要反向传播到spp层之前的层->(reason)反向传播需要计算每一个RoI感受野的卷积层,通常会覆盖整个图像,如果一个一个用RoI-centric sampling的话就又慢又耗内存。

Fast Rcnn:

改进了SPP-Net在实现上无法同时tuning在SPP layer两边的卷积层和全连接,image-centric sampling: (solution)mini-batch采用层次取样,先对图像取样,再对RoI取样,同一图像的RoI共享计算和内存。

另外,FRCN在一次微调中联合优化softmax分类器和bbox回归。

看似一步,实际包含了:多任务损失(multi-task loss)、小批量取样(mini-batch sampling)、RoI pooling层的反向传播(backpropagation through RoI pooling layers)、SGD超参数(SGD hyperparameters)。

Multi-task loss

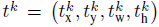

两个输出层,一个对每个RoI输出离散概率分布:

p=(P0,……..,PK)

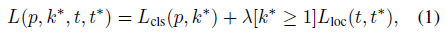

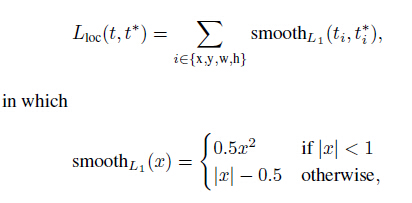

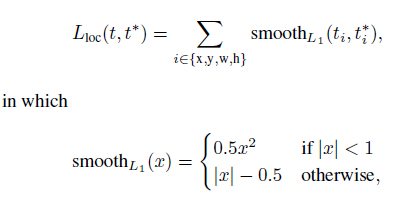

一个输出bounding box回归的位移:

k表示类别的索引,前两个参数是指相对于object proposal尺度不变的平移,后两个参数是指对数空间中相对于object proposal的高与宽。把这两个输出的损失写到一起:

k*是真实类别,式中第一项是分类损失,第二项是定位损失,L由R个输出取均值而来。

以下具体介绍:

对于分类loss,是一个N+1路的softmax输出,其中的N是类别个数,1是背景。为何不用SVM做分类器了?在5.4作者讨论了softmax效果比SVM好,因为它引入了类间竞争。(笔者觉得这个理由略牵强,估计还是实验效果验证了softmax的performance好吧 ^_^)。

对于回归loss,是一个4xN路输出的regressor,也就是说对于每个类别都会训练一个单独的regressor的意思,比较有意思的是,这里regressor的loss不是L2的,而是一个平滑的L1,形式如下:

作者这样设置的目的是想让loss对于离群点更加鲁棒,控制梯度的量级使得训练时不容易跑飞。最后在5.1的讨论中,作者说明了Multitask loss是有助于网络的performance的。

Mini-batch sampling

在微调时,每个SGD的mini-batch是随机找两个图片,R为128,因此每个图上取样64个RoI。从object proposal中选25%的RoI,就是和ground-truth交叠至少为0.5的。剩下的作为背景。

分层数据

在调优训练时,每一个mini-batch中首先加入N张完整图片,而后加入从N张图片中选取的R个候选框。这R个候选框可以复用N张图片前5个阶段的网络特征。实际选择N=2, R=128->每一个mini-batch中首先加入2张完整图片,而后加入从2张图片中选取的128个候选框。这128个候选框可以复用2张图片前5个阶段的网络特征。

训练数据构成

N张完整图片以50%概率水平翻转。

R个候选框的构成方式如下:

类别 比例 方式

前景 25% 与某个真值重叠在[0.5,1]的候选框

背景 75% 与真值重叠的最大值在[0.1,0.5)的候选框

Backpropagation through RoI pooling layers

RoI pooling层计算损失函数对每个输入变量x的偏导数,如下:

y是pooling后的输出单元,x是pooling前的输入单元,如果y由x pooling而来,则将损失L对y的偏导计入累加值,最后累加完R个RoI中的所有输出单元。下面是我理解的x、y、r的关系:

8. Scale invariance

SPPnet用了两种实现尺度不变的方法:

- brute force (single scale):

直接将image设置为某种scale,直接输入网络训练,期望网络自己适应这个scale。 - image pyramids (multi scale):

生成一个图像金字塔,在multi-scale训练时,对于要用的RoI,在金字塔上找到一个最接近227x227的尺寸,然后用这个尺寸训练网络。

虽然看起来2比较好,但是非常耗时,而且性能提高也不对,大约只有%1,所以这篇论文在实现中还是用了1。

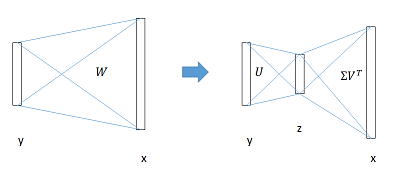

9. Truncated SVD for faster detection

在分类中,计算全连接层比卷积层快,而在检测中由于一个图中要提取2000个RoI,所以大部分时间都用在计算全连接层了。文中采用奇异值分解的方法来减少计算fc层的时间。具体来说,作者对全连接层的矩阵做了一个SVD分解,mAP几乎不怎么降(0.3%),但速度提速30%。

全连接层提速

分类和位置调整都是通过全连接层(fc)实现的,设前一级数据为x后一级为y,全连接层参数为W,尺寸u×v。一次前向传播(forward)即为:

y=Wx

计算复杂度为u×v。将W进行SVD分解,并用前t个特征值近似:

W=UΣVT

计算复杂度变为u×t+v×t。在实现时,相当于把一个全连接层拆分成两个,中间以一个低维数据相连。

2209

2209

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?