目录

面向对象分析方法举例:

Peter Coad的面向对象方法:

- 对象有“定义清晰的边界”

- 对象中封装有属性和行为

- 面向对象分析的五个核心概念:对象、属性、结构、服务、主题

常用结构:

- 继承/一般-特殊结构:基于继承关系的分类层次结构

- 整体-部分结构:用于描述对象间的组合关系

服务建模:

- 瞬时服务

- 计算服务

- 监控服务

- 在类图中用带箭头的虚线表示一个对象引用另一个对象的服务

面向对象的分析方法学:

面向对象分析常用术语对照表:

CRC卡片分拣法

- 过滤对象类

- 类筛选

- 类识别

- 识别类的功能职责

- 识别类交互协作关系

类图建模

-

类

-

对象

-

类属性定义

-

类关系:

-

关联关系的种类(自返关联、二元关联、N元关联)、关联关系的维度、关联类

- 聚合和组合关系

- 继承/泛化关系

-

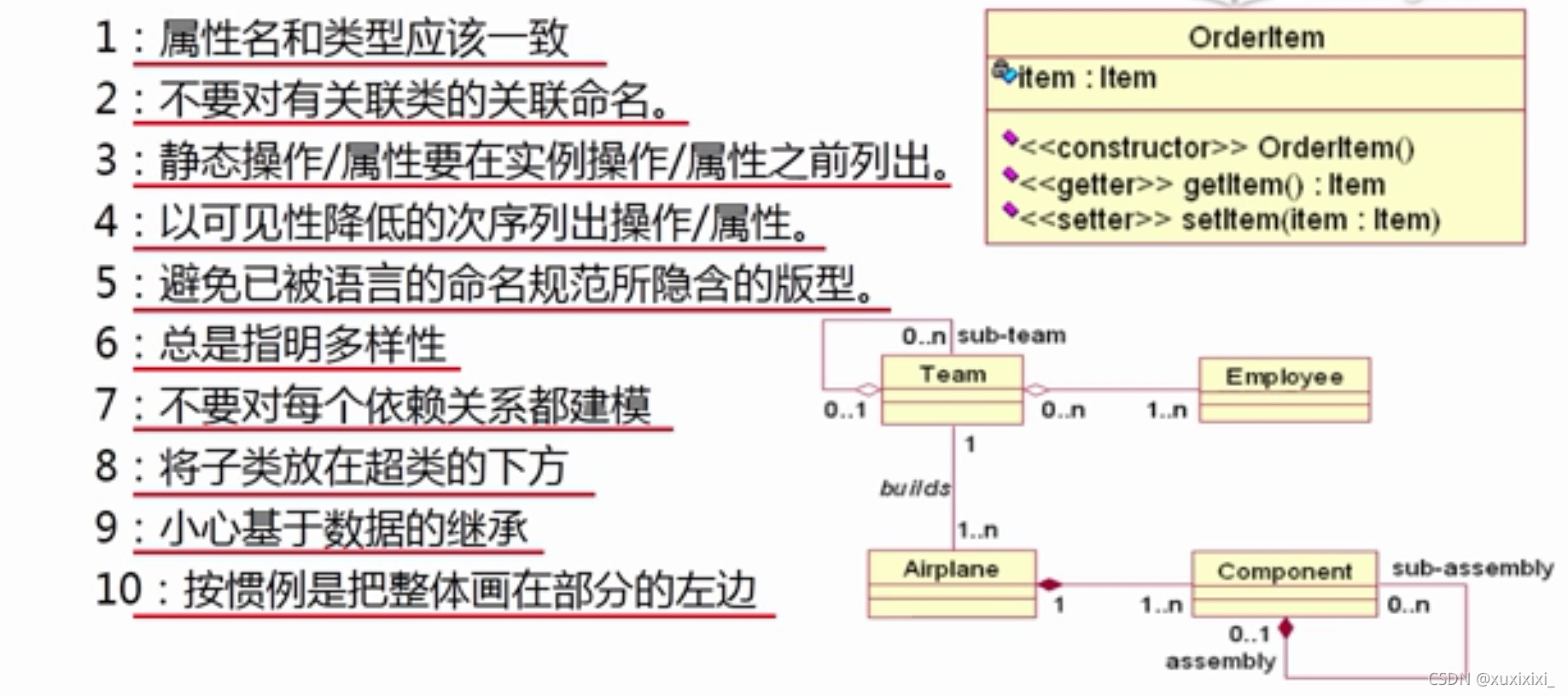

类图建模风格

本文详细介绍了面向对象分析的方法,包括Peter Coad的面向对象方法,强调了对象的边界、属性和行为的封装。同时,讨论了常用的结构如继承和整体-部分关系,并阐述了服务建模中的瞬时、计算和监控服务。此外,文章还讲解了面向对象分析的常用术语,并通过CRC卡片分拣法识别和定义类的功能职责及交互关系。最后,深入探讨了类图建模,涵盖了类、对象、属性、关系等要素。

本文详细介绍了面向对象分析的方法,包括Peter Coad的面向对象方法,强调了对象的边界、属性和行为的封装。同时,讨论了常用的结构如继承和整体-部分关系,并阐述了服务建模中的瞬时、计算和监控服务。此外,文章还讲解了面向对象分析的常用术语,并通过CRC卡片分拣法识别和定义类的功能职责及交互关系。最后,深入探讨了类图建模,涵盖了类、对象、属性、关系等要素。

1044

1044

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?