摘要:本文提出了一种生成式对抗网络来去除视觉雾霾,称为HRGAN。HRGAN由生成网络和鉴别网络组成。一个联合估计传输图、大气光和无雾图像的统一网络(称为UNTA)被提议作为HRGAN的生成器网络。HRGAN不是通过最小化像素级损失来优化,而是通过最小化由鉴别器网络产生的像素级损失、感知损失和对抗损失组成的新型损失函数来优化。我们的网络由两个网络组成:一个生成器网络和一个鉴别器网络。鉴别器网络产生对抗损失。对抗性损失将恢复后的无雾图像推向真实的无雾图像。经典的基于模型的图像去雾算法包括三个阶段:1)估计传输映射;2)估算大气光;3)利用大气散射模型对透射图和大气光进行处理,恢复无雾图像。这样一个单独的方案并不能保证得到最优的结果。相反,UNTA同时进行透射图估计和大气光估计,得到联合最优解。在合成图像数据库和真实图像数据库上的实验结果表明,HRGAN算法在有效性和效率方面都表现出良好的性能。

1.主要贡献

我们提出了HRGAN,它是一种基于GAN的图像去雾网络。与以往基于CNN的方法相比,HRGAN的有效损耗包括像素级损耗、基于VGG16网络特征图计算的感知损耗和鉴别器网络产生的对抗损耗。提出了一种能够同时估计透射图和大气光的UNTA作为HRGAN的发生器网络。与以往基于模型的图像去雾方法相比,该方法具有获得联合最优解的能力。(3) HRGAN不仅能产生卓越的无雾图像,而且执行效率很高。

2.去雾模型

2.1网络结构

该网络由两个网络组成:一个生成网络和一个鉴别网络。

图1

1) Generator Network Architecture: 生成网络的目标是生成无雾的图像。生成网络以模糊图像为输入,生成无模糊图像。如图1的上半部分所示,生成器网络由传输图模块、大气光模块和处理模块三部分组成。

a)传输图模块:传输图模块的任务是估算传输图。传输映射模块体系结构如图2所示。扩展卷积在语义分割中取得了很大的成功。在此基础上,利用三个不同扩张因子的并行扩张卷积层提取多尺度特征。已知不同的膨胀因子可以提取不同尺度的特征。当扩张因子为1、2、3时,传输图体系结构的3个平行分支可分别提取小尺度、中尺度和大尺度特征。每个膨胀因子提取的特征在不同的分支中处理,并融合生成最终结果。每个卷积层之后都使用池化层和上采样层。池化层的下采样因子为2。上采样层的上采样因子为2。在最后的卷积层中,利用1 × 1卷积滤波器对多分支扩张卷积产生的多尺度特征图进行线性变换。与传统卷积滤波器相比,扩张卷积滤波器的网络参数要少得多。例如,传统的7×7卷积滤波器的接收域为7×7。相比之下,3×3放大因子为3的放大卷积滤波器具有相同的接收域。每个传统卷积滤波器的参数数为49。相比之下,每个扩张卷积滤波器的参数数只有9个。

图2

b)大气光模块:大气光模块的目的是估计式中的大气光A。如图3所示,大气光模块由一个卷积层、一个s型激活层和一个池化层组成。W和H是输入图像的尺寸。卷积滤波器的大小为h×w,卷积步幅固定为1像素,填充为0像素。Max-pooling在(W−(W−1))× (H−(H−1))窗口上执行。

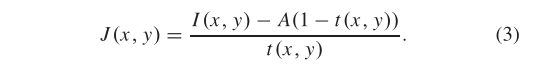

c)处理模块:无雾图像J(x, y)可以表示

透射图模块和大气光模块分别生成透射图t(x, y)和大气光A。处理模块的目的是将透射图t(x, y)、大气光A和朦胧图像I (x, y)结合起来,从式(3)中还原出无雾图像J(x, y)。

图3

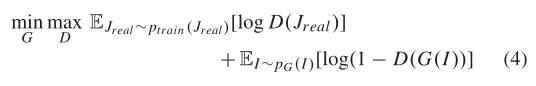

2)鉴别器网络架构:利用鉴别器网络来区分生成的无雾图像和真实图像。相反,利用生成器网络来欺骗鉴别器网络。本文通过求解最小-最大值问题,交替更新生成器网络和鉴别器网络:

其中,I表示输入朦胧图像,Jreal为真实无朦胧图像,G(•)表示生成器网络,D(•)为鉴别器网络。鉴别器网络的体系结构如图1底部所示。它由包含3 × 3卷积滤波器的5个卷积层、LeakyRELU激活层、批处理归一化层、两个全连接层和sigmoid激活层组成。5个卷积层的输出通道数分别为64、64、128、256、256。在这五个卷积层之后,又有两个完全连接的层:第一个层有512个通道,第二个层是双向分类,因此包含2个通道(一个用于真实无雾图像,另一个用于生成的无雾图像)。

2.2损失函数

基于像素的欧几里德损失、对抗损失和感知损失构成损失函数。损失函数L表示为:

其中,L E为像素级欧氏损失,L A为来自判别器网络的对抗性损失,L P为感知损失,λA和λP分别为对抗性损失和感知损失的权值。

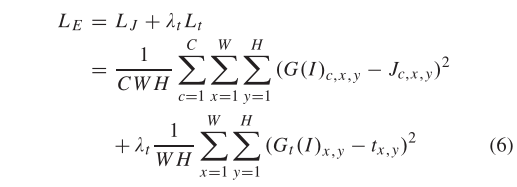

2.2.1欧几里得损失

像素级欧氏损耗由两部分组成,一是生成的无雾图像与其对应的地真图像之间的欧氏距离,二是估计的传输图与其对应的地真传输图之间的欧氏距离。像素级欧几里得损失计算如下:

式中I为输入雾天图像,L J为无雾图像的损耗,Lt为透射图的损耗,λt为Lt的权值。C, W, H是输入图像的尺寸。c, x, y是输入图像的位置。函数G(•)和Gt(•)分别生成无雾图像和透射图。

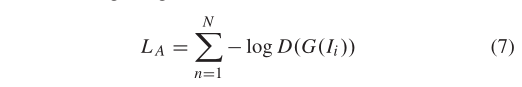

2.2.2对抗损失

对抗性损失的任务是使生成器网络生成的无雾图像更接近真实无雾图像。在训练生成器网络时,最小化最小值问题使log(1−D(G(I))最小。在训练阶段开始时,log(1−D(G(I))可以饱和。由于log(D(G(I)))在训练阶段可以提供更强的梯度,所以我们将log(D(G(I))最大化来训练生成器网络,在训练阶段,将对手的损失降到最低。对于N个训练图像,L A可定义为:

其中D(G(Ii))为去雾图像G(Ii)为真实无雾图像的概率。

2.2.3感知损失

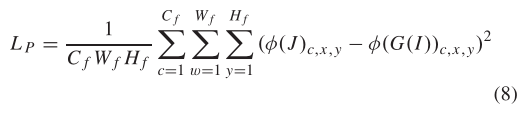

基于相关网络的高级特征提取的感知损失被广泛应用于图像超分辨率。此外,知觉损失比像素损失更有效地测量图像的视觉相似性。因此我们定义了一种感知损失,以增加恢复后的无雾图像和真实图像之间的感知相似性。感知损失可以写成:

其中,C f、W f、H f是VGG-16网络中各自特征映射的维数,φ的作用是从VGG-16网络中获取特征映射。

2.3最优化

我们利用带动量的随机梯度下降(SGD)优化透射图t(x, y)和大气光A。损失L对透射图t(x, y)和大气光A的梯度分别计算为:

3.实验结果

3.1数据集

我们利用NYU2深度数据集中的无雾图像及其对应的深度图合成了雾状图像。对于每幅图像,利用公式计算深度d(x, y)和散射系数β,得到透射图t(x, y)。然后,利用无雾图像、大气光a和透射图t(x, y),通过大气散射模型合成雾霾图像。假设大气光A在全球范围内是均匀的。设大气光A = [A, A, A],其中A∈[0.7,1.0],选取散射系数β∈{0.4,0.6,0.8,1.0,1.2,1.4,1.6}。从NYU2深度数据集中随机选择1000张hazfree图像。对于每幅无雾图像,我们利用随机采样的散射系数β和大气光A合成10幅训练图像。最后,我们有10000张训练图像。此外,利用SOTS数据集中的500幅室外合成雾霾图像作为室外测试合成数据集。这些测试图像都没有在训练阶段使用。

3.2实验比较

4.结论

我们提出了一种基于GAN的图像去雾网络,称为HRGAN。HRGAN由两个网络组成:生成器网络和鉴别网络。HRGAN的生成网络是一个统一的网络,可以联合估计透射图、大气光和无雾图像。在优化任务中,除了基于像素的损耗外,还利用了鉴别器网络产生的对抗损耗和感知损耗。实验结果表明,无论在合成图像还是真实图像上,HRGAN都达到了非常高的效率,优于目前的先进方法。

3370

3370

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?