一、pySpark环境准备

1、window配置python环境变量

window安装python,配置python环境变量。安装python后,在环境变量path中加入安装的路径,cmd中输入python,检验python是否安装成功。

注意:如果使用的是anaconda安装的python环境,建议安装python3.5.x版本,这个版本和spark1.6兼容。如何在anaconda中安装python3.5.x版本的python环境?参考文档:“Anaconda安装及使用.docx”

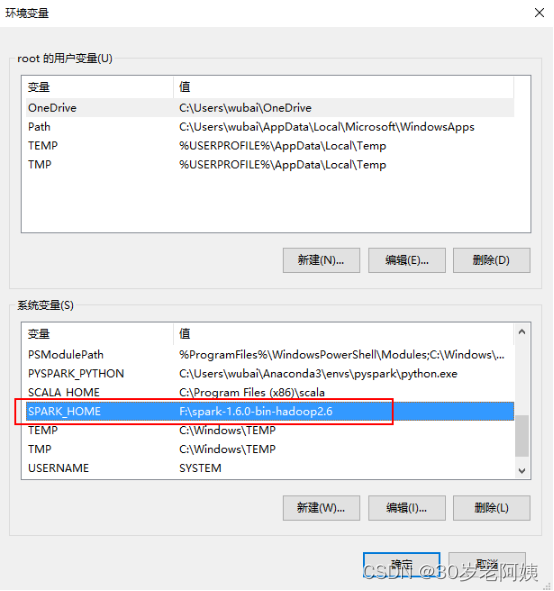

2、window Spark环境变量

window中配置Spark运行环境及Spark环境变量。

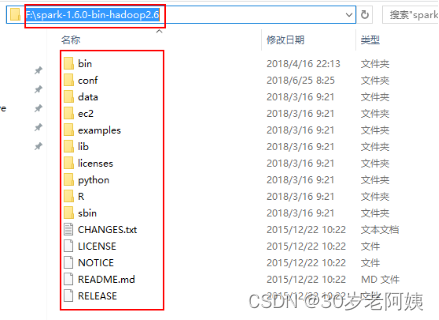

a).解压spark的安装包到磁盘目录

b).在环境变量中配置SPARK_HOME指定解压的路径,配置环境变量。

注意:解压spark安装包后,配置环境变量,一定配置到含有bin的外层。

3、python中安装py4j模块

在python环境中安装py4j模块(python调用java API的中间通信模块)

进入C:\Python27\Scripts使用pip install py4j:

pip install py4j 注:卸载python 模块:pip uninstall py4j

或者,将解压的spark安装包中的F:\spark-1.6.0-bin-hadoop2.6\python\lib\py4j-0.9-src\py4j拷贝C:\Python27\Lib\site-packages中。

验证py4j是否安装成功:进入python ,import py4j

注意:如果使用的是anaconda安装的python3.5.x的环境,之后使用这个python3.5.x环境,一定要将py4j模块放在安装的python3.5.x的目录,即:anaconda目录\envs\Python35【安装python3.5.x版本取的名称】\Lib\site-packages\中。

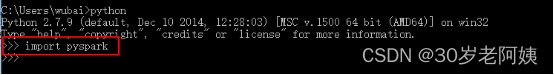

4、在python中安装pyspark模块

使用pip安装pyspark:

pip install pyspark//会安装最新的版本的pyspark或者,将解压的spark安装包中的F:\spark-1.6.0-bin-hadoop2.6\python\pyspark拷贝到C:\Python27\Lib\site-packages中,验证pyspark模块是否安装成功:

进入cmd,输入python,导入pyspark模块,如果没错即安装成功。

注意:如果使用的是anaconda安装的python3.5.x的环境,之后使用这个python3.5.x环境,一定要将pyspark模块放在安装的python3.5.x的目录,即:anaconda目录\envs\Python35【安装python3.5.x版本取的名称】\Lib\site-packages\中。

809

809

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?