Abstract

概述:我们提出了一种新的方法,利用最近的发展神经机器翻译(NMT),生成对抗性网络(GANs)和运动生成来生成手语。我们的系统能够从口语句子中生成手语视频。与当前依赖于大量注释数据的方法相反,我们的方法需要最少的注释和骨架级别的注释来进行培训,我们通过将任务分解为专门的子流程来实现这一点。

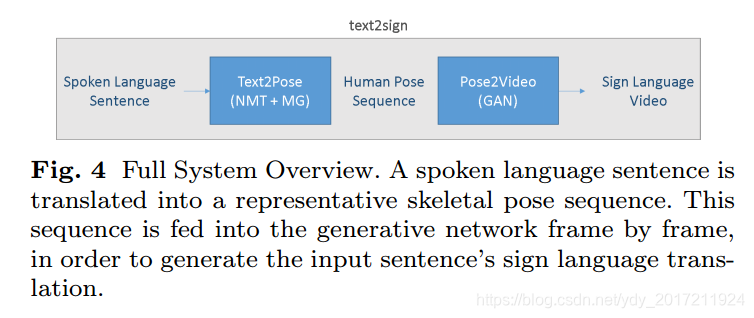

方法:我们首先将一个NMT网络和一个运动图(MG)结合起来,将口语句子翻译成手语姿势序列。生成的姿态信息用于生成生成模型,生成逼真的手语视频序列。这是第一种不使用经典图形头像的连续符号视频生成方法。

数据集:我们在PHOENIX14T手语翻译数据集上评估了我们的方法的翻译能力。

我们为文本到注释的翻译设置了基线,开发/测试集BLEU-4的分数为16.34/15.26。

我们还将使用广播质量评估指标,定性和定量地演示我们的方法对于多手势者和高清的视频生成功能。

Introduction

和口语一样,手语也有自己的语法规则和语言结构。这使得口语和手语之间的翻译成为一个复杂的问题,它不是简单地将文本映射到手势的逐字逐句的练习。图1演示了语言的标记化和它们的顺序是不同的,它需要机器翻译方法来找到一种口语和手语之间的映射,这需要考虑到它们的语言模型。

SLR的工作: 将手势序列映射为口语,提供手势序列的文本,如【17】【48】,那是因为觉得耳聋的人能自如地阅读口语,因此不需要翻译成手语的错觉。然而,并不能保证一个人的第一语言是,例如,

英国手语,熟悉书面英语,这两种语言是完全不同的。

此外,从口语生成手语是一项复杂的任务,不能通过简单的一对一映射来完成。

与口语不同,手语使用多个异步通道传播信息(在语言学中被称为发音器),这些渠道包括手势(即上半身运动,手的形状和轨迹)和非手动(即面部表情,口型,身体姿势)的特征。

SLP工作1: SLP的问题通常是通过动画化身来解决的,[12][20][38] 当使用动作捕捉数据驱动时,化身可以生成栩栩如生的签名,但是这种方法仅限于预先录制的短语,并且动作捕捉数据的生成是昂贵的。

SLP工作2:另一种方法是将口语翻译成符号注释(代表个体符号的词汇实体)并将每个实体连接到参数表示,如动画角色所需的手形和运动.

存在问题:但是,这种方法有几个问题。将口语句子翻译成符号注释是一项艰巨的任务,因为注释的顺序和数量与口语句子的单词不匹配。此外,通过将手语视为孤立注释的串联,上下文和非手势信息特征被忽略了,这会导致粗糙、错误的翻译,结果在许多基于动画形象的方法中看到指示性的“机器人”运动。

我们的方法:为了推动SLP领域的发展,我们提出了一种新的方法,利用NMT、计算机图形学和基于神经网络的图像/视频生成方法。该方法能够生成手语视频,给定一个书面或口头语言句子。

1)一个编码器-解码器网络从口语文本输入中提取注释概率序列,用来调整一个运动图(MG)找出代表输入的姿态序列。

2)最后,使用这个序列对GAN进行条件处理,生成包含输入语句符号转换的视频

本文贡献:

- 一个基于nmt的网络和一个实现连续文本到姿态转换的运动图的结合

- 基于姿势和外观的生成网络。

- 第一个口语手语视频翻译系统,不需要昂贵的动作捕捉或化身。(废话

这项工作的初步版本在[51]这个扩展的手稿包含一个改进的管道和额外的公式。

我们引入一个MG,在这个过程中,与NMT网络相结合的MG能够实现文本到姿势(text2pose)的转换。

此外,我们还演示了不同外观的多个手势者的生成。

我们还研究了高清(HD)标识的生成

提供了广泛的新的定量和定性评估,探索我们的方法的能力

图3给出了我们的方法的输出的比较(右)到其他基于角色的方法(左和中)

本文的其余部分组织如下:第2节概述了NMT以及使用化身的传统SLP的最新发展。在描述生成图像模型的最新进展之前,我们将解释运动图的概念。

第3节介绍了我们的方法的所有部分。在第4节中,我们在第5节结束之前,对我们的系统进行了定量和定性的评估。

Related work

我们将手语生产(SLP)视为一个从口语到手语的翻译问题。因此,我们首先回顾神经机器翻译领域的最新发展。

与传统的翻译任务不同,它本质上要求生成可视化的内容。通常这是通过动画一个3D头像来实现的。因此,我们将给一个概述过去和目前的符号化身技术。

最后,我们讨论了运动图(MGs)的概念,这是一种在计算机图形学中用于动态动画角色的技术,以及条件图像生成领域

2.1 Neural Machine Translation

NMT采用了基于递归神经网络(RNN)的序列对序列(seq2seq)架构,学习了一个统计模型来在不同语言之间进行转换,Seq2seq[52,10]在口语翻译方面取得了成功。

它由两个rns组成,一个编码器和一个解码器,学习将源序列转换为目标序列。

LSTM、GRU,这两种体系结构都具有允许每个单元只将相关信息传递给下一个时间步骤的机制,从而在长期依赖关系的基础上改进翻译性能

注意力机制 进一步提高长序列的翻译

Bahdanau等人介绍了注意机制。它通过允许解码器观察编码器的隐藏状态,为解码器提供额外的信息。这一机制后来被Luong等人改进

Camgoz等人将标准的seq2seq框架与卷积神经网络(CNN)相结合,将手语视频翻译成口语句子。他们首先使用CNN从视频中提取特征,然后翻译成文本。这可以看作是我们的问题的反面,将文本翻译成pose。

最近,人们探索了一些基于非rnn的NMT方法。ByteNet[27]使用扩张卷积进行翻译,Vaswani等人在[53]中引入了transformer,这是一种纯粹基于注意力的翻译方法

用NMT方法将文本翻译成pose是一个相对未被探索和开放的问题

Ahn等人使用RNN=based的编码器-解码器模型,从文本中生成人体动作的上半身姿势序列,并将其映射到Baxter机器人上,然而ÿ

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

700

700

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?