附件

📎20230625_Transformer的Pytorch代码解读.pptx

论文地址:https://arxiv.org/abs/1706.03762

完整代码:multimodal-learning/transformer_torch.py at main · Yeezy7/multimodal-learning

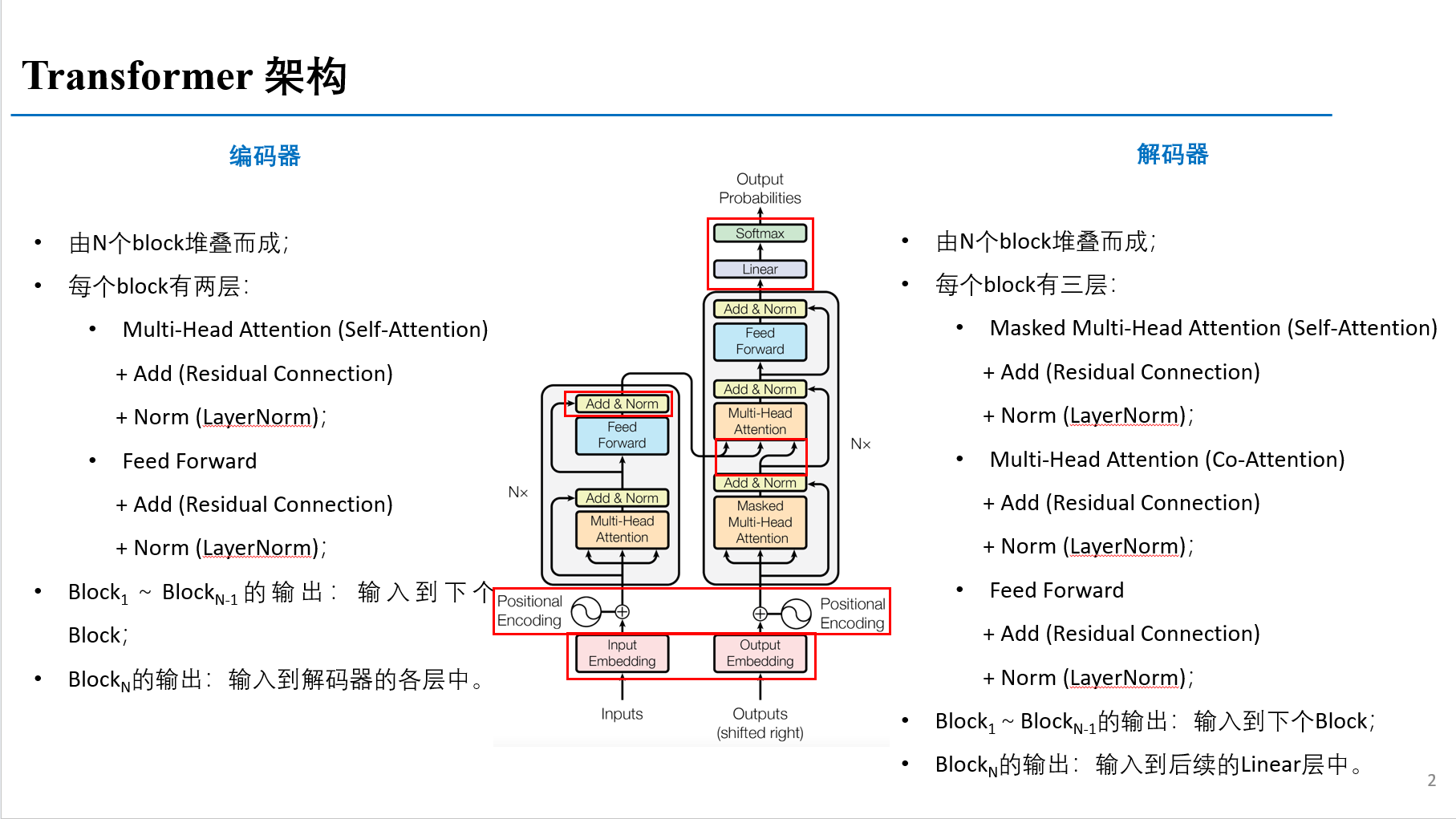

一、模型架构

1.1 整体框架

1.1.1 整体架构

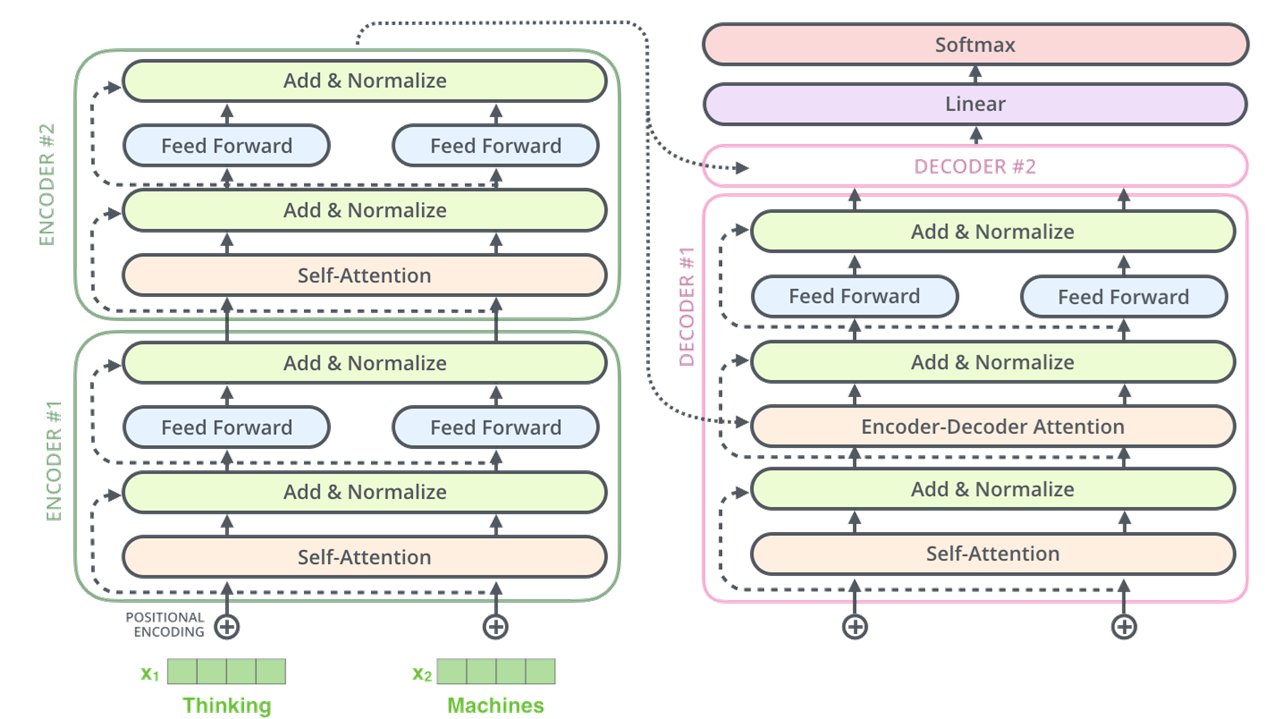

从整体网路结构来看,分为三个部分:编码层,解码层,输出层

1.1.2 Transformer工作流程

Transformer工作流程:

# 整体架构

class Transformer(nn.Module):

def __init__(self):

super(Transformer, self).__init__()

self.encoder = Encoder()

self.decoder = Decoder()

# 输出层 d_model 是解码层每个token输出的维度大小,之后会做一个 tgt_vocab_size 大小的softmax

self.projection = nn.Linear(d_model, tgt_vocab_size, bias=False)

def forward(self, enc_inputs, dec_inputs):

# 两个输入,一个是enc_inputs 形状为[batch_size, src_len], 主要作为编码端的输入;一个dec_inputs,形状为[batch_size, tgt_len], 主要作为解码端的输入

# enc_inputs作为输入 形状为[batch_size, src_len],输出由自己的函数内部指定,想要什么指定输出什么,可以是全部tokens的输出,可以是特定每一层的输出;也可以是中间某些参数的输出;

# enc_outputs就是主要的输出,enc_self_attns这里没记错的是 QK转置相乘之后softmax之后的矩阵值,代表的是每个单词和其他单词相关性;

enc_outputs, enc_self_attns = self.encoder(enc_inputs)

# dec_outputs 是decoder主要输出,用于后续的linear映射; dec_self_attns类比于enc_self_attns 是查看每个单词对decoder中输入的其余单词的相关性;dec_enc_attns是decoder中每个单词对encoder中每个单词的相关性;

dec_outputs, dec_self_attns, dec_enc_attns = self.decoder(dec_inputs, enc_inputs, enc_outputs)

# dec_outputs 做映射到词表大小

dec_logits = self.projection(dec_outputs) # dec_logits : [batch_size , tgt_len , tgt_vocab_size]

# dec_logits.view(-1, dec_logits.size(-1)) : [batch_size * tgt_len, tgt_vocab_size]

return dec_logits.view(-1, dec_logits.size(-1)), enc_self_attns, dec_self_attns, dec_enc_attns

1.2 编码器 Encoder

1.2.1 整体架构

Encoder 包含三个部分:

词向量embedding,位置编码,注意力层及后续的前馈神经网络

# 编码器

# Encoder 包含三个部分:词向量embedding,位置编码,注意力层及后续的前馈神经网络

class Encoder(nn.Module):

def __init__(self):

super(Encoder, self).__init__()

self.src_emb = nn.Embedding(src_vocab_size, d_model) # 这个其实就是去定义生成一个矩阵,大小是 src_vocab_size * d_model

self.pos_emb = PositionalEncoding(d_model) # 位置编码情况,这里是固定的正余弦函数,也可以使用类似词向量的nn.Embedding获得一个可以更新学习的位置编码

self.layer = nn.ModuleList([EncoderLayer() for _ in range(n_layers)]) # 使用ModuleList对多个encoder进行堆叠,因为后续的encoder并没有使用词向量和位置编码,所以抽离出来;

def forward(self, enc_inputs):

# enc_inputs 形状是: [batch_size x source_len]

# 通过src_emb,进行索引定位,enc_outputs输出形状是[batch_size, src_len, d_model]

enc_outputs = self.src_emb(enc_inputs)

# 这里就是位置编码,把两者相加放入到了这个函数里面,从这里可以去看一下位置编码函数的实现;

enc_outputs = self.pos_emb(enc_outputs.transpose(0, 1)).transpose(0, 1)

# get_attn_pad_mask是为了得到句子中pad的位置信息,给到模型后面,在计算自注意力和交互注意力的时候去掉pad符号的影响,去看一下这个函数 4.

enc_self_attn_mask = get_attn_pad_mask(enc_inputs, enc_inputs)

enc_self_attns = []

for layer in self.layers:

enc_outputs, enc_self_attn = layer(enc_outputs, enc_self_attn_mask)

enc_self_attns.append(enc_self_attn)

return enc_outputs, enc_self_attns1.2.2 位置编码

位置编码公式:

![]()

class PositionalEncoding(nn.Module):

def __init__(self, d_model, dropout=0.1, max_len=5000):

super(PositionalEncoding, self).__init__()

# 位置编码的实现其实很简单,直接对照着公式去敲代码就可以,下面这个代码只是其中一种实现方式;

# 从理解来讲,需要注意的就是偶数和奇数在公式上有一个共同部分,我们使用log函数把次方拿下来,方便计算;

# pos代表的是单词在句子中的索引,这点需要注意;比如max_len是128个,那么索引就是从0,1,2,...,127

# 假设我的demodel是512,2i那个符号中i从0取到了255,那么2i对应取值就是0,2,4...510

self.dropout = nn.Dropout(p=dropout) # 正则化层

pe = torch.zeros((max_len, d_model))

position = torch.arange(0, max_len, dtype=torch.float).unsqueeze(1)

div_term = torch.exp(torch.arange(0, d_model, 2).float() * (-math.log(10000.0) / d_model))

pe[:, 0::2] = torch.sin(position * div_term) # 这里需要注意的是pe[:, 0::2]这个用法,就是从0开始到最后面,补长为2,其实代表的就是偶数位置

pe[:, 1::2] = torch.cos(position * div_term) # 这里需要注意的是pe[:, 1::2]这个用法,就是从1开始到最后面,补长为2,其实代表的就是奇数位置

# 上面代码获取之后得到的pe:[max_len , d_model]

# 下面这个代码之后,得到的pe:[max_len , 1 , d_model]

pe = pe.unsqueeze(0).transpose(0, 1)

self.register_buffer('pe', pe) # 定一个缓冲区,其实简单理解为这个参数不更新就可以

def forward(self, x):

"""

x: [seq_len, batch_size, d_model]

"""

x = x + self.pe[:x.size[(0), :]

return self.dropout(x) 1.2.3 注意力掩码

是为了得到句子中pad的位置信息,给到模型后面,在计算自注意力和交互注意力的时候去掉pad符号的影响。

比如说,我现在的句子长度是5,在后面注意力机制的部分,我们在计算出来QK转置除以根号之后,softmax之前,我们得到的形状 [len_input , len , input] 代表每个单词对其余包含自己的单词的影响力,所以这里我需要有一个同等大小形状的矩阵,告诉我哪个位置是PAD部分,之后在计算计算softmax之前会把这里置为负无穷大;一定需要注意的是这里得到的矩阵形状是 [batch_size , len_q , len_k],我们是对k中的pad符号进行标识,并没有对q中的做标识,因为没必要。seq_q 和 seq_k 不一定一致,在交互注意力,q来自解码端,k来自编码端,所以告诉模型编码这边pad符号信息就可以,解码端的pad信息在交互注意力层是没有用到的;

def get_attn_pad_mask(seq_q, seq_k):

batch_size, len_q = seq_q.size()

batch_size, len_k = seq_k.size()

# eq(zero) is PAD token

pad_attn_mask = seq_k.data.eq(0).unsqueeze(1) # [batch_size, 1, len_k], False is masked

return pad_attn_mask.expand(batch_size, len_q, len_k) # [batch_size, len_q, len_k]

1.2.4 编码层

EncoderLayer :包含两个部分,多头注意力机制和前馈神经网络;

Encoder中通过ModuleList组合多个EncoderLayer层

# EncoderLayer :包含两个部分,多头注意力机制和前馈神经网络

class EncoderLayer(nn.Module):

def __init__(self):

super(EncoderLayer, self).__init__()

self.enc_self_attn = MultiHeadAttention()

self.pos_ffn = PoswiseFeedForwardNet()

def forward(self, enc_inputs, enc_self_attn_mask):

# 下面这个就是做自注意力层,输入是enc_inputs,形状是[batch_size x seq_len_q x d_model] 需要注意的是最初始的QKV矩阵是等同于这个输入的,去看一下enc_self_attn函数 6.

enc_outputs, attn = self.enc_self_attn(enc_inputs, enc_inputs, enc_inputs, enc_self_attn_mask) # enc_inputs to same Q,K,V

enc_outputs = self.pos_ffn(enc_outputs) # enc_outputs: [batch_size x len_q x d_model]

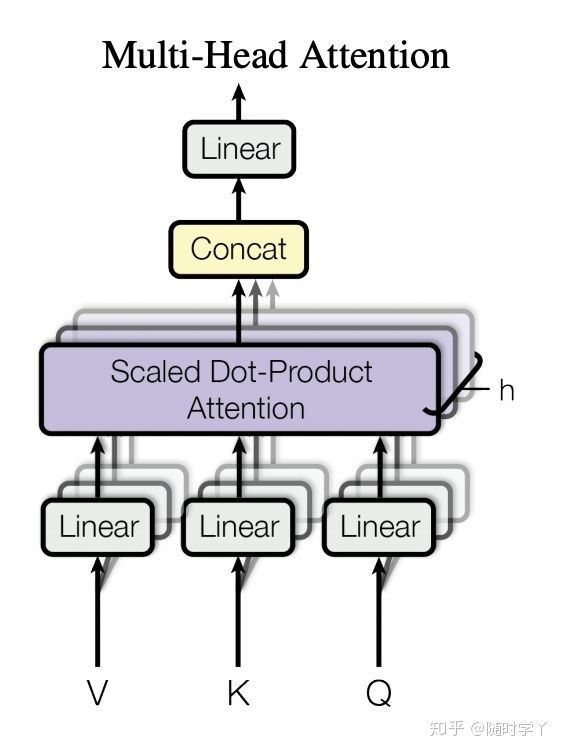

return enc_outputs, attn1.2.5 多头注意力

设置 h 组不同的 线性投影(linear projections)来变换查询、键和值。然后,这 h 组变换后的查询、键和值将并行地进行注意力池化。最后,将这 h 个注意力池化的输出拼接在一起,并且通过另一个可以学习的线性投影进行变换,以产生最终输出。这种设计被称为 多头注意力

# MultiHeadAttention

class MultiHeadAttention(nn.Module):

def __init__(self):

super(MultiHeadAttention, self).__init__()

# 输入进来的QKV是相等的,我们会使用映射linear做一个映射得到参数矩阵Wq, Wk,Wv

self.W_Q = nn.Linear(d_model, d_k * n_heads)

self.W_K = nn.Linear(d_model, d_k * n_heads)

self.W_V = nn.Linear(d_model, d_v * n_heads)

self.linear = nn.Linear(n_heads * d_v, d_model)

self.layer_norm = nn.LayerNorm(d_model)

def forward(self, input_Q, input_K, input_V, attn_mask):

# 这个多头分为这几个步骤,首先映射分头,然后计算atten_scores,然后计算atten_value;

# 输入进来的数据形状: Q: [batch_size , len_q , d_model], K: [batch_size , len_k , d_model], V: [batch_size , len_k , d_model]

residual, batch_size = input_Q, input_Q.size(0)

# (B, S, D) -proj-> (B, S, D) -split-> (B, S, H, W) -trans-> (B, H, S, W)

# 下面这个就是先映射,后分头,分为n_heads个头;一定要注意的是q和k分头之后维度是一致de,所以一看这里都是dk

Q = self.W_Q(input_Q).view(batch_size, -1, n_heads, d_k).transpose(1, 2) # Q: [batch_size, n_heads, len_q, d_k]

K = self.W_K(input_K).view(batch_size, -1, n_heads, d_k).transpose(1, 2) # K: [batch_size, n_heads, len_k, d_k]

V = self.W_V(input_V).view(batch_size, -1, n_heads, d_v).transpose(1, 2) # V: [batch_size, n_heads, len_v, d_v]

# 输入进行的attn_mask形状是 [batch_size , len_q , len_k],然后经过下面这个代码得到 新的attn_mask : [batch_size , n_heads , len_q , len_k],就是把pad信息重复了n个头上

attn_mask = attn_mask.unsqueeze(1).repeat(1, n_heads, 1, 1)

# 然后我们计算 ScaledDotProductAttention 这个函数

# 得到的结果有两个:context: [batch_size , n_heads , len_q , d_v], attn: [batch_size , n_heads , len_q , len_k]

context, attn = ScaledDotProductAttention()(Q, K, V, attn_mask) # 缩放点积注意力

context = context.transpose(1, 2).contiguous().view(batch_size, -1, n_heads * d_v) # context: [batch_size , len_q , n_heads * d_v]

output = self.linear(context) # output: [batch_size , len_q , d_model]

return self.layer_norm(output + residual), attn上述维度的变化

在

MultiHeadAttention类的forward方法中,输入数据和中间变量的维度变化如下:1. 输入数据维度:

input_Q:[batch_size, len_q, d_model]查询序列input_K:[batch_size, len_k, d_model]键序列input_V:[batch_size, len_k, d_model]值序列attn_mask:[batch_size, len_q, len_k]注意力掩码2. 线性映射和分头:

Q = self.W_Q(input_Q):[batch_size, len_q, d_k * n_heads]K = self.W_K(input_K):[batch_size, len_k, d_k * n_heads]V = self.W_V(input_V):[batch_size, len_k, d_v * n_heads]3. 调整形状和转置:

Q.view(...):[batch_size, len_q, n_heads, d_k]K.view(...):[batch_size, len_k, n_heads, d_k]V.view(...):[batch_size, len_k, n_heads, d_v]Q.transpose(1, 2):[batch_size, n_heads, len_q, d_k]K.transpose(1, 2):[batch_size, n_heads, len_k, d_k]V.transpose(1, 2):[batch_size, n_heads, len_k, d_v]4. 注意力掩码扩展:

attn_mask.unsqueeze(1):[batch_size, 1, len_q, len_k]attn_mask.repeat(...):[batch_size, n_heads, len_q, len_k]5. 缩放点积注意力计算:

context:[batch_size, n_heads, len_q, d_v]attn:[batch_size, n_heads, len_q, len_k]6. 合并头和线性变换:

context.transpose(1, 2):[batch_size, len_q, n_heads, d_v]context.contiguous(): 确保内存连续性,维度不变context.view(...):[batch_size, len_q, n_heads * d_v]output = self.linear(context):[batch_size, len_q, d_model]7. 残差连接和层归一化:

output + residual:[batch_size, len_q, d_model]self.layer_norm(...):[batch_size, len_q, d_model]

1.2.6 缩放点积注意力

缩放点积注意力:

class ScaledDotProductAttention(nn.Module):

def __init__(self):

super(ScaledDotProductAttention, self).__init__()

def forward(self, Q, K, V, attn_mask):

# 输入进来的维度分别是 Q: [batch_size , n_heads , len_q , d_k] K: [batch_size , n_heads , len_k , d_k] V: [batch_size , n_heads , len_k , d_v]

# 首先经过matmul函数得到的scores形状是 : [batch_size x n_heads x len_q x len_k]

scores = torch.matmul(Q, K.transpose(-1, -2)) / np.sqrt(d_k)

# 然后关键词地方来了,下面这个就是用到了我们之前重点讲的attn_mask,把被mask的地方置为无限小,softmax之后基本就是0,对q的单词不起作用

scores.masked_fill_(attn_mask, -1e9) # Fills elements of self tensor with value where mask is one.

attn = nn.Softmax(dim=-1)(scores)

context = torch.matmul(attn, V)

return context, attn1.2.7 位置感知前馈网络

d_model 是模型的维度,即输入和输出的维度。

d_ff 是前馈网络中间层的维度

class PoswiseFeedForwardNet(nn.Module):

def __init__(self):

super(PoswiseFeedForwardNet, self).__init__()

self.conv1 = nn.Conv1d(in_channels=d_model, out_channels=d_ff, kernel_size=1)

self.conv2 = nn.Conv1d(in_channels=d_ff, out_channels=d_model, kernel_size=1)

self.layer_norm = nn.LayerNorm(d_model)

def forward(self, inputs):

residual = inputs # inputs : [batch_size, len_q, d_model]

output = nn.ReLU()(self.conv1(inputs.transpose(1, 2)))

output = self.conv2(output).transpose(1, 2)

return self.layer_norm(output + residual)1.3 解码器Dncoder

1.3.1 整体架构

解码器包含:掩码多头注意力、

class Decoder(nn.Module):

def __init__(self):

super(Decoder, self).__init__()

self.tgt_emb = nn.Embedding(tgt_vocab_size, d_model)

self.pos_emb = PositionalEncoding(d_model)

self.layers = nn.ModuleList([DecoderLayer() for _ in range(n_layers)])

def forward(self, dec_inputs, enc_inputs, enc_outputs): # dec_inputs : [batch_size x target_len]

dec_outputs = self.tgt_emb(dec_inputs) # [batch_size, tgt_len, d_model]

dec_outputs = self.pos_emb(dec_outputs.transpose(0, 1)).transpose(0, 1) # [batch_size, tgt_len, d_model]

## get_attn_pad_mask 自注意力层的时候的pad 部分

dec_self_attn_pad_mask = get_attn_pad_mask(dec_inputs, dec_inputs)

## get_attn_subsequent_mask 这个做的是自注意层的mask部分,就是当前单词之后看不到,使用一个上三角为1的矩阵

dec_self_attn_subsequent_mask = get_attn_subsequent_mask(dec_inputs)

## 两个矩阵相加,大于0的为1,不大于0的为0,为1的在之后就会被fill到无限小

dec_self_attn_mask = torch.gt((dec_self_attn_pad_mask + dec_self_attn_subsequent_mask), 0)

## 这个做的是交互注意力机制中的mask矩阵,enc的输入是k,我去看这个k里面哪些是pad符号,给到后面的模型;注意哦,我q肯定也是有pad符号,但是这里我不在意的,之前说了好多次了哈

dec_enc_attn_mask = get_attn_pad_mask(dec_inputs, enc_inputs)

dec_self_attns, dec_enc_attns = [], []

for layer in self.layers:

dec_outputs, dec_self_attn, dec_enc_attn = layer(dec_outputs, enc_outputs, dec_self_attn_mask, dec_enc_attn_mask)

dec_self_attns.append(dec_self_attn)

dec_enc_attns.append(dec_enc_attn)

return dec_outputs, dec_self_attns, dec_enc_attns1.3.2 掩码多头注意力

关键步骤:

1、生成掩码:创建一个上三角矩阵作为掩蔽,用于屏蔽序列中未来的信息。并扩展到与批次大小和头数相匹配的形状

2、应用掩码:在计算注意力权重之前,将掩蔽矩阵加到注意力分数上,使得被掩蔽的位置具有一个非常大的负值,这样,在应用softmax函数时,这些位置的权重会接近于0。

3、计算注意力:使用修改后的注意力分数来计算注意力权重,并通过这些权重来加权求和值序列。

def get_attn_subsequent_mask(seq): # seq: [batch_size, tgt_len]

attn_shape = [seq.size(0), seq.size(1), seq.size(1)]

# attn_shape: [batch_size, tgt_len, tgt_len]

subsequence_mask = np.triu(np.ones(attn_shape), k=1) # 生成一个上三角矩阵

subsequence_mask = torch.from_numpy(subsequence_mask).byte() # 转成byte张量

return subsequence_mask # [batch_size, tgt_len, tgt_len]其余掩码多头注意力代码见1.3.2

1.3.3 解码层

单个解码器包含:自注意力机制、编码器-解码器注意力机制和前馈网络

对于编码器-解码器注意力:

查询(Query):dec_outputs是解码器自注意力层的输出,它作为查询(Q)输入到编码器-解码器注意力层。这是因为解码器层的每个步骤都是基于之前步骤的输出。

键(Key)和值(Value):enc_outputs是编码器的输出,它被用作键(K)和值(V)输入到编码器-解码器注意力层。这是因为解码器需要关注编码器的完整输出,以获取与当前解码步骤最相关的信息。

# 由自注意力机制、编码器-解码器注意力机制和前馈网络组成

class DecoderLayer(nn.Module):

def __init__(self):

super(DecoderLayer, self).__init__()

self.dec_self_attn = MultiHeadAttention()

self.dec_enc_attn = MultiHeadAttention()

self.pos_ffn = PoswiseFeedForwardNet()

def forward(self, dec_inputs, enc_outputs, dec_self_attn_mask, dec_enc_attn_mask):

dec_outputs, dec_self_attn = self.dec_self_attn(dec_inputs, dec_inputs, dec_inputs, dec_self_attn_mask)

dec_outputs, dec_enc_attn = self.dec_enc_attn(dec_outputs, enc_outputs, enc_outputs, dec_enc_attn_mask)

dec_outputs = self.pos_ffn(dec_outputs)

return dec_outputs, dec_self_attn, dec_enc_attn

495

495

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?