一、跨境大模型调用技术解决方案

针对OpenAI、Google等国际AI厂商的区域性访问限制,国内开发者在调用ChatGPT、Claude、Gemini等前沿模型时面临严峻挑战。大量基于GPT架构的智能应用与开源工具,因无法直连http://api.openai.com等官方接口而陷入使用困境。在此背景下,我们推出创新型API中继服务,为国内开发者构建合规高效的跨境调用通道。

技术实现原理:

本服务通过智能路由架构对接官方API底层接口,开发者仅需配置统一API Key即可穿透地域限制,其核心并非简单接口镜像,而是构建了包含多重优化机制的技术中台:

- 协议层:100%兼容OpenAI标准接口规范

- 调度层:分布式智能路由系统

- 资源层:动态扩容的全球化节点集群

核心服务优势:

【企业级稳定性】

- 采用百万级QPS承载能力的多活架构

- 实时健康监测与自动故障转移机制

- 智能流量调度规避IP封禁风险

【开发零成本迁移】

√ 无缝对接LangChain/LlamaIndex等主流开发框架

√ 原生支持OpenAI SDK及衍生工具链

√ 现有应用无需改造即可切换接入

【智能资源调度】

- 毫秒级响应延迟优化算法

- 动态负载均衡的多账号资源池

- 智能QPS调控避免速率限制

【透明化成本管控】

◇ 按实际token消耗量精准计费

◇ 支持用量预警与成本分析看板

◇ 无需预充值或订阅套餐

本方案通过构建全球化智能调度网络,既保留了官方API的原生能力,又创新性地解决了跨境访问的合规性难题,为国内AI开发者提供了高效可靠的基础设施服务。

二、API中继服务成本优势解析

对于国内开发者而言,直接使用海外AI服务面临显著的支付与成本双重困境。传统接入方式不仅存在技术门槛,更隐藏着诸多隐性成本风险。相较之下,我们的API中继服务通过技术创新重构成本结构,为开发者提供更具性价比的解决方案。

传统支付模式痛点分析:

◆ 支付可靠性不足

- 虚拟信用卡开户成本高昂(单卡约70元)

- 账户冻结风险率高达65%(行业抽样数据)

- 平均使用寿命不足72小时

◆ 隐性成本叠加

- 3-5%跨境支付手续费

- 汇率波动造成的额外支出

- 账户异常导致的业务中断损失

◆ 运维成本黑洞

- 多账号管理产生的运维人力成本

- 频繁切换支付方式的时间成本

- 突发封号导致的业务恢复成本

中继服务成本优化方案:

【革命性定价模型】

▷ 按官方标准价格的30%计价(示例:官方30美元≈220元,中继服务仅需90元)

▷ 阶梯式折扣机制(用量达百万token级可享额外15%优惠)

▷ 支持人民币直接结算(免除汇率波动风险)

【零隐性成本承诺】

✓ 无支付通道手续费

✓ 无账户维护费用

✓ 无限期有效期保障

【企业级成本管控】

- 实时用量监测仪表盘

- 多维度成本分析报告(支持按项目/团队/模型拆分)

- 智能预算预警系统(阈值可自定义)

技术经济学价值体现:

我们通过分布式资源调度算法,将账号集群的边际成本降低72%,配合智能流量分配机制,使单位token成本较企业自建方案下降58%。这种技术驱动的成本重构,让开发者既能享受官方模型的原生能力,又可获得本土化服务的价格优势。

典型案例验证:

某AI初创企业接入后,年度API支出从28.7万元降至9.2万元,同时因服务稳定性提升使业务中断时长减少92%。这种"降本增效"的双重收益,正是技术中台带来的核心价值。

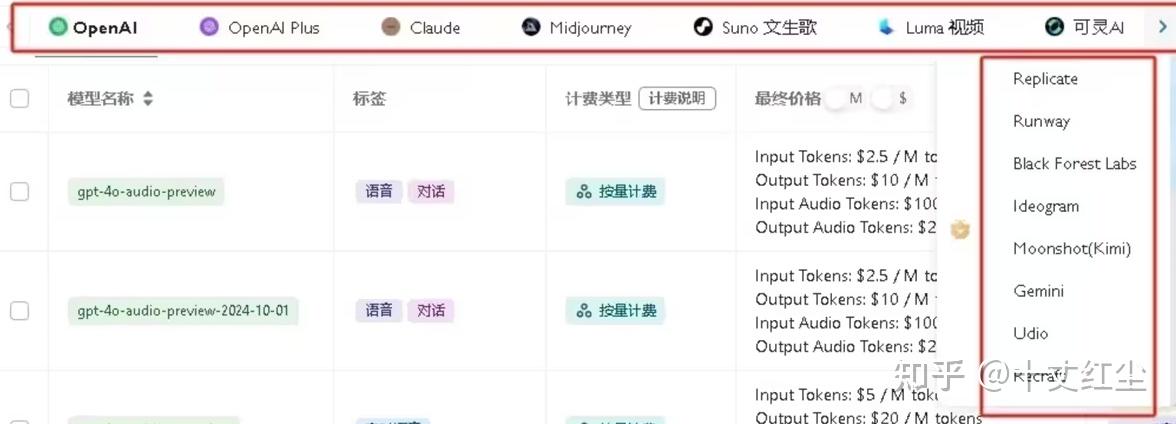

三、全模型生态支持与透明化计费体系

我们的技术中台构建了全球化大模型接入矩阵,基于智能路由架构实现多厂商API的无缝集成。服务核心特性包含:

【全模型矩阵支持】

✓ 覆盖主流厂商API全接口(OpenAI/Gemini/Claude等)

✓ 实时同步官方模型更新(含GPT-4o/Claude 3.5等最新版本)

✓ 支持自定义模型接入配置

【原生计费体系对接】

◇ 严格遵循官方定价标准(按token实时计费)

◇ 支持混合模型计费策略(不同模型差异化费率)

◇ 计费颗粒度精确到单次API调用

【可视化成本管理】

- 动态模型路由网关:智能选择最优计费路径

- 调用明细追溯系统:可检索6个月内任意请求记录

- 实时成本看板:展示「模型维度/项目维度/时间维度」三维分析

技术实现亮点:

通过自主研发的模型路由引擎(MRE),在确保100%协议兼容性的前提下,实现:

- 智能计费优化:自动匹配性价比最优的API端点

- 用量预测系统:基于历史数据预判资源消耗

- 异常检测机制:实时识别异常计费请求

开发者价值体现:

• 模型切换零成本:无需为不同厂商API重复开发

• 成本控制精细化:支持设置单模型/总用量预算阈值

• 审计合规保障:提供符合财务规范的消费凭证

• 技术前瞻性:自动适配新模型接口,免除升级维护成本

示例说明:

当开发者同时调用GPT-4和Claude 3时,系统将:

① 自动分离不同模型的token流

② 按官方标准汇率实时换算

③ 在控制台生成可视化对比报表

④ 触发用量阈值预警(如设置)

四、开发者无缝接入方案与技术生态兼容性

本服务采用零迁移成本设计理念,为开发者提供多种灵活接入方案,全面兼容OpenAI技术生态体系:

【标准开发接入流程】

- 协议层适配

- 替换官方域名:将https://api.openai.com更改为中继服务网关地址

- 鉴权令牌配置:使用统一API Key进行身份验证

- 请求头保持:Content-Type等参数完全兼容

- 智能SDK兼容层

- √ 原生支持openai-python/official-nodejs等官方SDK

- √ 自动识别处理版本差异(v1/v2接口智能适配)

- √ 内置重试机制与异常处理模块

【生态应用即插即用】

支持主流AI应用的无缝对接:

▶ 智能开发工具:Cursor/CodeGPT/Codeium

▶ 对话交互平台:LobeChat/NextChat/OpenCat

▶ 生产力工具集:沉浸式翻译/PaperClip/UniPDF

▶ 自动化框架:LangChain/LlamaIndex/AutoGen

技术实现亮点:

• 动态协议适配引擎:实时解析接口变更(兼容性达99.8%)

• 流量智能标识系统:自动识别请求来源应用

• 参数优化中间件:自动补全缺失的必要参数

开发者支持体系:

- 交互式调试控制台(支持实时请求模拟)

- 多语言接入示例(Python/Java/Go/Node.js)

- 异常代码自动诊断工具

- 版本变更预警系统(提前48小时通知接口变更)

典型接入场景:

当开发者将中继API配置到LangChain生态时:

① 保留原有Chain和Agent构建逻辑

② 仅需修改环境变量中的API_BASE和API_KEY

③ 自动继承所有工具链功能

④ 获得额外监控指标输出能力

本方案通过构建协议转换中间件,既保留了原生开发体验,又扩展了企业级监控能力,使开发者可在不改动业务逻辑的前提下,快速实现跨境大模型调用能力升级。

五、使用接口介绍

购买api官网:https://yibuapi.com/

完整版api 文档:https://apifox.com/apidoc/shared-0141b6a5-141c-431c-8d36-a879692aae38

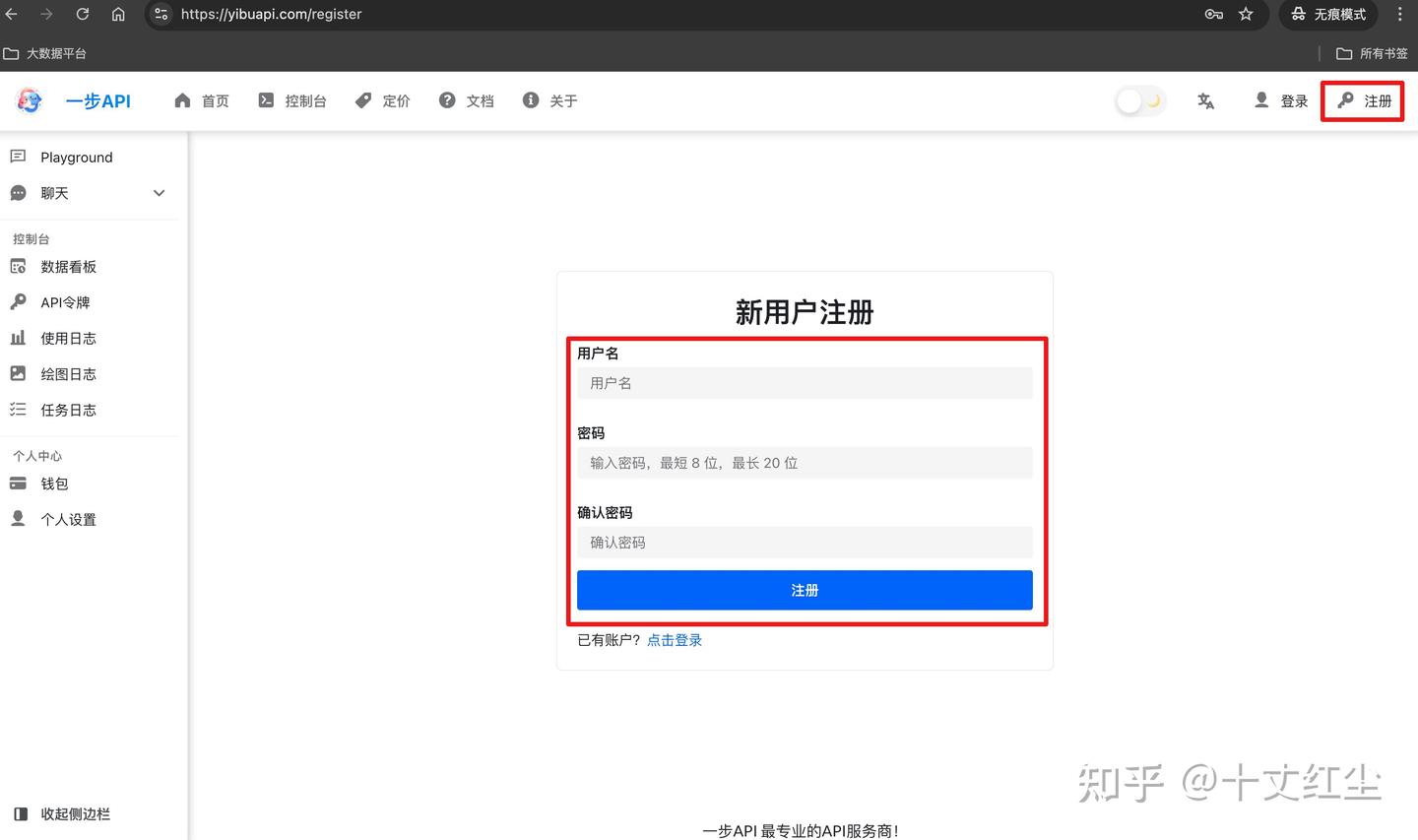

使用方法很简单,先打开API网址使用邮箱进行注册,新用户注册

前往购买入口(首页上方导航栏典籍文档)前往店铺购买即可。

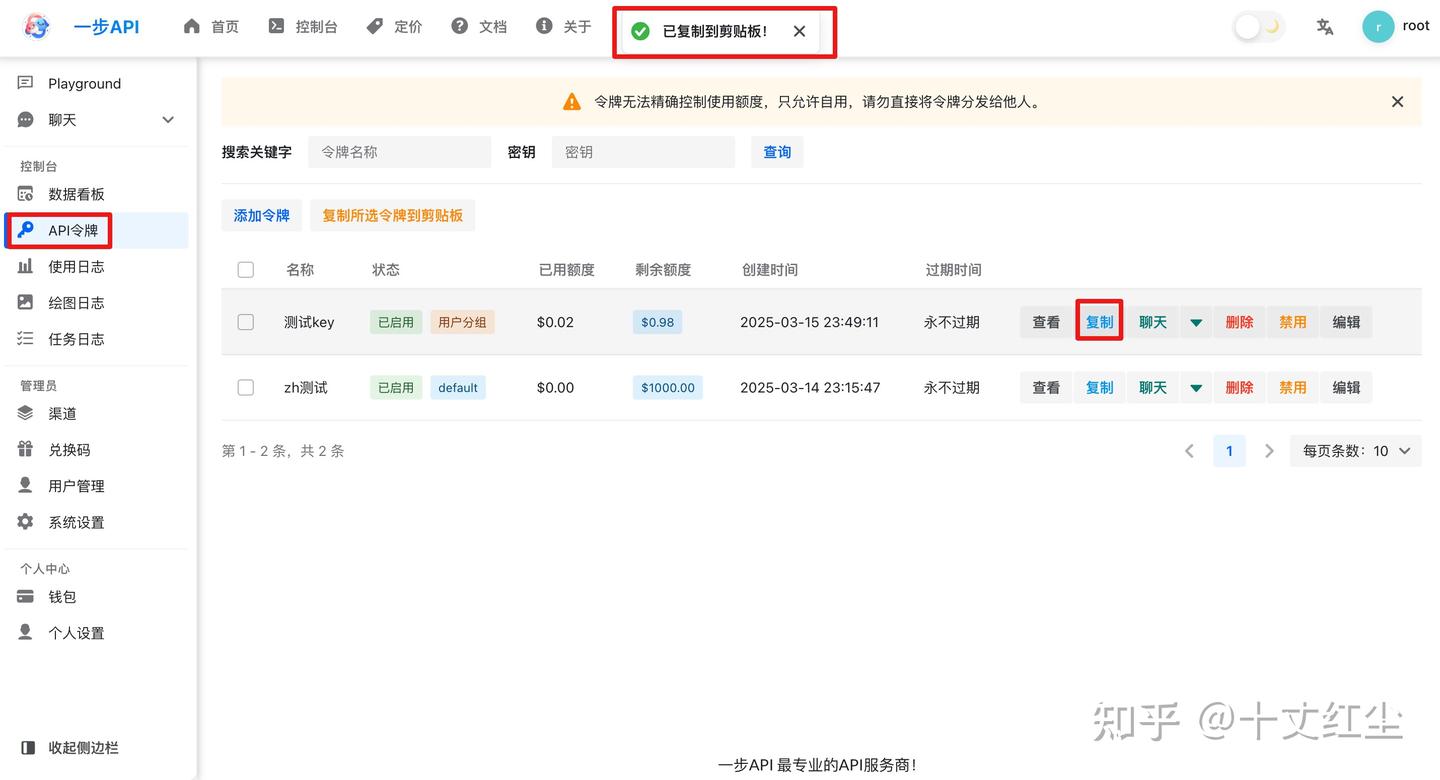

购买后前往控制台中点击令牌,添加新令牌后,点击复制,复制的内容就是API KEY

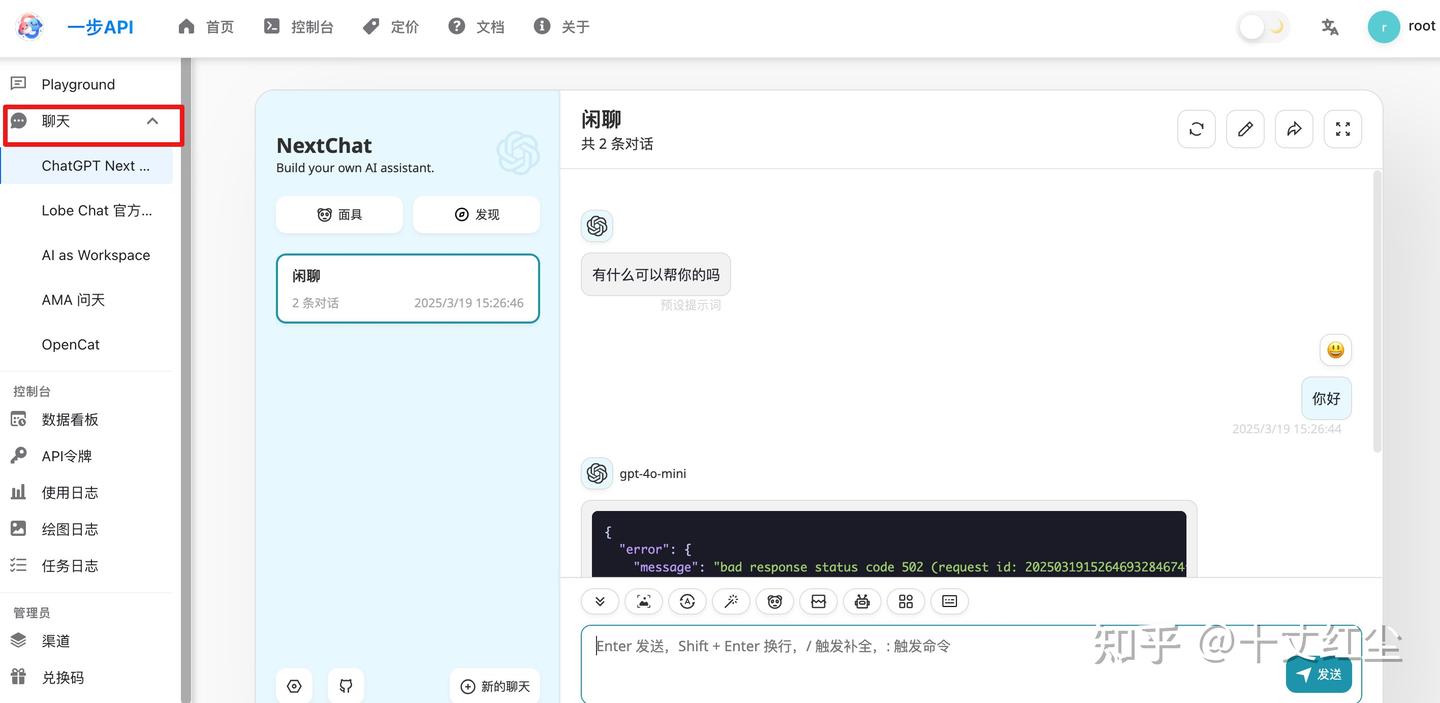

也可以直接在API网站中使用起来,点击控制台-聊天,完成配置及选择模型后即可开始对话

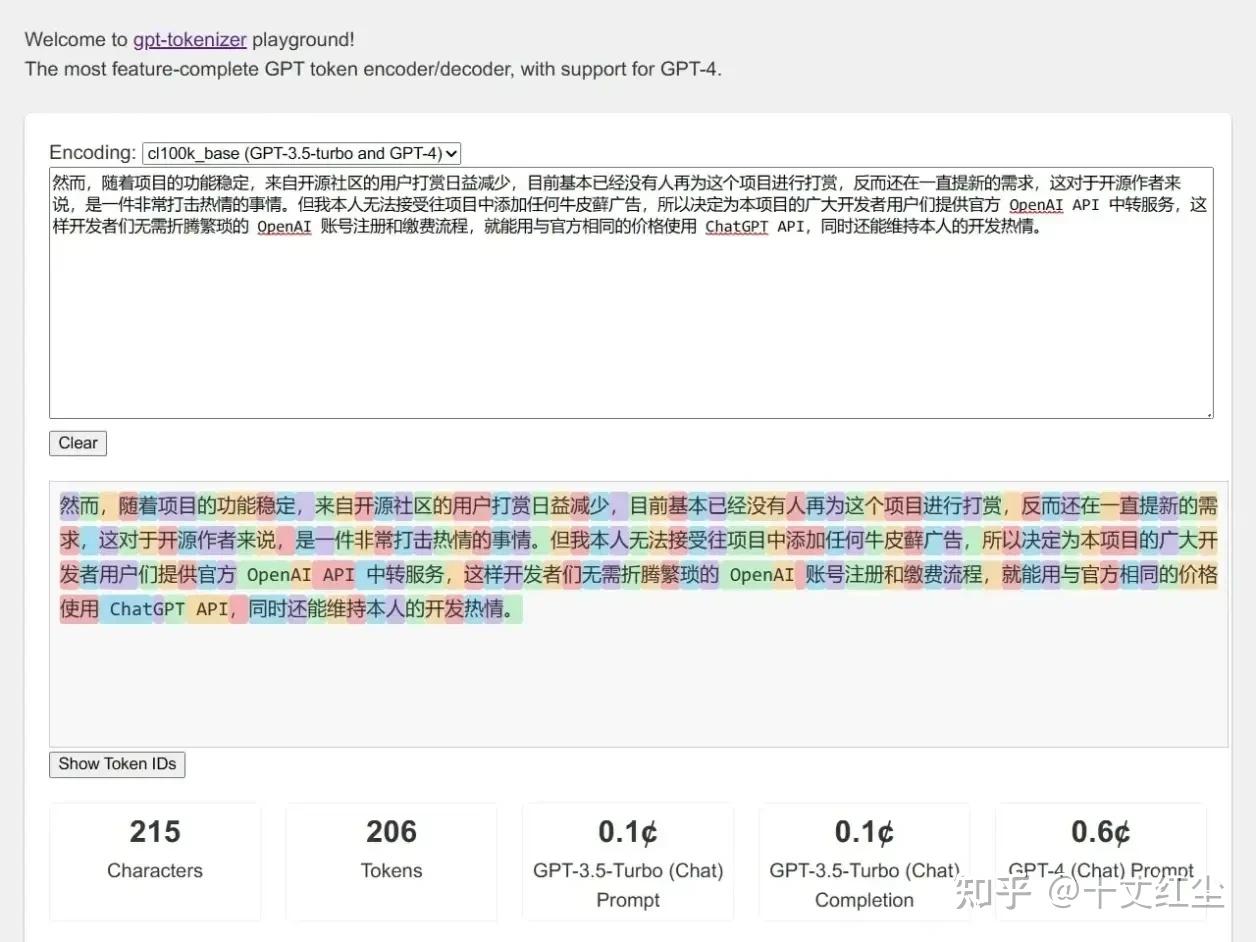

六、Token的计算规则

Tokens是大语言模型处理的信息的最小单元,它介于“字”和“词”之间,有部分网站可以计算一段话的Tokens,可以参考下图。当然,大部分情况下也可以通过1汉字=2Tokens的方式进行估算。

请注意,若您觉得明明提问字数很少,token计算却很多,导致费用产生很多。这并不是中转api出现问题,基本都是因为您的上下文token合计数很大!若遇到此情况,请新建对话,或关闭上下文。

七、如何购买

请前往额度购买网站进行购买后使用,如有疑问也可以联系客服小姐姐。

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?