引言

本文是DistilBERT1的阅读笔记。

核心思想

DistilBERT是一个更小更快的BERT模型,类似ALBERT,也是用来给BERT瘦身的。

DistilBERT应用了基于三重损失(Triplet Loss)的知识蒸馏(knowledge distillation)方法。相比BERT模型,DistilBERT的参数量压缩至原来的40%,同时带来60%的推理速度提升,并且在多个下游任务上达到BERT模型效果的97%。

并且该模型可以放到像手机📲(on-device)这类设备上运行,具备的好处就是更好的隐私保护,一些隐私数据可以不用上传到服务器,直接在手机端针对这些数据就可以为人们带来个性化的服务。

模型剖析

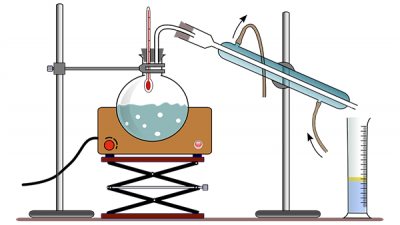

DistilBERT的名字中Distil就是蒸馏的意思,我们先来看下什么是蒸馏。

蒸馏

蒸馏的解释是加热液体汽化,再使蒸气液化

DistilBERT是BERT的一个轻量化版本,通过知识蒸馏技术,将模型大小减小到40%,速度提高60%,在多项任务中表现接近BERT的97%。它采用三重损失函数进行训练,包括有监督MLM损失、蒸馏MLM损失和词向量余弦损失。DistilBERT适用于设备本地运行,提高隐私保护。

DistilBERT是BERT的一个轻量化版本,通过知识蒸馏技术,将模型大小减小到40%,速度提高60%,在多项任务中表现接近BERT的97%。它采用三重损失函数进行训练,包括有监督MLM损失、蒸馏MLM损失和词向量余弦损失。DistilBERT适用于设备本地运行,提高隐私保护。

订阅专栏 解锁全文

订阅专栏 解锁全文

442

442

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?