25年3月来自斯坦福李飞飞团队的论文“BEHAVIOR ROBOT SUITE: Streamlining Real-World Whole-Body Manipulation for Everyday Household Activities”。

现实世界的家务任务对移动机械操作机器人提出了重大挑战。对现有机器人基准的分析表明,成功的任务执行取决于三个关键的全身控制能力:双手协调、稳定和精确的导航以及广泛的末端执行器可达性。实现这些能力需要精心的硬件设计,但由此产生的系统复杂性使视觉运动策略学习进一步复杂化。为了应对这些挑战,本文推出行为机器人套件 (BRS),这是一个用于各种家务任务中全身操作的综合框架。BRS 以具有 4 自由度躯干的双手轮式机器人为基础,集成用于数据收集的经济高效全身遥操作界面和用于学习全身视觉运动策略的新算法。在五项具有挑战性的家务任务上对 BRS 进行评估,这些任务不仅强调三大核心能力,还引入额外的复杂性,例如长距离导航、与铰接体和可变形体的交互以及在密闭空间中的操作。

BRS 如图所示:

开发能够协助日常生活的多功能机器人,仍然是以人为本的机器人研究的重大挑战[1-4],最近重点关注日常家务活动[5-12]。为了有效地执行这些任务,机器人必须在避开障碍物的情况下导航很长的距离,到达并操纵不同位置和高度的物体,与铰接体或可变形体交互,并执行复杂的全身控制。这就提出了一个关键问题:机器人必须具备哪些关键能力才能实现所有这些功能?

为了探索这个问题,分析数据集 BEHAVIOR-1K [8] 中的活动,这是一个以人为本的机器人基准,包含 1,000 种日常家务活动,由人类定义和优先考虑,并在生态和虚拟环境中实例化,包括住宅、办公室和餐馆。通过分析,确定了成功执行这些任务的三个基本全身控制能力:双手协调、稳定和准确的导航以及广泛的末端执行器可达性。

诸如举起大而重物体之类的任务需要双手操作 [13, 14],而在整个房子中检索工具则取决于稳定和精确的导航 [15–17]。诸如在携带杂货的同时开门之类复杂任务需要两种能力的协调 [18–20]。此外,日常物品分布在不同的位置和高度,需要机器人相应地调整其可达性。为了说明这一点,分析 BEHAVIOR-1K [8] 中与任务相关的家用物品空间分布。如图所示,这里水平距离表示从物体到机器人最近的可导航位置欧氏距离,而垂直距离表示物体距离地板的高度。值得注意的是,垂直距离的多模态分布,凸显广泛的末端执行器可达性必要性,使机器人能够与各种空间配置中的物体交互。

但机器人如何才能有效地实现这些能力呢?精心设计的机器人硬件包括双臂、移动底座和灵活的躯干,对于实现全身操控至关重要 [21]。然而,如此复杂的设计给策略学习方法带来重大挑战,特别是在扩展数据收集 [22–24] 和准确模拟复杂现实环境中协调的全身动作方面。当前的机器人系统通常难以全面应对这些挑战 [21, 25–31],这凸显对更适合家庭任务的硬件、更有效的数据收集策略以及能够捕捉全身控制固有层次结构和相互依赖关系的改进模型需求。

本文行为机器人套件 (BRS),就是一个用于学习全身操控的综合框架,用于处理各种现实世界的家务。BRS 通过两项关键技术解决硬件和学习方面的挑战。第一项是 JoyLo,这是一种低成本的全身遥操作界面,专为普遍适用而设计,具体实现在 Galaxea R1 机器人上,该机器人是一种带轮子的双臂机械手,躯干灵活。第二项是全身-视觉运动注意 (WB-VIMA) 策略,这是一种学习算法,可以有效地模拟协调的全身动作。

机器人平台

其选择 Galaxea R1 机器人作为平台,以满足家务必不可少的三个关键能力:双手协调、稳定而精确的导航以及广泛的末端执行器可达性。如图所示,R1 机器人具有两个安装在 4 自由度躯干上的 6 自由度臂。每条臂都配备一个平行钳口夹持器,最大有效载荷为 5 kg,非常适合操纵日常家务活动中遇到的大多数物体。躯干包含四个旋转关节:两个用于腰部旋转和臀部弯曲,另外两个关节可实现类似膝盖的运动。这种设计使机器人能够在站立和蹲姿之间平稳过渡,增强其在家庭环境中的可达性。通过将躯干集成到末端执行器的运动链中,R1 机器人实现从地面到垂直 2 米、水平 2.06 米的有效伸展范围,覆盖了上图所示的工作空间。手臂和躯干使用关节阻抗控制器进行控制,以目标关节位置作为输入。

为了确保在家庭环境中稳定导航,机器人的躯干安装在一个全向移动基座上,能够在地面上以 1.5 m/s 的最大速度向任何方向移动。此外,基座可以独立执行偏航旋转,最大角速度为 3 rad/s。这种移动由三个轮式电机和三个转向电机驱动。移动基座的离地间隙为 30 毫米,可以穿越大多数家庭地面。它还实现了高达 2.5 m/s^2 的水平加速度,增强需要同时移动和操纵的任务的机动性,例如开门。移动基座通过与其在地面上三个自由度相对应的速度命令进行控制:向前运动、横向运动和偏航旋转。

为了实现感知,为 R1 机器人配一套机载传感器,包括一个立体 ZED 2 RGB-D 摄像头作为头部摄像头,两个立体 ZED-Mini RGB-D 摄像头作为腕部摄像头,以及一个用于视觉里程计的 RealSense T265 跟踪摄像头。所有 RGB-D 摄像头均以 60 Hz 的频率运行,流式传输经过校正的 RGB 和深度图像。通过机器人的正向运动学,摄像头的姿势以 500 Hz 的频率更新,从而能够有效融合来自所有三个摄像头的传感数据。这种集成支持高保真的全局感知和以自我为中心的 3D 感知,例如彩色点云观测。同时,视觉里程计系统以 200 Hz 的频率运行,提供移动基座的实时速度和加速度估计,这是学习移动基座精确速度控制的关键反馈。

JoyLo:低成本运动双臂的任天堂 Joy-Con

为了实现对具有大量自由度移动机械手的无缝控制,并促进下游策略学习的数据收集,引入 JoyLo——一个用于构建经济高效的全身遥控界面的通用框架。如图所示,在 R1 机器人上实现 JoyLo,其设计目标如下:

• 高效的全身控制,以协调复杂的动作;

• 丰富的用户反馈,实现直观的遥控操作;

• 确保高质量的演示以进行策略学习;

• 低成本实施,增强可访问性;

• 实时、用户友好的控制器,实现无缝操作。

虽然该实施特定于 R1 机器人,但 JoyLo 的设计原则是通用的,可以适用于类似的机器人平台。

a) 高效的全身控制:全身机器人遥操作存在多种可能的方法,每种方法的准确性、效率、适用性和用户体验各不相同。一种极端是动觉教授,即人类通过物理方式引导机器人沿着目标轨迹运动。虽然这种方法简单而准确 [40–43],但它耗时且不易扩展。另一种极端是运动重定向,它使用运动捕捉设备 [25、44–46] 或计算机视觉技术 [47–53] 将人类运动直接映射到机器人执行。虽然这消除对物理交互的需要,但它存在着具身不匹配和跨不同机器人平台适用性有限的问题。为了在直观性、易用性和操纵任务的精确性之间取得平衡,提出一种基于木偶操纵的方法,使用一对运动双臂和 Dynamixel 电机作为关节。躯干和移动底座的运动通过安装在引导臂末端的拇指杆进行控制。具体来说,用现成的 Nintendo Joy-Con 控制器,因为它们体积小巧、集成拇指杆和多个功能按钮,可实现丰富的可自定义功能。这些控制器使用定制设计的外壳连接,使它们可以滑入并牢固连接。如上图所示:

• 左拇指杆向移动基座发出速度命令。

• 右拇指杆控制腰部旋转和臀部弯曲。

• 两个箭头键可调节躯干高度以进行站立和下蹲。

• 扳机控制夹持器。

借助全面实施的 JoyLo 系统,用户可以同时控制手臂运动、夹持器操作、上身运动和移动基座导航,确保高效、准确、用户友好且可扩展的全身控制。

b) 丰富的用户反馈:提供足够的用户反馈对于提高遥操作性能至关重要。JoyLo 通过双边遥操作实现的触觉反馈实现了这一点 [32, 33]。在高层次上,JoyLo 臂和机器人臂是运动学耦合的:JoyLo 臂作为领导者,向机器人臂发出命令,同时由机器人当前的关节位置进行规则化。正式地,让 q_JoyLo 和 q_robot 分别代表 JoyLo 臂和机器人臂的关节位置。施加到 JoyLo 臂关节上的扭矩 τ 计算如下:

其中 q ̇ 表示关节速度,K_p 和 K_d 是比例和微分增益系数,K 表示阻尼系数。通过这种公式,JoyLo 无需额外的力传感器即可提供触觉反馈 [54, 55]。这种反馈会阻止用户的突然动作,并在机器人接触时提供比例阻力。为了确保 JoyLo 臂中承重关节(例如肩关节)有足够的失速扭矩,两个低成本 Dy-namixel 电机耦合在一起,如上图所示。

c) 针对策略学习进行优化:遥操作界面的选择,对下游策略学习性能有重大影响 [56–60],其中一个关键指标是能够持续重现成功的轨迹。重放成功率至关重要,因为此类数据本质上是经过“验证”的;也就是说,在这些数据上训练的模仿学习策略只需复制演示的动作,而无需补偿具身或运动学差异。这需要在数据收集过程中避免奇点,因为它们会显著降低重放成功率。JoyLo 通过将人类操作员物理限制在机器人的具身中来确保这些属性。运动双臂施加的运动学约束,可防止操作员产生不可行或无法部署的动作。此外,由于操作员直接在关节级别控制 JoyLo 臂,因此可以通过直观的人为调整,自然避免和解决奇点,从而确保演示流畅可靠。

d) 低成本:JoyLo 的设计非常实惠,整个系统由 3D 可打印臂连杆、低成本 Dynamixel 电机和现成的 Joy-Con 控制器组成,总价不到 500 美元。此外,其模块化设计确保所有组件都是可更换的,从而最大限度地减少停机时间并消除不必要的维修成本。

e) 易于使用的实时控制器:为了使 JoyLo 与 R1 机器人高效配合,BRS 包含一个直观的实时控制器,带有 Python 接口。该控制器接受手臂和躯干的目标关节位置以及移动基座的目标速度。这些输入是从随机样本 xK ∼ N(0,I) 开始,然后将其反向转换为控制命令并通过机器人操作系统 (ROS) 主题传输到机器人的去噪过程。

训练方法

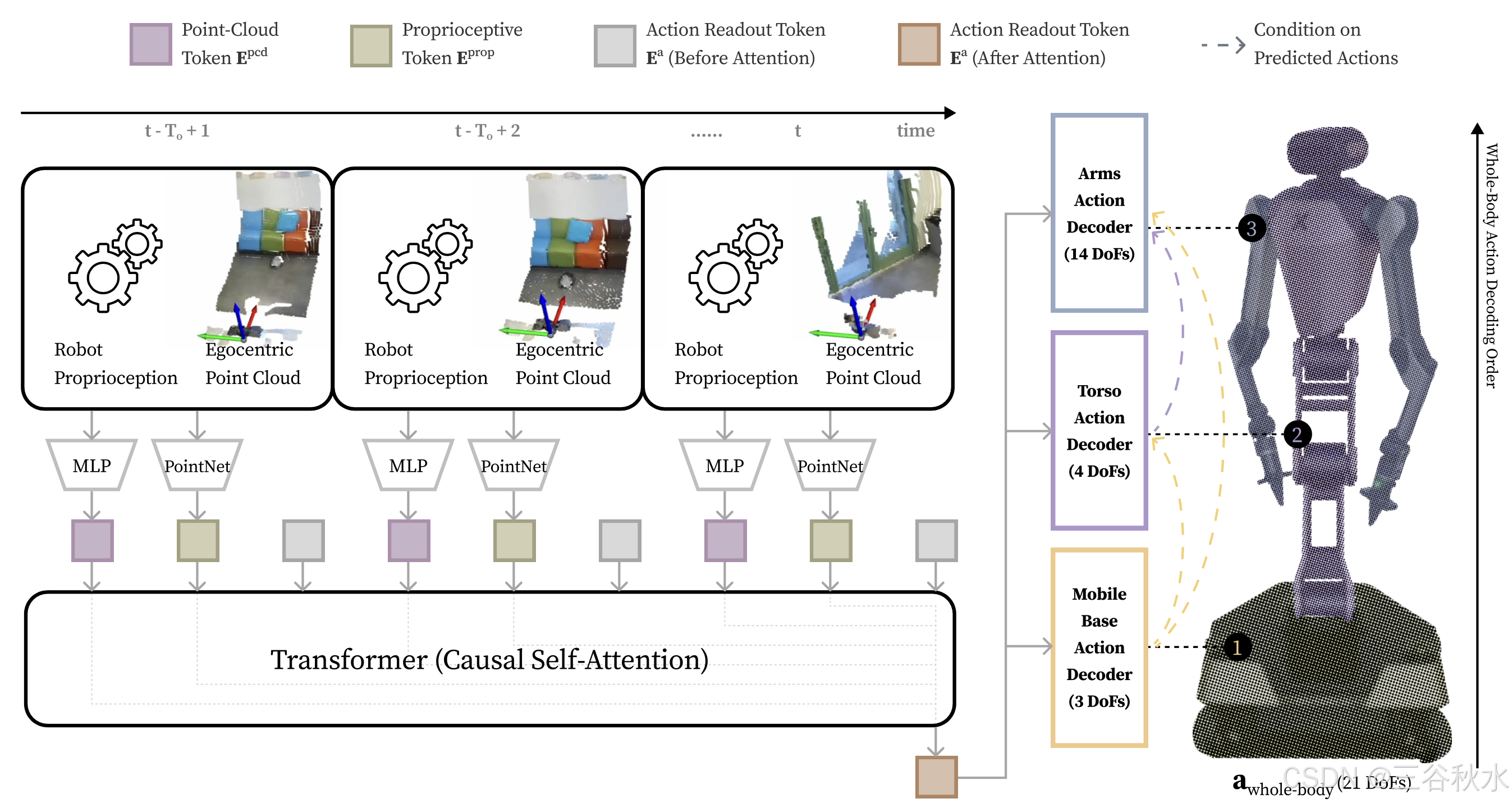

如图显示所提模型的概述。

准备工作

a) 问题表述:将机器人操作表述为马尔可夫决策过程 (MDP) M := (S, A, T , ρ_0, R),其中 s 表示状态,a 表示动作,T 是转换函数,ρ_0 是初始状态分布,R 是奖励函数 [61]。由 θ 参数化的策略 π_θ 学习映射 S → A。b) 策略学习的去噪扩散:将数据分布 p(x_0) 去噪为正向噪声过程 q(xk|xk−1) 的逆过程,其中迭代应用高斯运算噪声。给定正向过程中的噪声样本 xk 和时间步 k,由 θ 参数化的神经网络 ε_θ (x^k , k) 学习预测所施加的噪声 ε。

从随机样本 xK ∼ N(0,I) 开始,逆向去噪过程描述为

最近,DDPM 已被用于建模策略 π_θ,其中去噪网络 ε_θ(a^k|s,k) 是通过行为克隆来训练的 [65–67]。

全身视觉运动注意策略

全身视觉运动注意策略 WB-VIMA 是一个基于Transformer的模型 [38, 39],旨在学习协调的全身动作以完成移动操作任务。如图所示,WB-VIMA 自回归地对整个具体空间中的全身动作进行去噪,并使用自注意力动态聚合多模态观察结果。

a) 自回归全身动作去噪:在具有多个铰接部件的移动机械操纵器中,例如 R1 机器人,移动基座或躯干运动中的小错误可能会导致末端执行器在笛卡尔空间中的姿势出现重大偏差。例如,当 R1 机器人处于中立姿势且双臂略微向前伸展时,膝关节 0.17 弧度(10◦)的小幅运动就可能导致末端执行器位移高达 0.14 米。这是由于运动链延长所致,上游关节的误差会在下游关节中传播和放大。这种放大的程度因运动树中每个关节的位置而异,因此精确的协调对于准确的全身操纵至关重要。为了解决这个问题,利用机器人具身中固有的层次结构。具体而言,根据下半身的预测动作来调节上半身动作预测,可以使策略更好地模拟协调的全身运动。这种方法可确保下游关节考虑上游运动,从而减少误差传播。全身动作解码过程遵循自回归结构,其中动作在机器人具身内按顺序预测。在时间步 t,动作解码首先使用从观察结果编码的动作读出token E_a作为条件参数,预测移动基座的未来轨迹。然后,将移动基座的预测轨迹 a_base 与 E_a 一起用于预测躯干 a_torso 的未来轨迹。最后,将 a_base、a_torso 和 E_a 一起用于预测两个手臂和夹持器 a_arms 的未来轨迹。为了实现这一点,WB-VIMA 联合学习移动基座、躯干和手臂的三个独立去噪网络,分别表示为 ε_base、ε_torso 和 ε_arms。全身动作 a_whole-body 通过迭代去噪按顺序解码,如下所示:

b) 多模态观察注意:多种模态的观察对于学习可以在复杂现实环境中运行的自主机器人至关重要。在 WB-VIMA 中,用以PointNet [68] 将点云编码为点云token Epcd,而 MLP 将本体感受编码为本体感受 token E^prop。然后将当前和之前时间步骤的观察token组装成视觉运动序列:

S = [Epcd_t−T_o+1, E^prop_t−To+, Ea_t−To+,…,Epcd_t, E^prop_t, E^a_t],

其中 T_o 是观察窗大小,E 是 token 维度,Ea 表示插入的动作读出 token。token 序列 S 通过因果自注意进行处理。请注意,动作读出 token 仅关注序列中出现在它们之前的观察token。最后,与最后一个时间步相对应的动作读出 token E^a 用于上面讨论的自回归全身动作解码。

c) 有效推理:为了确保在 WB-VIMA 中对高频闭环控制进行有效推理,仅使用动作读出 token 通过去噪扩散进行全身动作解码。这种设计允许使用轻量级的基于 UNet [69] 动作头和更重的 Transformer 主干进行观察编码。它在模型表达力和推理延迟之间取得平衡。

d)训练和部署细节:WB-VIMA 经过训练可以预测含噪的全身动作所带来的额外噪音。对于每个去噪网络,损失为 L = MSE(ε^k, ε_θ(·|k)),其中 ε^k 表示真实增加的噪声,ε_θ 是预测噪声。总损失是所有去噪网络的总和。在部署期间,在配备 NVIDIA RTX 4090 GPU 的工作站上执行推理,实现 0.02 秒的有效延迟。以 10 Hz 的频率收集数据,同时以 100Hz 的频率更新控制器的输入。因此,每 0.1 秒发布一次新的策略操作并重复 10 次。

受 BEHAVIOR- 1K [8] 中定义的日常活动启发,选择五个代表性的家庭任务来展示 BRS 的能力。这些任务需要三个关键的全身控制能力:双手协调、稳定准确的导航以及广泛的末端执行器可达性。所有任务均在现实世界中未经修改的环境中执行,其中有人类每天与之交互的物体。这些任务是长期的,人类操作员使用 JoyLo 完成这些任务需要 60 秒到 210 秒的时间。由于这些活动的多阶段性质,每个任务被细分为多个子任务(“ST”)。在评估过程中,如果子任务失败,会将机器人和环境重置为后续子任务的初始状态并继续评估。此外,整个任务的成功率(“ET”)——表示策略端到端完成活动的能力。为了进行基线比较,纳入 DP3 [70] 和基于 RGB 图像的扩散策略(“RGB- DP”)[66]。记录人类远程操作成功率作为参考,并跟踪安全违规行为,这些违规行为定义为机器人碰撞或由于用力过大导致的电机功率损失。每个策略对每个活动进行 15 次评估。

局限性:

1)WB-VIMA 仍使用在特定 R1 机器人上收集的数据进行训练。探索多具身数据和跨具身迁移如何有益于训练是件很有趣的事 [22, 95, 157–159]。

2)收集的数据可能不足以进行场景级泛化。未来的工作可以探索使用大型预训练模型(如 VLA [160–162])来促进场景级泛化能力。

3)探索如何从合成数据 [163, 164] 或人类数据 [165–167] 中受益于学习全身操控将是互补的。

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?