1、背景

今天这种方式非常贴合低配置笔记本电脑的小伙伴们, 又没有GPU资源, 可以考虑使用api方式,让模型服务厂商提供计算资源

有了开放的api,让你没有显卡的电脑也能感受一下大模型管理知识库,进行垂直领域知识的检索和问答.算是自己初步玩一下AI agent

之前有写过一篇《平民如何体验一把大模型知识库》里面有提到使用阿里的免费GPU进行部署,但是免费总有到头的一天, 今天教大家如何使用在线模型管理自己的知识库, 同样是基于ChatChat的开源代码来讲解. 随着大模型竞争的白热化,基本很多大模型都开放的api方式,让大家自己定义AI agent的应用.

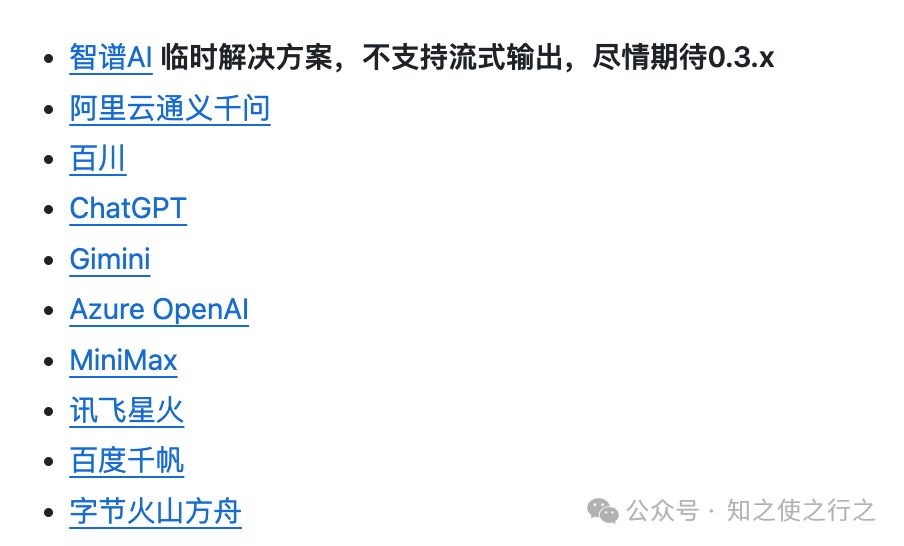

目前官方github上支持联网模型有:

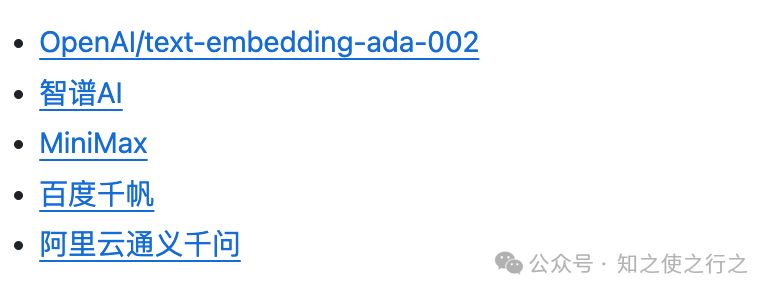

目前官方github上支持的词嵌入(Embedding)模型有:

2、准备下前置条件

(1)、联网大模型选择

刚好最近讯飞星火发布了3.5大模型, 为了对它免费的感谢,顺便也支持一下国产的服务,我们就拿它的api来玩一玩, 个人实名认证的可以免费领取,领取就可以获得api调用key等信息:

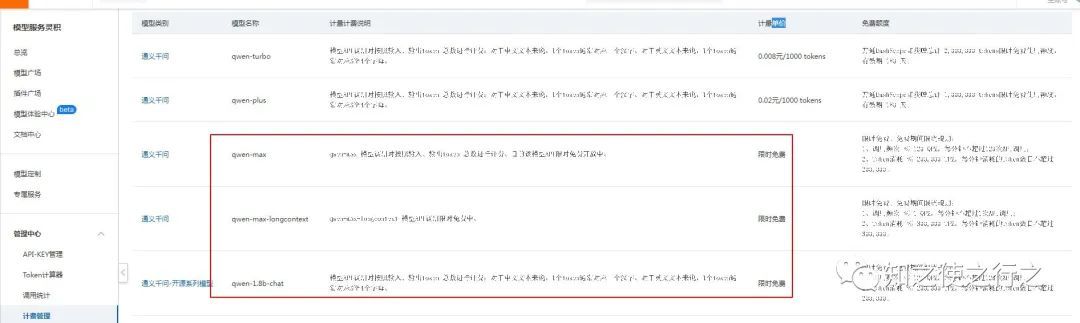

(2)联网的词嵌入(Embedding) 模型

在对话过程中并不要求 LLM 模型与 Embeddings 模型一致,你可以在知识库管理页面中使用 qwen-api,在之前《限时免费的羊毛撸起来!@刚入大模型坑的朋友们》文章中有提到过。

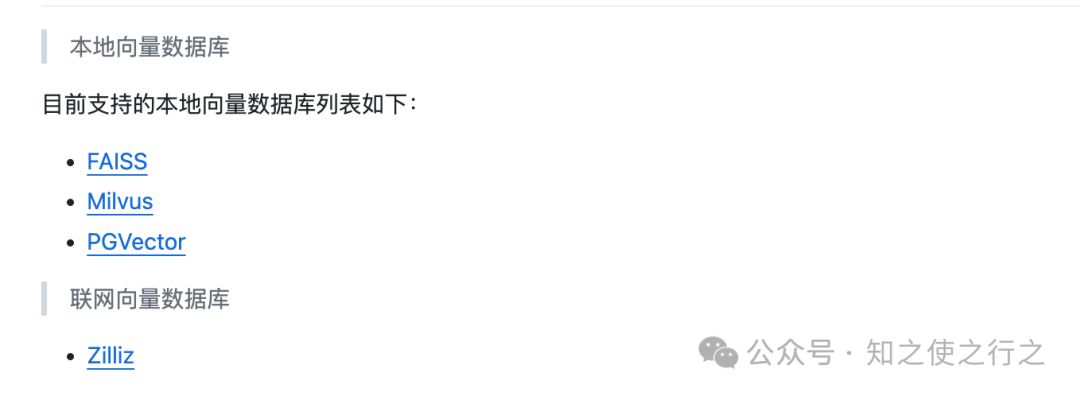

(3) 向量数据库

官方的github支持向量数据库有以下选择:

为了完全降低本地资源的损耗, 模拟成最差的资源的机器, 证明自己是光杆指令,选择Zilliz向量库.

3、实操

(1) 、创建虚拟python环境

conda create --name chatchat python=3.10.12

(2)、安装必要的包

pip install -r requirements_lite.txt # 安装轻量依赖

pip install -r requirements_api.txt

pip install -r requirements_webui.txt

pip install pymilvus # Zilliz依赖

(3)、运行

python copy_config_example.py #修改配置文件

vim configs/model_config.py # 修改模型配置变量

vim configs/kb_config.py # 修改配置文件,配置Zilliz和Zilliz 信息

nohup python3.10 startup.py -a > chat.log 2>&1 &

4、效果展示

(1) 、对话效果

(2)、无GPU使用

1267

1267

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?