来自:NIPS2013

一:解决了什么问题?

针对论文Efficient Estimation of Word Representations in Vector Space中提出CBOW和Skip-gram俩种模型计算softmax时因为语料库V太大导致计算复杂度偏高的问题。提出了俩种方式分层采样和负采样俩种方式。

二:怎样解决的问题?

1:Hierarchical Softmax

层次softmax的核心思想就是通过引出二叉树结构(Huffmax 二叉树)将求softmax的计算转为求sigmoid的计算,从而将计算复杂度从V 降到log2V

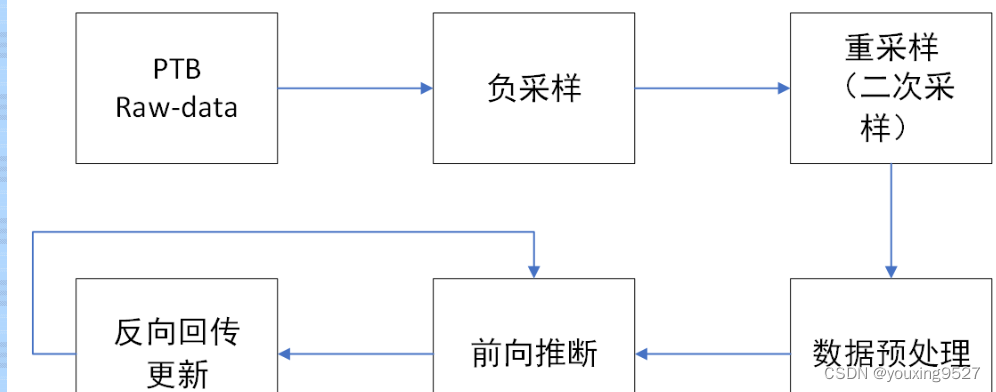

2:Negative Sampling

负采样的核心思想就是将多分类(V类)问题转为二分类问题。Softmax之所以慢,是因为它涉及一个多分类问题,且和词表大小V 相关的。负采样就是舍弃多分类,转为二分类来提升速度。

422

422

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?