1.LMDeploy环境部署

2.LMDeploy模型对话(chat)

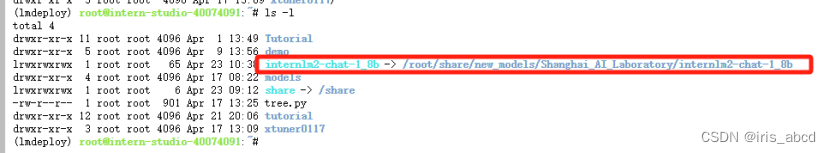

(1)下载模型

(2)使用Transformer库运行模型

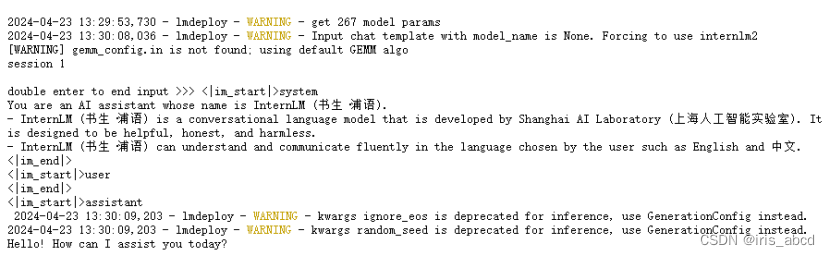

(3)使用LMDeploy与模型对话

3.LMDeploy模型量化(lite)

3.1 设置最大KV Cache缓存大小

首先保持–cache-max-entry-count参数(默认0.8),运行1.8B模型。

改变–cache-max-entry-count参数,设为0.5,运行1.8B模型。

把–cache-max-entry-count参数设置为0.01,约等于禁止KV Cache占用显存。

**结论,**降低KV Cache缓存会明显减小显存占用,但也会降低模型推理速度。

3.2 使用W4A16量化

模型量化时间较久

使用Chat功能运行W4A16量化后的模型:

将KV Cache比例再次调为0.01,运行模型,查看显存占用情况明显降低

4.LMDeploy服务(serve)

以上为本地直接推理大模型,称为本地部署。

在生产环境中,将大模型封装为API接口,供客户端访问。

4.1 启动API服务器

API调用log

608

608

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?