一、操作系统信息

版本 Windows 11 家庭中文版

版本号 23H2

安装日期 2023/8/21

操作系统版本 22631.4460

二、搭建思路

ollama拉取deepseek、bge-m3模型

docker拉取dify的镜像

dify链接ollama使用模型,并上传文件搭建知识库,创建应用三、搭建步骤

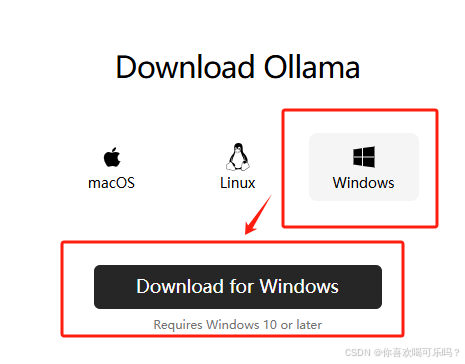

1.下载安装ollama,拉取模型

1.1 下载

下载链接:https://ollama.com/download

1.2 安装

将下载的文件 OllamaSetup.exe 安装

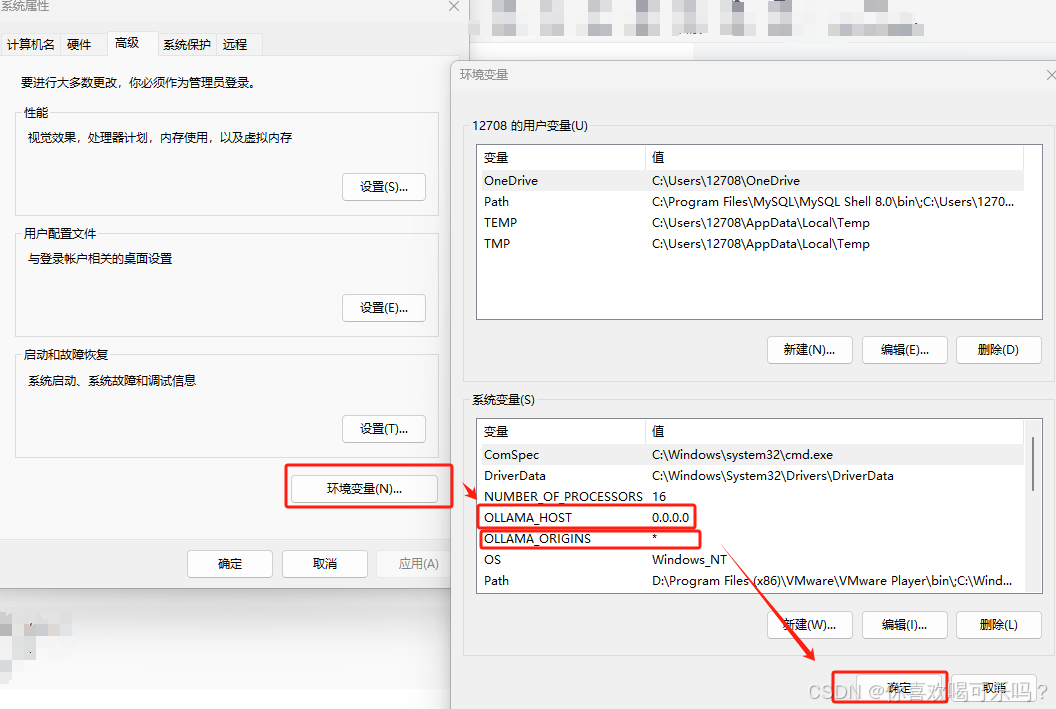

修改环境变量

重启ollama

1.3 验证是否安装成功

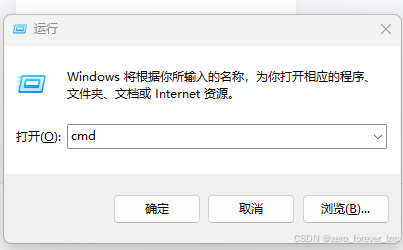

打开命令框

1.快捷键 win+r

2.输入 cmd

3.Enter

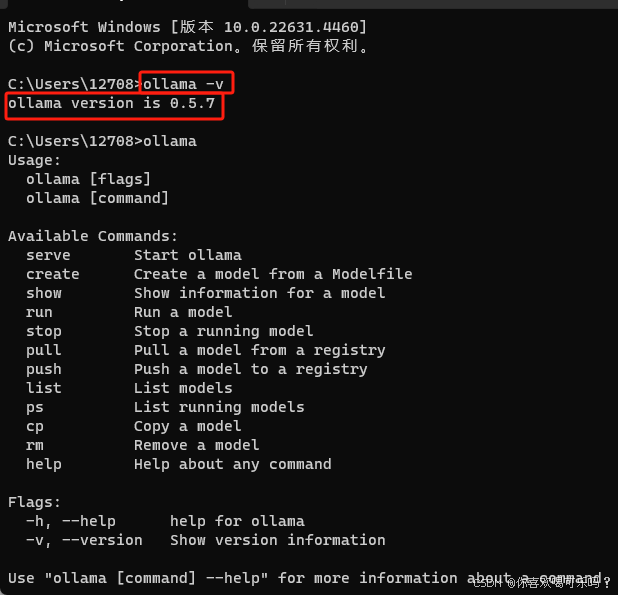

查看是否安装成功

ollama -v

1.4 拉取模型

deepseek模型

链接:https://ollama.com/library/deepseek-r1:1.5b

命令:ollama run deepseek-r1:1.5bbge-m3模型

链接:https://ollama.com/library/bge-m3

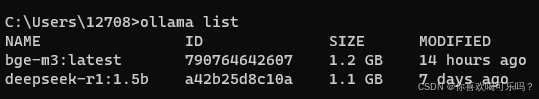

命令:ollama pull bge-m31.5 查看拉取的模型

ollama list

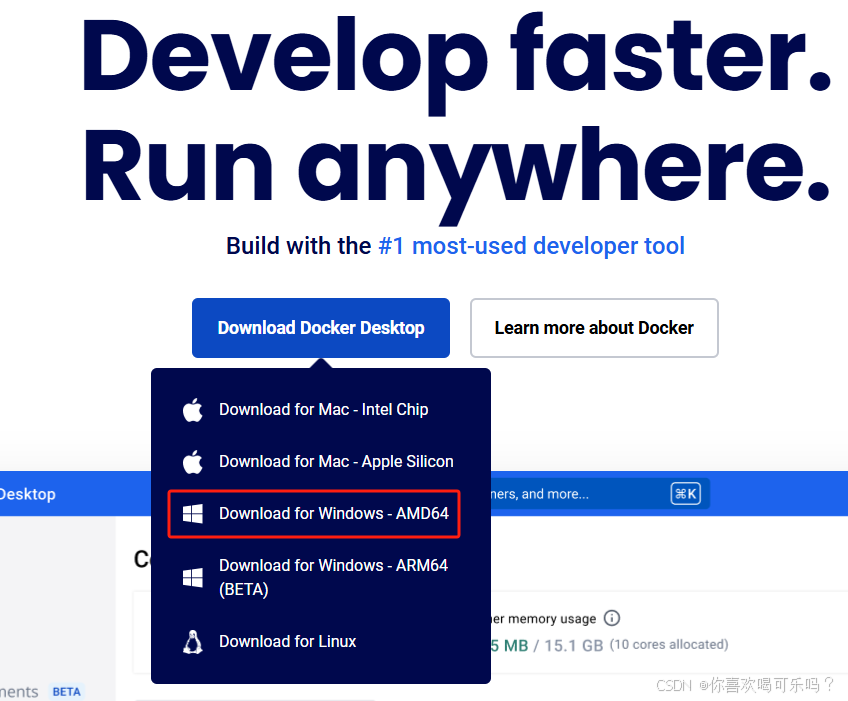

2.下载安装docker

2.1 下载

下载链接:https://www.docker.com/

2.2 安装

将下载的文件 Docker Desktop Installer.exe 安装,

鼠标右键,以管理员身份运行

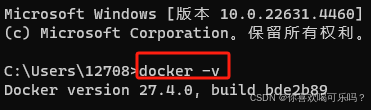

2.3 验证

命令:docker -v

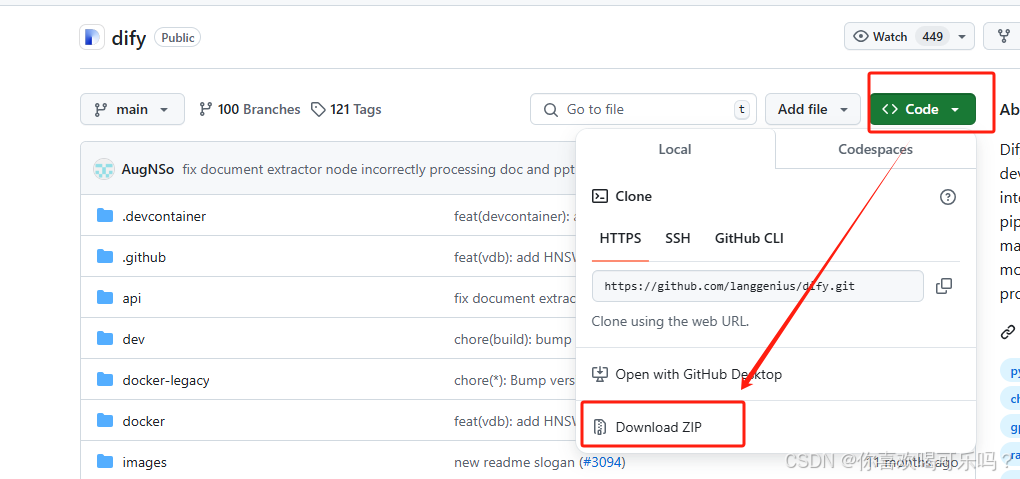

3.在docker中拉取dify的镜像

3.1 下载dify

链接:https://github.com/langgenius/dify

3.2 拉取

解压下载的zip压缩包

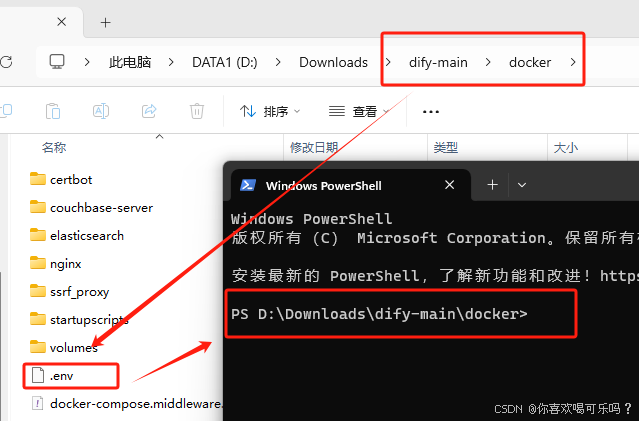

找到该文件夹下的文件

dify-main -> docker -> .env.example将该文件重命名命名为

.env在该文件所在的文件夹下,鼠标右键点击 在终端中打开

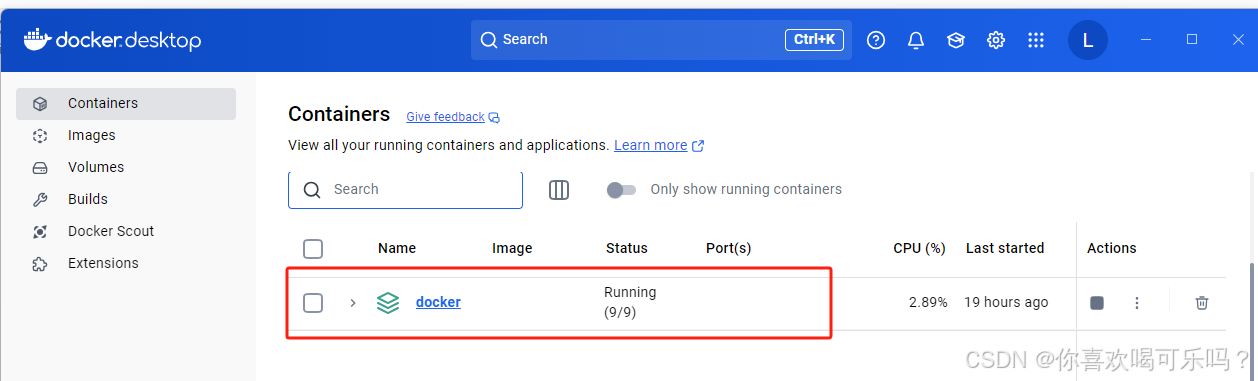

在docker打开的前提下,在命令框中输入以下命令,将dify上传到docker

docker compose up -d3.3 验证

打开 Docker Desktop,可看到上传的镜像

4.在dify中设置模型,搭建知识库,创建应用 个人助手

4.1 打开界面

浏览器登录,打开以下链接

http://localhost/signin登录后,点击右上角头像 -> 设置,可参考以下图片添加模型

完成图

4.2 添加模型

4.3 模型设置

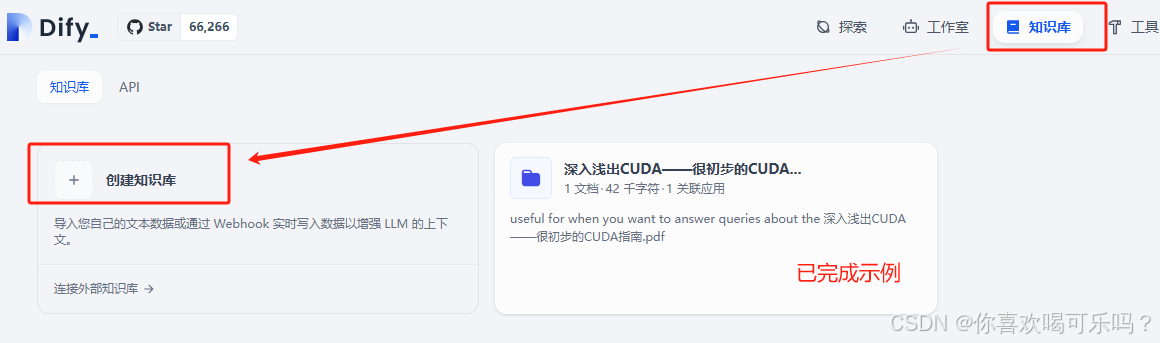

4.4 创建知识库

拖拽文件,创建知识库

4.5 创建应用

4.6 引用知识库,并更新发布,测试

四、补充

请参考该文章内容自行探索dify的其他功能

下载文件的链接若打不开,请科学上网

可尝试在Linux系统中搭建私有知识库

参考链接:

6个步骤,一文将透如何用DeepSeek本地部署以及知识库 - 知乎

十分钟用DeepSeek v3快速搭建企业级本地私有知识库(保姆级教程),AI终于私有化了!_deepseek搭建本地知识库-CSDN博客

1811

1811

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?