本文目录

- DeepSeek模型推理性能的理论分析

- DeepSeek模型推理性能的优化手段

- 企业级部署与实践:成本与性能的权衡

- 生产应用中的后续优化思路

- 结语

- 展望

一、DeepSeek模型推理性能的理论分析

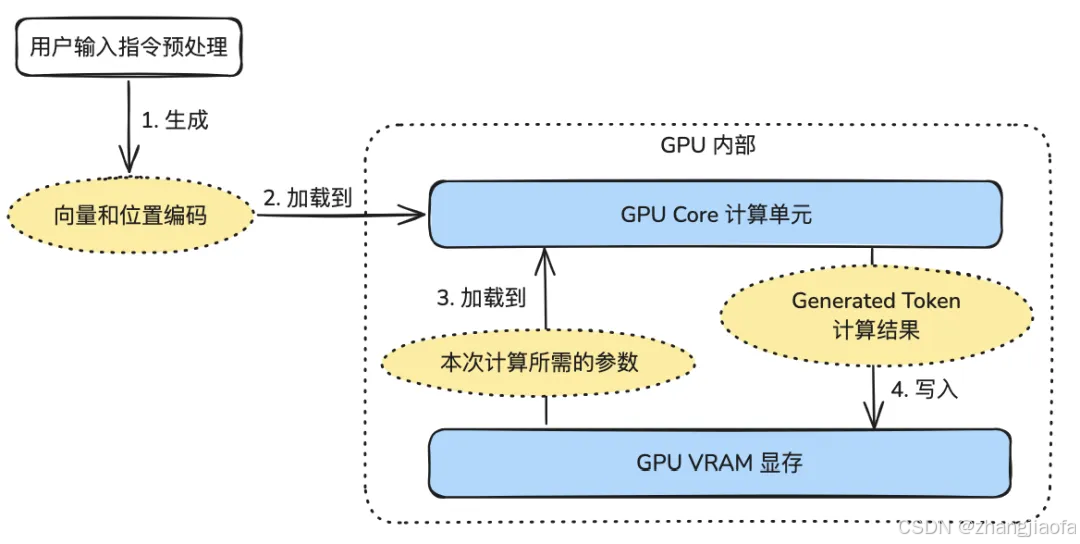

对于当下的大模型,其GPU运行过程可简化为以下几步:

- 对输入文本进行转换,将汉字或者单词转换成大模型能理解的数字(向量和位置编码)。

- 基于模型的参数进行计算,此时需将模型的参数(以Qwen2.5 - 72B为例,即145GB数据)加载到计算单元进行计算。

- 生成回答,本质是生成候选词和概率分布。

在此过程中,对于GPU硬件有两个关键参数:

5. 矩阵乘法的性能:即我们常说的GPU的TFlops。

6. GPU显存带宽:因为要从显存读取模型参数,这与显存采用GDDR还是HBM有关。

对于现代GPU而言,后者的“瓶颈效应”往往大于前者。我们列出一些常见GPU的算力和显存带宽:

订阅专栏 解锁全文

订阅专栏 解锁全文

1839

1839

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?